Geht es um Big Data, kommen Unternehmen kaum um die Open-Source-Lösung Hadoop herum. In diesem Beitrag zeigen wir Ihnen 10 Dinge, die Sie über Hadoop wissen sollten, wenn Sie die Lösung bereits einsetzen oder einsetzen wollen. [...]

Hadoop steht über die Apache-Lizenz vollkommen zur Verfügung. Es sind keine zusätzlichen Lizenzen notwendig. Als Basisbetriebssystem bietet sich Linux an, welches in den meisten Distributionen ebenfalls kostenlos zur Verfügung steht.

Wollen Sie zusätzliche Dienste, Support und weitere Funktionen nutzen oder in Anspruch nehmen, müssen Unternehmen natürlich die Erweiterungen und den Support bezahlen.

HADOOP – FRAMEWORK FÜR BIG DATA

DARAUS BESTEHT HADOOP

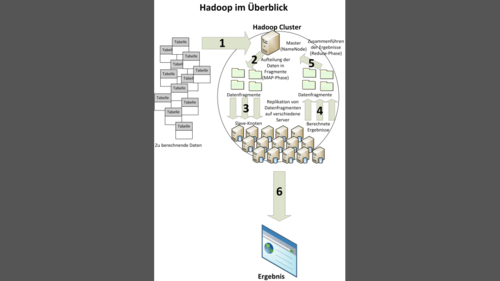

Hadoop besteht aus einem Cluster. Ein Knoten übernimmt die Steuerung (NameNode), die anderen die Berechnungen (DataNodes) im Cluster. Grundlage ist „Hadoop Common“. Dieser stellt die Schnittstelle für alle anderen Bestandteile dar. MapReduce ist die wichtigste Funktion zur Verarbeitung der Daten. Die Technik teilt große Datenmengen in kleinere Teile auf, verteilt diese auf die Knoten im Hadoop-Cluster und führt diese nach der Berechnung wieder zusammen. Basis ist HDFS oder GPFS welches die Speicherung übernimmt. MapReduce sorgt für die Berechnung der Daten zwischen den Clusterknoten. Entwickelt wurde MapReduce von Google.

LOKALER BETRIEB ODER CLOUD – HADOOP IN DER AZURE-CLOUD

Um Hadoop zu betreiben, benötigen Unternehmen einen Cluster, der die verschiedenen Knoten zur Berechnung enthält. Einfacher ist aber der Betrieb in der Cloud. Hier bietet Microsoft zum Beispiel mit HDInsight einen Cloud-Dienst in Azure an, mit dem Sie einen vollwertigen Hadoop-Cluster in der Cloud betreiben können. Im Gegensatz zu vielen anderen Microsoft-Lösungen, hat der Software-Konzern aber keine eigenen Standards integriert, sondern sich komplett an Hortonworks Data Platform (HDP) gehalten.

ERSETZT HADOOP BUSINESS INTELLIGENCE IM UNTERNEHMEN?

Big Data-Lösungen wie Hadoop ergänzen Business Intelligence. Im Gegensatz zu BI-Lösungen, benötigen Big-Data-Lösungen keine perfekt zusammen gestellten Daten, sondern können aus einer Vielzahl verschiedener Datenquellen mit komplett unterschiedlichen Daten effektive Berichte und Analysen ausstellen. Ein BI-System kann zum Beispiel exakt darstellen, welches Produkt in unterschiedlichen Ländern zu welchem Prozentteil, Umsatz und zu welcher Marge verkauft wurde. Diese Informationen sind auch wichtig. Big-Data-Lösungen können wiederum erfassen bei welchem Kundenkreis das Produkt besonders gut ankommt, welche Zusammenhänge es mit anderen Produkten gibt, ob der Transport eines Produktes sowie dessen Lieferdauer auf die Verkaufszahlen Auswirkungen hatten. Auch ein Zusammenhang zwischen Defekten und Verkaufszahlen der nächsten Generation lässt sich erfassen.

Be the first to comment