Geht es um Big Data, kommen Unternehmen kaum um die Open-Source-Lösung Hadoop herum. In diesem Beitrag zeigen wir Ihnen 10 Dinge, die Sie über Hadoop wissen sollten, wenn Sie die Lösung bereits einsetzen oder einsetzen wollen. [...]

IBM GENERAL PARALLEL FILE SYSTEM IM BIG DATA-EINSATZ

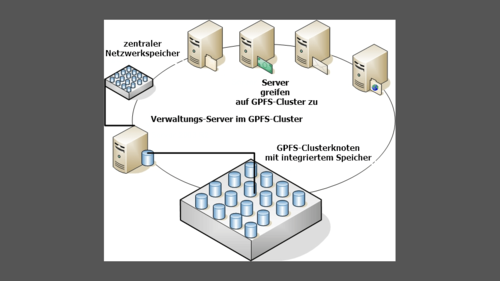

Das IBM General Parallel File System (GPFS) ist ein spezielles Dateisystem von IBM, welches auch in Hadoop-Clustern zum Einsatz kommt. Diese verwenden oft das Hadoop File System (HDFS), können aber auch GPFS nutzen. Diese beiden Dateisystems können große Datenmengen enorm schnell verarbeiten und sind daher anderen Dateisystemen überlegen. Vorteil von GPFS ist zum Beispiel der schnelle Zugriff auf sehr große Dateien. Die Daten werden auf hunderte oder tausende Clusterknoten gespiegelt und verteilt, bleiben aber dennoch zugreifbar.

GPFS kann Daten auch intelligent speichern. Wenn Unternehmen verschiedene Technologien einsetzen, zum Beispiel SSD, SAN, NAS und DAS, kann GPFS häufig verwendete Daten in schnellen Bereichen sparen und alte Dateien auf langsamere Datenträger. Das ist bei der Verarbeitung mit Hadoop besonders wichtig.

HADOOP IN AMAZON WEB SERVICES, GOOGLE CLOUD PLATFORM UND RACKSPACE

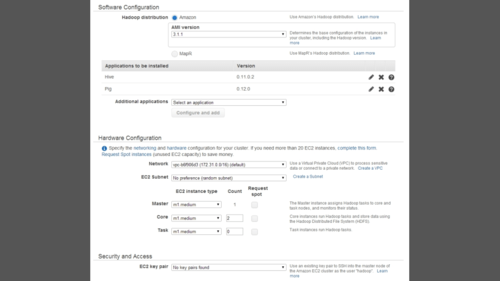

Neben Microsoft Azure HDInsight, lassen sich Hadoop-Cluster auch in Amazon Web Services (AWS) betreiben. Nutzen Sie AWS, werden die Daten des Hadoop-Clusters im AWS-Speicherdienst S3 abgelegt. Das Unternehmen Rackspace bietet ebenfalls eine Cloud-Lösung an, die auf Apache Hadoop und Hortonworks Data Platform aufbaut. Hadoop kann aber auch auf der Google Cloud Platform betrieben werden.

DIE WICHTIGSTEN HADOOP-DISTRIBUTIONEN

Neben den Möglichkeiten Hadoop in Microsoft Azure HDInsight oder Amazon Web Services zu betreiben, können Sie natürlich auch auf eigene Installationen setzen. Besonders bekannt in diesem Zusammenhang sind die folgenden Anbieter:

- Hortonworks Data Platform

- Cloudera

- MapR

HADOOP ERWEITERN – YARN UND CO.

Auf dem Markt finden Sie zahlreiche Erweiterungen, mit denen sich der Funktionsumfang von Hadoop vergrößern lässt. Beispiele dafür sind Hadoop YARN und Apache Hive. Entwickler können mit Hive direkt die Daten abfragen, die in HDFS gespeichert sind.

Auch Apache Spark spielt in diesem Zusammenhang eine wichtige Rolle. Bei Yarn handelt es sich um eine Cluster-Verwaltungs-Technologie für Hadoop. Viele Big Data-Profis bezeichnen YARN auch als MapReduce 2.

Mit Apache ZooKeeper können Sie die Hadoop-Infrastruktur zentral steuern. Apache HCatalog ist eine Verwaltungslösung für verschiedene Prozessverarbeitungs-Tools.

SICHERHEIT UND ÜBERWACHUNG IM HADOOP-CLUSTER – APACHE KNOX UND CHUKWA

Bei Apache Knox handelt es sich um ein REST API Gateway für Hadoop-Cluster. Die Hadoop-Erweiterung erhöht das Sicherheitsmodell von Hadoop und integriert Authentifizierungen und Benutzerrollen.

Um die Hadoop-Infrastruktur zu überwachen, setzen Sie am besten auf Apache Chukwa. Die Lösung überwacht HDFS-Datenzugriffe und das MapReduce-Framework.

ORACLE, IBM UND CO. – HADOOP KOMMERZIELL ERWEITERN

Oracle bietet zum mit Big Data SQL die Möglichkeit über SQL-Abfragen auf Big Data-Daten zuzugreifen. IBM InfoSphere BigInsights erweitert Hadoop um zahlreiche Möglichkeiten. Die Daten lassen sich besser verwalten und bieten mehr Möglichkeiten zur Abfrage.

*Thomas Joos ist freiberuflicher IT-Consultant und seit 20 Jahren in der IT tätig.

Be the first to comment