Unter den großen Anbietern von Public-Cloud-Services ist Amazon Web Services unangefochten die Nummer Eins. Um diese Position zu halten, setzt die Tochtergesellschaft von Amazon auf eine mehrgleisige Strategie: günstige Preise und eine rasante Erweiterung seiner Cloud-Services. Doch dieses Vorgehen ist nicht ohne Risiko. [...]

Der führende Anbieter von Public-Cloud-Diensten, die Anwender im Selbstbedienungsverfahren (Self Service) ordern und implementieren können, heißt Amazon Web Services (AWS). Alleine im IaaS-Bereich taxierte die IT-Community Wikibon den Marktanteil von AWS im Jahr 2015 auf mehr als 27 Prozent und damit klar vor Microsoft Azure (16 Prozent). Noch deutlicher fällt die Dominanz von AWS nach Angaben von Rightscale aus, einem Anbieter von Management- und Analyse-Software für Cloud-Umgebungen. Demnach setzten 2015 rund 57 Prozent der Unternehmen und öffentlichen Einrichtungen weltweit zumindest einen Cloud-Dienst von AWS sein. Unter den mittelständischen Unternehmen mit bis zu 1.000 Mitarbeitern waren es sogar 61 Prozent.

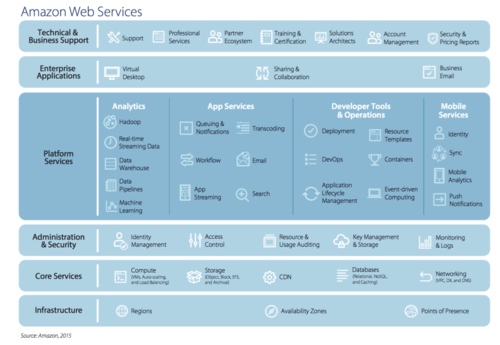

Ein Grund für die hohen Werte ist, dass AWS neben IaaS-Services eine breite Palette an Tools für Kunden bereitstellt, die mithilfe der AWS-Plattform Applikationen entwickeln, testen und bereitstellen wollen, Stichwort Platform-as-a-Service. Dazu zählen DevOp-Tools und Dienste, um mobile Services zu entwickeln. Zudem bietet AWS Data Warehouses, Hadoop-Cluster und Datenbanken an.

AWS IST FÜR AMAZON EINE SPRUDELNDE GELDQUELLE

Für den Mutterkonzern Amazon hat sich AWS mittlerweile zu einer soliden Einnahmequelle entwickelt. Im vierten Quartal des Geschäftsjahres 2015 erzielte AWS bei einem Umsatz von 2,4 Milliarden Dollar ein Betriebsergebnis vor Zinsen, Steuern und Abschreibungen (EBITDA) von 687 Millionen Dollar. Das machte immerhin 40 Prozent des Ergebnisses von Amazon aus. Dieses betrug im vierten Quartal 2015 rund 1,7 Milliarden Dollar, allerdings bei einem deutlich höheren Umsatz von 35,7 Milliarden Dollar.

Daher ist es nicht verwunderlich, dass AWS für den Konzern mittlerweile eine zentrale Rolle spielt. Dies hat auch damit zu tun, dass das Management Analysten und Aktionären einen Unternehmensbereich präsentieren möchte, der hohe Gewinnmargen erzielt. Denn in den vergangenen Monaten wuchs die Kritik an der mäßigen Profitabilität des Gesamtunternehmens. Dies bedeutet jedoch auch, dass AWS auch künftig „liefern muss“, also möglichst hohe Gewinne erzielt.

DIE ARCHITEKTUR DER AWS-CLOUD

Eine Stärke von AWS ist die globale Cloud-Infrastruktur. Derzeit verfügt AWS weltweit über 32 Availability Zones in zwölf Weltregionen, darunter eine mit zwei Rechenzentren in Frankfurt am Main. Fünf weitere will der Cloud Service Provider 2016 etablieren, unter anderem in Großbritannien und Indien. Eine Availability Zone besteht aus Gründen der Ausfallsicherheit aus zwei oder mehr Rechenzentren. Nutzer von AWS-Diensten können auch mehrere dieser Zonen nutzen und Daten zwischen ihnen replizieren. Dies erhöht die Redundanz für den Fall, dass AWS-Datacenter in einer Region ausfallen, etwa durch eine Naturkatastrophe.

Zudem bietet AWS 54 Points of Presence (PoP) an. Dort steht Nutzern von AWS-Diensten ein direkter Zugang zur Cloud-Infrastruktur des Unternehmens zur Verfügung. Diese PoPs können beispielsweise zusammen mit dem Content Delivery Service (CDN) CloudFront von AWS eingesetzt werden, um Inhalte (Content) wie „Streaming Media“ (Videos) bereitzustellen oder den Zugriff auf Unternehmens-Web-Seiten zu beschleunigen.

Die globale Infrastruktur macht AWS vor allem für Unternehmen interessant, die weltweit tätig sind. Die regionale Präsenz hat mehrere Vorteile. Ein technischer Aspekt ist, dass wegen der kürzeren Übertragungswege die Latenzzeiten geringer ausfallen. Das ist speziell für Echtzeit-Dienste relevant, etwa Datenbanken oder Workplaces, die in der Amazon-Cloud vorgehalten werden, sowie für CDN-Services.

Ein zweiter Faktor sind juristische Vorgaben, insbesondere Datenschutzbestimmungen. AWS hat nicht zuletzt deshalb im Oktober 2014 in Frankfurt am Main eine Availability Zone eingerichtet, um Bedenken deutscher Unternehmen in puncto Datenschutz auszuräumen. Nach Angaben von AWS können Anwender festlegen, dass Daten ausschließlich in den deutschen Rechenzentren gespeichert und bearbeitet werden. Microsoft, der größte Mitbewerber von AWS, will erst 2016 ein Rechenzentrum in Deutschland aufbauen. Von Google, einem weiteren Schwergewicht im Bereich Cloud-basierte Infrastrukturservices, sind keine derartigen Pläne bekannt.

PLUSPUNKT: DAS BREITE IAAS- UND PAAS-ANGEBOT

Kaum zu übertreffen ist AWS derzeit in puncto Angebotsvielfalt. Anwender haben die Wahl zwischen mittlerweile mehr als 50 zentralen Cloud-Angeboten, hinzu kommen ergänzende Services. Die Fokussierung auf Rechenleistung (Amazon EC2), Speicher-Dienste wie den objektorientierten Storage-Service Amazon S3 und Netzwerkservices ist einer breiten Palette von IaaS- und PaaS-Diensten gewichen. Dazu zählen Services wie Elastic Beanstalk für die Implementierung von Web-Applikationen, die Unterstützung von Container-Technologien (EC2 Container) sowie Datenbank-Dienste wie DynamoDB (NoSQL) und der Amazon Relational Database Service (RDS) für MySQL, Oracle-Datenbanken, SQL Server und PostgreSQL.

Ebenso wie die Cloud-Angebote von Microsoft Azure und die IBM-PaaS-Plattform Bluemix greift AWS auf das Konzept der Microservices zurück. Beispiele sind Amazon S3, Amazon Simple Notification Service (SNS), Amazon Elastic Block Storage (ELB) und die Data-Warehouse-Lösung Amazon Redshift. Aus solchen Mikrodiensten können Nutzer in Kombination mit anderen Cloud-Services modulare Applikationen zusammenstellen. Der Ansatz hat den Vorteil, dass jedes Modul separat erweitert und angepasst werden kann, ohne dass die komplette Anwendung in ihrer Funktion beeinträchtigt wird. Allerdings erhöht sich durch diese Architektur die Komplexität.

Be the first to comment