On-Premises oder Cloud? Diese Frage stellt sich Mittelständlern, wenn es um die Datenspeicherung und -verarbeitung geht. Ein Kosten-Nutzen-Vergleich. [...]

Unternehmen haben die Qual der Wahl, wenn es um die Speicherung der eigenen Unternehmensdaten geht: Ein Rechenzentrum On-Premises, also auf dem eigenen Betriebsgelände, verspricht zwar umfassende Kontrolle über Hard- und Software. Allerdings sind Anschaffung, Betrieb und Wartung mit hohen Kosten verbunden, die insbesondere für Mittelständler nicht einfach zu stemmen sind.

Abhilfe versprechen Cloud-Lösungen, die von einem der großen Cloud-Provider oder auch einem anderen (lokalen) Dienstleister bereitgestellt werden. Hier stehen IT-Infrastruktur und Anwendungen per Serverzugriff zur Verfügung. Der Anbieter spielt regelmäßig Updates auf und kümmert sich um die Hardware, ohne dass es zu Unterbrechungen im Betrieb kommt. Im Folgenden werden die wichtigsten Unterschiede zwischen On-Premises und Cloud-Lösung dargelegt.

Cloud vs. On-Premises: Grundlegende Entscheidungskriterien

Vor der Entscheidung für eine On-Premises-Installation oder eine Cloud-Lösung sollte im Unternehmen eine umfassende Analyse des Ist-Zustands von Software- und Hardwarearchitektur sowie der zukünftig benötigten Features erfolgen. Grundlegende Kriterien dabei sind:

- Time to Market: Wie lange würde es dauern, die analoge Funktionalität entweder On-Premises durch die eigene IT aufbauen zu lassen oder in der Cloud zu beziehen? Im Bereich der Authentisierung dauert die Umsetzung eines On-Premises-Projekts in der Regel zwei bis fünf Mal länger als beim Ausrollen einer Cloud-Lösung, abhängig von der Ausgangslage und den verfügbaren Ressourcen.

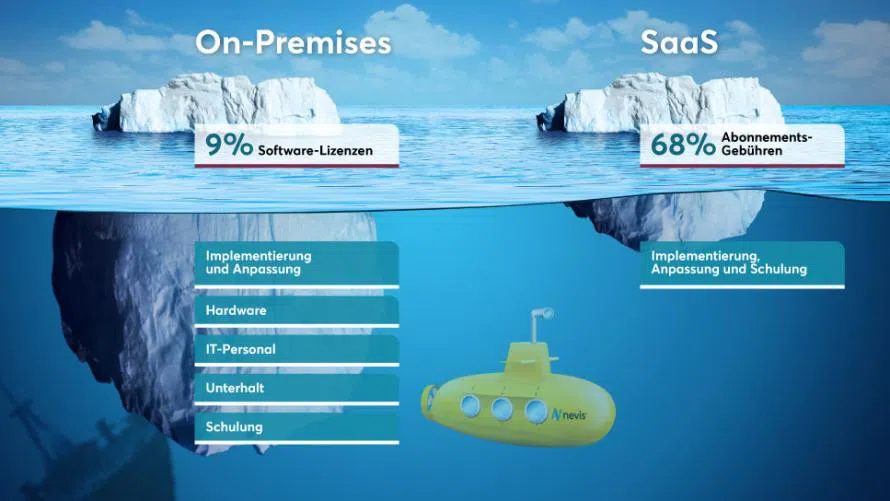

- Kosten: Bei einer Vollkostenrechnung über einen Zeitraum von drei bis fünf Jahren schneiden SaaS-Ansätze praktisch immer besser ab. Insbesondere gilt das, wenn Vorinvestitionen, Projektkosten, Abschreibung und Ersatz der Hardware, laufende Betriebskosten etc. korrekt ausgewiesen werden. Bei den verbrauchsbasierten Abrechnungsmodellen von Cloud-Dienstleistungen entfallen die Vorinvestitionen praktisch ganz. Die laufenden Betriebskosten sind gut planbar.

- Infrastruktur und Security: Die Infrastrukturen der großen Cloud-Anbieter ermöglichen eine kosteneffiziente Umsetzung von hochverfügbaren Infrastrukturen. Das umfasst den Einsatz mehrerer Data Center, die zum einen eventuelle Ausfälle kompensieren können (Georedundanz) und zum anderen sicherstellen, dass Latenzzeiten so gering wie möglich gehalten werden (Geoproximity). Darüber hinaus verfügen diese Anbieter standardmäßig über sehr gute Sicherheitsbausteine, etwa für die Datenverschlüsselung, welche einfach ausgerollt und betrieben werden können.

Für ein mittelständisches Unternehmen stellt sich daher die Frage: Was würde es uns kosten, wenn wir die gleichen Infrastrukturanforderungen mit einem konventionellen Ansatz (On-Prem mit mehreren Rechenzentren) umsetzen und betreiben müssten? Der Kleinbetrieb wird schnell zu dem Ergebnis kommen, dass dieses Unterfangen zu teuer ist. Oder anders formuliert: Dank Cloud-Ansätzen sind nun auch kleine und mittelständische Unternehmen in der Lage, hochverfügbare IT-Infrastrukturen zu betreiben, die zuvor global agierenden Großunternehmen vorbehalten waren.

On-Premises oder Cloud: Eine individuelle Frage

Schon anhand der genannten Entscheidungskriterien wird deutlich: Welche Lösung für das eigene Unternehmen optimal ist, hängt von einer Vielzahl von Faktoren ab, die genau geprüft werden müssen. Eine Modellrechnung, die lediglich den Umsatz und die Größe der IT-Abteilung berücksichtigt, ist hierbei wenig aussagekräftig und kann sogar in die Irre führen. In der Praxis haben sich jedoch fünf Faktoren herauskristallisiert, die IT-Verantwortliche bei der Planung im Hinterkopf behalten sollten. Von wenigen Ausnahmen abgesehen überwiegen dabei die Vorteile von Cloud-Lösungen gegenüber dem Aufbau eines eigenen Data Centers:

- Selbst sehr große Unternehmen – einschließlich die der Telekommunikationsbranche – schaffen es nicht, ähnliche Skaleneffekte wie die global agierenden Cloud-Anbieter zu erzielen. Um kostenseitig konkurrenzfähig zu bleiben, lagern auch sie Services in die Public Cloud der Hyperscaler aus.

- Die Preise der Cloud-Anbieter sind transparent. Die meisten bieten einen Preisrechner an, mit dem sich die Kosten für eine bestimmte Lösung relativ genau bestimmen lassen. Das Finanzierungsmodell kann gerade für kleine und mittlere Unternehmen (KMUs) wesentlich attraktiver sein als eine Lösung in Eigenregie: Es sind keine großen Vorinvestitionen nötig und der Preis korreliert mit der Nutzung. In aller Regel korreliert die intensivere Nutzung auch mit der Geschäftsentwicklung – daher sollten die zwangsläufig steigenden Opex-Kosten für die meisten Firmen kein großes Problem sein. Im Gegenteil: Geht die Nutzung etwa aufgrund eines schwierigeren Marktumfelds zurück, reduzieren sich auch die Kosten entsprechend.

- Um On-Premises-Infrastrukturen auf einem mit der Cloud vergleichbaren Level von Sicherheit und Hochverfügbarkeit zu halten, werden sehr gut ausgebildete Fachkräfte benötigt, die der Arbeitsmarkt derzeit einfach nicht hergibt. Häufig trägt der Fachkräftemangel sogar dazu bei, dass der Weg in die Cloud gegangen wird.

- On-Premises-Installationen können durch die Kombination aus längeren Projektlaufzeiten (Time-to-Market von digitalen Lösungen) sowie hohen IT-Kosten zu erheblichen Wettbewerbsnachteilen gegenüber Mitbewerbern mit konsequenter Cloud-Strategie führen.

- Der wichtigste und berechtigste Treiber für On-Premises-Lösungen sind regulatorische Anforderungen. Doch auch bei den Regulatoren wie BAFIN, FINMA oder BAS ist ein Umdenken im Gang.

Wie gezeigt wurde, lohnen sich On-Premises-Ansätze rein wirtschaftlich betrachtet in den meisten Fällen nicht einmal bei Großunternehmen mit umfassenden IT-Ressourcen. Ausnahmefälle, in denen auf On-Premises-Lösungen nicht verzichtet werden kann, existieren – wie bereits erwähnt – vor allem in hoch regulierten Bereichen wie zum Beispiel im Behördenumfeld oder dem Gesundheitswesen.

Diese rechtlichen Hürden sind vor allem Folge des 2018 in Kraft getretenen „Cloud Act“ der US-Regierung: Das Gesetz gestattet es den dortigen Behörden, Zugriff auf sämtliche Daten von in den USA ansässigen Unternehmen anzufordern – auch wenn diese auf Servern außerhalb der Vereinigten Staaten gespeichert sind. Der Cloud Act beeinträchtigt also den Spielraum für in den USA ansässige Cloud-Anbieter, die strikte Geheimhaltung der bei ihnen hinterlegten Daten zu garantieren. Im Kontext des Cloud Acts reduziert sich daher die Diskussion in der Regel auf die Frage: Wer hat Zugriff auf die Schlüssel, die etwa für die Verschlüsselung der Datenbank verwendet werden? Im Zweifelsfall müssen Unternehmen hier entweder auf eine On-Premises-Lösung setzen oder – sofern regulatorisch zulässig – auf einen nicht in den USA ansässigen Cloud-Dienstleister.

Einen weiteren Spezialfall bilden bestimmte Anwendungen in Industrie und Forschung – etwa spezielle Messsysteme, die nur in Zusammenhang mit spezifischer Hardware (Sensoren, optimierte Prozessoren für Echtzeitverarbeitung etc.) funktionieren. In solchen Fällen kann ein On-Premises-Betrieb sinnvoll sein. Auch Hybrid-Lösungen bieten sich hierfür an: Während die Spezial-Hardware wie gehabt On-Premises läuft, können andere Teile der IT-Infrastruktur in die Cloud ausgelagert werden.

On-Prem vs. Cloud: Abhängigkeiten im Vergleich

Bedenken bezüglich der Datenhoheit werden im Kontext von Cloud-Lösungen immer wieder diskutiert. Besteht die Gefahr, dass Unternehmen sich in eine starke Abhängigkeit von Cloud-Anbietern begeben, wenn sie deren Lösungen nutzen? Und wie ist es um die Weiternutzung gesammelter Daten bestellt, wenn der Vertrag mit einem Cloud-Anbieter ausläuft?

Die Befürchtung, man sei auf Gedeih und Verderb an den einmal gewählten Anbieter gebunden, entbehrt jeder Grundlage, denn die Frage der Datenhoheit und Datenexportierbarkeit ist bei Cloud-Ansätzen gesetzlich und technisch klar geregelt. Die Daten gehören dem Kunden, die Exportierbarkeit ist gegeben. Damit haben Kunden zum einen die Möglichkeit, den Cloud-Anbieter zu wechseln, können zum anderen aber auch von Anfang an bewusst einen Multi-Cloud-Ansatz fahren.

In der Frage der Abhängigkeit von IT-Lösungen und deren Verfügbarkeit wird jede Firma akzeptieren müssen, dass diese immer gegeben ist. Die Frage ist vielmehr, welche Abhängigkeiten die größeren Risiken bergen. Bei On-Premises-Lösungen besteht häufig das Risiko, dass kritisches Know-how auf nur wenige Personen verteilt ist. Da die On-Premises-Infrastrukturen nicht standardisiert sind, stehen extern hinzugezogene Spezialisten oft vor der Herausforderung, sich erst einmal in die Systemlandschaft eindenken zu müssen, bevor sie überhaupt tätig werden können. Welche Verzögerungen dadurch entstehen, lässt sich leicht an der Zahl der geöffneten Support-Tickets ablesen. Bei Unternehmen mit On-Premises-Umgebungen haben diese oft zu 70 oder 80 Prozent einen starken Bezug zur Infrastruktur des Unternehmens. Externe Spezialisten müssen in solchen Fällen also zuerst die Infrastruktur ihres Kunden verstehen. Die Problemanalyse beansprucht in diesen Fällen 80 bis 90 Prozent der aufgewendeten Zeit, die Problemlösung dagegen nur zehn bis 20 Prozent.

Im Gegensatz dazu ist bei Cloud-Ansätzen die Infrastruktur weitgehend standardisiert. Das hat per se schon einmal einen positiven Effekt auf viele betriebliche Themen und macht auch die Supportunterstützung einfacher. Außerdem lassen sich Themen wie Hochverfügbarkeit und Geo-Redundanz zu vertretbaren Kosten umsetzen, was wiederum andere Risiken massiv senken kann. Auch bei der Datenhoheit ist also eine Gesamtbetrachtung aller Risiken angeraten. Das Thema Abhängigkeit ist nur eines von vielen.

Datenspeicherung: Länderspezifische Anforderungen

Einige Staaten wie Brasilien oder Russland fordern explizit eine Datenspeicherung innerhalb ihres Landes. Diese Anforderung gilt gleichermaßen für On-Premises– wie auch für Cloud-Lösungen. Für ein mittelständisches Unternehmen mit On-Premises-Infrastruktur würde das bedeuten, in solchen Ländern physische Hardware installieren zu müssen und ein Team vorzuhalten, das sich um Updates und Wartung kümmern kann.

Bei einem Cloud-Ansatz gilt es zu beachten, dass der gewählte Cloud-Anbieter für die jeweiligen Länder Data-Locality anbietet. Physischer Standort aller verwendeten Server ist dann das jeweilige Staatsgebiet, so dass alle gesetzlichen Regelungen eingehalten werden. Falls dies gegeben ist, kann relativ einfach eine neue Cloud Location mit den notwendigen Services aufgebaut werden.

*Stephan Schweizer blickt auf 22 Jahre Berufs- und Managementerfahrung im Bereich Sicherheitslösungen zurück. In dieser Zeit war er federführend beim Aufbau Betrieb und der Weiterentwicklung der Nevis-Infrastruktur. Seit 2020 verantwortet er als Chief Executive Officer der neu gegründeten Nevis Security AG, einem Spin-off der AdNovum Informatik AG, den strategischen Geschäftsaufbau der Nevis Security Suite auf dem internationalen Markt.

Hallo,

aus der Praxis kann ich den Bericht von Hr. Schweizer definitiv NICHT bestätigen und viele Aspekte wurden falsch oder gar nicht berücksichtigt.

Da wir grundsätzlich IT Infrastruktur, Groupware und Collaboration Services mit Enterprise Open Source Technologie umsetzen, ergibt sich ein gänzlich anderes Bild:

– Kosten

— Die TCO (von der Hardwareanschaffung, Abschreibung über 5 Jahre, Projektkosten und Betriebsführung) sind ca. 30% bis 50% günstiger.

— Kostenplanung: Preisanpassungen kann man eigentlich nur akzeptieren (zB: Microsoft erhöht Microsoft 365 Preise im März um bis zu 20% – was tun?

– Abhängigkeit

— Einen lokalen IT-Dienstleister zu wechseln ist zwar mit einem Aufwand verbunden aber in der Regel – mit einer guten Planung – ohne größere Probleme möglich. Einen Cloud Anbieter zu wechseln ist in vielen Fällen kaum mehr m öglich.

— Neben dem Cloud Anbieter selber ist das Unternehmen auch von der Politik abhängig. zB: USA vers. China – Huawei Sperre oder USA vers. Venezuela Adobe Konten Sperre, usw… Wer sagt, dass es nicht auch uns treffen kann, speziell wenn wir diplomatische Beziehungen zu Russland pflegen?

– Alle IT-Services laufen über die Internetleitung. Bei einem Ausfall geht gar nichts mehr.

Verfügbarkeit

— Leider wird immer wieder propagiert, dass die großen Public Clouds immer verfügbar sind. Diese Information stimmt leider nicht. Auch große Tech Konzerne haben Ihre Ausfälle – siehe https://allestörung.at

– Alle IT-Services laufen über die Internetleitung. Bei einem Ausfall geht gar nichts mehr.

– Mit einem Vernünftigen Setup, lässt sich auch bei einem onPremis Betrieb eine sehr hohe Verfügbarkeit erzielen.

IT-Security

— Auch hier muss man „blind“ vertrauen, dass der Cloud Anbieter seine Hausaufgaben macht. In der Branche ist ja längst bekannt, nicht ob die Großen gehackt werden, sondern wann. Und dann?

— des weiteren sind viele Services (aus meiner Sicht) unvollständig. Beispielsweise bieten viele kein Backup an bzw. muss sich das Unternehmen selber darum kümmern. Ein menschlicher Fehler könnte fatal sein.

– Cloud Act

— bedeutet, dass die US Behörden auf diese Daten zugreifen können (müssen). Damit steht Ihnen das KnowHow von Unternehmen und die Daten von der öffentlichen Verwaltung zur Verfügung.

– Wertschöpfung

— bei Public Cloud Services findet kaum Wertschöpfung in Österreich bzw. in der EU statt.

— im Gegensatz zu Open Source Lösungen (onPrem bzw. im DataCenter/Rechenzentrum) verbleibt ein Großteil in Österreich oder in der EU. Das sind Unternehmen die hier Mitarbeiter beschäftigen und ihre Steuern bezahlen!

– Fachkräftemangel

— Auf den Fachkräftemangel mit Cloud Services zu reagieren bedeutet langfristig, dass wir einen der wichtigsten Zukunftsthemen unserer Wirtschaft und Gesellschaft anderen überlassen und nicht selber in die Bildung investieren wollen. Das halte ich für komplett den falschen Weg. Wissen, Innovation und Fortschritt, kann nur mit gut ausgebildeten Mitarbeitern funktionieren und hier muss investiert werden.

– Individualisierung

— Jedes Unternehmen hat individuelle Anforderungen. Ein Public Cloud Service ist ein Massenprodukt, welches gewisse Features beinhaltet oder eben auch nicht. Schnittstellen, Anpassungen, Individualisierungen sind hier kaum möglich und würde Innovationen bremsen.