Das datengetriebene Unternehmen ist längst keine Illusion mehr. Selbstlernende Maschinen und Analyse-algorithmen durchkämmen riesige Datenberge. Die daraus resultierenden Erkenntnisse werden mehr und mehr zur Basis von wichtigen Unternehmensentscheidungen. Doch das funktioniert nur, wenn die zugrunde liegenden Daten passen und richtig sind. Ansonsten droht das bekannte "Garbage in - Garbage out". Unternehmen müssen sich deshalb verstärkt um Data Governance und Datenqualität kümmern. [...]

Sie arbeitet 24 Stunden, 365 Tage im Jahr, braucht keinen Schlaf und keinen Kaffee – und ist trotzdem stets hellwach. Die Rede ist von „Vital“, Board-Mitglied der in Hongkong ansässigen Investoren-Company Deep Knowledge Venture, die sich auf Projekte im Pharma- und Medizinbereich konzentriert. Vital kann wie die anderen Manager im Board von DKV mit über Investitionsvorhaben abstimmen. Nur hebt sie dabei keine Hand – Validating Investment Tool for Advancing Life Sciences, so ihr voller Name, ist ein in Software gegossener Algorithmus, entwickelt von der britischen Softwarefirma Aging Analytics. Die Maschine tut nichts anderes, als riesige Datenmengen zu sammeln, auszuwerten und anhand der so gewonnenen Ergebnisse den Kollegen Ratschläge zu geben.

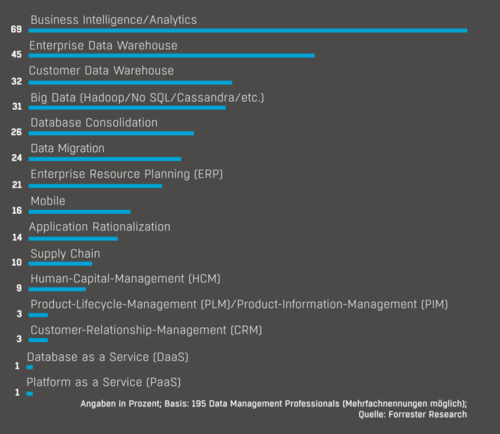

Vital ist ein gutes Beispiel für das derzeit so oft beschworene datengetriebene Business. Das funktioniert allerdings nur, wenn die Daten, auf denen das Analysewerk beruht, korrekt sind. Die notwendige Datenqualität und Data Governance sicherzustellen, ist jedoch alles andere als einfach. Gerade in Zeiten von Big Data, in denen die Menge der Daten, die Zahl der Datenquellen und die Varianz der Datentypen ständig zunehmen, wachsen auch die Herausforderungen. Die Tatsache, dass sich Big Data zunehmend zum Mainstream in vielen Unternehmen entwickle, lasse auch das Risiko steigen, dass Daten verwendet würden, die sich nicht dafür eigneten, die gesetzten Ziele zu erreichen, sagt Michele Goetz, Analystin von Forrester Research.

Das Bewusstsein, etwas in Sachen Data Governance unternehmen zu müssen, scheint bei den meisten Verantwortlichen angekommen zu sein. So hat sich beispielsweise die Zahl der Chief Data Officers (CDOs) im vergangenen Jahr verdoppelt, berichtete Kurt Schlegel, Research Vice President von Gartner, auf dem Business Intelligence und Analytics Summit Mitte Oktober in München.

Jemand, der sein Hauptaugenmerk darauf richtet, wie Daten im Unternehmen gesammelt, aufbereitet, verteilt und analysiert werden, dürfte in Zukunft immer stärker gefragt sein – vor allem auch um die Organisation rund um die Datenflüsse in den Griff zu bekommen. Ein zentrales BI-Team, dessen Streben allein darauf ausgerichtet ist, eine „Single Version of Truth“ zu finden und zu bewahren, sei heute aber nicht mehr zeitgemäß. Das gehe auf Kosten der für die neuen Analytics-Aufgaben notwendigen Agilität und Flexibilität, warnen die Gartner-Analysten.

DATA WAREHOUSE, REPORTING UND DIE DATENINTEGRATION

Aber auch die traditionellen Aufgaben rund um Data Warehouse, Reporting und die Datenintegration müssten weiter erledigt werden, sagt Schlegel. Die Experten von Gartner plädieren daher für einen bimodalen Ansatz rund um die Daten. Einerseits brauche es eine einheitliche klare Strategie, die notwendige Sicherheit und eine zentrale Kontrolle, was mit Daten im Unternehmen passiert. Auf der anderen Seite müssten die Unternehmen aber auch dafür sorgen, Freiraum für neue Ideen rund um Daten zu schaffen. Mitarbeiter müssten über den Tellerrand schauen können.

Das erfordere eine flexible und agile Organisation, die auch Fehler toleriere. Gartner geht davon aus, dass sich in den Fachabteilungen im Zuge der stärkeren Verbreitung von Self-Service-BI selbständig Datenspezialisten heranbilden werden. Die Zahl dieser „Citizen Data Scientists“ werde in den beiden kommenden Jahren fünfmal so schnell wachsen wie die der speziell ausgebildeten Data Scientists.

Diese Auffächerung versetzt zwar möglicherweise mehr Mitarbeiter in die Lage, ihren Job mit Hilfe von Analytics besser zu erledigen, macht aber zugleich die Aufgabe der für Data Governance verantwortlichen Manager nicht einfacher. Nicht einmal jedes zehnte Unternehmen werde im kommenden Jahr Kontrollmechanismen für die eigenen Self-Service-BI-Aktivitäten eingerichtet haben, mutmaßt Thomas Oestreich, Research Director für den Bereich Business Intelligence und Analytics bei Gartner.

Unternehmen müssten sich verstärkt um Data Governance kümmern. Dabei gehe es vor allem darum, die Balance zwischen den neuen Möglichkeiten ausgefeilter Analysewerkzeuge und den damit verbundenen Risiken zu finden. Doch damit tun sich die Verantwortlichen offenbar schwer. Fast jedes zweite Unternehmen habe dafür keine Strategie, berichtet Oestreich unter Berufung auf eine Umfrage.

Be the first to comment