Für Big-Data-Analysen brauchen Unternehmen nicht unbedingt einen eigenen Hadoop-Cluster. Wir stellen die wichtigsten Tools aus der Cloud vor, mit denen sich große Datenmengen verwalten, strukturieren und analysieren lassen. [...]

AMAZON WEB SERVICES (AWS)

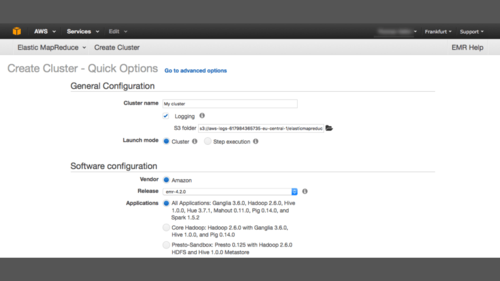

Mit Elastic MapReduce (EMR) bietet Amazon Web Services einen umfangreichen Big-Data-Service auf der hauseigenen Cloud-Plattform. Die dort verfügbaren AMIs (Amazon Machine Image) enthalten bereits ein bootfähiges Linux-Betriebssystem, Hadoop und weitere Software, die zum Betrieb des Clusters notwendig ist. Die Version 4.2.0 unterstützt neben Hadoop auch Ganglia, Hive, Hue, Pig, Mahout und Spark. Als Datenbanken stehen neben der NoSQL-Lösung DynamoDB und der relationalen Datenbank RDS auch das Big-Data-Warehouse Redshift zur Verfügung, das auf PostgreSQL basiert.

Mit Kinesis bietet der Hersteller zudem einen Service zur Echtzeitanalyse großer Mengen von Streaming-Daten; über AWS IoT (Beta) lassen sich Sensoren, Aktoren, Embedded Devices oder Wearables mit der Cloud-Plattform verbinden. Ergänzt wird das Angebot durch mehr als 300 Applikationen von Drittanbietern, die über den AWS Marketplace abgerufen werden können.

Eine Hadoop-Instanz lässt sich auch manuell auf Knoten der Elastic Compute Cloud (EC2) einrichten. Zur Speicherung der Initialdaten nutzt man sinnvoller Weise Amazon S3, da der Datentransfer zwischen S3 und EC2 kostenlos ist. Dort legt man auch die Ergebnisse ab, bevor der Cluster heruntergefahren wird. Temporäre Daten hält man dagegen besser im Hadoop Distributed File System (HDFS) vor.

Amazon bietet eine 12-monatige Testphase, in der ein Kunde unter anderem 750 Stunden pro Monat eine EC2-Instanz (t2.micro-Instance) und 5 GB Standard-S3-Speicher nutzen kann. Auch einige Big-Data-Anwendungen wie DynamoDB, AWS IoT und Redshift lassen sich kostenlos testen, nicht aber EMR.

AMAZON WEB SERVICES – LEISTUNGSUMFANG BIG-DATA-ANALYSE

- Amazon Elastic MapReduce (EMR): Hadoop und zahlreiche Big-Data-Frameworks als Service (Hive, Hue, Pig, Hbase, Impala, Mahout, Spark)

- Amazon Kinesis: Echtzeitanalyse von Streaming-Daten

- Amazon Machine Learning: Erstellung von Vorhersagemodellen

- Amazon Elasticsearch Service: Suche, Protokollanalyse und Datenvisualisierung

- AWS IoT (Beta): Kommunikation mit Smart Devices

- diverse Datenbanken / Warehouses (DynamoDB, RDS, Redshift)

AMAZON WEB SERVICES – FAZIT

Pro

- kostenloser Datentransfer zwischen Speicher (S3) und Computing-Plattform (EC2)

- wichtigste Systeme vorinstalliert

- Hadoop-Cluster können bedarfsorientiert auf- und auch wieder abgebaut werden

Contra

- manuelle Hadoop-Installation aufwendig

- wenn Daten in S3 statt in HDFS gespeichert werden, ist die Latenz recht hoch

- EMR nicht im kostenlosen AWS-Kontingent enthalten

Be the first to comment