Für Big-Data-Analysen brauchen Unternehmen nicht unbedingt einen eigenen Hadoop-Cluster. Wir stellen die wichtigsten Tools aus der Cloud vor, mit denen sich große Datenmengen verwalten, strukturieren und analysieren lassen. [...]

GOOGLE CLOUD PLATFORM

Das Google-Angebot an Big-Data-Services ist sehr umfangreich. Neben Open-Source-Lösungen wie Hadoop gehören dazu auch von Google selbst entwickelte Produkte wie BigQuery oder Dataflow. Für Hadoop bietet Google einen „Cloud Launcher„, mit dem sich nach Angaben des Providers in wenigen Minuten ein Cluster zur verteilten Big-Data-Analyse aufbauen lässt. Es besteht aus drei virtuellen Maschinen (n1-standard-4) inklusive 10 GB Boot Disk sowie drei Standardspeicherplatten mit 500 GB Kapazität. Die installierte Hadoop-Version 2.4.1 ist allerdings nicht ganz auf der Höhe der Zeit. Die neueste stabile Version von Hadoop hat die Versionsnummer 2.7.1.

Weitere Big-Data-Lösungen lassen sich ebenfalls mit wenigen Klicks per Launcher installieren, darunter hoch skalierbare Datenbanken wie Cassandra, MongoDB und Redis sowie Elasticsearch, ein Open-Source-Tool zur Echtzeitanalyse. Elasticsearch ist aber nicht die einzige Möglichkeit für die Echtzeitanalyse auf der Google-Plattform: Eine weitere ist die Kombination aus dem Cluster-Manager Kubernetes, der In-Memory-Datenbank Redis und dem Abfragesystem BigQuery. In der zweiten Variante können Anwender Kubernetes und BigQuery mit Pub/Sub verknüpfen, einem Real-Time-Messaging-System. Für Logging-Zwecke lässt sich BigQuery schließlich auch noch mit dem Open-Source-Datensammler Fluentd kombinieren.

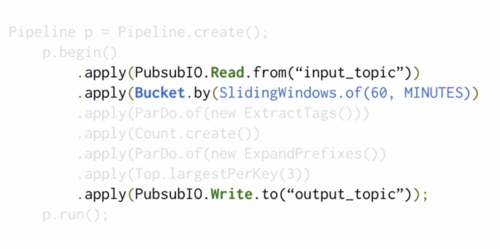

Im Jahr 2014 hat Google außerdem den Big-Data-Service „Cloud Dataflow“ gestartet. Google Cloud Dataflow erlaubt die Analyse großer Datenmengen sowohl im Batch- als auch im Streaming-Modus nahezu in Echtzeit. Der Code ist für beide Methoden gleich, die Entscheidung trifft der Entwickler durch die Wahl der Datenquelle. Die Programmierung ist sehr einfach. Für die Analyse muss ein Entwickler die logischen Schritte nur in eine Sequenz simpler Befehle übersetzen. Um zum Beispiel ein Zeitfenster für eine Streaming-Analyse zu definieren, genügt eine Zeile Code. Google verspricht außerdem eine Skalierbarkeit bis in den Exabyte-Bereich und eine nahtlose Integration in andere Systeme.

Die Google Cloud-Services lassen sich 60 Tage lang testen. Der Anbieter stellt dafür ein Guthaben von 300 Dollar zur Verfügung.

GOOGLE CLOUD PLATFORM – LEISTUNGSUMFANG BIG-DATA-ANALYSE

- Cloud Launcher (Click to Deploy) unter anderem für Hadoop, Cassandra, MongoDB

- Echtzeitanalyse mit Elasticsearch oder mit BigQuery in Kombination mit Kubernetes, Redis / Pub/Sub beziehungsweise Fluentd.

- Cloud Dataflow: Managed Service für Batch- und Streaming-Analysen

GOOGLE CLOUD PLATFORM – FAZIT

Pro

- Einfache Installation von Hadoop-Clustern und anderen Big-Data-Lösungen

- Cloud Dataflow erlaubt auch weniger erfahrenen Anwendern den Einstieg in die Big-Data-Analyse

Contra

- Im Cloud Launcher sind nicht immer die aktuellsten Versionen verfügbar

Be the first to comment