Für Big-Data-Analysen brauchen Unternehmen nicht unbedingt einen eigenen Hadoop-Cluster. Wir stellen die wichtigsten Tools aus der Cloud vor, mit denen sich große Datenmengen verwalten, strukturieren und analysieren lassen. [...]

MICROSOFT AZURE

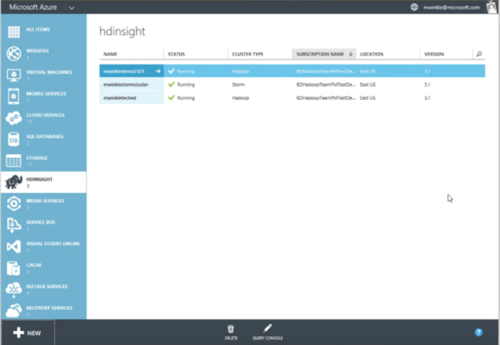

Auch Microsoft verspricht auf seiner Public Cloud Azure eine Hadoop-Installation in wenigen Minuten. Zuständig dafür ist der „Data-Lake“-Dienst „HDInsight„, der darüber hinaus auch zur Verwaltung von MapReduce-, Pig-, Hive-, HBase-, Storm- oder Spark-Projekten verwendet werden kann. Laut Anbieter lassen sich Analysen bis in den Petabyte-Bereich skalieren. Der Anwender kann sowohl per Linux als auch per Windows auf das Cluster zugreifen, Hadoop-Daten in Excel visualisieren oder lokale Hadoop-Cluster mit der Cloud-Instanz verknüpfen. Vorsicht ist allerdings geboten, wenn mehrere HDInsight-Cluster mit demselben Blob Storage verknüpft werden. Laut Microsoft kann es zu Fehlern und Systemabstürzen kommen. Der Hersteller empfiehlt, einen zusätzlichen Storage-Account anzulegen, falls mehrere HDInisght-Cluster auf dieselben Daten zugreifen sollen.

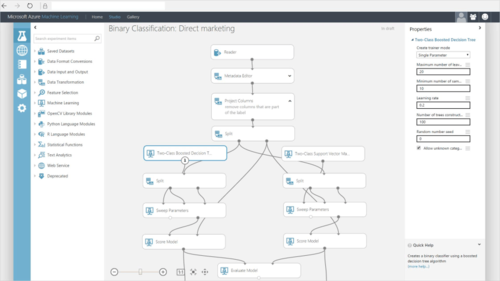

Ein weiterer Big-Data-Analyse-Service von Microsoft ist „Data Lake Analytics„. Er basiert auf YARN und soll dank der Abfragesprache „U-SQL“ einfach zu bedienen sein. U-SQL kombiniert SQL mit C#-Ausdrücken und ist so für die meisten Entwickler leicht erlernbar. Mit „Machine Learning“ lassen sich auf Azure erfahrungsbasierte Analysealgorithmen über einen Webservice definieren und ausführen, wie sie zum Beispiel zur Entwicklung von Vorhersagemodellen bei Predictive Analytics verwendet werden. Echtzeitanalysen kann der Anwender mit „Stream Analytics“ durchführen und zur Datenerfassung mit „Event Hubs“ kombinieren, einer Plattform, die Log-Daten schnell in großen Mengen aufzeichnen kann, wie sie etwa auf Webseiten, mobilen Endgeräten oder Industrieanlagen anfallen. Microsoft bietet die Möglichkeit, die Services 30 Tage mit einem Guthaben von 170 Euro zu testen.

Mit der „Cortana Analytics Suite“ bietet Microsoft außerdem ähnlich wie Google mit Cloud Dataflow einen einfacheren Einstieg in die Big-Data-Analyse. Sie verbindet die bestehenden Big-Data-Cloud-Angebote mit einer „Perceptive Intelligence“ genannten Auswahl an Werkzeugen zur intelligenten Erfassung und Verarbeitung von Daten. Dazu zählen Microsofts „Siri“-Alternative „Cortana“ sowie Tools zur Sprach- und Gesichtserkennung und zur Analyse von Texten oder Bildern.

MICROSOFT AZURE – LEISTUNGSUMFANG

- HDInsight: Bereitstellung verwalteter Hadoop-Cluster

- Data Lake Analytics: Verteilter Dienst zur Big-Data-Analyse

- Machine Learning: Erfahrungsbasierte Erstellung von Vorhersagemodellen

- Stream Analytics: Echtzeitanalyse von Datenströmen

- Cortana Analytics Suite: Gemanagter Big-Data-Service für den einfachen Einstieg

MICROSOFT AZURE – FAZIT

Pro

- großes Angebot an Analysetools

- Integration anderer Microsoft-Produkte (Windows, Excel)

- Cortana Analytics Suite bietet umfassendes Angebot für Prognosen, Entscheidungsfindung und Automatisierung

Contra

- Probleme, wenn mehrere HDInsight-Cluster auf den denselben Blob Storage zugreifen

Be the first to comment