Die Künstliche Intelligenz boomt – aber sie ist nicht vom Himmel gefallen. Was wir heute erleben, ist das Ergebnis von Gedanken und Tüfteleien genialer Vordenker. Eine kleine Geschichte der KI zeigt die wichtigsten Stationen - von Turing bis Watson. [...]

EXPERTENSYSTEME – DIE KI WIRD PRAKTISCH: 1975 BIS 1985

In der dritten Ära ab Mitte der 70er Jahre löste man sich von den Spielzeugwelten und versuchte praktisch einsetzbare Systeme zu bauen, wobei Methoden der Wissensrepräsentation im Vordergrund standen. Die KI verließ ihren Elfenbeinturm und KI-Forschung wurde auch einer breiteren Öffentlichkeit bekannt.

Die von dem US-Informatiker Edward Feigenbaum initiierte Expertensystem-Technologie beschränkt sich zunächst auf den universitären Bereich. Nach und nach entwickelten sich Expertensysteme jedoch zu einem kleinen kommerziellen Erfolg und waren für viele identisch mit der ganzen KI-Forschung – so wie heute für vieleMachine Learning identisch mit KI ist.

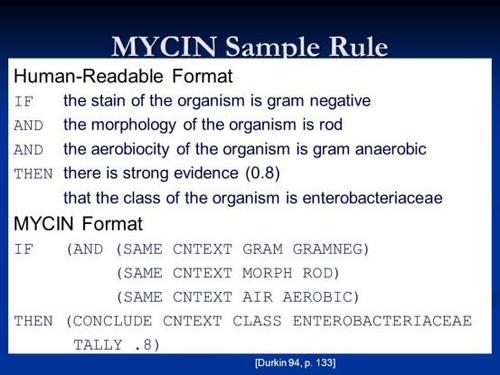

In einem Expertensystem wird das Wissen eines bestimmten Fachgebiets in Form von Regeln und großen Wissensbasen repräsentiert. Das bekannteste Expertensystem war das von T. Shortliffe an der Stanford University entwickelten MYCIN. Es diente zur Unterstützung von Diagnose- und Therapieentscheidungen bei Blutinfektionskrankheiten und Meningitis. Ihm wurde durch eine Evaluation attestiert, dass seine Entscheidungen so gut sind wie die eines Experten in dem betreffenden Bereich und besser als die eines Nicht-Experten.

Ausgehend von MYCIN wurden eine Vielzahl weiterer Expertensysteme mit komplexerer Architektur und umfangreichen Regeln entwickelt und in verschiedensten Bereichen eingesetzt. In der Medizin etwa PUFF (Dateninterpretation von Lungentests), CADUCEUS (Diagnostik in der inneren Medizin), in der Chemie DENDRAL (Analyse der Molekularstruktur), in der Geologie PROSPECTOR (Analyse von Gesteinsformationen) oder im Bereich der Informatik das System R1 zur Konfigurierung von Computern, das der Digital Equipment Corporation (DEC) 40 Millionen Dollar pro Jahr einsparte.

Auch das im Schatten der Expertensystem-Euphorie stehende Gebiet der Sprachverarbeitung orientierte sich an praktischen Problemstellungen. Ein typisches Beispiel ist das Dialogsystem HAM-ANS, mit dem ein Dialog in verschiedenen Anwendungsbereichen geführt werden kann. Natürlichsprachliche Schnittstellen zu Datenbanken und Betriebssystemen drangen in den kommerziellen Markt vor wie INTELLECT, F&A oder DOS-MAN.

DIE RENAISSANCE NEURONALER NETZE: 1985 BIS 1990

Anfang der 80er Jahre kündigte Japan das ehrgeizige „Fifth Generation Project“ an, mit dem unter anderem geplant war, praktisch anwendbare KI-Spitzenforschung zu betreiben. Für die KI-Entwicklung favorisierten die Japaner die Programmiersprache PROLOG, die in den siebziger Jahren als europäisches Gegenstück zum US-dominierten LISP vorgestellt worden war. In PROLOG lässt sich eine bestimmte Form der Prädikatenlogik direkt als Programmiersprache verwenden. Japan und Europa waren in der Folge weitgehend PROLOG-dominiert, in den USA setzte man weiterhin auf LISP.

Mitte der 80er bekam die symbolische KI Konkurrenz durch die wieder auferstandenen neuronalen Netze. Basierend auf Ergebnissen der Hirnforschung wurden schon in den vierziger Jahren durch McCulloch, Pitts und Hebb erste mathematische Modelle für künstliche neuronale Netze entworfen. Doch damals fehlten leistungsfähige Computer. Nun in den Achtzigern erlebte das McCulloch-Pitts-Neuron eine Renaissance in Form des sogenannten Konnektionismus.

Der Konnektionismus orientiert sich anders als die symbolverarbeitende KI stärker am biologischen Vorbild des Gehirns. Seine Grundidee ist, dass Informationsverarbeitung auf der Interaktion vieler einfacher, uniformer Verarbeitungselemente basiert und in hohem Maße parallel erfolgt. Neuronale Netze boten beeindruckende Leistungen vor allem auf dem Gebiet des Lernens. Das Programm Netttalk konnte anhand von Beispielsätzen das Sprechen lernen: Durch Eingabe einer begrenzten Menge von geschriebenen Wörtern mit der entsprechenden Aussprache als Phonemketten konnte ein solches Netz zum Beispiel lernen, wie man englische Wörter richtig ausspricht und das gelernte auf unbekannte Wörter richtig anwendet.

Doch selbst dieser zweite Anlauf kam zu früh für neuronale Netze. Zwar boomten die Fördermittel, aber es wurden auch die Grenzen deutlich. Es gab nicht genügend Trainingsdaten, es fehlten Lösungen zur Strukturierung und Modularisierung der Netze und auch die Computer vor der Jahrtausendwende waren immer noch zu langsam.

!["Sammlung allerhand auserlesener Reponsorum […]", Johann Hieronymus Hermann, 1736 (c) Österreichische Nationalbibliothek](https://d020f13e.delivery.rocketcdn.me/wp-content/uploads/Kulturpool_Digitalisat_ONB-326x245.jpg)

Be the first to comment