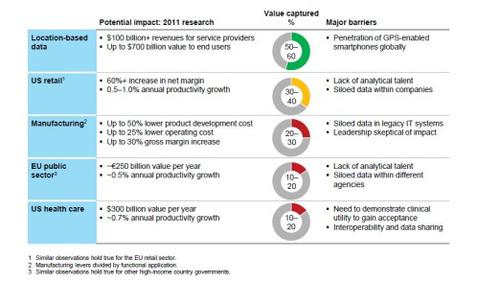

Das McKinsey Global Institute legt in einer aktuellen Studie dar, dass sich ihre 2011 formulierte Erwartungen an Big Data nicht realisiert haben. Dennoch halten die Analysten daran fest, dass sich die enormen Potenziale bald entfalten werden. [...]

Daneben erschwert eine doppelte Aufgabenstellung die Lage vieler Unternehmen. Bevor sie – ausgerüstet mit einer passenden Strategie und dem benötigten Know-how – tatsächlich Honig aus den neuen Möglichkeiten saugen können, gilt es, bestehende Silo- und Legacy-Strukturen zu überwinden und die Datenintegration voranzutreiben. Die Studienautoren rechnen hier in den kommenden Jahren mit einer Fülle an Projekten.

Die Datenanalyse gleicht aus Anwendersicht laut Studie einem Dreiklang: Daten müssen generiert, aggregiert und analysiert werden, damit das profitable Ökosystem vollständig ist. Das größte Datenvolumen fällt – auch was die Use Cases angeht – im Bereich der Aggregation an. Der Wertanteil ist indes bei der Analyse selbst am größten.

„ORTHOGONALE“ DATEN FÜHREN ZU DISRUPTIONEN

Eine besonders disruptive Wirkung geht nach Ansicht der Analysten von „orthogonalen“ Daten aus (orthogonal: griechisch ‚rechtwinklig‘). Der Begriff soll aussagen, dass die Daten hinsichtlich Typ und Quelle gewissermaßen quer zu den etablierten Daten stehen. Ein Beispiel dafür sind Telematikdaten über das Fahrverhalten, die von Unfallversicherern ausgewertet werden können – orthogonal zu den demografischen Daten, die bislang die alleinige mathematische Grundlage für die Prämien darstellen. Laut Studie kann auch das Internet der Dinge als Quelle für orthogonale Daten dienen. Zu denken ist hier beispielsweise an vernetzte Lichtsysteme, die die Zahl der Anwesenden in einem Raum erkennen und den Energieverbrauch dahingehend optimieren.

6 DISRUPTIVE MODELLE

Orthogonale Daten werden nach Einschätzung der Autoren die Wettbewerbsbasis auf vielfältige Weise verändern. Sie werden die bislang genutzten Daten aber nicht ersetzen. „Wahrscheinlicher ist, dass ein Unternehmen orthogonale mit vorhandenen Daten integriert.“ Insgesamt erkennt McKinsey sechs disruptive Modelle, die weitreichende Big Data-Potenziale umreißen. Die Berater haben jeweils auch die Branchen im Blick, die besonders betroffen sein dürften.

1. Durch orthogonale Daten ermöglichte Geschäftsmodelle: Versicherungen, Gesundheitswirtschaft, Personalwesen

2. Echtzeit-Matching auf übergroßer Datenbasis: Transport und Logistik, Automotive, Smart Cities und Infrastruktur

3. Radikale Personalisierung: Healthcare, Handel, Medien, Bildung

4. Massive Datenintegration: Banken, Versicherungen, öffentlicher Sektor, Personalwesen

5. Datengetriebene Entdeckungen: Life Sciences und Pharmazie, Materialwissenschaften, Technologie

6. Verbesserte Entscheidungsfindung: Smart Cities, Healthcare, Versicherungen, Personalwesen

BESONDERES AUGENMERK AUF MACHINE LEARNING

Einen beträchtlichen Teil der Studie widmen die Autoren den jüngsten Fortschritten im Bereich Machine Learning. Lernende Maschinen können laut McKinsey in 80 Prozent der dafür in Frage kommenden Fälle Automatisierung ermöglichen. Ausstrahlung hat das auf diverse Anwendungsfelder: vom Kundendienst über das Logistik-Management und die Analyse medizinischer Werte bis hin zum Schreiben von Literatur – durch Software und ohne menschlichen Autor.

SPRACHE: GIGANTISCHES POTENZIAL VORHANDEN

„Der Wertpotenzial liegt überall, sogar in Branchen, die sich bisher nur langsam digitalisieren“, heißt es in der Studie. „Diese Technologien könnten Produktivitätszuwächse und eine bessere Lebensqualität generieren – einhergehend mit Jobverlusten und anderen Zerrüttungen.“

Untersucht wird in der Studie, welche Voraussetzungen derzeit für Automatisierung bestehen. In 99 Prozent der Fälle geht es bei den betroffenen Aktivitäten um das Erkennen bekannter Muster. Mit 79 beziehungsweise 76 Prozent folgen danach aber bereits das Generieren und das Verstehen von Sprache. Durchbrüche in der Verarbeitung menschlicher Sprache durch Roboter hätten deshalb nach Einschätzung der Analysten ein äußerst disruptives Potenzial.

Die 2011 an Big Data formulierten Erwartungen haben sich also bisher nicht wirklich erfüllt. Dennoch hält das MGI an seiner hohen Messlatte fest. „Data & Analytics erschüttern schon viele Branchen – und die Auswirkungen werden sich zuspitzen, sobald der Einsatz eine kritische Masse erreicht“, lautet das Fazit der Studie. „Eine noch größere Welle der Veränderung zeichnet sich am Horizont ab, wenn Deep Learning ausgereift ist – was Maschinen noch nicht gekannte Möglichkeiten des Denkens, des Problemlösens und des Verstehens von Sprache gibt.“

*Werner Kurzlechner lebt als freier Journalist in Berlin

Be the first to comment