Predictive Analytics wirft auf Basis von komplexen Datenanalysen einen Blick in die Zukunft. Doch wie aussagekräftig sind die Prognosen? Bei der Implementierung einer Predictive Analytics-Lösung drohen viele Fallstricke – von der Auswahl der Daten über die Methodik bis hin zur unzureichenden Analyse der Geschäftsprozesse. Unternehmen sollten Predictive Analytics daher als kontinuierlichen, iterativen (Lern-)Prozess sehen. [...]

ITERATIVER PROZESS MIT PASSENDEM METHODEN-MIX

Es gibt viele unterschiedliche Methoden und Vorhersagemodelle, um aus Daten Prognosen abzuleiten. Sie reichen von klassischen Data-Mining-Methoden wie Clustering oder Regressionsanalyse über Elemente der Spieltheorie bis hin zum maschinellen Lernen. Bei letzterem werden die Algorithmen so trainiert, dass sie aus den vorliegenden Daten lernen, selbstständig ein Datenmodell erzeugen und dieses für Prognosen oder Entscheidungen einsetzen.

„Ziel ist es, den besten Ansatz für den Kunden zu finden. Wir füttern die verschiedenen Vorhersagemodelle mit den ausgewählten Daten, kombinieren verschiedene Modelle und verfeinern die Datenanalyse dadurch Schritt für Schritt, um die Vorhersagegenauigkeit zu verbessern“, erläutert Avantum-Manager Böckmann. Blue Yonder setzt eine eigene Methodik ein, die auf maschinellem Lernen mit neuronalen Netzen beruht.“ „Wir passen unseren Algorithmus aber speziell auf die Situation beim Kunden an und entwickeln ihn kontinuierlich weiter. Es ist unser Ziel, auf der Basis von ähnlichen Fällen ein Standardmodell für bestimmte Branchen zu erstellen“, sagt Milnik von Blue Yonder.

Angesichts der Komplexität der Predictive Analytics-Projekte mit vielen Variablen und Einflussfaktoren raten beide Experten den Unternehmen, schrittweise vorzugehen und mit einem kleinen Pilotprojekt zu starten, das in einem laufenden Prozess ständig weiterentwickelt wird. Dazu Milnik: „Es besteht immer das Risiko, dass die Vorhersagemodelle nicht das erwartete Ergebnis bringen. Das kann unterschiedlichste Ursachen haben. Beispielsweise kann es an der Datenqualität mangeln. Daher ist es äußerst wichtig, gemeinsam mit Experten bei unseren Kunden die Projekte schrittweise zu erarbeiten und auch die Datenquellen sukzessive zu erweitern.“

GUTE PROGNOSE, SCHLECHTE PROGNOSE

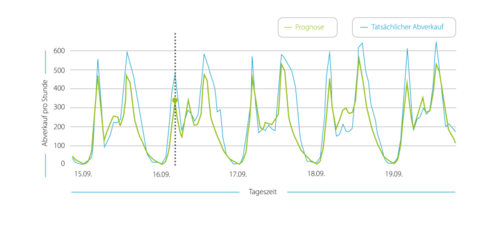

Ob sich der ganze Aufwand für das entsprechende Vorhersagemodell gelohnt hat, zeigt ein Vergleich der Prognose mit der Realität. Eine weitere Kenngröße für die Qualität einer Prognose wäre der Vergleich mit bislang im Unternehmen eingesetzten Methoden (zum Beispiel Regressionsanalyse in Verbindung mit dem Bauchgefühl des Managers) oder Konkurrenz-Algorithmen. „Die statistische Auswertung der Prognosen und die korrekte Maßzahl für die Prognosegüte ist ein wichtiger Bestandteil eines Projektes. Zum Beispiel sollten prognostizierte Absatzzahlen nicht über quadratische Abweichungen evaluiert werden, da Abweichungen von +/-10 wirtschaftlich aussagekräftiger sind“, erklärt Milnik.

Erweist sich die Prognose als stichhaltig, gilt es, die Ergebnisse so in die Geschäftspraxis zu übertragen, dass sie einen Mehrwert ergeben. Nehmen wir das Beispiel Schnupfenspray: Hier konnte der Pharmagroßhändler dank der besseren Absatzvorhersage seine Lager rechtzeitig auffüllen, die Fehlmenge für Schnupfenspray auf 0,5 Prozent senken und seine Umsätze erhöhen. „Natürlich sagt der gesunde Menschenverstand, dass die Absatzzahlen von Schnupfenspray bei Kälte und schlechtem Wetter steigen. Predictive Analytics lässt aber durch die Kombination historischer Daten mit den Wetterprognosedaten viel granularere Einsichten zu, die letztendlich zu deutlich besseren Geschäftsergebnissen führen“, sagt Böckmann.

FAZIT

Es gibt nicht die eine richtige Predictive-Analytics-Methode für alle Unternehmen. Welche Methode und welcher Algorithmus am besten funktionieren, hängt vom individuellen Ziel und der Fragestellung ab. Predictive Analytics ist zudem als immerwährender Prozess zu sehen mit dem Test und der Kombination verschiedener Datensätze und Vorhersagemodelle. Da sich die Modelle im Laufe der Zeit immer weiter verbessern, werden auch die Vorhersagen immer präziser. Unternehmen sollten daher mit einem kleineren Projekt starten und die Lösung dann Schritt für Schritt erweitern.

*Jürgen Mauerer betreibt als freier Journalist ein Redaktionsbüro in München.

Be the first to comment