Data-Center sind die logistische Drehscheibe der Digitalisierung - die Anforderungen steigen. Innovationspotenzial ist jedenfalls vorhanden. [...]

Sie sind eine Grundvoraussetzung für die Digitalisierung von Wirtschaft und Gesellschaft: Rechenzentren. Neben Breitbandanschlüssen und den internationalen Internetaustauschknoten bilden sie das Rückgrat der digitalen Wertschöpfungskette. Hier werden Daten übertragen, gespeichert, verwaltet und verarbeitet.

Rund 53.000 Data-Center gibt es nach Angaben des Energieversorgers E.ON in Deutschland. In denen sollen rund zwei Millionen Server laufen. Die Spannweite reicht dabei vom kleinen Serverrack oder einem Server-Raum im Keller eines kleinen Unternehmens und Rechenzentren für Hosting und Co-Location über große, internationale Hyperscaler bis zu extrem leistungsfähigen Supercomputern für die Forschung und Entwicklung.

Vor allem der Trend zum Cloud-Computing und das Internet of Things (IoT) sorgen für einen regelrechten Rechenzentrums-Boom: Das Datenvolumen nimmt exponentiell zu – und die vielen Bits und Bytes müssen irgendwo gespeichert und verarbeitet werden. Doch reichen die Rechenzentrumskapazitäten dafür überhaupt aus und schaffen es die Betreiber, ihre Kapazitäten schnell genug anzupassen?

Die Herausforderungen, die auf die Data-Center zukommen, sind dabei vielfältig: „Das exponentielle Datenwachstum allein auf das Internet of Things zurückzuführen, greift zu kurz“, erklärt Holger Nicolay, Business Development Manager beim Co-Location-Spezialisten Interxion. Jede unserer Handlungen, ob Social Media, Online-Shopping, Gaming oder Videostreaming, führe zur Entstehung, Speicherung und Verarbeitung neuer Daten. Und auch die voranschreitende Digitalisierung von Geschäftsprozessen und die pandemiebedingte Verlagerung ins Homeoffice habe das Datenwachstum in die Höhe schnellen lassen.

So stieg die Internetnutzung im Frühjahr vergangenen Jahres innerhalb kürzester Zeit stark an. Die Folge: Der DE-CIX, gemessen am Datendurchsatz ohnehin bereits der größte Internetknoten der Welt, stellte im November 2020 einen neuen Rekord auf – die Schallmauer von 10 TBit/s Datendurchsatz wurde durchbrochen. Das waren noch einmal 10 Prozent mehr als im März. Größere Sorgen macht sich Holger Nicolay angesichts der Datenmassen allerdings nicht: „Alle Provider – ganz gleich ob aus der Telekommunikations-, Cloud- oder Co-Location-Branche – planen immer mit umfangreichen Reservekapazitäten.“ So könnten Netze und Rechenzentren spontane Lastspitzen jederzeit abfedern und einen reibungslosen Betrieb sicherstellen. „Solche Peaks“, ergänzt Nicolay, „also einen kurzfristigen Bedarf an Internet- und Rechenzentrumskapazitäten, gab es übrigens auch schon vor der Corona-Krise, zum Beispiel im Zuge globaler Großereignisse.“

Edge-Computing

Vor allem der bereits angesprochene Boom des Internets of Things bringt Veränderungen in der Rechenzentrumslandschaft mit sich. Die vielen Daten von Sensoren, Geräten und Maschinen werden vermehrt dort verarbeitet, wo sie anfallen. „Im IoT-Zeitalter wird das Speichern und Verarbeiten von Daten am Edge, also dem Entstehungsort der Daten, immer wichtiger“, bestätigt Dominik Friedel, Business Development Manager Global Data Centers EMEA beim IT-Dienstleister NTT.

Holger Nicolay von Interxion unterstreicht die Bedeutung von Edge-Computing im Hinblick auf das exponentielle Datenwachstum: „Es ist ein unverzichtbarer Schlüssel zur Bewältigung sehr großer Datenmengen.“

Ein Beispiel hierfür ist die direkte Auswertung und Aggregation von Sensordaten im Industrie-4.0-Umfeld. Vereinfacht gesagt stellt Edge-Computing sicher, dass nur relevante und bereits aggregierte Daten in ein zentrales Rechenzentrum – im Keller eines Unternehmens, in einer Co-Location-Umgebung oder in der Public Cloud – transferiert werden, um sie dort zu speichern, weiterzuverarbeiten und etwa mithilfe Künstlicher Intelligenz auszuwerten. Holger Nicolay hält dezentrale Konzepte wie On-Premise-Rechenzentren und den Edge für eine perfekte Ergänzung zu zentralen Cloud-Umgebungen, „um Digitalisierung flächendeckend zu ermöglichen und das stetig steigende Datenwachstum zu bewältigen“.

Auslaufmodell On-Premise?

Cloud-Computing, Edge-Computing, stetig steigende Datenmengen und die Herausforderungen der Datenverarbeitung beispielsweise mit Künstlicher Intelligenz – lässt sich das alles noch im unternehmenseigenen Data-Center stemmen? Oder wird das On-Premise-Rechenzentrum mehr und mehr zum Auslaufmodell?

Dominik Friedel von NTT erkennt zumindest einen klaren Trend: „Die Rechenzentren im Keller beziehungsweise am Unternehmensstandort werden tatsächlich seit einigen Jahren weniger.“ Das liege zum einen an der steigenden Komplexität des Rechenzentrumsbetriebs. Gerade für Organisationen mit hohen Sicherheits- und Compliance-Anforderungen, etwa Banken oder Behörden, seien die Anforderungen und Zertifizierungen so vielschichtig, dass diese sich Friedel zufolge eher auf spezialisierte Anbieter verlassen.

Als weiteren Punkt sieht er das Cloud-Computing: So kombinierten Hybrid–Clouds lokale Ressourcen mit Angeboten in der Public Cloud und seien daher auf einen sicheren und leistungsfähigen Zugang zu diesen Cloud-Angeboten angewiesen. „Den erhalten Unternehmen in Co-Location-Rechenzentren, in denen sie eine zuverlässige und geschützte Rechenzentrumsinfrastruktur vorfinden, die volle Kontrolle über ihre Systeme behalten und gleichzeitig eine direkte, dedizierte Verbindung zu vielen Cloud-Anbietern nutzen können.“ Mit einem eigenen Rechenzentrum erreiche man keine vergleichbaren Übertragungsgeschwindigkeiten und müsse in neue Leitungen investieren, was sehr teuer sei.

Holger Nicolay vertritt – als Co-Locoation-Anbieter – eine ähnliche Auffassung: „Eine Cloud bietet eine Alternative zu kleinen, unsicheren und ineffizienten Server-Räumen ‚im Keller‘.“ Dennoch habe – abseits des Klischees von der selbst gebastelten Keller-IT – die anwendungsspezifische IT vor Ort auch zukünftig ihre Daseinsberechtigung. Als Beispiel nennt er Industrie 4.0 in Form von Edge-Technologien und latenzkritischer Produktionssteuerung.

Nach Ansicht von Johann Dasch, CEO und Vorstand des Hosting-Spezialisten 1blu, hat das Thema jedoch verschiedene Facetten: „Angesichts der aktuellen Bedrohungslagen im Bereich Security wird es für einige Kunden immer wichtiger, auf flexible Backups zugreifen zu können, die unabhängig, schnell und sicher sind“, auch wenn der Server im Unternehmen bleibe. „Andererseits gibt es immer mehr Unternehmen, die eine vollständige Auslagerung ihrer Infrastruktur bevorzugen.“ Laut Dasch setzen insbesondere kostenbewusste Unternehmen auf externe Lösungen.

RZ-Checkliste

Mit dem Trend zum Outsourcing der Rechenleistung wachsen auch die Ansprüche der Unternehmen an entsprechende Dienstleister. Während nach wie vor die Themen Sicherheit und Verfügbarkeit die zentralen Anforderungen an ein Data-Center sind, werden zum Beispiel Datensicherungen in separaten Gebäuden oder an anderen Standorten, sogenannte georedundante Backups, für Data-Center-Kunden immer wichtiger – „ebenso eine gute Konnektivität zu Internetknoten, Cloud-Anbietern und Service-Providern“, ergänzt Dominik Friedel von NTT. Des Weiteren würden Unternehmen heute auch vermehrt Angebote für die Installation oder die Wartung der IT-Systeme erwarten. Bei Co-Location zum Beispiel müssten sie dank solcher „Remote Hands Services“ für kleinere Aufgaben wie den Austausch einer Netzwerkkarte keinen eigenen Techniker vorbeischicken.

Dass das Thema Konnektivität bei Rechenzentrumskunden vermehrt eine Rolle spielt, weiß auch Holger Nicolay von Interxion: „Wir beobachten, dass heute schon sehr konkret nach direkten und privaten Anbindungsmöglichkeiten an die führenden Hyperscaler wie Microsoft Azure, Amazon Web Services und die Google Cloud gefragt wird.“

Go Green im Data-Center

Bei allen Vorteilen der Digitalisierung und dem damit einhergehenden Boom der Rechenzentren – das Ganze hat natürlich auch Folgen: So verbrauchten die Data-Center hierzulande im vergangenen Jahr nach Angaben des Borderstep Instituts für Innovation und Nachhaltigkeit rund 16 Milliarden Kilowattstunden Strom. Damit sei der Energiebedarf der Rechenzentren um 1 Milliarde Kilowattstunden im Vergleich zu 2019 angestiegen.

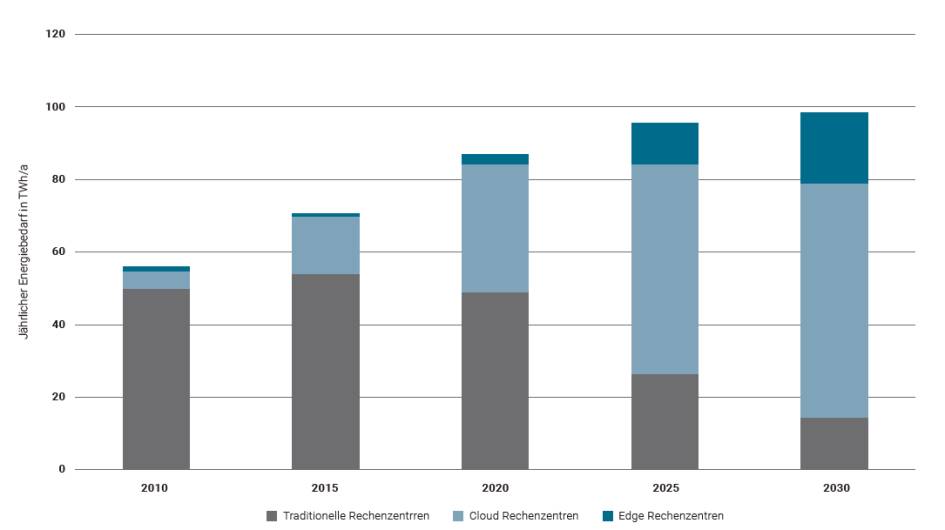

Insbesondere der Trend zum Cloud-Computing lässt den Energiehunger steigen: Die Cloud war 2020 laut Borderstep Institut für 40 Prozent des Energiebedarfs der Rechenzentren verantwortlich. Bis zum Jahr 2025 wird dieser Anteil voraussichtlich auf 60 Prozent ansteigen.

Eine im November vergangenen Jahres von der Europäischen Kommission vorgestellte Studie bestätigt den steigenden Strombedarf von Rechenzentren: Der Energieverbrauch von Rechenzentren in den EU-Mitgliedstaaten werde voraussichtlich von 2,7 Prozent des gesamten Bedarfs an Strom im Jahr 2018 bis 2030 auf 3,2 Prozent ansteigen.

Die Zahlen zum Energiebedarf von Data-Centern sollte man allerdings mit einer gewissen Skepsis betrachten. So gibt es schlicht zu wenig verfügbare Daten zu den einzelnen Rechenzentren. Das gilt insbesondere für die vielen Anlagen, die On-Premise in den Kellern der Unternehmen laufen.

Nichtsdestotrotz: Rechenzentren sind Stromfresser. Vor allem die Einführung des schnellen Mobilfunkstandards 5G wird den Strombedarf weiter in die Höhe schnellen lassen. Zu diesem Ergebnis kommt eine Studie des E.ON Energy Research Centers. Die Gründe dafür seien vielfältig: So benötigten viele 5G-Services den weiteren Ausbau von Edge-Computing. Und je mehr Edge-Rechenzentren es gebe, desto größer werde auch der Bedarf an zentralen Rechenzentren. Ein weiterer Faktor: Flottes mobiles Internet sorge dafür, dass immer weniger Daten auf den Endgeräten liegen, sondern in der Cloud. Die Daten mobiler Endgeräte wie Smartphones sollen bereits 2025 den größten Anteil aller Daten in der Cloud ausmachen.

In Zahlen ausgedrückt: Auf Rechenzentren entfallen laut E.ON Energy Research Center bis 2030 bis zu 13 Prozent des globalen Stromverbrauchs: Zum Vergleich: 2010 lag der Stromverbrauch der Data-Center noch bei einem Prozent. Der zusätzliche Energiebedarf von Rechenzentren durch die Einführung von 5G soll im Jahr 2025 in Deutschland äquivalent sein zum Verbrauch von 600.000 bis 1,23 Millionen Haushalten.

Die gute Nachricht: Die Unternehmen kümmern sich verstärkt um diese Problematik. Nach den Erfahrungen von Holger Nicolay von Interxion wollen die Kunden heute ganz genau wissen, welche Nachhaltigkeitskonzepte ihr Rechenzentrumsdienstleister implementiert hat oder welche in Planung sind.

Diese Thema greifen die Data-Center-Betreiber natürlich auf – in vielen Fällen allerdings wohl weniger aus Gründen des Umweltschutzes, sondern aus Kostenerwägungen. „Rechenzentrumsbetreiber sind – schon allein wegen der hohen Strompreise in Deutschland – intrinsisch motiviert, stromsparend zu arbeiten“, erklärt Holger Nicolay. Deshalb würden sie zahlreiche technische Vorkehrungen treffen und organisatorische Maßnahmen ergreifen, um hocheffizient mit Energie umzugehen – und damit auch den Umweltschutz weiter voranzutreiben.

Dominik Friedel gibt zu bedenken, dass man unterscheiden müsse zwischen der Nachhaltigkeit der betriebenen IT-Systeme und der Nachhaltigkeit des Rechenzentrums selbst. So hätten zum Beispiel Betreiber von Co-Location-Rechenzentren nur auf Letzteres Einfluss, da die Kontrolle über die IT-Systeme den Kunden und Partnern obliege – „allerdings nutzen diese schon aus Kostengründen zumeist energiesparende Hardware und versuchen, diese auch möglichst effizient auszulasten.“

Open-Source-Hardware

Eine Möglichkeit zum Stromsparen ist das Open Compute Project (OCP), eine Art Open Source für Rechenzentrums-Komponenten. Bereits im Jahr 2011 von Facebook ins Leben gerufen, haben sich inzwischen viele renommierte Hersteller wie Google, Intel und Microsoft dem Projekt angeschlossen. Das Ziel: Standardisierte IT-Architekturen sollen Investitions- und Betriebskosten senken – und gleichzeitig Energie sparen. So geben die beteiligten Unternehmen im Rahmen des OCP ihre Server- und Rechenzentrumsentwürfe frei, damit andere Server- und Rechenzentrumsbetreiber auf diesen aufbauen können.

Den Grundstein für das Open Compute Project legte Facebook mit der Offenlegung von Bauplänen und Spezifikationen der selbst entwickelten Server und Rechenzentren. Das Besondere daran: Ein im US-amerikanischen Prineville nach eigenen Entwürfen gebautes Facebook-Rechenzentrum hatte laut Facebook einen um fast 40 Prozent geringeren Stromverbrauch als bisherige Facebook-Rechenzentren, was die Kosten um knapp ein Viertel senkte. Hierfür ließ Facebook bei den Servern alles weg, was nicht unbedingt notwendig war, etwa Steckplätze. Hinzu kamen besonders effiziente Netzteile und optimierte Server-Schränke.

„Das Open Compute Project ist als generische Hardware-Plattform konzipiert, auf der im Prinzip alle nötigen Dienste über genormte Schnittstellen Software-gesteuert aufgesetzt werden können“, erklärt Jens-Peter Feidner, Deutschland-Geschäftsführer beim Rechenzentrumsbetreiber Equinix. (Siehe auch Interview auf Seite 58.) Gerade im Hinblick auf den aktuellen Trend der Infrastruktur-Automatisierung sei eine solche Plattform vielseitig einsetzbar und schaffe großen Mehrwert. „Der Austausch mit führenden Unternehmen der Branche innerhalb des Projekts führt zu mehr gegenseitigem Know-how.“ Die OCP-Struktur bietet laut Feidner zudem mehr Flexibilität und Leistung bei gleichzeitig niedrigeren Kosten und geringerem Energieverbrauch. „Mit Blick auf Nachhaltigkeit ist OCP daher eine wichtige Innovation, die künftig einen entscheidenden Beitrag leisten und sich auf lange Sicht zu einem Standard für Rechenzentren entwickeln kann“, resümiert Feidner.

Auch Dominik Friedel hält das Open Compute Project für einen spannenden Ansatz für neue Architekturen im Rechenzentrum, schränkt allerdings ein, dass der Nutzen sehr stark vom Unternehmen und seinem konkreten Anwendungsfall abhängig sei.

Fazit & Ausblick

Eines ist sicher: Im Zuge der Digitalisierung dürfte sich der Rechenzentrums-Boom auch in den kommenden Jahren fortsetzen. Einen Engpass bei den Kapazitäten braucht laut Johann Dasch von 1blu dabei aber kein Unternehmen zu fürchten. Die Herausforderung in der Data-Center-Branche sei seit jeher der technische Fortschritt: „Hätte die Autoindustrie in den vergangenen 30 Jahren die Innovationsgeschwindigkeit der IT-Branche gehabt, dann würden wir inzwischen in selbstfahrenden Wellness-Oasen durch die Gegend fahren und kaum Energie verbrauchen“, so Dasch. Daher seien die Rechenzentrumsbetreiber auch in der Lage, die steigenden Anforderungen zu bewältigen.

Wenig Veränderungen sind am grundlegenden Konzept von Rechenzentren zu erwarten. Ohne Frage aber wird sich etwas beim Thema Nachhaltigkeit tun, beispielsweise durch die effizientere Nutzung der Abwärme oder effizientere Komponenten. Noch mehr steigen wird in jedem Fall die Zahl der Rechenzentren – getrieben durch die Cloud und die zahlreichen Digitalisierungsprojekte in den Unternehmen.

Im Gespräch mit Jens-Peter Feidner von Equinix Deutschland

Das Thema Rechenzentren nimmt in Zeiten der Digitalisierung immer größeren Raum ein. Was heißt das für die Data-Center und wie sehen sie in ein paar Jahren aus? Vor allem eine sogenannte grüne Digitalisierung werde zum zentralen Designkriterium neuer Rechenzentren, prognostiziert Jens-Peter Feidner im Interview mit com! professional. Er ist Geschäftsführer Deutschland beim Rechenzentrumsbetreiber Equinix.

com! professional: Herr Feidner, das weltweite Datenvolumen nimmt exponentiell zu. Wo sollen all diese Daten künftig gespeichert und verarbeitet werden? Kommen die Rechenzentrumsbetreiber überhaupt hinterher, ihre Kapazitäten entsprechend anzupassen?

Jens-Peter Feidner: Das physische Bauen wird wohl erst einmal nicht aufhören, sich aber verändern, indem unter anderem auch die Nachhaltigkeit einbezogen wird. Ein wichtiger Faktor dabei ist, dass die Auslastung neuer Geräte viel effizienter geworden ist. Wo früher die Server nur zu 20 Prozent ausgelastet waren, sind es heute oft zwischen 60 und 80 Prozent. Zudem führt eine stärkere Virtualisierung auch dazu, dass Hardware immer standardisierter und somit effizienter wird.

com! professional: Das DE-CIX meldet einen Traffic-Rekord nach dem anderen. Was ist entscheidend dafür, dass die Netze und Rechenzentren den aktuellen Anforderungen standhalten?

Feidner: Die digitale Transformation hat sich durch die Covid-19-Pandemie in vielen Branchen beschleunigt. Das öffentliche Internet allein könnte diesen Datenverkehr schon heute nicht mehr ohne Weiteres abdecken.

Viel mehr spielt die private Interconnection eine entscheidende Rolle beim Datenaustausch zwischen Unternehmen. Hierbei vernetzen sich Unternehmen im Rechenzentrum mittels privater und direkter Anbindungen latenzarm miteinander und mit Clouds und anderen Services. Wir gehen davon aus, dass Anbieter digitaler Services ihre Bandbreite für private Konnektivität bis 2023 um das Fünffache erhöhen werden.

com! professional:Sie haben das Thema Nachhaltigkeit bereits angesprochen. Data-Center gelten als enorme Stromfresser. Mit welchen Technologien lassen sich Rechenzentren klimafreundlicher machen?

Feidner: Bessere und standardisierte Konzepte im Design der Rechenzentren helfen dabei, diese effizienter zu gestalten. Dazu gehören zum Beispiel begrünte Fassaden oder die Möglichkeit, die Abwärme von Rechenzentren für städtische Nah- oder Fernwärmenetze nutzbar zu machen.

com! professional: Haben sich in den vergangenen Jahren eigentlich die Ansprüche der Kunden an ein Data-Center verändert?

Feidner: Moderne Rechenzentren sind weit mehr als bloße Server-Hotels – vielmehr sind sie ein Marktplatz für Infrastrukturlösungen, Konnektivität und Services geworden. So ermöglichen Rechenzentren ihren Kunden den schnellen Aufbau einer skalierbaren Infrastruktur und vernetzen sie mit Partnern, Clouds und mit Managed Services, die alle Teil des Interconnection-Ökosystems sind.

Eine zunehmend wichtige Rolle spielt hier auch der Channel, über den Rechenzentrumskunden nicht nur von den Data-Center-eigenen Services profitieren, sondern auch von denen der Partnerlandschaft. Unternehmen können so ihre Effizienz und Innovationskraft steigern und müssen gleichzeitig weniger in den Aufbau und Betrieb der eigenen Hardware investieren. Rechenzentren fördern damit den sicheren Austausch zwischen Unternehmen und agieren über die bereitgestellten digitalen Ökosysteme als Digitalisierungsbeschleuniger.

com! professional: Welchen Einfluss hat Ihrer Erfahrung nach der Trend zum Edge-Computing?

Feidner: Laut einer von uns durchgeführten weltweiten Umfrage unter IT-Entscheidungsträgern führt die Hälfte die Verlagerung ihrer Infrastruktur an die Digital Edge als einen der wichtigsten Eckpfeiler ihrer Technologiestrategie auf. Rechenzentrumsanbieter können Unternehmen entscheidend beim Aufbau einer Edge-Infrastruktur unterstützen, indem sie Zugänge zu relevanten Cloud-Services, Netzwerk-Providern und Partnern möglichst nah am Kunden und Netzwerkrand bereitstellen.

com! professional: Eine Rolle dürfte hier sicher auch der 5G-Standard spielen …

Feidner: 5G-Anwendungen spielen für große Rechenzentren eine wichtige Rolle, da sie Anbietern von Netzwerk-Services direkte und sichere Verbindungs- und Aggregationspunkte zwischen 5G-Netzwerkknoten bereitstellen. Für 5G-Betreiber bedeutet dies, dass sie den Einsatz kleinerer Edge-Standorte reduzieren und auf diese Weise ihre Investitionskosten minimieren können.

com! professional: Das klingt alles so, als hätte das Rechenzentrum im Keller von Unternehmen allmählich ausgedient. Ist das

der Fall?

Feidner: Mit der Nachfrage nach Cloud-Connectivity ist auch der Bedarf an Co-Location- und Interconnection-Rechenzentren gewachsen. Die zentralen und auf Silos basierenden Rechenzentren vieler Unternehmen erfüllen damit immer weniger die Anforderungen moderner Cloud-Architekturen. Besonders für hybride oder Multi-Clouds benötigen Unternehmen direkten und schnellen Zugang zu relevanten Cloud-Partnern und einem umfassenden Ökosystem.

com! professional: Blicken wir noch kurz in die Glaskugel: Wie sehen Rechenzentren im Jahr 2025 aus?

Feidner: Unternehmen werden Rechenzentren künftig nicht mehr nur als IT-„Backbone“ für die Herstellung von Produkten sehen. Umgekehrt gehen wir davon aus, dass die physische Produktion den digitalen Services, Webshops und Produktentwicklungen nachgelagert sein wird, die sich aus den Interconnection-Ökosystemen innerhalb der Rechenzentren ergeben.

Ein großes Thema ist zudem auch die sogenannte grüne Digitalisierung: Energieeffizienz und Nachhaltigkeit werden zu einem zentralen Designkriterium beim Bau neuer Rechenzentren. Der Bezug von Ökostrom, die Bereitstellung von Abwärme und der Einsatz neuer Kühltechnologien sind hier nur als einige Beispiele zu nennen. Darüber hinaus werden sich spezialisierte Rechenzentrumstypen etablieren, die jeweils individuelle Kundenbedürfnisse bedienen. Dazu zählen beispielsweise auf der einen Seite große Hyperscaler für Cloud-Provider und Big-Data-Anwendungen. Auf der anderen Seite ist eine Zunahme von flexiblen und regional verteilten Rechenzentren etwa für das Edge-Computing zu erwarten.

*Konstantin Pfliegl ist Redakteur bei der Zeitschrift com! professional und schreibt auch für die Internet World Business, Telecom Handel und die Schweizer Computerworld. Er hat rund 20 Jahre Erfahrung als Redakteur für verschiedene Print- und Online-Medien. Er arbeitete als Redakteur unter anderem für die Fachpublikationen tecChannel und Internet Professionell sowie freiberuflich unter anderem für FOCUS Online.

Be the first to comment