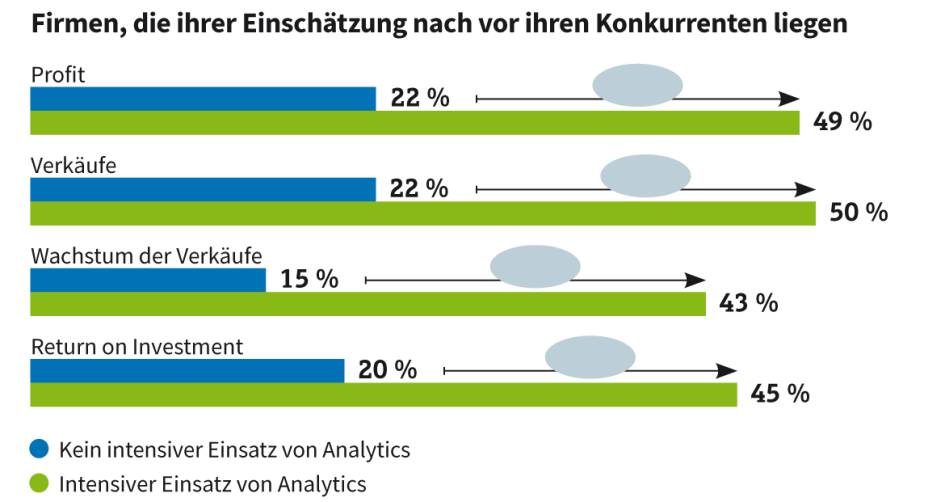

Um Daten wirtschaftlich relevant zu machen, braucht es Know-how, Tools und Manpower. Studien haben gezeigt, dass analytisch aktive Unternehmen erfolgreicher sind. [...]

Warum rücken Daten heute so sehr in den Fokus? Weil sie individuelle Erfahrung und Bauchgefühl durch empirisch gesicherte Erkenntnisse ersetzen. Ohne die Daten über Produkte, Kunden, Lieferanten geraten Unternehmen in unserer Zeit schnell aufs Abstellgleis. „Nur wer über Daten verfügt und sie vernünftig nutzt, wird künftig wirtschaftlich erfolgreich sein“, betont Bitkom-Präsident Achim Berg.

Dutzende von Studien belegen solche Aussagen. Laut einer Untersuchung des McKinsey Global Institute akquirieren datengesteuerte Organisationen mit 23-fach höherer Wahrscheinlichkeit Kunden, binden mit 6-fach höherer Wahrscheinlichkeit Kunden und sind mit 19-fach höherer Wahrscheinlichkeit profitabel. Kundendaten werden von solchen Unternehmen beispielsweise genutzt, um den Abbruch von Einkäufen zu analysieren oder Abwanderungen von Kunden zu verhindern.

Mit Daten und deren Analyse lassen sich aber nicht nur Einsichten ins Kundenverhalten gewinnen, sie können Unternehmen generell dabei helfen, entscheidende neue Erkenntnisse zu erlangen – auch mit tief greifenden Auswirkungen auf das Unternehmen. Was wird in drei Jahren im Trend liegen? Wie kann ich die Kapazität meiner Produktion steigern? Wie lässt sich die Logistik verbessern? Antworten auf solche Fragen sichern langfristig den Erfolg.

Der Haken an der Dateneuphorie ist: Ein Unternehmen mag auf dem größten Datenstapel der Welt sitzen, aber das ist nutzlos, wenn es nicht die Mittel hat, die Daten in Erkenntnisse zu übersetzen, die das Unternehmen voranbringen. Die puren Daten helfen nicht bei Entscheidungen, sie müssen erst in Informationen umgewandelt werden, sodass echte Einsichten in Zusammenhänge möglich sind. Vor diesem Hintergrund stellt dieser Beitrag die wichtigsten Schritte vor, die eine Firma unternehmen sollte, um ihre Daten in wichtige Erkenntnisse zu transformieren.

Prinzipien der Datenvisualisierung

Die folgenden Grundsätze können bei der Visualisierung von

Daten helfen:

- Trends statt Datenpunkte: Die besten Einsichten ergeben sich oft, wenn Sie nicht auf einzelne Datenpunkte blicken, sondern auf Trends – besonders, wenn diese ihre Richtung ändern.

- Vergleichen Sie Zeitbereiche: Untersuchen Sie verschiedene Zeitbereiche, zum Beispiel Woche für Woche, Monat für Monat oder Sommer für Sommer.

- Suchen Sie nach starken Beziehungen: Häufig sind die stärksten und aufschlussreichsten Entdeckungen bei der Datenanalyse die Beziehungen zwischen Variablen oder Korrelation und Abhängigkeit.

- Probieren Sie verschiedene Perspektiven aus: Da ein Einzelner nicht alles sehen kann, laden Sie Kollegen ein, sich mit den Daten zu beschäftigen. Es ist wichtig, mehrere Augenpaare zu haben, die nach verwertbaren Erkenntnissen suchen.

- Seien Sie skeptisch: Analysieren Sie Daten immer aus mindestens zwei Blickwinkeln. Zeichnen Sie beispielsweise dieselben Daten mehrmals mit verschiedenen Diagrammtypen auf. Daten können leicht in die Irre führen, stellen Sie also sicher, dass sie die Geschichte genau wiedergeben.

- Achten Sie auf Ästhetik: Menschen fühlen sich von Natur aus von Schönheit angezogen – warum also nicht ein Diagramm so schön wie möglich gestalten? Auch die Ästhetik kann dazu beitragen, dass Diagramme leichter verständlich sind.

Daten, Informationen, Einsichten

„Daten“, „Informationen“ und „Einsichten“ bilden das begriffliche Triumvirat, das klar unterschieden werden sollte. Die Basis des Dreigestirns sind die Daten – rohe unverarbeitete Zahlen, die von einer Organisation erfasst oder erzeugt werden. Das können die Ergebnisse einer Kundenumfrage ebenso sein wie die Sensordaten eines Rechenzentrums oder einer Windkraftanlage.

Informationen wiederum sind Daten, die schon verarbeitet wurden, damit sie leichter konsumiert und verstanden werden können. Ein Dashboard beispielsweise, das Daten aus einem Daten-Pool oder einer sehr großen Datenbank gezogen und aufbereitet hat, liefert bereits Informationen. Das Dashboard macht diese enorme Datenmenge für die Menschen leichter konsumierbar.

Einsichten gehen noch weiter. Sie vermitteln ein genaueres und tieferes Verständnis einer Situation. Einsichten entstehen, wenn Menschen Informationen aufnehmen und auf deren Grundlage Schlussfolgerungen ziehen. Einsicht ist der erste Handlungsschritt, etwas umzusetzen.

Einsichten gewinnen

Angenommen, Sie haben Ihre Jahresumsatzdaten analysiert und kommen zu dem Ergebnis: „Im Jahr 2019 erreichten wir einen Umsatz von 1 Million Euro; das ist ein Anstieg von 5 Prozent im Vergleich zum Vorjahr.“ Das Ergebnis ist eine Information, sie wurde aus den Rohdaten ermittelt.

Diese Information mag wichtig sein, wenn es um die Leistungsmessung geht, aber sie stellt keine Einsicht dar. Sie vermittelt kein Verständnis davon, was dieses Wachstum angetrieben hat und welche Maßnahmen ergriffen werden können, um dieses Verhalten zu reproduzieren.

Anders sieht es im folgenden Beispiel aus: „Im Jahr 2019 erreichten wir einen Umsatz von 1 Million Euro im (+ 5 Prozent im Jahresvergleich); dieses Wachstum ist auf die Einführung unseres neuen Produkts X in Frankreich und Spanien zurückzuführen. Das Verkaufsvolumen für dieses Produkt übertrifft die Indizes in diesen Regionen im Vergleich zu anderen Ländern.

“Beispiel zwei gibt ein besseres Verständnis für den Anstieg des Verkaufsvolumens. Wenn Sie an die Definition von Einsicht zurückdenken, dann ergeben die Wörter „ein genaues und tiefes Verständnis von X gewinnen“ jetzt absolut Sinn. Und das sollte das oberste Ziel datengesteuerter Organisationen sein: die Daten nutzbar zu machen, sie in Informationen umzuwandeln und Erkenntnisse zu gewinnen, die für Geschäftsentscheidungen verwertet werden können.

Die personelle Basis

Daten sammeln und auswerten ist eine Teamarbeit, bei der die Kombination von Geschäftsexperten mit Datenanalysten in der Regel eine gute Lösung ist. Wenn Sie also von Daten und Datenanalysen vollumfänglich profitieren möchten, sollten Sie zunächst für passendes Fachpersonal sorgen. Um nützliche Daten zu finden und sie in datengetriebenes Wissen und Einsichten zu übersetzen, braucht es die entsprechenden Mitarbeiter. Stellen Sie deshalb als Erstes sicher, dass auf allen Unternehmensebenen die richtigen Mitarbeiter an den Datenprojekten arbeiten. Investieren Sie in den Aufbau des Fachwissens, um Ihre Pläne umzusetzen – entweder durch Einstellungen oder durch Schulungen. Für die Suche nach neuen Mitarbeitern ist es lohnend, sich unter Datenexperten wie Data Scientists, Business-Intelligence-Fachleuten und Statistikern umzuschauen.

Sie müssen allerdings nicht zwingend Datenexperten wie Data Scientists akquirieren. Was Sie aber auf alle Fälle brauchen, sind motivierte Mitarbeiter, die analytisch denken und Zusammenhänge hinterfragen können. Dafür müssen diese nicht nur im Umgang mit Analyse-Tools und Analyse-Methoden geschult werden, sondern auch in ihren analytischen Fähigkeiten. Und Sie müssen dabei ihre Neugierde und Eigenständigkeit fördern. In einem datengetriebenen Unternehmen herrscht eine Kultur, in der sich solche Eigenschaften entfalten können. Diese sollten auch bei der Einstellung neuer Mitarbeiter ein Auswahlkriterium bilden.

Wo sind die Daten?

Sammlung, Speicherung und Aufbereitung von Daten ist der erste Schritt, wenn es um die Generierung geschäftsrelevanter Informationen geht. Dabei ergeben sich – insbesondere bei größeren Projekten – eine ganze Reihe von Hürden, die umschifft werden müssen.

Jede Organisation generiert und sammelt Daten, sowohl intern als auch aus externen Quellen, etwa von Kunden, Partnern oder Lieferanten. Die Daten nehmen viele Formate an und decken alle Geschäftsbereiche des Unternehmens ab wie Vertrieb, Marketing, Lohnbuchhaltung, Produktion oder Logistik.

Im ersten Schritt sollten Sie eruieren, welche Daten Sie überhaupt benötigen. Die Antwort auf diese Frage ist abhängig von den Zielen, die Sie mit den Daten erreichen möchten. Was wollen Sie herausfinden? Möchten Sie herausfinden, warum Kunden abwandern? Warum bestimmte Produktverkäufe hinter den Erwartungen zurückbleiben? Auf dieser Grundlage können Sie die Daten festlegen, die Sie sammeln und analysieren möchten.

Das nächste Problem: In der Praxis kommen solche Daten meistens nicht aus einem zentralen System, sondern sind auf verschiedene Subsysteme oder Silos verteilt. Traditionell wurden all diese Daten vor Ort auf Servern gespeichert – in Datenbanken wie Oracle oder Microsoft SQL-Server. Heute werden viele Daten auch in der Cloud abgelegt.

Finden Sie also zunächst heraus, welche Datenquellen Sie haben und welche Sie benötigen. Listen Sie all die verschiedenen Repositories, Tools und Systeme auf, in denen Daten erfasst und gespeichert werden. Legen Sie dann alle in einem zentralen Daten-Pool ab oder entwickeln Sie einen Weg, sie schnell zusammenzuführen. Dann werden Sie viel besser in der Lage sein, die Daten effektiv zu nutzen. Sind die Datenmengen sehr umfangreich, sollten Sie diese in Data Warehouses und Data Lakes ablegen.

Daten vorbereiten

Bevor Sie die Daten für die Analyse speichern, müssen sie – im zweiten Schritt – vorbereitet werden. In dieser Phase müssen die Daten bereinigt, normalisiert und aufbereitet werden. Was bedeutet das? Ein wesentliches Problem bei der Bereitstellung der Unternehmensdaten ist deren Qualität. Operative Systeme wie Buchungs- oder Warenwirtschaftssysteme liefern nicht immer perfekte Daten. Oft bestehen gravierende Qualitätsmängel, etwa mehrfach vorkommende, fehlende oder falsch verknüpfte Daten. Manchmal sind diese auch einfach inhaltlich falsch. Solche Datenmängel verfälschen die Ergebnisse der Datenanalyse.

Ein weiteres Problem ist die Heterogenität der Datenquellen selbst. Im Normalfall liegen den Daten unterschiedliche Formate zugrunde, die vor der Weiterverarbeitung vereinheitlicht werden müssen. Ziel dieser Datenintegration ist es, die Daten aus verschiedenen Vorsystemen für die BI-Systeme in einen einheitlichen, konsistenten Zustand zu überführen.

Dieser Prozess der Datenbereinigung und -standardisierung ist Teil eines umfassenderen Transformationsprozesses. Er hat die grundsätzliche Aufgabe, die internen und externen Daten in themenorientierte, „saubere“ und analysefähige Datenbanken zu überführen. Diese Aktion wird in drei Schritten als sogenannter ETL-Prozess vollzogen:

- Extract: Herausholen der relevanten Daten aus verschiedenen Quellen

- Transform: Umwandeln der Daten in das Schema und Format der Zieldatenbank

- Load: Laden der Daten in das Data Warehouse oder einen anderen Daten-Pool.

Am Ende dieser Phase sollten Ihre Daten in einem Format vorliegen, das den einfachen Zugriff und eine unumschränkte Datenanalyse ermöglicht.

| Daten-Tool | Lizenz | Beschreibung |

| Professionelle Analyse-Tools für Datenexperten | ||

| R | Open Source | R ist unter Datenexperten eines der beliebtesten Analysewerkzeuge. R kann gut mit großen Datensätzen umgehen, ist vielseitig einsetzbar und lässt sich in viele Big-Data-Plattformen integrieren |

| Python | Open Source | Python ist das Programmierwerkzeug der Wahl bei vielen Data Scientists. Die Sprache ist relativ leicht zu lernen und ziemlich schnell. Als mächtiges Analysewerkzeug hat sich Python mit der Entwicklung von analytischen und statistischen Bibliotheken wie NumPy und SciPy etabliert |

| Apache Spark | Open Source | Spark ist eine Open-Source-Tool mit einem Schwerpunkt auf Analytik, insbesondere auf unstrukturierten Daten und großen Datenmengen. Spark ist in den vergangenen Jahren enorm populär geworden |

| Apache Storm | Open Source | Storm ist das Big-Data-Tool der Wahl, wenn die Daten als kontinuierlicher Datenstrom eintreffen. Storm ist ideal für Echtzeit-Analysen oder die Verarbeitung von Datenströmen geeignet |

| SAS | Kommerziell | SAS ist ein robustes, vielseitiges und leicht zu erlernendes Tool. Einige der spezialisierten Module, die in der jüngsten Vergangenheit hinzugefügt wurden, sind SAS Analytics für IOT und SAS Analytics Pro für mittelständische Unternehmen |

| Splunk | Open Source | Splunk wurde früher vor allem zur Verarbeitung von Daten aus Maschinen-Log-Dateien verwendet. Inzwischen ist es viel mehr als das. Splunk hat mächtige Visualisierungsoptionen und dank einer Webschnittstelle ist es relativ einfach zu benutzen |

| Einfache Analyse- und Selfservice-Tools | ||

| Microsoft Excel | Kommerziell | Excel ist das am weitesten verbreitete Analyse-Tool der Welt, mit dem sich einfache Analysen durchführen lassen. Excel ist wichtig, wenn das Analyseteam mit dem Geschäftsbetrieb zusammenarbeitet |

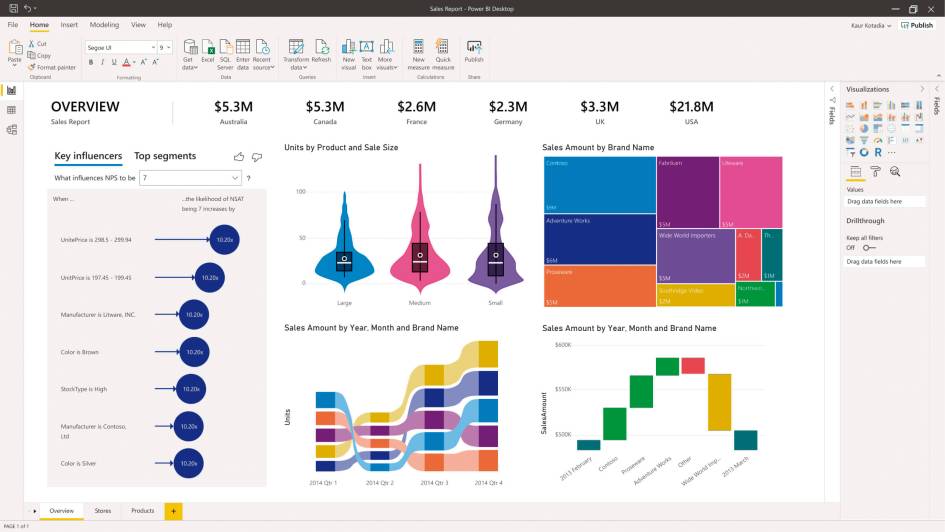

| Microsoft Power BI | Kommerziell | Power BI verwandelt Daten in umfassende interaktive Visualisierungen, indem es Business-Analyse-Tools nutzt und Erkenntnisse in Dashboards vorstellt |

| SAP Analytics Cloud | Kommerziell | SAP Analytics ist eine flexible Analytics-Plattform in der Cloud im Selbstbedienungsmodus. Der Anwender erhält Empfehlungen zur Umsetzung der individuellen Anforderungen |

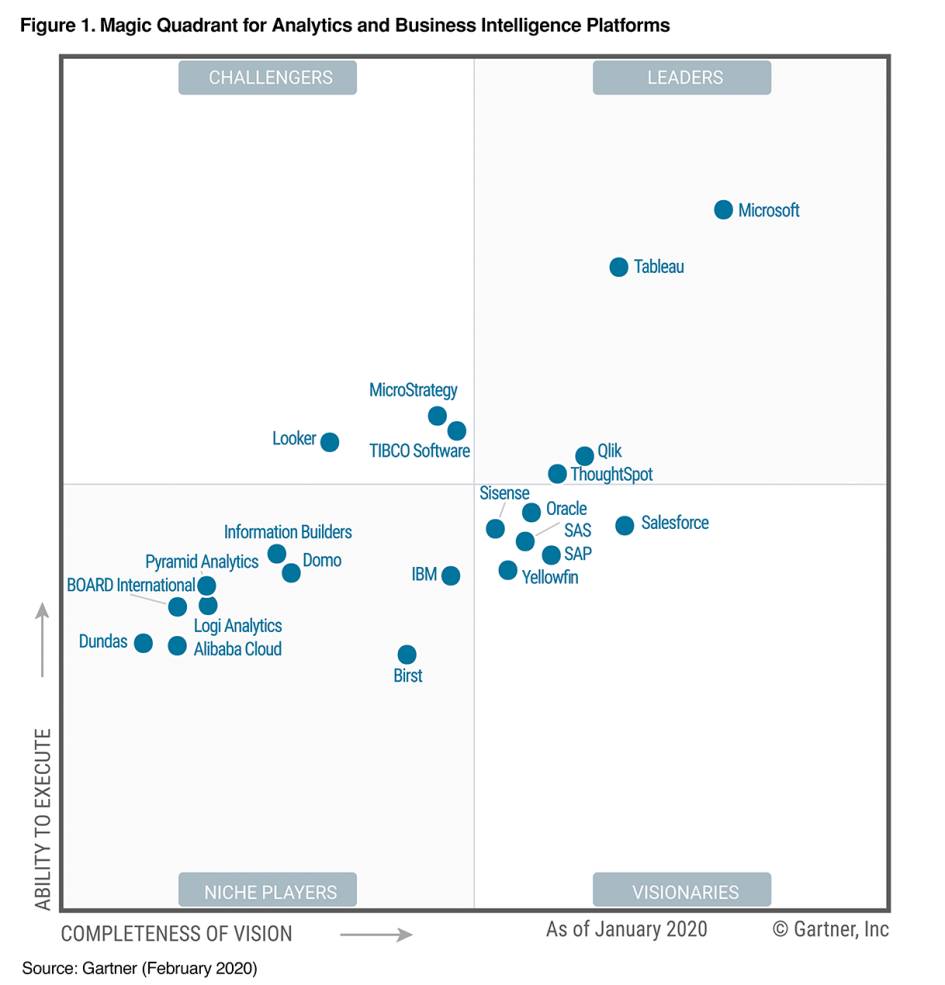

| Tableau | Kommerziell | Mit Tableau lassen sich Daten einfach analysieren, visualisieren und austauschen, ohne dass die IT-Abteilung eingreifen muss. Tableau unterstützt viele Datenquellen wie MS Excel, Oracle, MS SQL und Salesforce |

| Qlikview | Kommerziell | Qlikview und Tableau wetteifern im Wesentlichen um den Spitzenplatz unter den Giganten der Datenvisualisierung. Qlikview ist etwas schneller als Tableau und bietet erfahrenen Benutzern etwas mehr Flexibilität. Tableau hat eine intuitivere Bedienoberfläche und ist leichter zu erlernen |

Analyse-Methoden

Sobald die Daten zusammengestellt und vorbereitet sind, können Sie im dritten Schritt mit der Analyse starten und aus dem Daten-Pool Tabellen und Objekte erstellen. BI- und Business-Analysten und entsprechend geschulte Mitarbeiter können diese untersuchen, Beziehungen zwischen Daten herstellen, Tabellen verbinden und vergleichen sowie aus den Daten Analysen entwickeln.

Die Datenanalysen wandeln die wertlosen rohen Zahlen in kostbare Informationen um. Auf der untersten Ebene dreht sich hier alles um Statistik und mathematische Methoden. Dabei decken die eingesetzten Methoden ein breites Spektrum ab – es reicht von einfachen Mittelwert- und Varianzberechnungen über Tabellenanalysen und Cubes, bei denen man Daten in mehrere Dimensionen aufschlüsselt, bis hin zu komplexen Data-Mining-Verfahren wie Clustering, Entscheidungsbaum-Analyse, Regressionsanalyse und Assoziationsregeln.

Die komplexeren Verfahren unterstützen unterschiedliche Zielsetzungen. Entscheidungsbaum-Analysen werden beispielsweise gern von Banken zur Erkennung von Kreditkartenbetrug verwendet und für die Profilerstellung von Kunden, die mit einer gewissen Wahrscheinlichkeit ihre Kreditverbindlichkeiten nicht erfüllen können.

Assoziationsanalysen und Clustering setzt man häufig im E-Commerce und Marketing ein für Absatzprognosen, Kundensegmentierungen, Warenkorbanalysen und Missbrauchserkennungen. Mit Cluster-Analysen können etwa bestehende Kunden in profitable und weniger profitable Kunden eingeteilt werden, die dann unterschiedlich angesprochen werden.

Zur Erklärung von Zusammenhängen dienen oft Regressionsmodelle. Dabei wird eine abhängige Variable – zum Beispiel Einkommen – erklärt durch eine oder mehrere unabhängige Merkmale – zum Beispiel Schulabschluss, Berufsausbildung, Geschlecht. Derlei Modelle lassen sich dann zur Prognose einsetzen.

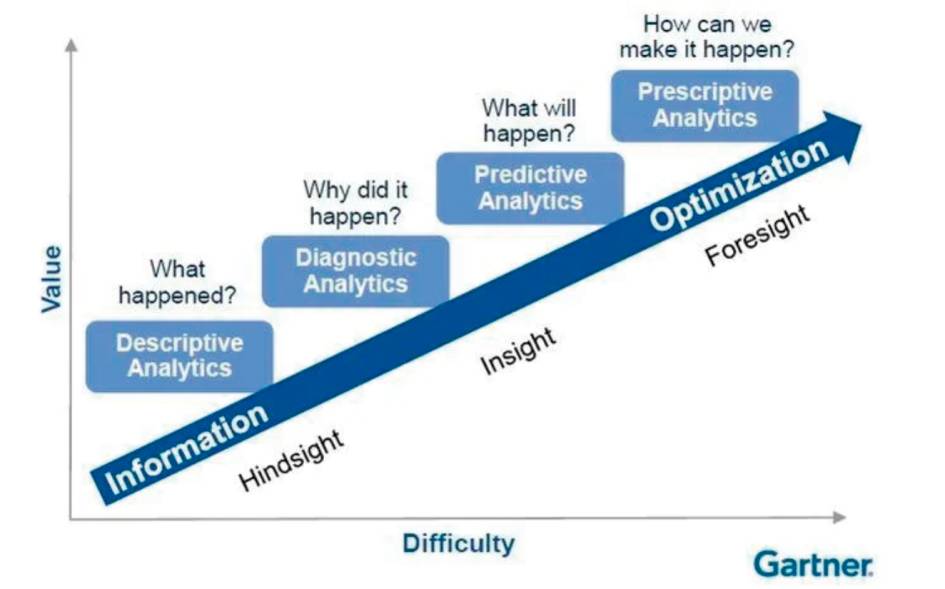

Von einfach zu komplex

Die statistischen und mathematischen Verfahren sind für unterschiedlichste analytische Zwecke nutzbar. Das Marktforschungs- und Beratungshaus Gartner hat mit seinem Analytics-Reifegradmodell vier Typen von Datenanalysen vorgeschlagen, die immer anspruchsvoller werden. Je komplexer eine Analyse ist, desto mehr Wettbewerbsvorteile bringt sie in der Regel. Gartner unterscheidet:

- Descriptive Analytics: Nutzt Daten aus der Vergangenheit für die Beantwortung der Frage „Was ist passiert?“. Ein Händler kann aus den Daten zum Beispiel erfahren, wie hoch der durchschnittliche Umsatz pro Woche ist, ein Hersteller, wie viele Artikel im letzten Monat zurückgegeben wurden.

- Diagnostic Analytics: Extrahiert nicht nur Informationen, sondern erlaubt Einsichten und beantwortet die Frage: „Warum ist etwas passiert?“. Mit dieser Analyse ist es möglich, Ursachen und Auswirkungen zu klären. Sie kann zum Beispiel herausfinden, warum Kunden abwandern oder ein neues Produkt am Markt nicht ankommt

- .Predictive Analytics: Blickt in die Zukunft und fragt: „Was wird passieren?“. Diese Methode ermöglicht es, Abweichungen von Normwerten frühzeitig zu erkennen und Trends vorherzusagen. Mit Predictive Analytics kann ein industrieller Hersteller beispielsweise den Ausfall eine Maschine prognostizieren.

- Prescriptive Analytics: Stellt die Frage „Welche Maßnahmen sind zu treffen?“, um ein künftiges Problem zu beseitigen oder zu verhindern. Prescriptive Analytics leitet aus den vorhergehenden Analysen Handlungsempfehlungen ab, wie man einen bestimmten Trend in eine gewünschte Richtung beeinflussen kann.

Als Oberbegriff für Diagnostic, Predictive und Prescriptive Analytics hat sich „Advanced Analytics“ etabliert. In Zukunft sollten Unternehmen laut Gartner verstärkt von der deskriptiven Analyse („Was ist passiert?“) der traditionellen Business Intelligence zu Advanced Analytics migrieren. „Während grundlegende Analysen eine allgemeine Zusammenfassung der Daten bereitstellen, ermöglicht Advanced Analytics vertiefte Erkenntnisse und granulare Datenanalysen“, erklärt Alexander Linden, Research Vice President von Gartner.

Umfragen unterstützen diese Aussage. Laut „2018 Advanced and predictive Analytics Market Research“ von Dresner Advisory Services haben die meisten Befragten zum ersten Mal Advanced und Predictive Analytics als „entscheidend“ oder „sehr wichtig“ betrachtet. Dem „BI Trend Monitor 2019 Survey“ des Forschungs- und Beratungsinstituts BARC zufolge glauben die Führungskräfte aus dem C-Level, dass Advanced Analytics einer der wichtigsten und aktuellsten BI-Trends ist.

Welche Methode der Datenanalyse für Sie geeignet ist, hängt aber grundsätzlich von Ihren Zielen ab, also der Frage, die Sie beantworten wollen, und davon, welchen Umfang die Daten haben.

Werkzeuge für Datenexperten

Die konkrete IT-technische Umsetzung der Datenanalyse erfolgt mit BI- und Analytics-Tools. Die Werkzeuge werten die Daten aus und visualisieren die Ergebnisse in der Regel gleich so, dass die Zusammenhänge verständlich werden. Wie simpel sich dieser Prozess gestaltet und wie gut sich Daten konkret visualisieren lassen, ist stark abhängig von der gewählten Software.In vielen Unternehmen sind Analytics-Anwendungen im Einsatz, mit denen nur versierte User aus der IT oder BI-Experten umgehen können. Auf der untersten Ebene sind das Programmierwerkzeuge wie Python und Statistik-Software wie R oder SPSS, die eigentlich nur für Hardcore-Datenwissenschaftler interessant sind.

Auf einer höheren Stufe angesiedelt ist Analytics-Software wie SAS Advanced Analytics oder das recht populäre Open-Source-Tool Apache Spark, das insbesondere für die Analyse unstrukturierter Daten beziehungsweise großer Datenmengen entwickelt wurde.

Darüber hinaus gibt es Werkzeuge speziell für Predictive Analytics – etwa IBMs Predictive-Analytics-Toolset oder die Watson-Tools für Predictive Analytics. Datenanalysten und Datenwissenschaftler mögen diese Tools gern nutzen und die Ergebnisse der Auswertungen auch sofort verstehen, aber im wirklichen Leben müssen auch Marketingspezialisten, Vertriebsteams oder andere Interessenvertreter mit den Resultaten vertraut gemacht werden.

Das herkömmliche Vorgehen ist, dass ein Datenexperte mit diesen Tools Analysen im Auftrag der Fachabteilungen durchführt. Er bearbeitet deren Fragen mit Hilfe mehr oder weniger komplexer Programmiermethoden. Auf Basis der Analysen erstellt der Datenexperte dann einen Report für die Fachabteilungen. Oft generiert er auch umsetzbare Analyseanwendungen und integriert so Dateneinblicke in Arbeitsabläufe. Beispielsweise erstellen Entwickler Dashboards, sodass Geschäftsanwender Daten leicht visualisieren und Einblicke entdecken können, die speziell auf ihre Bedürfnisse zugeschnitten sind.

10 Fragen

Die Beantwortung der folgenden Fragen trägt dazu bei, Analytics-Projekte erfolgreich durchzuführen.

- Was genau möchten Sie herausfinden?

- Welche statistischen Parameter interessieren Sie?

- Woher kommen Ihre Daten?

- Wie sichern Sie die Qualität Ihrer Daten?

- Welche statistischen Analysetechniken wollen Sie anwenden?

- Brauchen Sie ETL-Prozeduren für Ihre Daten?

- Wie lassen sich die Ergebnisse verifizieren beziehungsweise absichern?

- Wie und von wem wird das Ergebnis genutzt und in das Unternehmen integriert?

- Welche Datenvisualisierung setzen Sie ein?

- Wie wird der Erfolg des Projekts gemessen?

Analyse im Selfservice

In neuerer Zeit gibt es den Trend, dass normale Mitarbeiter selbst Datenanalysen vornehmen und Reports erstellen. Das ist vor allem für kleinere Betriebe interessant, die sich keine eigenen Datenexperten leisten können. Aber auch in größeren Unternehmen werden Datenanalysen immer öfter direkt von den Fachbereichen durchgeführt. Der Vorteil: Statt in langwierigen Prozessen mit den Experten zu kommunizieren, gestaltet sich die Datenauswertung in Eigenregie schnell und intuitiv.

in Eigenregie (c) Microsoft

Der Markt stellt für diese Zwecke eine Reihe einfach zu bedienender Analytics-Tools bereit. Microsoft Excel als das am weitesten genutzte Datenwerkzeug bietet bereits viele Datenanalyse-Funktionen wie Korrelationen oder Regression. Allerdings hat Excel als Analyse-Tool seine Grenzen und erfordert bei anspruchsvolleren Auswertungen Makro-Programmierung.

Mehr Möglichkeiten bieten dezidierte Selfservice-Tools. Mit diesen Werkzeugen können Fachabteilungen Analysen komplett in Eigenregie durchführen und Reports erstellen. Die Zeitersparnis ist enorm: Laut BARC warten Entscheider auf einen beauftragten Bericht bis zu einem Tag. Mit einem Selfservice-BI-Tool können sie einen großen Teil der Analysen selbst erarbeiten – in durchschnittlich 20 Minuten.

Auch Gartner beobachtet einen „Wandel von IT-zentrierten Analyse-Plattformen zu modernen BI- und Analyse-Tools, die nicht nur wenigen Fachleuten, sondern vielen Mitarbeitern gezielte Analysen ermöglichen“. Tableau und Microsoft Power BI bilden laut Gartner die beiden Spitzen-Selfservice-Tools. Sie enthalten beide intuitive Analysemöglichkeiten und sind für Anwender einfach zu handhaben.

Eine Studie der Harvard Business Review Analytic Services zeigt eine Verbindung zwischen der Befähigung zu Entscheidungen von Mitarbeitern an vorderster Front und der Leistung von Unternehmen. Die Studie fand heraus, dass Unternehmen erfolgreicher sind, wenn sie diese Mitarbeiter in die Lage versetzen, im aktuellen Moment wichtige Entscheidungen zu treffen. „Qualitativ hochwertige Entscheidungsfindung an vorderster Front führt kurzfristig zu Gewinnen, aber was noch wichtiger ist: Sie bringt langfristig bessere Geschäftsergebnisse“, erklärt Alex Clemente, Managing Director bei Harvard Business Review Analytics Services.

Der Nutzen von Visualisierung

Egal ob die Datenanalysen von einem Experten oder in Eigenregie durchgeführt werden – in jedem Fall müssen die Ergebnisse dargestellt, präsentiert und in Handlungen umgesetzt werden. In diesem vierten Schritt unterstützen Dashboards, Berichte und insbesondere Datenvisualisierungen Business-Anwender dabei, die erzielten Ergebnisse zu verstehen und für sich zu nutzen.

Besonders Visualisierung kann bei der Metamorphose von Daten in verwertbare Informationen und Einsichten helfen. Ihre Stärke liegt darin, komplexe Informationen in einer klaren, leicht verständlichen Weise darzustellen. Sie erlaubt es auch, zusätzlich zu den analytischen Auswertungen, verborgene Muster oder Trends zu entdecken, sodass tiefere Einsichten möglich sind und der Nutzer das „große Bild“ in seinen Daten sehen kann.

Viele BI- und Analytics-Werkzeuge und insbesondere Selfservice-Tools wie Microsoft Power BI und Tableau haben die Visualisierung von Daten bereits integriert. Das bedeutet, dass Sie am Ende des Analyseprozesses, wenn Sie Erkenntnisse extrahiert haben, das Gelernte sofort anwenden können, ohne Ihre Analyseplattform verlassen und alternative Tools verwenden zu müssen.

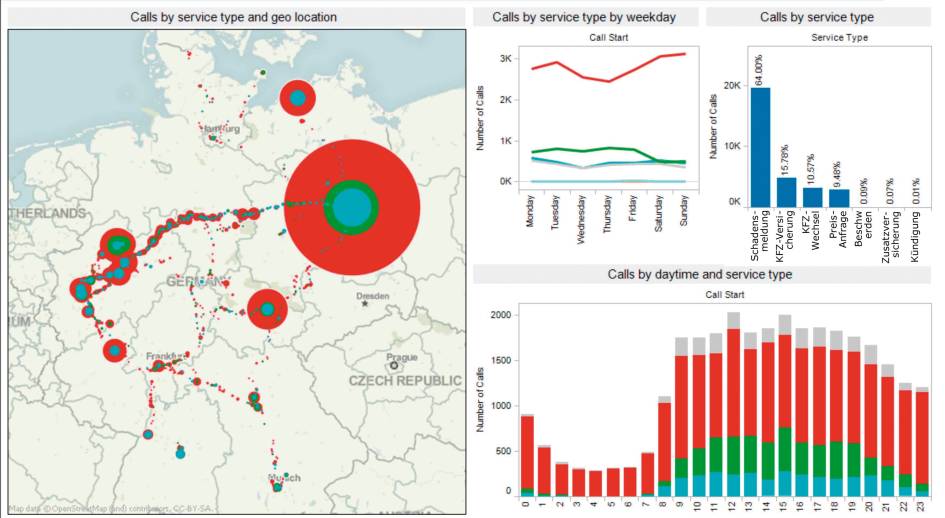

Die Möglichkeiten der Datenvisualisierung gehen weit über die Standarddiagramme und -graphen von Excel hinaus. Mit Hilfe von Infografiken, Geo-Maps, Sparklines und Heatmaps werden Daten in eine höchst informative Form gebracht. Die Besonderheit liegt dabei in der Interaktivität und den vielseitigen Möglichkeiten, die Analyse der Daten in verschiedene Richtungen zu steuern (siehe Kasten auf Seite 62).Interaktive Visualisierungs-Tools entfalten besonders auch bei Besprechungen und Präsentationen einen Mehrwert. Statt einer textlastigen PowerPoint-Präsentation zu folgen oder sich durch lange Excel-Tabellen zu quälen, können die Teilnehmer während der Besprechung Fragen stellen und sich diese anhand der visualisierten Daten sofort in Echtzeit beantworten lassen. Bei der gemeinsamen Analyse und Visualisierung von Daten sehen alle die Fakten und Zahlen auf einen Blick. Statt mit der Frage nach dem „Was“ können sie sich gleich mit der Frage nach Ursachen und Hintergründen beschäftigen. Das führt zu schnelleren Entscheidungen, erleichtert die Zusammenarbeit – und steigert die Produktivität.

Der letzte Schritt: Handeln

Nachdem Sie Ihre Daten analysiert und visualisiert haben, sollten sich jetzt – im letzten Schritt des Datenanalyse-Prozesses – Informationen herausgeschält und gewisse Einsichten ergeben haben, die Sie verwerten können. Es lassen sich dann konkrete Maßnahmen ergreifen.

Sind Sie etwa im E-Commerce tätig und haben aus Kunden-E-Mails, Website-Aktionen, Foren und Callcentern das Benutzerverhalten verfolgt, dann können Sie Kundenprofile erstellen. Diese helfen gezielt bei Marketing-Aktivitäten und Kundenansprachen. Im Finanzwesen wiederum können Sie leicht erkennen, ob ein Kunde kurz davor ist, abzuwandern, wenn er einem ähnlichen Muster folgt wie andere, die ihre Konten bereits gekündigt haben. Sie können dann sofort Maßnahmen ergreifen, um den Kunden bei der Stange zu halten.

Be the first to comment