Backups zu erstellen ist in Zeiten von Big Data und Ransomware-Attacken essenziell. Hier lesen Sie, wie Sie Ihre Daten sicher speichern. [...]

Egal, ob im privaten oder professionellen Umfeld – Backups gelten häufig nur als lästiges Übel und werden entsprechend stiefmütterlich behandelt. Dabei sind sie in Zeiten von steigenden Ransomware-Angriffszahlen im wahrsten Sinne des Wortes häufig überlebenswichtig. Etwa, wenn es gilt, die verschlüsselten IT-Systeme in kürzester Zeit wieder einsatzbereit zu haben, um den Geschäftsbetrieb fortsetzen zu können.

Backup – Definition

Ein Backup ermöglicht es Anwendern, gelöschte, überschriebene oder manipulierte Daten wiederherzustellen. So wird einem Verlust wichtiger Informationen vorgebeugt. Oftmals geschieht dies über Offline-Kopien oder eine externe Festplatte, doch auch die Cloud bietet sich als Backup-Option an. Solche Absicherungsmaßnahmen rücken im Zeitalter der Digitalisierung immer mehr in den Fokus, denn heutzutage werden Unmengen von Daten produziert, bearbeitet und gelesen.

Beispielsweise speichern Privatpersonen ihre digitalen Dokumente, wie Kontoauszüge oder Rechnungen, online ab und pflegen große Archive mit Smartphone-Fotos. Und im professionellen Umfeld fallen etwa im Zusammenhang mit Industrie 4.0 enorme Mengen geschäftskritischer Daten an, die häufig aus Platz- und Verwaltungsgründen in die Cloud verlagert werden. Stets besteht dabei jedoch die Gefahr eines Datenverlusts – sei es durch versehentliches Löschen, einen Hardwarefehler oder einen Cyberangriff. Als Pendant zum Backup sollte deshalb auch der Recovery-Prozess – als das Wiederherstellen der Daten – nicht vernachlässigt werden.

Vor diesem Hintergrund wurden im Rahmen des aktuellen „Veritas Vulnerability Lag Report“ 2.050 Führungskräfte aus insgesamt 19 Ländern befragt. Das Ergebnis: Im Schnitt brauchen Unternehmen in den kommenden zwölf Monaten zwei Millionen Euro und 24 neue IT-Mitarbeiter, um die Sicherheitslücken in ihren IT-Systemen zu schließen und ihre Daten ausreichend zu schützen. 82 Prozent der Befragten gaben außerdem an, dass ihr Unternehmen in den vergangenen Monaten unter Ausfällen zu leiden hatten. Worauf müssen Unternehmen also bei einem modernen Backup-System achten?

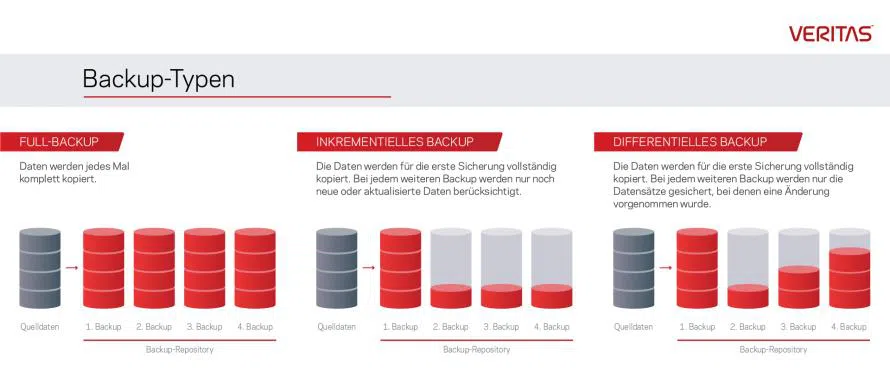

Backup erstellen – Vier Varianten

Grundsätzlich gibt es vier wichtige Möglichkeiten, um ein Backup zu erstellen:

Full Backup

Mit dieser Variante des Backups können Unternehmen sämtliche Daten sichern, die sich beispielsweise auf einem Server befinden. Sie stellt die Grundlage für Notfallwiederherstellungen dar. Es empfiehlt sich ein vollständiges Backup, sobald Backup-Quellen geändert oder aktualisiert wurden. Dies gilt auch bei signifikanten Anpassungen der Konfigurationen von Betriebssystem und Anwendungen. Der Vorteil dieser Variante besteht darin, dass immer ein aktuelles Backup des gesamten Systems in einem Backup-Satz verfügbar ist. Somit befinden sich alle Informationen an einem Ort beziehungsweise in einem „Datensatz“ – lästiges Suchen entfällt und die Wiederherstellungszeiten (kurz RTO) sind vergleichsweise gering. Allerdings handelt es sich hierbei um eine eher ineffiziente Lösung, da stets dieselben Daten kopiert werden.

Inkrementelles Backup

In diesem Fall werden – anders als beim Full-Backup – nicht pauschal alle Daten gesichert. Vielmehr geht es darum, neue und veränderte Daten mit jeder Sicherung zu erfassen und zu sichern. Dies führt zu einer effizienteren Speichernutzung im Vergleich zu häufigeren Full-Backups. Allerdings werden in diesem Fall die Datensicherungen auf mehrere Backup-Sätze verteilt. Eine Wiederherstellung kann daher mehr Zeit in Anspruch nehmen, zumal die einzelnen Backup-Sätze auch in der richtigen Reihenfolge wiederherzustellen sind.

Differenzielles Backup

Solche Sicherungen umfassen Daten, die sich seit dem letzten Full-Backup ergeben haben. Diesem Ansatz liegt der Gedanke zugrunde, dass im Allgemeinen die Änderungsraten der Daten im Vergleich zur gesamten Datenmenge eher gering sind. Der Zeitaufwand für die Durchführung des Backups lässt sich dadurch minimieren. Ein weiterer Vorteil im Vergleich zur inkrementellen Backup-Methode besteht darin, dass zum Zeitpunkt der Datenwiederherstellung maximal zwei Sicherungsmedien benötigt werden. Und je weniger Medien im Einsatz sind, desto geringer ist das Risiko, dass ein Wiederherstellungsauftrag aufgrund eines Medienfehlers fehlschlägt.

Gleichzeitig ermöglicht dieses Vorgehen eine überaus schnelle Wiederherstellung im Vergleich zur Wiederherstellung von inkrementellen Backups. Allerdings werden bei einem Datensicherungsvorgang alle Dateien berücksichtigt, die seit dem letzten vollständigen Backup hinzugekommen sind oder modifiziert wurden. Dies führt zur Erstellung größerer Sicherungskopien, die den Speicher entsprechend stärker belasten.

Synthetisches Backup

Die synthetische Sicherung, auch kataloggesteuerte Sicherung genannt, wird eingesetzt, wenn ein vollständiges Backup auf Grund von Dauer oder zu kleinen Backupfenstern und Netzwerkverkehr nicht möglich ist.

Synthetische Backups bauen im Allgemeinen auf inkrementelle Backups oder Deduplikations-Technologien auf. Durch Deduplikation wird eine Reduktion des benötigten Speichers für Datensicherungen erreicht, indem im Idealfall auf Segmentebene entschieden wird, ob entsprechende Daten einzigartig sind oder bereits bekannt sind. Entsprechend nutzt der Deduplikations-Mechanismus die bereits bekannten Segmente und verbindet diese auf logischer Ebene mit dem Backup. Diese Technik pflegt eine Tabelle der Kataloginformationen und aktualisiert diese, sobald Daten hinzugefügt, modifiziert oder gelöscht werden.

Über die Backup-Programmlogik steht immer ein logisches Full-Backup für den Restore zur Verfügung. Insbesondere wenn Deduplikation auf einem zu sichernden Server durchgeführt wird (CSD oder Client-Side-Deduplication), ergibt sich eine starke Entlastung der Netzinfrastruktur und es können kürzereBackupfenster erreicht werden. Im Wiederherstellungsfall setzt das Backup-Programm volle Backups intelligent aus den Inkrementen oder Segmenten zusammen und ermöglicht so einen zeitnahen Full-Backup Restore.

Datensicherung – Dark Data identifizieren

Eng verbunden mit der Erstellung von Backups ist das Thema der Datenverwaltung. Denn schließlich sollten Unternehmen nur Backups erstellen, die auch nötig sind. „Datenmüll“ – also triviale und überflüssige Daten – sollte vor der Erstellung von Backups aussortiert werden. In diesem Zusammenhang ist es wichtig, dass Unternehmen ihre Speicher auf sogenannte Dark Data untersuchen. Dabei handelt es sich um Informationen, deren Wert für das Unternehmen unbekannt ist. Laut Untersuchungen von Veritas beläuft sich deren Anteil auf mittlerweile über 50 Prozent.

Überflüssige Informationen zu sichern, bindet Ressourcen, ohne dass ein Mehrwert daraus gezogen wird. Folgende Schritte helfen, Dark Data zu identifizieren und zu vermeiden:

- Alle Datenquellen identifizieren und einsehen: Data Mapping und Data Discovery sind die ersten beiden Maßnahmen, mit denen Firmen die Datenflüsse in ihrer Organisation besser verstehen können. So gewinnen sie einen Überblick über ihre Datenbestände.

- Dark Data langfristig verhindern: Unternehmen sollten nur zweckgebundene Daten speichern. Mit Meta-Tags und flexiblen Regeln für die Aufbewahrung der Daten lassen sich irrelevante Informationen leichter aufspüren und risikofrei löschen. Zusätzlich bieten Self Services die Möglichkeit für berechtigte und privilegierte Anwender, früher im Erstehungsprozess von Dark Data einzugreifen.

- Automatisierung durchführen: Für Analysen, Nachverfolgungen und Reportings empfiehlt sich ein selbstständiger Ablauf. Auf Grundlage von automatisierten Berichten können Unternehmen in der Folge Dark Data besser identifizieren.

Cloud Backup: Daten in der Cloud sichern

Das Cloud-Backup gehört in vielen Unternehmen längst zum Alltag. Denn es bietet nicht nur viel Platz, sondern auch eine hohe Nutzerfreundlichkeit. Dementsprechend sind die dazugehörigen Backup-Systeme oftmals einfach zu bedienen. Somit können IT-Verantwortliche rasch wachsende Datenmengen und Workloads sichern und im Bedarfsfall Daten wiederherstellen – selbst in komplexen Umgebungen bestehend aus lokalen Rechenzentren, Private und Public Clouds.

Beim Cloud-Backup profitieren die Nutzer von vier Faktoren:

- Freie Auswahl des Anbieters: Das Angebot an Cloud Service Providern (CSPs) ist groß. Anwender können daher ihre Backups auf unterschiedliche Cloud-Anbieter verteilen, je nachdem, welcher die gewünschten Funktionen zur Verfügung stellt. Beispielsweise bietet Google umfangreiche Analytics, während sich Microsoft auf Legacy-Applikationen konzentriert und Amazon Web Services großen Wert auf Cloud-Storage legt.

- Unabhängigkeit: Ein Unternehmen, das mit nur einem Cloud Provider zusammenarbeitet, macht sich abhängig. Denn der Vendor-Lock-In kann zur Folge haben, dass ab einer gewissen Datenmenge die Transaktionskosten für einen Wechsel von einem CSP zu einem anderen unwirtschaftlich werden. Daher empfiehlt sich in diesem Zusammenhang eine Multi-Cloud. Dadurch lassen sich die Daten auf unterschiedliche Anbieter verteilen, und ein Umzug von Daten wird erleichtert.

- Sicherheit: Sind die Backups bei mehreren CSPs in verschiedenen Regionen hinterlegt, bedeutet dies eine erhöhte Sicherheit. Denn kein Dienst ist komplett ausfallsicher: Naturkatastrophen, Hackerangriffe oder menschliches Versagen können unverhofft eintreten. Verteilt gespeichert findet sich aber immer ein funktionierendes Backup.

- Skalierbarkeit: Ein besonders großer Vorteil der Cloud ist außerdem die Abrechnung nach Speicherplatz und Rechenzyklen für die Workloads, die auch tatsächlich genutzt wurden. Konzerne mit eigenem Rechenzentrum sind dadurch in der Lage, flexibel zu entscheiden, wo sie ihre Daten aufbewahren. Hierbei sollten Langzeit-Backups in günstigen Cloud-Speichern abgelegt werden, kritische Daten hingegen sollten lokal aufbewahrt werden.

Worst-Case-Backup-Szenario: Disaster Recovery

Ist der Ernstfall eingetreten und Unternehmen müssen Daten wiederherstellen, sollten bereits im Vorfeld alle erforderlichen Schritte festgelegt sein. So lassen sich reibungslose Recovery-Prozesse realisieren. Dabei sind im Wesentlichen folgende fünf Schritte zu beachten:

- Basics festlegen: Jede Anwendung in einem Unternehmen entspricht einem speziellen Geschäftswert. Je wichtiger die Applikation, desto schneller muss sie wiederhergestellt werden – ein möglichst kurzes Zeitfenster von etwa 5 Minuten ist keine Seltenheit. Neben diesen sogenannten Recovery Time Objectives (RTOs) muss auch geregelt sein, wie viele Daten eine Anwendung während des Ausfalls höchstens verlieren darf. Das spiegeln die Recovery Point Objectives (RPOs) wieder. Sie beschreiben die Häufigkeit der Sicherungsintervalle.

- Selbstständig ablaufende Prozesse: Automatische Abläufe sind für Unternehmen eine enorme Hilfe, rasch Daten und Anwendungen wiederherzustellen. Außerdem minimieren sie das Risiko auf Fehler. Deswegen empfiehlt sich eine Wiederherstellung mit automatisierten Prozessen für Failover, Failback und Tests, um lange und teure Ausfallzeiten zu vermeiden.

- Probeläufe durchführen: Testen ist essenziell, um die Funktionsfähigkeit im Krisenfall sicherzustellen. In manchen Branchen sind solche Tests bereits in den Compliance-Vorgaben enthalten, beispielsweise im Finanz- und Gesundheitssektor. Wichtig ist, dass die Tests in einer Sandbox ablaufen, ohne dass die Produktionssysteme darunter leiden. Dank dieser Simulationen können die Mitarbeiter die Dauer und Komplexität des Vorgangs besser einschätzen – eine wichtige Erkenntnis, die den Teams im Ernstfall bei einem Ausfall der Systeme viel Stress ersparen kann.

- Zentrale Erfassung verschiedener Clouds: Oft nutzen Unternehmen unterschiedliche Cloud-Lösungen gleichzeitig. Es ist jedoch nicht zielführend, für jede Umgebung ein eigenes Werkzeug zu verwenden. Denn dieser Ansatz zieht höhere Betriebskosten und längere Ausfälle nach sich und erhöht die Komplexität. Dadurch wächst das Risiko für die Geschäftsprozesse. Eine umfassende Disaster-Recovery-Strategie umfasst dagegen sämtliche Bereiche und ist effizienter.

- Individuelle Ansprüche adressieren: Für eine Wiederherstellung gibt es unterschiedliche Szenarien. Es kann beispielsweise sein, dass es nur um wenige virtuelle Maschinen geht. Aber auch komplexe, mehrschichtige Applikationen oder sogar ein ganzes Rechenzentrum sind denkbar. Die Recovery-Strategie sollte diese Möglichkeiten flexibel und simpel abbilden können.

*Patrick Englisch ist Director Technical Sales DACH bei Veritas Technologies.

Be the first to comment