Hersteller bewerben ihre Produkte gerne mit beeindruckenden Zahlen. Aber funkt der neuste Router tatsächlich viel schneller als der Vorgänger? Und ist das ultraschnelle 5G heute schon nützlich? Unser Ratgeber bringt Licht ins Dunkel. [...]

Zahlen und Werte sind ein essenzieller Bestandteil der Technologiewelt. Und in vielen Technikbereichen schnellen diese Zahlen nur so in die Höhe. Da fragt man sich zu Recht: Wie viel davon ist wirklich nötig? Lohnt es sich überhaupt, wegen höherer Werte auf dem Papier auf neue Hardware umzusteigen? Wir haben uns die beliebtesten Technologien angeschaut. Wir sagen Ihnen, was sich bei diesen verändert hat, ob Sie die Neuerungen wirklich schon brauchen oder ob Sie besser noch abwarten.

Mobilfunk

5G war eines der großen Themen von 2020. Und das soll in diesem Jahr etwas heißen. Von Tech-Fans über Sportveranstalter bis in die Untiefen der Verschwörungstheoretiker-Ecke ist die neue Mobilfunkgeneration in aller Munde. Für den Endnutzer halten sich die Vorteile aber noch in Grenzen. Längst noch nicht alle Geräte unterstützen 5G, Bild 1. Derzeit ist das hauptsächlich einigen Android-Flaggschiffen vorbehalten. Der Ausbau des Netzes variiert noch relativ stark je nach Anbieter und Region. Das globale Chaos von 2020 hat hier natürlich auch nicht geholfen.

Für den Nutzer sind die Vorteile von 5G relativ überschaubar. Etwas mehr als dreimal so schnell ist das 5G-Netz gegenüber 4G aktuell, mehr wird in Zukunft erwartet. Ob man das braucht, hängt sehr vom individuellen Nutzungsverhalten ab. Wer sein Smartphone größtenteils für Chats und Telefonanrufe verwendet, profitiert kaum. Wer hingegen Videostreams oder Cloud-Dienste nutzt, dürfte den Unterschied spüren. Das kann vor allem für jüngere Anwender ein Vorteil sein, da diese oftmals das Smartphone als Hauptgerät im Alltag verwenden.

Grundsätzlich öffnen sich mit 5G auch ein paar andere Optionen wie 5G-Router, die für einige Nutzer einen Glasfaseranschluss ersetzen können. Die größten Vorteile bringt 5G aber im Bereich des« Internet der Dinge» (IoT, Internet of Things). Smarte Autos oder Verkehrsanlagen können über 5G mit deutlich weniger Latenz funktionieren und werden so erst richtig praktikabel, Bild 2. Mittelfristig kann 5G auch größere Nutzerzahlen mit schnellem Tempo versorgen als 4G, was bei der stetig wachsenden Mobilnutzung relevant wird.

Fazit

Früher oder später wird sich 5G durchsetzen. Für den Nutzer gibt es aber kaum einen triftigen Grund, sich mit dem Umstieg zu beeilen. Die direkten Vorteile sind aktuell noch überschaubar und mit der Weiterentwicklung von 4G nicht allzu groß. Man kann also durchaus in 5G-kompatible Hardware investieren, aber auch noch ein paar Jahre mit 4G zufrieden sein.

Wi-Fi

Wi-Fi ist die Technologie, die im Alltag hauptsächlich zur Erstellung von kabellosen Lokalnetzwerken (WLAN) verwendet wird. Häufiger ist auch die Verbindung zwischen zwei spezifischen Geräten per Wi-Fi; beispielsweise zum Übertragen von Fotos von einer Kamera auf ein Smartphone. Der neue Wi-Fi-6-Standard bringt neben schnelleren Übertragungsraten noch einige weitere Tricks mit sich, die das Upgrade von Wi-Fi 5 lohnenswert machen. Stellen wir gleich zu Beginn die Terminologie klar: Wi-Fi 5 ist der neue Name für 802.11ac. Bei Wi-Fi 6 handelt es sich um 802.11ax. Die älteren Standards 802.11a/b/g/n werden von uns nicht umbenannt.

Die wichtigste Neuerung ist die maximal mögliche Datenübertragungsrate. Wi-Fi 5 schafft unter perfekten Bedingungen bis zu 6,9 Gbit/s, bei Wi-Fi 6 sind es 9,6 Gbit/s. Die Optimalwerte werden bei beiden Standards aber in der Praxis nicht annähernd erreicht (siehe Fazit). Wi-Fi 6 wurde jedoch besser auf Effizienz getrimmt, Bild 3.

Stark verbessert wurde mit dem neuen Wi-Fi 6 die parallele Unterstützung mehrerer Geräte. Mit immer mehr Netzwerkgeräten pro Haushalt ist es wichtig, dass diese Geräte stabil und schnell miteinander kommunizieren können. Das neue Wi-Fi 6 erledigt dies deutlich effizienter als Wi-Fi 5. Ein weiterer Vorteil ist die gleichzeitige Unterstützung der beiden Frequenzbänder 2,4 GHz und 5 GHz. Wi-Fi 5 konnte nur mit 5 GHz etwas anfangen und musste für 2,4-GHz-Verbindungen einen älteren Standard verwenden. In den meisten Fällen ist 5 GHz die bessere Wahl. Das 2,4-GHz-Frequenzband strahlt jedoch besser durch Wände sowie andere Hindernisse und ist somit in gewissen Häusern und Wohnungen die stabilere Lösung.

Fazit

Wi-Fi 6 lohnt sich vor allem für Power-Nutzer und IoT-Fans (Internet of Things = smarte Geräte), Bild 4. Großfamilien, Büros oder Messen dürften ebenfalls vom verbesserten Multi-User-Support profitieren. Für Einzelpersonen und kleinere Haushalte gibt es hauptsächlich einen besseren Datendurchsatz, was nett, aber nicht wirklich lebensnotwendig ist. Zumal in unseren Tests auch mit Wi-Fi 6 die Höchstwerte zwar gut, aber nicht sensationell sind; die schnellsten Geräte erreichten auf sehr kurze Distanz um die 900 Mbit/s, also nicht einmal 1 Gbit/s. Wer auf eine wirklich schnelle und stabile Leitung angewiesen ist, bleibt am besten beim Kabel. Hinzu kommt, dass Wi-Fi 6 momentan auch noch nicht von allen neuen Geräten unterstützt wird.

USB

USB ist extrem populär und gleichzeitig extrem verwirrend. Jeder, der in den letzten 20 Jahren irgendwann einmal irgendetwas mit einem Computer zu tun hatte, hat USB verwendet. Die Frage ist allerdings: Welche Version davon?

Zunächst sollten wir unterscheiden zwischen USB-Steckern und USB als Übertragungsstandard. Das sind zwei verschiedene Dinge. USB-Stecker gibt es drei: Type-A, Type-B und Type-C, wobei beim Type-B Variationen vorkommen. Type-A ist der altbekannte breite, rechteckige Anschluss, den man vom PC oder von vielen Ladeadaptern her kennt. Type-B ist meistens ein kompakteres Gegenstück zu einem Type-A-Stecker, vor allem an älteren Smartphones oder externen Festplatten gebräuchlich – üblich in vier häufigen und ein paar seltenen Variationen, die natürlich miteinander inkompatibel sind. Dann ist da der neue Type-C-Stecker, wendbar und oval, der mittlerweile praktisch überall zum Einsatz kommt und bei Weitem nicht nur für USB-Verbindungen verwendet wird, so zum Beispiel auch für Audio/Video-Übertragungen über den DisplayPort-Anschluss.

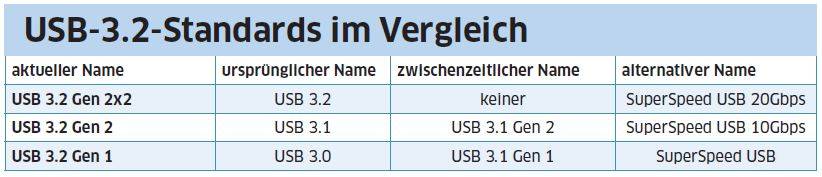

Neben den Steckern gibt es den Übertragungsstandard USB. Dieser kann Daten und teilweise Strom über ein Kabel von einem Gerät zu einem anderen übertragen. Im Umlauf sind vor allem noch die Standards USB 2.0, USB 3.0, USB 3.1 und USB 3.2. Das wäre grundsätzlich einfach zu verstehen. Allerdings wurden USB 3.0 und 3.1 mit der Einführung von USB 3.2 umbenannt in 3.2 Gen 1 und 3.2 Gen 2, während USB 3.2 als 3.2 Gen 2×2 bezeichnet wird. Bei der Einführung von USB 3.1 passierte ein ähnlicher Wechsel und auch USB 2.0 enthält den bisherigen USB-1.0-Standard im Namen, um die Verwirrung noch grösser zu machen. In der Tabelle unten finden Sie eine Übersicht über die neueren 3.2-Standards. Es sind fast alle Kombinationen von USB-Standard und Steckertyp erhältlich. Es gibt sogar seltene Kabel mit Type-C-Stecker und USB 2.0. Diese könnten künftig deutlich häufiger werden, da der Type-C-Stecker immer beliebter wird, aber nicht in jedem Fall mehr als USB 2.0 nötig ist. Die einzige unmögliche Kombination ist USB 3.2 Gen 2×2 mit einem älteren Type-A- oder Type-B-Stecker, Bild 5.

Upgrades lohnen sich vor allem bei Speichermedien. Externe Festplatten und SSDs profitieren ungemein von schnelleren Durchsatzraten. Per USB 3.2 Gen 2×2 angeschlossene Datenträger sind schneller verbunden als SATA-Datenträger und können quasi wie eingebaute Laufwerke verwendet werden. Als Datenübertrager ist das Upgrade bei USB aber etwas schwierig, denn die Kompatibilität hängt nicht nur von einem, sondern gleich zwei Geräten ab. Entsprechend ist ein USB-Upgrade meistens eher ein Nebenprodukt eines sonstigen Hardware-Upgrades.

Die aktuell spannendste Upgrade-Möglichkeit liegt wohl bei Type-C als Monitorkabel, Bild 6. Dabei wird ein Bildschirm per Type-C-Kabel mit dem PC verbunden und überträgt Strom und Daten per USB sowie Audio und Video per DisplayPort; alles in einem Kabel. Ist der Monitor stark genug, kann sogar das Notebook oder Tablet über das USB-Kabel aufgeladen werden.

Fazit

Ein USB-Upgrade lohnt sich vor allem bei Datenträgern und Videoverbindungen. Allerdings muss dafür fast immer mehr als nur die Verbindung ersetzt werden, was die Sache verkompliziert. Entsprechend ist es sinnvoll, ein USB-Upgrade mehr als Nebeneffekt eines sowieso fälligen Hardware-Upgrades zu behandeln. Es gibt auch Situationen, in denen ein Upgrade kaum etwas bringt. Beispielsweise bei USB-Instrumenten, die darüber MIDI-Daten senden. Diese brauchen nicht mehr als USB 2.0 und profitieren nicht wirklich von neueren Standards, Bild 7.

Nutzspeicher

HDD-Festplatte oder SSD (Solid State Drive)? Das ist eine Frage, die schon eine Weile kursiert und praktisch jedes Jahr eine etwas andere Antwort bekommt. Das Zeitalter der Festplatte neigt sich mehr und mehr dem Ende zu, je günstiger das Terabyte eines SSD wird. Technisch gesehen ist das SSD der Festplatte praktisch in jeder Hinsicht überlegen: SSDs lesen und schreiben schneller, haben keine physisch bedingten Verzögerungen, sind kompakter und deutlich weniger fehleranfällig. Der Hauptgrund, warum noch immer nicht jeder PC ausschließlich mit SSDs ausgerüstet ist, sind die Kosten. Nach aktuellem Stand (*September 2020) kostet ein Terabyte HDD zwischen 50 und 80 Franken. Nach oben skaliert der Preis nur wenig. Vier Terabyte kosten knapp über 100 Franken. Bei SSDs sieht die Sache anders aus. Das Terabyte ist aktuell preislich fast an der Festplatte dran. Je nach Variante kostet ein Terabyte SSD zwischen 100 und 300 Franken, wobei die günstigeren Modelle deutlich langsamer sind als die High-End-Modelle. Will man hingegen 4 Terabyte in einem SSD-Modul verbauen, geht unter 400 Franken nichts. Die schnellen NVMe/M.2-Modelle sind ab 800 Franken verfügbar.

Entsprechend lohnt sich ein SSD vor allem für Daten, die rasch zugänglich sein sollten: das Betriebssystem beispielsweise. Games, große Grafikdateien oder aufwendige 3D-Projekte profitieren ebenfalls ungemein vom schnelleren Speicher. Für weniger kritische Daten ist die HDD allerdings immer noch unschlagbar, wahrscheinlich aber nicht mehr lange. Denn wie erwähnt: Es liegt praktisch ausschließlich am Preis und dieser sinkt stetig. Wichtig zu beachten ist jedoch, dass SSD nicht gleich SSD ist. Achten Sie beim Kauf unbedingt auf die Lese- und Schreibraten sowie auf die Durchsatzraten des Anschlusses. Die meisten 2,5-Zoll-SSDs werden per SATA III angeschlossen und sind so tempomäßig limitiert (wenn auch immer noch deutlich schneller als Festplatten). Richtigen Superspeed gibt es erst mit SSDs mit PCI-E-Anschluss. Die meisten davon kommen im M.2-Format und ähneln optisch einem RAM-Riegel. Diese Modelle sind noch um ein Vielfaches schneller und machen richtig Spaß, Bild 8.

Fazit

Der Wechsel von HDD auf SSD ist eines der besten Upgrades, das man als PC-Nutzer machen kann. Nur schon die Möglichkeit, den PC innerhalb einer einstelligen Sekundenzahl aufzustarten, ist die Investition wert. Ein SSD macht sich bei jedem Arbeitsschritt bemerkbar und ist somit ein lohnendes Upgrade.

Bildwiederholrate

Der Standard-PC-Monitor liefert Bilder in 60 Hz. Das heißt in diesem Kontext, dass das Bild 60-mal pro Sekunde neu gezeichnet wird. Das ist flüssig genug, ohne allzu viel Leistung zu verbrauchen. Bildschirme mit niedrigeren Wiederholraten sind kaum noch zu finden. Allerdings gibt es immer mehr Displays mit schnelleren Frequenzen. Bei Smartphones verwenden einige Spitzenmodelle 90 Hz oder 120 Hz und im Gaming-Bereich sind Monitore mit 120, 144 und 240 Hz üblich, Bild 9.

Eine höhere Bildwiederholrate lässt Animationen und Bewegungen flüssiger erscheinen, sofern diese selbst genug schnell sind. Zieht man beispielsweise ein Explorer-Fenster eine Sekunde lang über den Bildschirm, sieht man bei einem 60-Hz-Display 60 einzelne Bilder, wobei das Fenster bei jedem Bild ein wenig weiterbewegt wird. Bei einem 120-Hz-Display sind es doppelt so viele Bilder, was die Bewegung weicher und flüssiger erscheinen lässt.

Ist die Quelle jedoch sowieso in niedrigerer Frequenz, macht das keinen Unterschied. Die meisten Filme werden in 24 FPS gefilmt und sehen so auf einem 60-Hz-Bildschirm genau gleich aus wie auf einem 240-Hz-Bildschirm, da die Kamera gar nie mehr als 24 Bilder pro Sekunde aufgezeichnet hat. Ähnlich ist es bei Games: Schafft die Grafikkarte nur 30 FPS, ist die Bildwiederholrate des Monitors irrelevant. Dazu sei noch gesagt, dass Bildwiederholraten über 60 Hz zwar im Direktvergleich klar wahrgenommen werden, denn das Auge gewöhnt sich daran. Verwendet man einen Morgen lang einen hochfrequenten Bildschirm, erscheint ein 60-Hz-Modell am Nachmittag erst etwas rucklig. Nach einigen Minuten nimmt man den Unterschied aber nicht mehr bewusst wahr. Wer sollte sich also einen Monitor mit mehr als 60 Hz zulegen?

Im Prinzip lohnt sich so ein Display praktisch nur für kompetitive Gamer. Schnelle Games, die Millimeter-Präzision voraussetzen, profitieren von dieser flüssigeren Darstellung am meisten. Nur schon für Singleplayer-Games ist es fragwürdig, ob man eine solche Bildwiederholrate wirklich braucht. Für alle anderen Nutzer ist ein hochfrequenter Monitor ein reiner Luxus und je nach Modell sogar ein Nachteil. Denn viele Bildschirme erreichen die hohen Frequenzen, indem sie an anderen Orten sparen – beispielsweise bei der Farbqualität des Panels oder beim Kontrast. Für kompetitive Gamer ist das nicht wichtig, für andere Nutzer unter Umständen schon.

Fazit

Hochfrequente Bildschirme sind für fast alle Anwender ein reines Luxusgut. Man hat es, weil man es will, nicht weil man es unbedingt braucht. Einzig kompetitive Gamer erhalten einen wirklich greifbaren Vorteil davon. Alle anderen bekommen ein flüssigeres Bild, was nett, aber nicht wirklich überlebensnotwendig ist.

Megapixel

Es ist der Marketingklassiker des frühen 21. Jahrhunderts schlechthin. Mehr Megapixel = bessere Fotos. Und auch nach 20 Jahren in diesem Millennium ist das nur bedingt richtig. Denn die Anzahl Pixel ist lediglich ein kleiner Teil der Fotoqualität. In den Anfängen der Digitalfotografie hatte das Megapixel-Argument durchaus seine Berechtigung. Die meisten Sensoren dieser Zeit waren eher schwach und lieferten oftmals niedrigere Auflösungen als gängige PC-Bildschirme; etwa die weitverbreitete VGA-Auflösung früher Handy-Kameras, die mit 640 × 480 Pixeln gerade einmal 0,3 Megapixel festhielt. PC-Bildschirme dieser Zeit liefen aber bereits häufig mit Auflösungen um XGA (1024 × 768 Pixel) und auch HD-Bildschirme (1280 × 720 Pixel) warteten gleich um die Ecke. Entsprechend ergibt es Sinn, dass sich Kamerahersteller wegen ein paar Pixeln mehr oder weniger brüsteten. Gerade auch im Druck ist der Unterschied zwischen 1 und 4 Megapixeln ein großer. Der Unterschied zwischen 24 Megapixeln und 48 Megapixeln ist für ein reguläres Fotoalbum aber nicht mehr relevant. Da muss man schon grösser drucken, um wirklich profitieren zu können. Für Drucke bis etwa A4 reichen rund 10 Megapixel bei der klassischen Tintenstrahl-Auflösung von 300 dpi. Mit einer modernen 24-Megapixel-Kamera schafft man bei 300 dpi Fotos bis etwa 50 × 30 Zentimeter. Diese Werte kann man mit einer niedrigeren, aber immer noch guten Auflösung von 150 dpi verdoppeln.

Auch was Bildschirme angeht, hat der Druck nach mehr Pixeln etwas abgenommen. Aktuelle Bildschirmauflösungen liegen deutlich unter den üblichen Kamerasensoren:

- FHD: 1920 × 1080 Px = 2,07 Mpx

- QHD: 2560 × 1440 Px = 3,69 Mpx

- UHD: 3840 × 2160 Px = 8,29 Mpx

Die meisten modernen Kameras bieten mindestens 12 Megapixel. Bei spiegellosen Systemkameras sind 24 Megapixel derzeit ein üblicher Wert. Spannend wird es mit 8K UHD-2. Hier sprechen wir von einer Bildauflösung von 7680 × 4320 Pixeln und somit von 33,18 Megapixeln. Einige aktuelle Kameras liegen darunter. Allerdings ist bis dahin noch ein wenig Zeit. Zeit, in der beispielsweise die Upscaler der Grafikprozessoren weiter verbessert werden. Eine Technologie, die solche Pixelknappheit fast restlos ausrotten könnte.

Einen großen Vorteil haben hochauflösende Kameras: den Digitalzoom. Ein 48-Megapixel-Bild kann relativ stark zugeschnitten werden, ohne dabei allzu klein zu werden, Bild 10. Das ist mit einem kleineren Foto nicht möglich. Ob dann in diesem zugeschnittenen Bildausschnitt genug Details vorhanden sind, hängt aber nicht nur von der Auflösung des Sensors, sondern auch vom Objektiv und von Faktoren wie sichtbaren Partikeln in der Luft ab. Und genau dieser letzte Punkt ist wichtig.

Fazit

Mehr Pixel heißt nicht ein besseres Bild. Eine 24-Megapixel-Kamera mit einem ordentlichen Objektiv liefert garantiert bessere Qualität ab als ein 96-Megapixel-Smartphone. Die Pixel sind nur ein Teil der Gleichung und viele andere Teile haben im Endeffekt einen größeren Einfluss auf das Endresultat. Für Druckaufträge sind die heutigen, riesigen Megapixel-Werte praktisch irrelevant. Mit dem Aufkommen von 8K-Bildschirmen könnte es hingegen noch einmal interessant werden.

Be the first to comment