MLOps überträgt DevOps-Prinzipien aufs Machine Learning. Das fördert die Zusammenarbeit und beschleunigt Projekte. [...]

Das Interesse am Einsatz von Künstlicher Intelligenz (KI) und maschinellem Lernen (ML) ist ungebrochen. Bereits 2021 beschäftigten sich laut der Studie „Machine Learning 2021“ von IDG Research Services rund zwei Drittel der Firmen in Deutschland mit diesem Thema. Inzwischen dürfte sich dieser Anteil weiter erhöht haben.

Damit gewinnen Konzepte an Bedeutung, die KI-Projekte beschleunigen und optimieren sollen. Besonderes Interesse hat in letzter Zeit der Ansatz des Machine Learning Operations (MLOps) auf sich gezogen. „MLOps ist eine Erweiterung der DevOps-Methodik, um Ressourcen aus den Bereichen maschinelles Lernen und Data Science gleichberechtigt in die DevOps-Ökologie einzubeziehen“, erläutert Christoph Nützel, Head of Technology and Data bei Futurice, einem Digitalisierungsspezialisten, der selbst agile Methoden und MLOps einsetzt.

Eine Kernfunktion von MLOps ist die Verwaltung von Machine-Learning-Modellen über den gesamten Lebenszyklus hinweg, einschließlich der Bereitstellung, Überwachung und Governance, ergänzt Joseph George, Vice President Product Management bei BMC Software.

„Machine-Learning-Modelle werden in Bezug auf das Lifecycle-Management und die Entwicklung wie Software behandelt und verwaltet.“

Eine wichtige Funktion von MLOps besteht darin, ML-Modelle zu schaffen, die sich mehrfach verwenden lassen. Das wirkt sich günstig auf die Entwicklungskosten aus und reduziert die Zeit, bis ML-Anwendungen einsatzfähig sind.

Ein zentrales Element ist außerdem die Automatisierung von Entwicklungs- und Bereitstellungsschritten. Dies gilt für die Integration, das Testen, die Implementierung und die Verwaltung der erforderlichen Infrastruktur.

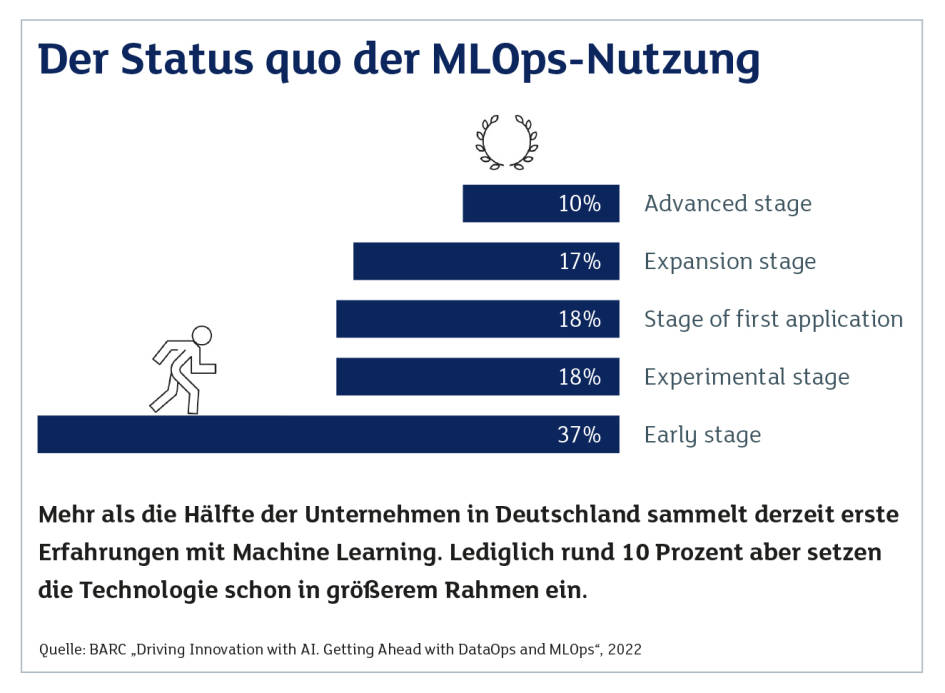

(Quelle: BARC)

Außerdem können sich Entwickler und Data Scientists besser auf Kernaufgaben wie das Entwickeln von Machine-Learning-Algorithmen konzentrieren, wenn Routineaufgaben automatisch ablaufen – vom Validieren bis zum Update von ML-Modellen.

„Zudem erleichtert MLOps die Qualitätssicherung durch ein vereinfachtes Debugging und macht Modelle und deren Performance interpretierbar“, sagt Srikumar Ramanathan, Chief Solutions Officer bei Mphasis, einem Anbieter von Lösungen und Services für Digitalisierungsprojekte. (Siehe auch Interview.)

Am Anfang der Reise

Doch dass MLOps Vorteile bietet, scheint sich in deutschen Unternehmen nur langsam zu verbreiten. Denn laut der Studie „Driving Innovation with AI. Getting Ahead with DataOps and MLOps“ des Würzburger Marktforschungs- und Beratungsunternehmens BARC (Business Application Research Center) stehen die meisten Unternehmen in Deutschland noch am Anfang ihrer Reise in Richtung Machine Learning Operations.

Demnach setzt nur etwa die Hälfte der Firmen, die ML-Projekte gestartet haben, diesen Ansatz und die komplementäre Methodik DevOps (Development Operations) ein.

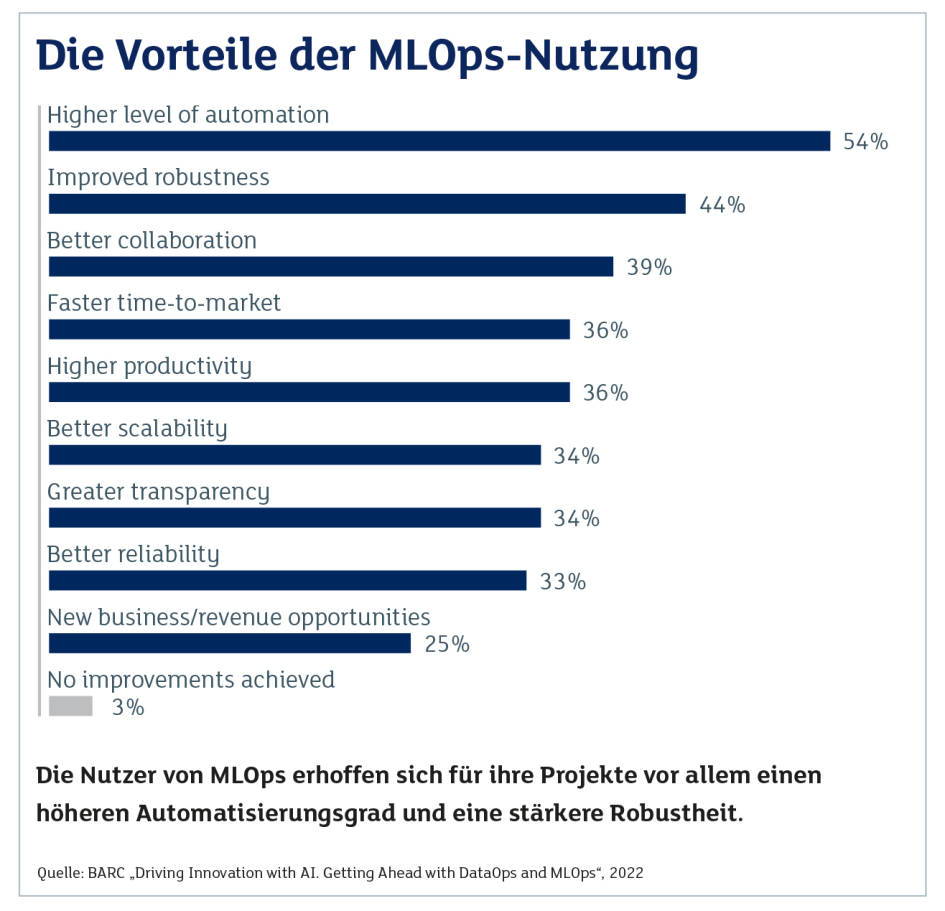

Dies ist BARC zufolge verwunderlich. Denn 97 Prozent der Befragten gaben zugleich an, dass MLOps und DevOps in Projekten zu deutlichen Verbesserungen führen, etwa in Bezug auf den Automatisierungsgrad von Prozessen, eine schnellere Marktreife und eine bessere Zusammenarbeit der Projektbeteiligten.

„DataOps richtet sich auf die Realisierung eines überschaubaren, wartbaren und automatisierten Flusses qualitätsgesicherter Daten zu Datenprodukten“, erklärt Alexander Rode, Data & Analytics Analyst bei BARC. „Und MLOps adressiert zusätzlich die speziellen Anforderungen bezüglich der Entwicklung, Bereitstellung und Pflege von ML-Modellen, die ebenfalls Datenprodukte sind.“

„ML-Projekte richten sich nicht am Anwendungsfall aus, sondern an den vorhandenen Daten.“

Christoph Nützel – Head of Technology and Data bei Futurice

Ein Grund für die zögerliche Haltung gegenüber MLOps ist nach Einschätzung von Jens Beier, Business Area Manager Business Applications & Data Analytics bei Axians, die Furcht vor einer Zerfaserung der IT-Umgebung: „Oft setzen Unternehmen Standard-Software-Tools ein, wie SAP oder Salesforce, um eine homogene Umgebung zu haben.“

Diese Plattformen würden häufig den Kontext für KI- und Machine-Learning-Projekte vorgeben, trotz daraus resultierender möglicher Reibungsverluste.

(Quelle: BARC)

Keine Wunderwaffe

Im ersten Schritt sollten sich Nutzer von KI und Machine Learning darüber klar werden, welche Ziele sie überhaupt mit diesen Technologien erreichen möchten. Beide seien fast immer in einen bestehenden Unternehmens- oder Prozesskontext eingebettet, beispielsweise in Bereichen wie Vertrieb, Produktion oder Service, so Jens Beier.

„KI steht also nicht als Wunderwaffe da, sondern optimiert und automatisiert bestehende Prozesse.“

Daher ist es unverzichtbar, vor der Einführung von KI, ML und der entsprechenden „Ops-Frameworks“ zu prüfen, ob nicht bereits konventionelle Ansätze ausreichen: „Oftmals stellt sich heraus, dass ein spezifisches Problem eine andere oder einfachere Lösung benötigt als zunächst gedacht“, betont Christoph Nützel von Futurice.

„KI ist keine Wunderwaffe, sondern optimiert und automatisiert bestehende Prozesse.“

Jens Beier – Business Area Manager Business Applications & Data Analytics bei Axians Deutschland

Ein weiterer potenzieller Stolperstein ist die Datenbasis: „ML-Projekte richten sich nicht am jeweiligen Anwendungsfall aus, sondern an den vorhandenen Daten“, so Nützel weiter.

Diese Tatsache lässt sich häufig mit herkömmlichen Arbeitsweisen nicht in Einklang bringen. Daher ist es notwendig, dass Entwickler, IT-Fachleute, Experten aus den Fachbereichen und Data Scientists Wege finden, um effektiv zusammenzuarbeiten und zu kommunizieren.

Der MLOps-Prozess

Dabei spielt nicht nur der Faktor Mensch eine Rolle bei der Entwicklung und dem Operationalisieren von Machine-Learning-Modellen und entsprechenden Anwendungen. Im ersten Schritt ist es nötig, die Problemstellung zu definieren, die ein Anwender mithilfe von ML angehen möchte, etwa die Qualitätssicherung in einer Produktionsumgebung zu verbessern.

Zusätzlich müssen Kriterien festgelegt werden, die den Erfolg des Einsatzes von Machine Learning belegen. Das kann eine Reduzierung der fehlerhaften Produkte in der Fertigung um einen bestimmten Prozentsatz sein.

Eine zentrale Rolle spielt die Suche nach passenden Daten und deren Aufbereitung. „Ein Grund für das Scheitern von ML-Projekten ist die mangelhafte Datenbereinigung“, stellt Joseph George von BMC Software fest.

Dieser Schritt sieht die Aufteilung in Datensets für Training, Test und Validierung vor und wird von Data Scientists durchgeführt.

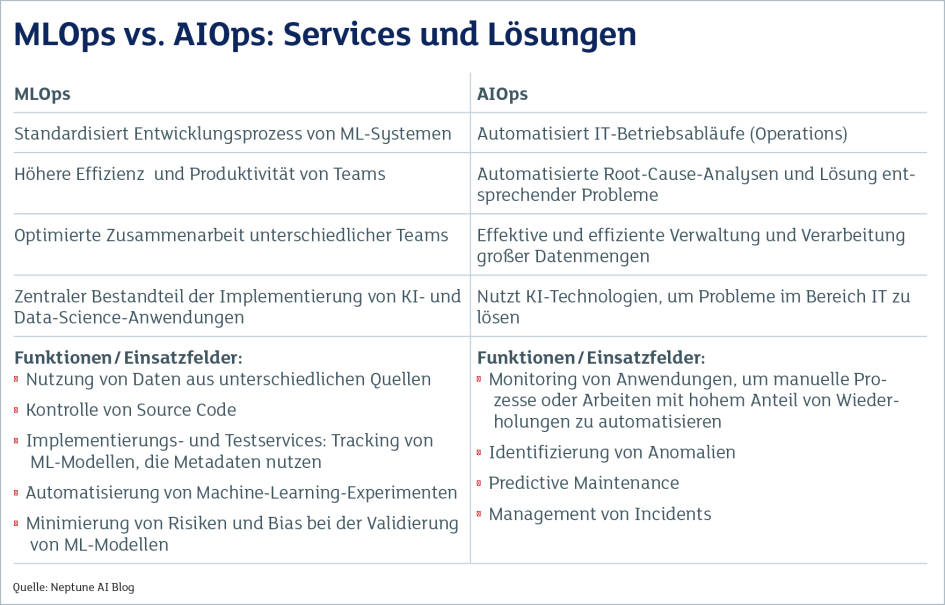

(Quelle: Neptune AI Blog)

Schnelle Bereitstellung durch Automatisierung

Anschließend folgt das Training von Machine-Learning-Modellen. Meist kommen dabei unterschiedliche Algorithmen zum Einsatz. Das Modell, das sich nach Abschluss dieser Arbeiten als tauglichste Variante präsentiert, wird evaluiert und validiert.

Ein Kriterium dabei ist die Fähigkeit eines ML-Modells, Vorhersagen zu treffen. In diesem Stadium sind Automatisierungsfunktionen besonders wichtig, um den Zeitraum zwischen Training und Validierung kurz zu halten. Kurz bedeutet, dass ein ML-Modell nach wenigen Tagen zur Verfügung stehen sollte.

Die letzten Schritte sind die Implementierung des Modells in der Einsatzumgebung und das Monitoring. Die kontinuierliche Überprüfung ist wichtig, weil Machine Learning meist nicht in statischen Umgebungen zum Einsatz kommt. Vielmehr kann es sinnvoll sein, ein Modell zu modifizieren, etwa wenn neue oder ergänzende Daten zur Verfügung stehen.

Das heißt, es handelt sich um eine iterative Vorgehensweise mit ständigen Anpassungen und Optimierungen. Auch diese Aufgaben lassen sich im Rahmen eines MLOps-Ansatzes automatisieren.

Open Source, Cloud, kommerziell?

Unternehmen, die MLOps einführen möchten, haben mehrere Optionen. „Generell können MLOps und DevOps als prozessorientierte Konzepte gleichermaßen mit Open-Source- und kommerziellen Tool-Stacks umgesetzt werden“, sagt Alexander Rode von BARC.

Laut der erwähnten Studie des Beratungshauses haben Nutzer von kommerziellen Werkzeugen seltener Probleme mit der Komplexität, wenn sie Machine-Learning-Modelle operationalisieren, als User von Open-Source-Werkzeugen. Generell rät Rode, mit unterschiedlichen MLOps-Tools zu experimentieren. Dabei sollten Anwender aktuelle und künftige Anforderungen berücksichtigen.

Zu den bekanntesten Open-Source-Werkzeugen zählt MFlows, eine Plattform, mit der Nutzer den Lebenszyklus von Machine-Learning-Modellen verwalten können, inklusive Test und Implementierung.

Weitere Open-Source-Plattformen sind Kubeflow von Google, Metaflow vom Streaming-Spezialisten Netflix sowie MLReefs. Zudem können MLOps-Fachleute auf eine breite Palette von Werkzeugen für spezielle Aufgaben zurückgreifen.

Beispiele sind etwa MLRun für das Entwickeln und Implementieren von ML-Modellen und AutoKeras, eine Library für Automated Machine Learning (AutoML). Auf AutoML greift eine weitere Lösung zurück: H2O für die Optimierung von Machine-Learning-Prozessen.

„Machine-Learning-Modelle werden mit MLOps in Bezug auf das Lifecycle-Management und die Entwicklung wie Software behandelt und verwaltet.“

Joseph George – Vice President Product Management bei BMC Software

Für Unternehmen ist es sicherlich eine Herausforderung, aus vielen Komponenten eine MLOps-Umgebung zusammenzustellen. Vor allem dann, wenn es an Fachleuten mangelt, etwa Data Scientists und Machine-Learning-Spezialisten. Mit Kubeflow steht jedoch nach Einschätzung der deutschen IT-Beratung Viadee eine Open-Source-Plattform bereit, die das Potenzial hat, sich zur dominierenden MLOps-Lösung zu entwickeln.

Eine weitere Option sind Plattformen und Frameworks, die Anbieter wie BMC Software, Mphasis oder Data Robot offerieren. Sie stellen teilweise Funktionen bereit, die über MLOps hinausreichen. Das ist beispielsweise bei BMC Helix Operations Management mit AIOps der Fall.

Eine Komponente ist ein Operations-Management, eine weitere sind KI-gestützte Analyse- und Automatisierungsfunktionen für den IT-Betrieb.

Pace-ML von Mphasis dagegen kombiniert Model Deployment Pipelines und ein Monitoring von ML-Modellen auf einer Plattform. Dies vereinfacht nach Angaben des Anbieters die Versionskontrolle und die Wartung der Modelle.

Auch bekannte Unternehmen aus dem IT-Bereich wie IBM und HPE haben Plattformen wie HPE Ezmeral und IBM Cloud Pak for Data um Machine Learning Operations erweitert. Hilfreich ist, dass Nutzer bei einem Teil der Lösungen diese wahlweise in einer Public Cloud oder im eigenen Rechenzentrum implementieren können.

Eine weitere Option sind cloudbasierte MLOps-Plattformen von Anbietern wie AWS, Microsoft (Azure) und Google (Google Cloud Platform, GCP). Sie ergänzen KI- und Machine-Learning-Services dieser Cloud-Service-Provider. Für Unternehmen, die bereits solche Dienste nutzen, ist es daher eine Überlegung wert, auch die MLOps-Komponente beim betreffenden Provider zu buchen.

„Unsere Lösung übernimmt die Implementierungs- und Inferenzschritte, um die Integration und Ausführung zu beschleunigen.“

Johan den Haan – Chief Technology Officer bei Mendix

Allerdings gibt Joseph George von BMC Software eines zu bedenken: „Vor allem große Unternehmen sind selten reine Cloud-Shops, sondern eine Mischung aus Multi-Cloud- und On-Premises-Infrastrukturen sowie Mainframe-Umgebungen.“ Daher sei es wichtig, dass cloudgestützte MLOps-Lösungen Daten aus solchen hybriden Umgebungen verarbeiten können.

Christoph Nützel von Futurice wiederum rät dazu, die Entscheidung für MLOps-Tools an die IT-Strategie anzupassen. Wichtig bei der Auswahl einer Lösung sei vor allem, „wie ich Daten, ML-Modelle und Features versionieren kann“. Die Antworten darauf geben die Richtung vor. Nötigenfalls sollten Anwender auf die Expertise herstellerneutraler Beratungsunternehmen zurückgreifen.

Be the first to comment