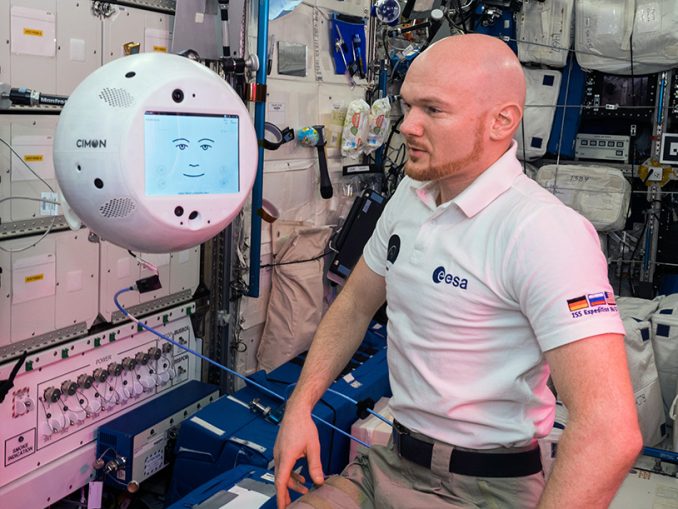

Der in Deutschland entwickelte und gebaute Astronauten-Assistent CIMON (Crew Interactive Mobile CompanioN) hat seine Feuertaufe im All bestanden. Er und der deutsche ESA-Astronaut Alexander Gerst haben rund 90 Minuten im Columbus-Modul der Internationalen Raumstation ISS miteinander gearbeitet. [...]

Am 15. November 2018 um 11.40 Uhr MEZ hielt das Missionsteam im Bodenkontrollzentrum BIOTESC der Hochschule Luzern den Atem an. Nach zweieinhalb Jahren intensiver Vorbereitungen und unzähliger Test– und Trainingsstunden mit CIMON auf der Erde konnte man eine Stecknadel zu Boden fallen hören – höchste Konzentration und freudige Anspannung lagen in der Luft: Nach dem Software-Upload zur ISS und einem Software-Update von CIMON selbst, einem Audio-Check und einem Test der Navigationskamera nahm Alexander Gerst seinen neuen künstlichen Mitbewohner auf der Raumstation nicht nur in Augenschein, sondern auch in Betrieb. 90 Minuten lang dauerte die Weltpremiere, das erste „Rendezvous“ zwischen dem deutschen ESA-Astronauten und dem sich autonom fortbewegenden robotischen Assistenten.

„Wach auf, CIMON!“

Nachdem Alexander Gerst seinen künstlichen Helfer aus seiner Box im Columbus-Modul der ISS geholt hatte, weckte er ihn mit den Worten „Wach auf, CIMON!“ und die Antwort kam prompt: „Was kann ich für Dich tun?“ Danach ließ Alexander Gerst CIMON frei schweben – zunächst noch ferngesteuert vom Boden. Damit wurde das so genannte „Guidance, Navigation and Control“-System in Betrieb genommen.

Es folgte die autonome Navigation mit mehreren Drehungen und Bewegungen in alle Richtungen und CIMON war in der Lage, das Gesicht von Alexander Gerst zu suchen und Augenkontakt aufzunehmen. Als Demonstration seiner Assistenzfähigkeiten zeigte CIMON auf seinem „Gesicht“, einem Display in der Mitte der Kugel, die Anleitung für ein Schüler-Experiment zur Kristallbildung und spielte einen Musiktitel ab. Er nahm mit seinen integrierten Kameras ein Video und ein Foto von Alexander Gerst auf. Zum Abschluss brachte Gerst CIMON wieder an seinen Platz im Columbus-Modul zurück. Während der Kommissionierung hat die Projektverantwortliche von BIOTESC, Gwendolyne Pascua, direkt mit Alexander Gerst gesprochen, um ihn durch das Experiment zu begleiten: „Die Sprachverbindung hat einwandfrei funktioniert und ich bin sehr erleichtert, dass die Zusammenarbeit mit CIMON und Alex so gut geklappt hat.“

„Es ist ein unglaubliches Gefühl und eine wahnsinnige Freude, zu erleben, dass CIMON wirklich sieht, hört, versteht und spricht. Dieser erste echte Einsatz im All bedeutet für uns ein Stück Raumfahrtgeschichte und stellt den Beginn für einen hoffentlich langen Einsatz auf der ISS dar“, fasst Christian Karrasch, CIMON-Projektleiter in der deutschen Raumfahrtagentur im DLR zusammen. „Die Interaktion mit einer Künstlichen Intelligenz fasziniert mich. Das System CIMON ist in dieser Form weltweit einzigartig und speziell für den Einsatz auf der Internationalen Raumstation konzipiert. Wir betreten hier Neuland und erweitern den technologischen Horizont in Deutschland.“

„Ein großer Schritt für die bemannte Raumfahrt“

„Mit CIMON haben wir eine Vision von uns in die Realität umgesetzt. Es ist ein sehr großer Schritt für die bemannte Raumfahrt, den wir hier gemeinsam gehen konnten. Durch CIMON haben wir den Grundstein für soziale Assistenzsysteme gelegt, die unter extremen Bedingungen zum Einsatz kommen sollen“, ergänzt Till Eisenberg, CIMON-Projektleiter bei Airbus.

Zur Datenübertragung nutzte CIMON das WLAN auf der Internationalen Raumstation und stellte über Satellitenverbindung per Bodenstationen eine Internetverbindung zur IBM Cloud her. Was dann in CIMONs Gehirn abläuft, erklärt Matthias Biniok, IBM–Projektleiter, so: „Wird CIMON eine Frage gestellt oder mit ihm gesprochen, wandelt die Watson KI dieses Audiosignal zunächst in Text um, der von der KI verstanden bzw. interpretiert wird. Dabei kann IBM Watson die Inhalte nicht nur in ihrem Kontext verstehen, sondern ebenso die damit verbundene Intention. Das Resultat ist eine passgenaue Antwort, die wiederum in Sprache umgewandelt und wieder an die ISS zurückgeschickt wird. So ist ein natürlicher, dynamischer Sprachdialog möglich.“

Bernd Rattenbacher, Teamleiter beim Bodenkontrollzentrum an der Hochschule Luzern: „Die Datenverbindung zur Erde läuft via Satellit zur NASA und zum Columbus Kontrollzentrum beim DLR in Oberpfaffenhofen. Von dort aus geht das Signal zu uns, der CIMON Bodenstation in BIOTESC, dem Schweizer User Support und Operations Center, das per Internet mit der IBM Cloud in Frankfurt verbunden ist. Die reine Signallaufzeit über die Satelliten beträgt 0,4 Sekunden in eine Richtung. Zur Datensicherheit sind viele Firewalls und VPN Tunnel aktiv.“

CIMON hat auch einen wissenschaftlichen Hintergrund. Berater sind Judith-Irina Buchheim und Alexander Choukèr von der Klinik für Anästhesiologie am Klinikum der Ludwig-Maximilians-Universität München. Judith Buchheim: „CIMON könnte als KI-Partner und Begleiter Astronauten bei ihrem hohen Pensum an Experimenten, Instandhaltungs- und Reparaturarbeiten unterstützen und dadurch deren Stressexposition reduzieren.“

CIMON wurde im Auftrag der Raumfahrtagentur im Deutschen Zentrum für Luft- und Raumfahrt (DLR) mit Mitteln des deutschen Wirtschaftsministeriums von Airbus in Friedrichshafen und Bremen entwickelt und gebaut und nutzt die künstliche Intelligenz (KI) der IBM–Watson–Technologie. Das Klinikum der Ludwig-Maximilians-Universität München betreut das Projekt wissenschaftlich.

Die Idee hinter CIMON

CIMON ist ein in Deutschland entwickeltes und gebautes Technologie–Experiment zur Unterstützung und Effizienz-Steigerung der Arbeit eines Astronauten. CIMON kann Informationen, Anleitungen zu wissenschaftlichen Experimenten und Reparaturen darstellen und erklären. Ein Vorteil ist, dass der Astronaut beide Hände frei hat durch den sprachgesteuerten Zugriff auf Dokumente und Medien. Weitere Anwendungen sind z.B. die Nutzung als mobile Kamera zur Einsparung von Astronauten Crew-Zeit. Vor allem Routineaufgaben könnten durch CIMON erledigt werden, wie etwa die Dokumentierung von Experimenten, Suche nach Objekten und Inventarisierung. CIMON kann auch sehen, hören, verstehen und sprechen. Seine beiden Augen sind zwei Kameras zur Gesichtserkennung und weitere fünf Kameras zur Orientierung und Videodokumentation. Ultraschall-Sensoren messen Abstände zur Kollisionserkennung. Seine Ohren sind acht Mikrofone zur Richtungserkennung plus ein Richtmikrofon für eine gute Spracherkennung. Sein Mund ist ein Lautsprecher, über den er sprechen und Musik abspielen kann. Kernstück der KI für das Verständnis von Sprache ist die IBM Watson KI–Technologie aus der IBM Cloud. Selbstständiges Lernen von CIMON wurde ausgeschlossen, er muss aktiv durch einen Menschen trainiert werden. Die KI zur autonomen Navigation stammt von Airbus und dient der Bewegungsplanung und Objekterkennung. Durch zwölf interne Ventilatoren kann sich CIMON frei in alle Raumrichtungen bewegen und rotieren. Somit kann er sich dem Astronauten zuwenden, wenn er angesprochen wird, Kopfnicken, Kopfschütteln und räumlich selbstständig oder auf Kommando folgen.

Be the first to comment