Neue technologische Entwicklungen ermöglichen ein höheres Vertrauensniveau von KI. Sie schützen vor „Halluzinationen“ und feindlichen Übergriffen. [...]

Fujitsu gab kürzlich die Einführung von zwei neuen Technologien für die Erhöhung der Vertrauenswürdigkeit von Künstlicher Intelligenz (KI) bekannt, die die Zuverlässigkeit der Antworten von KI-gesteuerten Gesprächsmodellen verbessern.

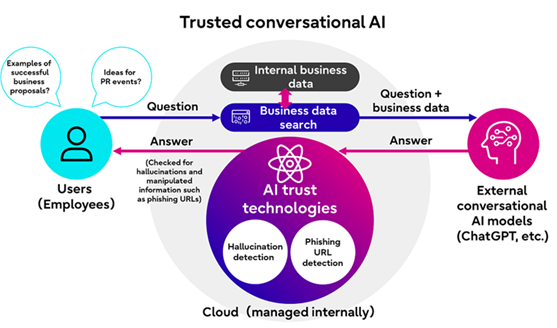

Die neu entwickelten Technologien umfassen eine Methode zur Erkennung sogenannter „Halluzinationen“. Bei diesem Phänomen erzeugt generative KI fehlerhafte oder nicht zusammenhängende Ausgaben. Des Weiteren hat Fujitsu gemeinsam mit der Ben-Gurion-Universität (BGU) Negev eine Technik entwickelt, um Phishing-URLs in den Antworten der KI auf Grund vorheriger Angriffe zu erkennen, die falsche Informationen einschleusen.

Mit den neuen Technologien will Fujitsu Unternehmens- und Einzelnutzern ein Werkzeug zur Verfügung stellen, das die Zuverlässigkeit der Antworten von KI-gesteuerten Gesprächssystemen bewertet. Dies soll zu einer sichereren Nutzung von KI in einer Vielzahl von Anwendungsfällen beitragen, so auch für Unternehmen, die beabsichtigen, die Technologie in ihren täglichen Betrieb einzuführen.

„Generative KI ist ein entscheidender Faktor und innerhalb dieses Bereichs erweist sich die von Fujitsu entwickelte Halluzinations-Erkennungstechnologie als entscheidend für die Schaffung vertrauenswürdiger Gesprächs-KI-Systeme“, kommentiert Professor Yuval Elovici von der Ben-Gurion-Universität.

„Die Forscher der Ben-Gurion-Universität und Fujitsu haben eine innovative Technik entwickelt, um die Sicherheit von KI-basierten URL-Filtern gegenüber Angreifern zu erhöhen. Unsere Arbeit konzentriert sich auf tabellarische Daten und führt zu einem widerstandsfähigeren Abwehrmechanismus gegen Angriffe im Bereich KI-gesteuerter URL-Filterung. Fujitsu und die Ben-Gurion-Universität planen, auch in Zukunft zusammenzuarbeiten, um neuartige sicherheitszentrierte Fortschritte im Bereich der generativen KI zu erzielen.“

Fujitsu wird diese neuen Technologien in seine Core-Engine für KI-gesteuerte Gespräche aufnehmen. Diese wird über die KI-Plattform Kozuchi angeboten und bietet Nutzern Zugang zu einer breiten Palette leistungsstarker KI- und ML-Technologien.

Die Technologie zur Erkennung von Halluzinationen in KI-gesteuerten Gesprächen ist seit dem 28. September 2023 in Japan verfügbar. Die Lösung zur Erkennung von Phishing-URLs in den Antworten von KI-gesteuerten Gesprächen wird ab Oktober 2023 zur Verfügung stehen. Die neuen Technologien werden sowohl für Unternehmensnutzer als auch für Einzelnutzer über eine spezielle Portal-Website2 innerhalb der Kozuchi-Plattform als Demoumgebung verfügbar sein. Fujitsu plant, beide Technologien auf dem globalen Markt einzuführen.

Neu entwickelte Technologien

1. Technologie zur genauen Erkennung von Halluzinationen in den Antworten von KI-gesteuerten Chatsystemen

Unternehmen verwenden in ihren betrieblichen Abläufen oftmals Technologien mit KI-gesteuerten Chats, um Informationen aus bereits bestehenden Geschäftsdaten, welche vorverarbeitet wurden, zu extrahieren. Explizit bedeutet dies, dass die Daten als Information zu einer Referenz hinzugefügt werden, wenn Fragen an externe KI-gesteuerte Gesprächssysteme gestellt werden.

Obwohl diese Methode genaue Antworten liefert und Halluzinationen reduziert, bleibt die vollständige Verhinderung von Halluzinationen ein fortlaufendes Problem, da KI-gesteuerte Chatbots in einigen Fällen Informationen zu Fragen nicht korrekt extrahieren können und daher nicht zusammenhängende, falsche Antworten generieren.

Zwar gibt es Methoden, um abzuschätzen, mit welcher Wahrscheinlichkeit in der Antwort einer KI eine Halluzination vorkommen könnte (Halluzinations-Score). Dennoch bleibt die genaue Abschätzung dieses Scores eine schwierige Aufgabe, da KI-gesteuerte Gesprächssysteme verschiedene Phrasen verwenden, um die gleiche Antwort auszudrücken.

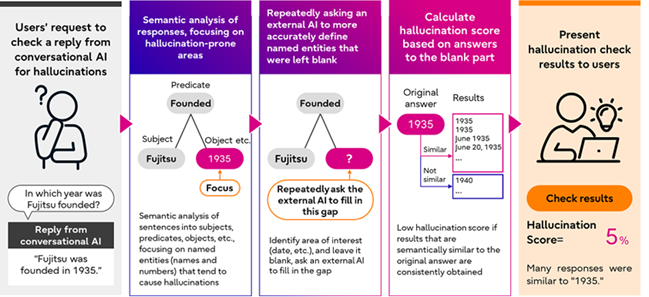

KI-gesteuerte Chatsysteme generieren häufig falsche Informationen für Eigennamen und Zahlen und der Inhalt der Antworten ändert sich bei wiederholtem Fragen. Basierend auf dieser Beobachtung hat Fujitsu eine Lösung entwickelt, um Teile von Sätzen zu identifizieren, in denen Halluzinationen wahrscheinlich auftreten.

Um einen besonders genauen Halluzinations-Score zu berechnen, zerlegt die neue Technologie zuerst die Antwort der KI in drei Teile (Subjekt, Prädikat, Objekt) und identifiziert dann automatisch benannte Entitäten in der Antwort. Als nächsten Schritt lässt die Technologie diese benannten Entitäten leer und fragt die externe KI wiederholt, um diese spezifischen Ausdrücke genauer zu definieren. (Abbildung 2)

Fujitsu hat diese Technologie anhand von Open-Data, einschließlich des WikiBio GPT-3 Halluzinationsdatensatzes, getestet und festgestellt, dass sie die Genauigkeit der Erkennung (AUC-ROC)4 um etwa 22 Prozent im Vergleich zu anderen fortschrittlichen Methoden zur Erkennung von KI-Halluzinationen wie SelfCheckGPT5 verbessern konnte.

2. Technologie zur Erkennung von Phishing-URLs in den Antworten von KI-gesteuerten Chatbots

Da KI-gesteuerte Gesprächssysteme Antworten auf der Grundlage ihrer Trainingsdaten generieren, können manipulative Entitäten die KI dazu bringen, Antworten zu generieren, die manipulierte Informationen wie Phishing-URLs enthalten. Diese führen beispielsweise zu gefälschten Websites, da manipulierte Informationen in die KI-Trainingsdaten einschleust wurden.

Um dieses Problem anzugehen, hat Fujitsu eine Technologie entwickelt, die manipulierte URLs in den Antworten von KI-gesteuerten Gesprächssystemen erkennt. Sobald die Lösung eine Phishing-URL identifiziert, gibt sie eine Warnmeldung an die Benutzer aus.

Fujitsus neue Technologie erkennt nicht nur Phishing-URLs. Sie erhöht auch die Widerstandsfähigkeit der KI gegen Angriffe, die die KI-Modelle dazu verleiten sollen, absichtliche Fehleinschätzungen vorzunehmen. So stellt Fujitsu äußerst zuverlässige Antworten der KI-basierten Chatsysteme sicher. Die neu entwickelte Technologie nutzt eine gemeinsam von Fujitsu und der Ben-Gurion-Universität im Fujitsu Small Research Lab an der Ben-Gurion-Universität entwickelte Methode.

Diese basiert auf der Tendenz, dass feindliche Entitäten oft nur einen einzigen Typ von KI-Modell angreifen, und erkennt manipulierte Daten, indem sie Informationen mit verschiedenen KI-Modellen verarbeitet und Unterschiede in den Antworten für das Beurteilungsergebnis auswertet.

Die Technologie kann nicht nur zur Erkennung von Phishing-URLs verwendet werden, sondern auch zur Verhinderung von allgemeinen Angriffen, bei denen KI-Modelle mit tabellarischen Daten arbeiten. Daher kann sie auch dazu verwendet werden, Angriffe auf andere Dienste zu verhindern.

Be the first to comment