Mit speziellen Paketen aus Hardware und Software verlängert Google seine Cloud in die On-premises-Rechenzentren und an die Edge-Standorte der Kunden. [...]

Google erweitert den Radius seiner Cloud-Plattform auf Edge-Szenarien und On-premises-Rechenzentren seiner Kunden. Anlässlich seiner Konferenz „Cloud Next 21“ kündigte der Anbieter dafür die „Google Distributed Cloud“ an. Einige Unternehmen könnten bestimmte Workloads nicht in die Public Cloud verlagern, konstatierten die Google-Verantwortlichen. Gründe dafür seien beispielsweise branchen- oder regionalspezifische Compliance-Anforderungen, der Wunsch nach Datenhoheit, niedrige Latenzzeiten sowie lokale Anforderungen an die Datenverarbeitung, oder weil Workloads am Ort der Datenentstehung ausgeführt werden müssen.

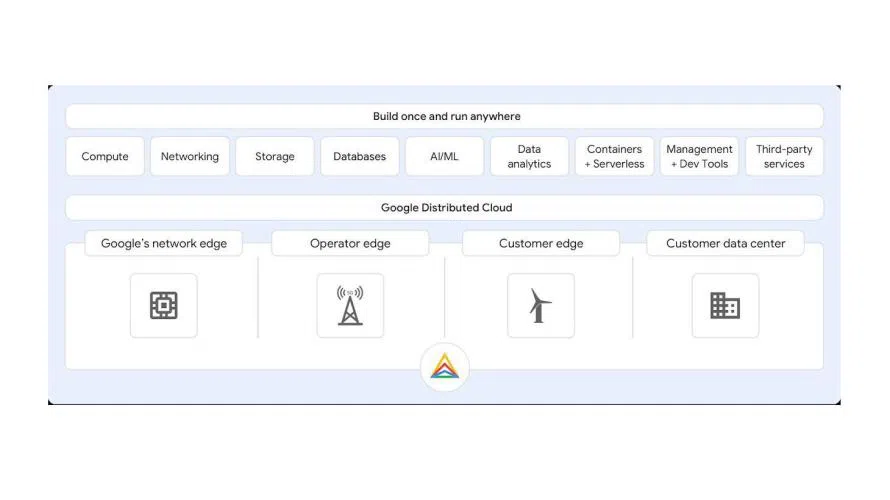

Diese Workloads trotzdem in ein Cloud-Szenario einzubinden, dafür soll Google Distributed Cloud sorgen. Der Anbieter spricht von einem Lösungsportfolio aus Hardware und Software, das Googles Cloud-Infrastruktur bis in den Edge-Bereich und in lokale Rechenzentren erweitere. Die Basis bildet „Anthos“, eine Open-Source-basierte Plattform für die Verwaltung und Steuerung von Infrastruktur- und Anwendungskomponenten in heterogen zusammengesetzten IT-Landschaften.

Anwender sollen via Anthos in die Lage versetzt werden, Anwendungen Plattform- und Cloud-agnostisch entwickeln und betreiben zu können. Google hatte die Plattform 2019 angekündigt und im vergangenen Jahr erste Dienste und Anbindungen beispielsweise an die Clouds von AWS und Microsoft vorgestellt. Hinzu kam „Migrate for Anthos“, ein Service, der es Anwendern ermöglichen sollte, Workloads aus dem klassischen Server-Betrieb und aus virtuellen Maschinen in Kubernetes-Container zu konvertieren.

Nun hat Google seine Strategie für hybride IT-Umgebungen weiter konkretisiert. Anthos läuft auf von Google verwalteter Hardware beim Kunden oder an Edge-Standorten. Mit Google Distributed Cloud ließen sich dem Anbieter zufolge Anwendungen migrieren oder modernisieren sowie Daten lokal mit Google Cloud-Services verarbeiten. Dazu zählen Datenbankfunktionen, Machine Learning, Datenanalysen und Container Management. Zudem können auch Dienste von Drittanbietern eingebunden und genutzt werden. Verschiedene Hersteller haben bereits angekündigt, Googles neue Cloud-Pakete zu unterstützen, darunter Cisco, Dell, HPE und NetApp.

(c) Google

Zum Start hat Google zwei vorkonfigurierte Packages für sein Distributed-Cloud-Portfolio vorgestellt. „Google Distributed Cloud Edge“ ist ein von Google verwaltetes Produktpaket, das die Infrastruktur und Services von Google Cloud näher an die Orte bringen soll, an denen Daten generiert werden. Integriert seien beispielsweise 5G-Core- und RAN-Funktionen (Radio Access Network) aus dem Portfolio von Telekommunikationslösungen der Google Cloud, um Anwendungsfälle wie Computer Vision und Google AI Edge Inferencing zu unterstützen.

Distributed Cloud Edge helfe Anwendern, Daten lokal sowie Edge-Computing-Workloads mit niedriger Latenz zu verarbeiten, hieß es. Google setzt an dieser auch auf den Aufbau eines Ökosystems. Mit an Bord kommen sollen beispielsweise Communications Service Provider (CSPs) sowie Anbieter wie Intel und Nvidia auf Hardwareseite und Ericsson und Nokia für das Netzequipment. Google Distributed Cloud Edge ist bereits als Preview verfügbar.

Noch bis zur ersten Jahreshälfte 2022 wird es mit dem zweiten Paket dauern. „Google Distributed Cloud Hosted“ richtet sich an Behörden und Unternehmen, die sich an strenge Vorgaben hinsichtlich Datenhaltung, Sicherheits- und Privacy-Anforderungen halten müssen. In diesen Fällen sind Googles Cloud-Dienste in den Rechenzentren der Kunden nutzbar. Dafür sei keine Verbindung in Googles Public Cloud notwendig, versichert der Anbieter. Stattdessen wird für den Betrieb von Infrastruktur, Diensten und APIs eine lokale Steuerungsebene von Anthos bereitgestellt. Ein solches System können Anwender selbst aufbauen und betreiben oder über Partner in Auftrag geben. In Frankreich arbeitet Google im Rahmen einer sogenannten „Trusted-Cloud“-Partnerschaft mit Thales zusammen, in Deutschland mit T-Systems.

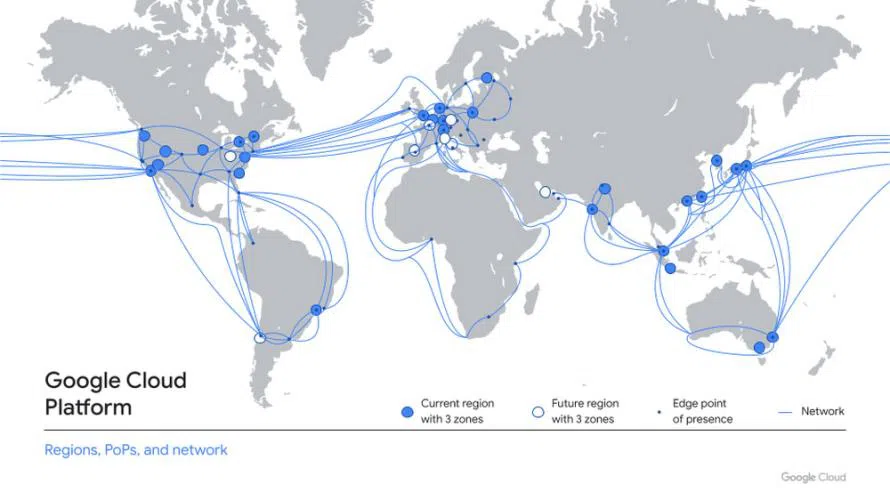

Google baut seine Cloud-Infrastruktur weiter aus

Google hat zur Next-Konferenz außerdem den Ausbau seiner weltweiten Cloud-Infrastruktur angekündigt. So seien im laufenden Jahr bereits vier neue Regionen hinzugekommen, in Warschau, Delhi, Melbourne und Toronto. Gearbeitet wird an Cloud-Zentren in Berlin-Brandenburg, Madrid, Mailand, Turin, Paris, Santiago, Columbus sowie in Israel und Saudi-Arabien. Insgesamt betreibt der Internet-Gigant derzeit 28 Cloud-Regionen weltweit. Darüber hinaus ist der Konzern an 19 Unterseekabel-Projekten beteiligt.

(c) Google

Funktional erweitert Google seine Cloud mit neuen Datenmanagement- und Analytics-Tools. Nicht einmal einem Drittel aller Unternehmen gelinge es, Nutzen aus ihren Dateninvestitionen ziehen, berichteten die Google-Verantwortlichen unter Berufung auf eine Accenture-Umfrage. Das liege in erster Linie daran, dass die entsprechenden Systeme zu schwer zugänglich, langsam, unzuverlässig, komplex und fragmentiert seien. Die Google Cloud soll Anwendern helfen, den Umgang mit Daten zu vereinfachen und ihre eigenen Daten-Clouds aufzubauen.

Zur Next 21 hat der Konzern die allgemeine Verfügbarkeit von „BigQuery Omni“ verkündet. Mit dem Tool könnten Anwender auch komplexe Aufgaben beim Datenmanagement in hybriden und Multicloud-Umgebungen steuern, beispielsweise Cloud-übergreifende Analysen mit Daten in AWS und Microsoft Azure. Noch in diesem Jahr soll „Dataplex“ folgen. Das Data-Fabric-Tool erlaubt es Anwendern, ihre Daten in verteilten Systemen zu belassen, und trotzdem den Überblick zu behalten. Mit Hilfe von Dataplex könnten diese verteilten Daten für sämtliche Analyics-Werkzeuge im Unternehmen zugänglich gemacht werden.

Mit „Spark on Google Cloud“ sollen Anwender einen automatisch skalierenden und Server-losen Spark-Service auf Googles Cloud-Datenplattform erhalten. Data Scientists könnten damit Spark über ihre bevorzugten Schnittstellen nutzen, ohne dafür Daten replizieren oder benutzerdefinierte Schnittstellen entwickeln zu müssen. Mit dieser Funktion könnten Entwickler Anwendungen und Daten-Pipelines bauen, die automatisch skaliert werden, verspricht Google. Ein manuelles Tuning und Provisioning der Infrastruktur sei nicht erforderlich.

Ausgebaut hat Google auch das im Mai 2021 vorgestellte „Vertex AI“. Das Werkzeug soll Anwender in die Lage versetzen, auf Basis der Datenpipelines in der Google Cloud standardisierte KI-Pipelines zu entwickeln. Um dies zu vereinfachen, hat Google nun „Vertex AI Workbench“ vorgestellt. Dabei handelt es sich um eine einheitliche Benutzeroberfläche, um ML-Modelle schneller bauen und bereitstellen zu können. Data-Engineering-Funktionen seien nun direkt in die Data-Science-Umgebung integriert, gleiches gelte für Datendienste wie Dataproc, BigQuery, Dataplex und Looker. Modelle ließen sich so fünf Mal schneller erstellen und trainieren als mit herkömmlichen Methoden, stellt Google seinen Kunden in Aussicht.

Auch in Sachen Analytics setzt das Unternehmen auf Partnerschaften. Zur Next wurde eine Kooperation mit Tableau angekündigt. Tableau-Nutzer sollen künftig Daten aus BigQuery analysieren, semantische Modelle von Looker nutzen und Tableau direkt aus Google Sheets starten können.

Google stellt Cybersecurity Action Team auf

Ein weiterer Schwerpunkt auf Googles Next-Konferenz war das Thema Sicherheit. Der Cloud-Anbieter will ein „Cybersecurity Action Team“ aufstellen. Die Mission der Security-Experten: Die Sicherheit und digitale Transformation von Regierungen, kritischen Infrastrukturen, Unternehmen und kleinen Firmen unterstützen. Das soll beispielsweise durch strategische Beratungsdienste passieren.

Außerdem will Google Dienste anbieten, um Compliance-Zertifizierungen für bestimmte industriespezifische Kontroll-Frameworks anzupassen. Blueprints sollen den Anwendern helfen, Googles Cloud-Produkte und -Services in Übereinstimmung mit den jeweiligen gesetzlichen Vorschriften zu nutzen und zu betreiben. Mit Hilfe von Threat-Intelligence- und Incident-Response-Services könnten sich Anwender zudem über die aktuelle Bedrohungslage und die sich laufend weiter entwickelnden Sicherheitslandschaften informieren.

(c) Google Cloud

Darüber hinaus hat Google mit „Work Safer“ ein neues Sicherheitsprogramm für Unternehmen aller Größenordnungen und für Behörden aufgelegt. Diese seien häufig auf ältere Technologien angewiesen und verfügten nicht über das nötige Fachwissen, um die wachsenden Sicherheitsherausforderungen gerade im Zusammenhang mit hybrider Arbeit zu bewältigen, verlautete von Seiten des Anbieters. Mit Work Safer erhielten Kunden Zugang zu Googles Sicherheitslösungen für E-Mails, Meetings, Nachrichten und Dokumente. Neben den Cloud-basierten Zero-Trust-Lösungen von Google Workspace könnten die Kunden auch auf Sicherheitslösungen von Partnern wie CrowdStrike und Palo Alto Networks zugreifen.

„Angesichts der zunehmenden Bedeutung von Exploits in der Software-Lieferkette, Ransomware und anderen Angriffen steht das Thema Cybersicherheit ganz oben auf der Agenda aller Führungskräfte und Vorstände“, sagte Thomas Kurian, CEO von Google Cloud. Um diese Sicherheitsherausforderungen anzugehen, habe man sich zur Gründung des Cybersecurity Action Teams entschlossen. Google wolle Partner für Unternehmens- und Regierungskunden auf ihrem Weg zu mehr Sicherheit zu sein.

Die jüngsten Angriffe wie USAID, Colonial Pipeline und Solarwinds hätten Google zufolge gezeigt, dass sich die Anforderungen an den Schutz vor Bedrohungen stark verändert haben. Im August hat Google angekündigt, in den nächsten fünf Jahren zehn Milliarden Dollar zu investieren, um die Cybersicherheit zu stärken. Damit sollen beispielsweise Zero-Trust-Programme ausgeweitet, Software-Lieferketten abgesichert und die Open-Source-Sicherheit verbessert werden. Auch das Cybersecurity Action Team sei Teil dieser Bemühungen um mehr Sicherheit.

* Martin Bayer ist stellvertretender Chefredakteur der COMPUTERWOCHE.

Be the first to comment