Forscher*innen der FH St. Pölten verknüpfen unser Hören und Sehen für die Analyse von Daten. [...]

Beim Projekt SoniVis entwickeln Forscher*innen der FH St. Pölten einen Rahmen, um auditive und visuelle Datenanalyse zu kombinieren. Damit der Mensch große und komplexe Datenmengen verstehen und interpretieren kann, sollen Inhalte grafisch und auditiv aufbereitet werden. Ein neuer Prototyp SoniScope unterstützt Data Scientists bei ihrer Arbeit.

Das Auswerten von Daten erfordert viele Schritte, die sich nicht vollständig automatisieren lassen. Meist ist dabei die Expertise von Menschen erforderlich. In den Forschungsfeldern der Informationsvisualisierung und der Sonifikation, der „Verklanglichung“, also der Darstellung von Daten in Klängen, werden Datenanalyseaktivitäten unterstützt.

Doch die Datenmengen und -komplexität steigen, sodass beide Ansätze für sich alleine genommen an ihre Grenzen stoßen. Seit 2 Jahren arbeitet das Team von SoniVis, einem Projekt der FH St. Pölten, an audiovisuellen Werkzeugen für die Datenanalyse, die Sehen und Hören miteinander verbinden. Ende Juni wurde der Protoyp eines Analysetools, das SoniScope, präsentiert, der auch als Free & Open Source Software verfügbar ist.

„Die Menge und Komplexität von Daten steigen ständig und wir müssen sie verstehen und analysieren können. Das Projekt SoniVis zielt darauf ab, die Lücke zwischen Sonifikation und Visualisierung zu schließen. Dabei soll die Basis für eine vereinheitlichte Designtheorie einer audio-visuellen Analytics gelegt werden, die den visuellen und den auditiven Kanal miteinander ergänzt.

Dafür vereinigt das Projekt Kompetenzen aus den Feldern der Informationsvisualisierung und Sonifikation“, erklärt Projektleiter Wolfgang Aigner vom Institute for Creative\Media/Technologies an der FH St. Pölten.

Lücke in der Forschung schließen

Obwohl bereits zahlreiche Studien die auditive oder die visuelle Repräsentation von Daten untersuchten, gab es nur wenige Versuche diese beiden Kanäle zu kombinieren.

„Es fehlen Datenanalyseansätze, die beides kombinieren und die gegenseitige Beeinflussung der Kanäle berücksichtigen. Bislang fokussierte sich die Forschung auf den auditiven Kanal und vernachlässigten den visuellen oder umgekehrt. Deshalb gibt es noch keinen etablierten methodischen Ansatz Informationsvisualisierung und Sonifikation in Form einer komplementären Designtheorie zu kombinieren“, betont Wolfgang Aigner.

Interaktive Linse als Prototyp

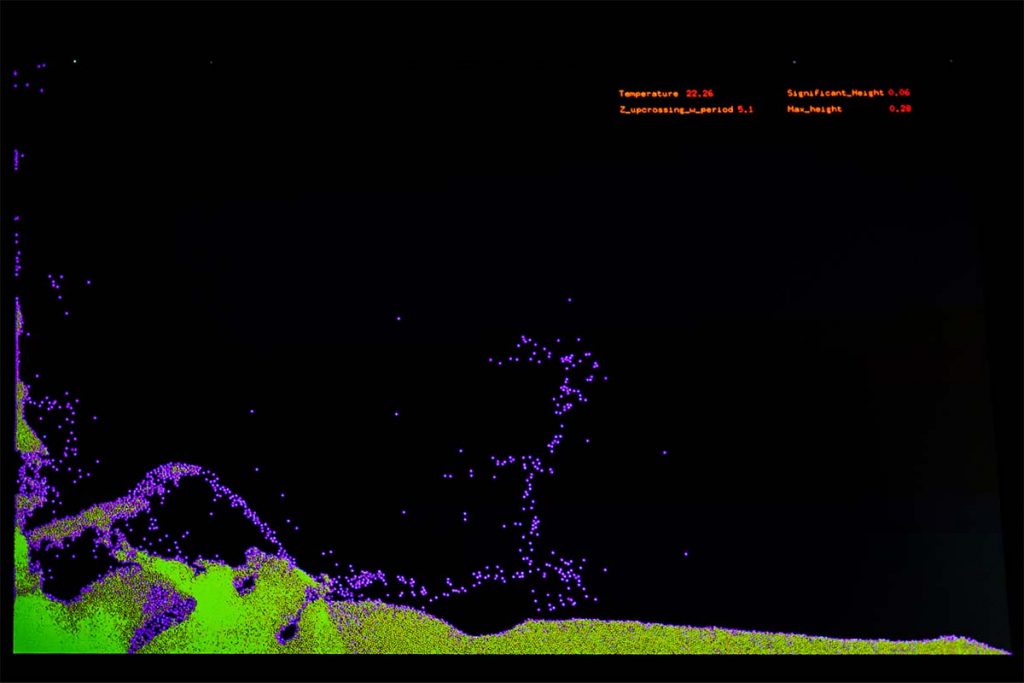

Auf praktisch empirischer Ebene verfolgen die Forscher*innen mit dem SoniScope einen audiovisuellen Ansatz zur Datenanalyse. Das SoniScope verwendet eine interaktive Linse, die so wie ein Stethoskop zum Abhören von sonst verborgenen Variablen der Daten und Mustern verwendet werden kann.

Das Team von SoniVis entwickelte einen Prototyp, der innerhalb eines Jupyter Notebooks – einer Browser-basierten interaktiven Plattform – läuft und so Data Scientists bei der Datenanalyse unterstützt. Dieser Prototyp ist auch als Free & Open Source Software verfügbar. Junior Researcher Kajetan Enge präsentierte den derzeitigen Stand der Konzept- und Prototypenentwicklung Mitte Juni 2022 auf der EuroVis Konferenz in Rom.

International vernetzt

Internationale Vernetzung von Forscher*innen aus Sonifikation und Visualisierung ist ein weiterer Schwerpunkt des SoniVis Projekts. Dazu wurde die Audio-Visual Analytics Community zusammen mit führenden Forscher*innen der Kunst-Universität Graz, der Linköping Universität, des Georgia Institute of Technology und der University of Maryland gegründet.

Im Rahmen dessen wurden bisher drei wissenschaftliche Workshops im Rahmen der AudioMostly Konferenz 2021, der IEEE Visualization Conference 2021 und der Advanced Visual Interfaces 2022 Konferenz abgehalten.

Weitere Informationen rund um das Projekt SoniVis

- Mehr zum Projekt SoniVis – finanziert vom Wissenschaftsfonds FWF – finden Sie auf ihrer Website

- Protoyp SoniScope Software

- SoniScope Publikationsfiles und Video

- Publikation EuroVis Konferenz 2021 in Rom

- Mehr zur Audio-Visual Analytics Community

Be the first to comment