Das 2008 gegründete Technologieunternehmen webLyzard technology bietet eine Big-Data-Plattform zur automatisierten Analyse und Visualisierung digitaler Inhalte. Welche Rolle Sprachtechnologie dabei spielt, verrät Arno Scharl im Gespräch mit der Computerwelt. [...]

Was ist der Tätigkeitsbereich von webLyzard?

Das 2008 gegründete Technologieunternehmen webLyzard technology bietet eine international führende Big-Data-Plattform zur automatisierten Analyse und Visualisierung digitaler Inhalte. Die semantischen Verfahren von webLyzard beruhen auf zwanzigjähriger Forschungs- und Entwicklungsarbeit und liefern wertvolle Indikatoren für die Messung von Kommunikationserfolg sowie die Entscheidungsunterstützung und strategische Positionierung einer Organisation. Bedeutende Referenzkunden in Europa und den Vereinigten Staaten unterstreichen die Leistungsfähigkeit des Systems – unter anderem wurde die webLyzard Plattform bereits für Projekte der Vereinten Nationen und der US-Klimabehörde NOAA eingesetzt. Nähere Informationen dazu findet man auf www.weblyzard.com/showcases.

Wie setzen Sie Sprachtechnologie ein?

Sprachtechnologien werden eingesetzt, um Erkenntnisse aus der öffentlichen Debatte zu erzielen und Entscheidungen zu unterstützen – etwa durch die Analyse der Nachrichtenberichterstattung, sozialer Medien sowie Community-Foren. Die zur Anwendung kommenden Methoden reichen von der Sentiment-Analyse (diese ermittelt, ob Themen in einem positiven oder negativen Licht dargestellt werden) und Bestimmung menschlicher Emotionen bis hin zur geografischen Verortung oder der Vorhersage künftiger Themen. Solche Analysen liefern wichtige Kennzahlen und leistungsfähige Werkzeuge, um die Wirkung von Öffentlichkeitsarbeit und Marketingmaßnahmen zu beurteilen. Zu diesen Werkzeugen zählen beispielsweise die WYSDOM-Metrik zur Messung von Kommunikationserfolg sowie das Brand Reputation Radar. Besondere Bedeutung kommt auch der integrierten Analyse virtueller und physischer Kennzahlen zu – darunter fallen Mobilitätsverhalten, Verkaufszahlen, Satellitendaten und so weiter.

Ist die verwendete Technologie eine Eigenentwicklung beziehungsweise welche Sprachtechnologie verwenden Sie?

Für Standardprozesse wie Spracherkennung, Wortsegmentierung oder Part-of-Speech-Annotation nutzen wir allgemein verfügbare Werkzeuge, etwa jene der Stanford NLP-Gruppe. Die gesamte darüber hinausgehende Verarbeitungskette wurde allerdings in-house entwickelt. Dies umfasst die Berechnung syntaktischer Informationen und Integration der Daten, die Wissensextraktion (Fakten, Emotionen) und Anreicherung der erfassten Inhalte mit den generierten Metadaten (Entitäten, Referenzen, Emotionen) sowie die interaktive Visualisierung dieser Metadaten. Wir setzen dabei sowohl auf lexikalische Verfahren als auch auf maschinelles Lernen in Kombination mit statistischen Sprachmodellen und Wissensgraphen.

Wie verlässlich ist die Technik?

Die Qualität der Wissensextraktionsverfahren gehört zu unseren Alleinstellungsmerkmalen und hat zum Erfolg bei Aufträgen großer internationaler Organisationen beigetragen. Dank langjähriger Erfahrung und kontinuierlicher Verbesserung sowohl der Algorithmen als auch der zugrundeliegenden lexikalischen Ressourcen konnten Precision und Recall kontinuierlich gesteigert werden. Die Evaluation dieser Indikatoren erfolgte im Rahmen konkreter Analysen – etwa die öffentliche Debatte rund um die HBO-Serie Game of Thrones (Anm. Scharl et al., 2016) oder User-Bewertungen auf Amazon, TripAdvisor und IMDB (Anm. Weichselbraun et al., 2014).

In den letzten Jahren sind die Fortschritte insbesondere auf eine Verknüpfung lexikalischer Verfahren mit Deep-Learning-Methoden zurückzuführen. Da sich der Sprachgebrauch ständig wandelt, ist es wichtig im Sinne einer laufenden Optimierung der Verfahren neue und abgewandelte Bedeutungen und neu im Trend liegende Kontexte von Begriffen mit Hilfe von dynamischen Sprachmodellen zu erkennen und in die Analyse miteinzubeziehen.

Wohin geht die Reise – sowohl im Bereich Technik als auch im Bereich Kunden?

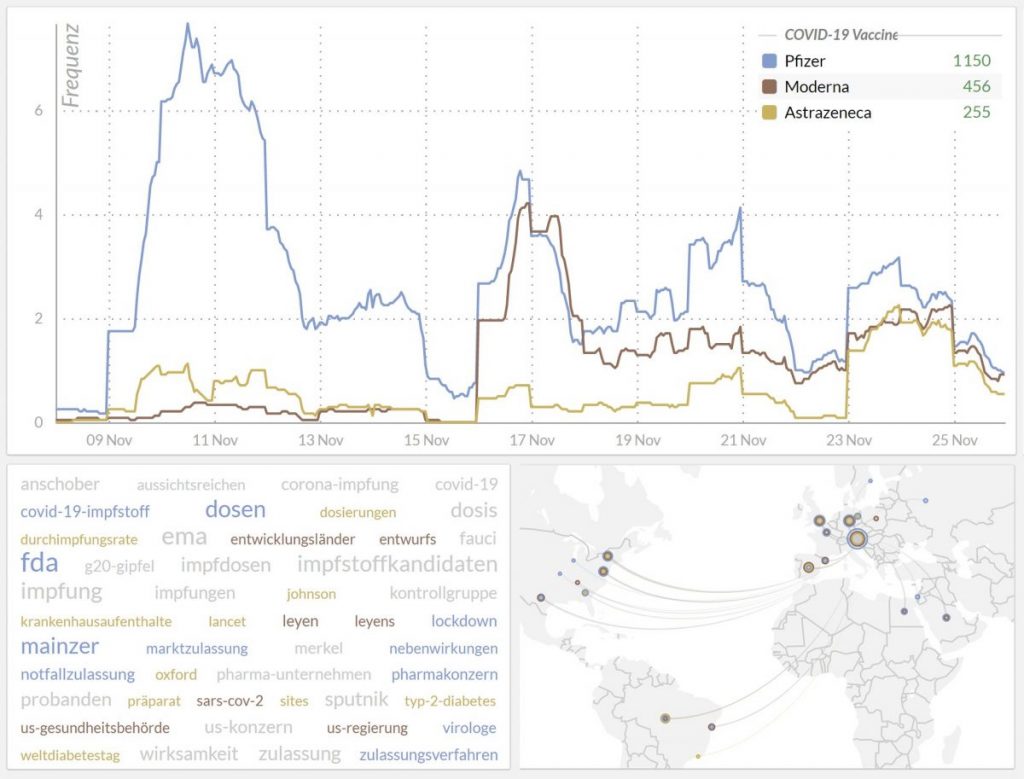

Im Hinblick auf die Multilingualität unserer Sprachtechnologien und die bestehenden Referenzprojekte im Auftrag der Vereinten Nationen und der US-Klimabehörde NOAA wollen wir uns 2021 vermehrt internationalen Märkten widmen und in diesem Zusammenhang auch die regionalen Inhalte der entsprechenden Zielmärkte in unsere Wissensbasis aufnehmen. Öffentlich zugängliche Showcases wie zum Beispiel das Corona-Stimmungsbarometer und der US Election 2020 Web Monitor haben international viel Beachtung gefunden und werden unsere Pläne unterstützen. Auch unsere Zusammenarbeit mit der Kommunikationsagentur Ketchum Publico und KPMG Austria im Rahmen des FFG-Projekts EPOCH und die dort entwickelten Methoden zur Vorhersage künftiger Schwerpunkte in der öffentlichen Debatte werden im Rahmen dieser Bestrebungen eine wichtige Rolle spielen.

Auch mit unserer neuesten Innovation Storypact beschreiten wir neue Wege. Hierbei handelt es sich um ein Werkzeug zur Optimierung digitaler Inhalte auf Basis semantischer und statistischer Methoden, um mit Postings maximale Aufmerksamkeit zu erzielen beziehungsweise das Suchmaschinen-Ranking von Artikeln zu verbessern. Auch hier gehört die Möglichkeit künftige Themen vorherzusagen zu den wesentlichen Innovationen – nicht nur um das Wording eines Textes zu optimieren, sondern auch um den optimalen Zeitpunkt dessen Verbreitung zu bestimmen.

Welche Neuerungen planen Sie? Welche Trends sehen Sie im Bereich Sprachtechnologie?

Neben einer noch umfangreicheren Nutzung von Technologien der Künstlichen Intelligenz wollen wir insbesondere die semantischen Integration von unstrukturierten (Text, Bild, Video) und strukturierten (Business Intelligence Kennzahlen, Linked Open Data etc.) Datenbeständen noch weiter vorantreiben. In Österreich ist in diesem Zusammenhang beispielsweise das EcoMove-Projekt zu erwähnen, das neue Methoden entwickelt, um Erkenntnisse aus der öffentliche Debatte zu nutzen sowie die Bewegung von Personen in Städten zu planen, zu beobachten und unter Berücksichtigung nachhaltiger Mobilitätskonzepte zu lenken. Auf internationaler Ebene sind wir am von der Europäischen Union mit rund elf Millionen Euro geförderten Big Data-Projekt EVOLVE beteiligt, im Rahmen dessen wir Mobilitätsdaten und Satellitenbilder automatisch kontextualisieren und über ein Dashboard interaktiv zugänglich machen. Aus Sicht der Sprachtechnologien kommt im Zuge dieser semantischen Datenintegrationen der korrekten Disambiguierung der in Online-Dokumenten referenzierten Entitäten (Personen, Organisationen, Ortsbezeichnungen, Events) besondere Bedeutung zu – eine Herausforderung, der wir uns ebenfalls durch eine Kombination lexikalischer Verfahren mit Deep-Learning-Ansätzen stellen.

Während wir die letzten Jahre einen veritablen Boom von Deep-Learning-Verfahren gesehen haben, wird es in Zukunft darauf ankommen, diese Technologie mit lexikalischen, auf explizitem Wissen basierenden Methoden in Beziehung zu setzen und eine gegenseitige Ergänzung zu schaffen. Darüber hinaus wird es zunehmend wichtiger, Sprachmodelle für spezifische Anwendungsfälle und Textsorten zu optimieren und anzupassen. Hier kommt dem Transfer Learning eine zentrale Rolle zu. Hier handelt es sich um Mechanismen, um die mit Hilfe sehr großer Datensätze gewonnenen statistischen Erkenntnisse in die Generierung spezifischer Modelle mit einfließen zu lassen.

Be the first to comment