Open-Source-Hardware ist zu einem der wichtigsten Trends in der Data-Center- und IT-Industrie geworden. [...]

Mittlerweile dürfte kaum mehr jemand am Erfolg von Open-Source-Anwendungen zweifeln. Freie Software wie Linux, OpenStack oder Docker ist heutzutage in so gut wie allen Unternehmen anzutreffen. Dabei geht es nicht mehr um den Preis. Der spielt schon lange keine zentrale Rolle mehr. In der kürzlich von Red Hat durchgeführten Studie „The 2021 State of Enterprise Open Source“ gab ein großer Teil der Befragten an, Open-Source-Software nicht mehr nur als „günstiger“ oder „gut genug“ einzuschätzen, sondern als „tatsächlich besser“. 87 Prozent halten die freien Alternativen zudem für sicherer als ihre proprietäre Konkurrenz.

OCP = Open Source + Hardware

Das Open Compute Project (OCP) will an diese Erfolge anknüpfen und das Konzept der Open-Source-Bewegung auf Hardware und Rechenzentren ausweiten. Die Organisation wurde vor etwa zehn Jahren auf Bestreben von Facebook gegründet. Bereits zwei Jahre zuvor hatte das soziale Netzwerk eine interne Initiative unter dem Code-Namen „Project Freedom“ gestartet. Das wichtigste Ziel dabei war, mehr Einfluss auf zentrale Rechenzentrumsaspekte zu erhalten.

Außerdem ging es um eine Senkung des enormen Strombedarfs, den moderne Rechenzentren aufweisen, aber auch um das Problem, dass viele Server über Funktionen verfügen, die Facebook nicht haben wollte oder nicht benötigte. Gleichzeitig fehlten andere Eigenschaften, die das Unternehmen als essenziell betrachtete.

Facebook ging es also nicht direkt um eine Förderung des Open-Source-Gedankens, sondern es gab immer auch vor allem finanzielle Motive. Open Source bietet nicht nur mehr Freiheit, sondern auch mehr Kontrolle über die eingesetzte Hardware. Anders als bei Closed-Source-Lösungen lassen sich in einem offenen Prozess entstandene Produkte individuell anpassen. Zwei Jahre lang entwickelte daher ein kleines Team von Facebook-Ingenieuren Konzepte und Lösungen für ein effizienteres, günstigeres und zugleich deutlich skalierbareres Data-Center, das auf standardisierten Modulen basiert.

Der erste Prototyp wurde in Prineville in Oregon errichtet. Die Ingenieure testeten dort neue Software, Server, Racks sowie Energieversorgungs- und Kühlsysteme. Nach Angaben von Facebook war das selbst entwickelte Rechenzentrum bereits nach kurzer Zeit beim Stromverbrauch um 38 Prozent effizienter und insgesamt um 24 Prozent günstiger als vergleichbare Infrastrukturen. Facebook wollte das Projekt aber auf Dauer nicht allein stemmen. So wurden Partner mit an Bord geholt; offiziell gegründet wurde das Open Compute Project (OCP) 2011. Es richtet sich vor allem an Betreiber großer, hochskalierbarer Rechenzentren.

Im Unterschied dazu hat die Open19 Foundation auch kleinere Rechenzentren im Fokus. Sie wurde vom Business-Netzwerk Linkedin zusammen mit Hewlett-Packard Enterprise und dem Netzwerk- und Edge-Spezialisten VaporIO gegründet.

Schlagkräftige Truppe

Zu den ersten OCP-Unterstützern gehörten der Prozessorhersteller Intel, der Cloud- und Hosting-Anbieter Rackspace, das Finanzunternehmen Goldman Sachs und der bekannte Investor Andreas von Bechtolsheim. Der gebürtige Oberbayer hatte sich 1982 an der Gründung des Server-Herstellers Sun Microsystems beteiligt, stieg 1998 als einer der ersten Investoren bei Google ein und verfügte 2018 laut Forbes über ein Privatvermögen von mehr als 6,6 Milliarden Dollar. Bechtolsheim gehört auch heute noch zum OCP-Vorstand, der vom Vorsitzenden Mark Roenigk geleitet wird.

Während Roenigk von Facebook in das Komitee entsandt wurde, kommen Jim Hawkins von Rackspace, Zaid Kahn von Microsoft, Partha Ranganathan von Google und Rebecca Weekly von Intel. Komplettiert wird das Team durch Rocky Bullock, der lange bei Dell arbeitete und sich als CEO und CFO um das OCP-Tagesgeschäft kümmert.

Neben den Gründungsunternehmen zählen mittlerweile knapp über 40 weltweit bekannte Hersteller wie Asus, Arm, HPE, Nokia, Nvidia, Rittal, Samsung, Seagate und Cisco Systems sowie internationale TK-Konzerne wie AT&T und die Deutsche Telekom zu den OCP-Mitgliedern. Sie haben sich zum Ziel gesetzt, Architekturen für Server und Rechenzentren im Open-Source-Modus zu entwickeln und zu verbreiten. Damit tragen sie auch dem Trend Rechnung, dass die meisten Cloud-Firmen keine Server „von der Stange“ mehr kaufen wollen. Google war mit solchen Lösungen bekannt geworden. Diese Zeiten sind aber weitgehend vorbei. Das zeigt sich unter anderem darin, dass die Zahl der verkauften klassischen Server nicht mit dem Wachstum der Cloud-Umgebungen mithalten kann.

CP in der Praxis

Das Open Compute Project konnte sich in den vergangenen Jahren als Plattform zum Austausch von Gedanken und Ideen zwischen Herstellern und Kunden etablieren. Es wird genutzt, um Standards und Best Practices zu entwickeln, von denen die gesamte Server- und Rechenzentrumsindustrie profitieren soll. Es dauerte aber eine Weile, bis es so weit war und konkrete Produkte auf den Markt kamen. Inzwischen hat die Nachfrage stark zugenommen.

Offene Standards auf Basis von interoperabler Hardware sollen zudem einen Vendor-Lock-in verhindern. Die entwickelten Lösungen eignen sich zum Aufbau in sich homogener, skalierbarer und zugleich energieeffizienter Rechenzentren. Interessierte Hersteller und Kunden können Konstruktionsdaten herunterladen und für den Bau oder die Anpassung individueller Produkte verwenden. Ebenso wie bei Open-Source-Software dürfen die Daten verändert und etwa um neue Funktionen erweitert werden.

Voraussetzung ist allerdings, dass sie anschließend wieder mit der Community geteilt werden. Genau dieses Prinzip hat mit zum Erfolg der Open-Source-Bewegung beigetragen. Ihre Produkte sind damit weit flexibler als herkömmliche Lösungen, die sich nur in Maßen an die individuellen Bedürfnisse eines Kunden anpassen lassen und möglicherweise für eine geplante Aufgabe nicht wirklich gut geeignet sind. Bei Open-Source-Produkten ist es genau andersherum. Sie lassen sich individuell gestalten und auf die Anforderungen des Kunden zuschneiden.

Das hat noch einen weiteren Vorteil: Anders als bei klassischen Lösungen müssen keine Komponenten mehr erworben und finanziert werden, die der Kunde überhaupt nicht benötigt. Ein Beispiel dafür sind Grafikchips in Servern, die gar nicht über eine grafische Bedienoberfläche verfügen. Der Verzicht auf solche Elemente verschlankt nicht nur das Management, sondern erhöht auch die Sicherheit und senkt den Energiebedarf. Dazu kommen kleine, aber entscheidende Details wie ein Zugang zu den Servern über die Vorderseite der Racks oder die integrierten Gleichstromschienen zur Stromversorgung, mit denen sich Wandlerverluste reduzieren lassen. Die hohe Standardisierung sorgt zudem dafür, dass das Ersatzteilmanagement, die Wartung und der Service einfacher werden.

Organisatorischer Aufbau

OCP ist in zahlreiche Unterprojekte und Gruppen aufgeteilt. Diese kümmern sich um das Design neuer Server, Storage-Systeme und Racks, in denen die neu entwickelte Hardware untergebracht werden kann. Dazu kommen komplette Designs und Architekturvorgaben für Rechenzentren bis hin zu offenen Switches, die für die Netzwerkverbindungen benötigt werden. Dabei geht es keineswegs nur um Hardware. Auch Software wird von den Teilnehmern entwickelt. Sie dient etwa zum Management der Hardware. Andere Projekte widmen sich der Firmware, die ebenfalls für die Geräte benötigt wird.

Um an der Entwicklung teilzunehmen, können Unternehmen und unter Umständen auch Einzelpersonen Mitglied beim Open Compute Project werden und dann auf die Designs zugreifen, sie herunterladen und für ihre Zwecke verwenden. Darauf basierend können neue Produkte hergestellt werden, die besser an die individuellen Bedürfnisse des Mitglieds angepasst sind. Ergänzungen oder Änderungen werden wieder mit der Community geteilt.

Testzentrum in Amsterdam

2019 wurde vom Frankfurter Rechenzentrumsbetreiber Maincubes in Zusammenarbeit mit dem Data-Center-Ausrüster Rittal und dem OCP-Supplier Circle B das European Open Compute Project Experience Center in Amsterdam eröffnet. Es ist als „OCP Ready“ zertifiziert. Weltweit haben erst eine Handvoll Data-Center diese Auszeichnung erhalten. In Großbritannien steht mit dem KDL1 ein vom lokalen Provider Kao Data aufgebautes Rechenzentrum, das „OCP Ready“ ist. In China befindet sich in Tianjin das vom Betreiber Chayora errichtete TJ1. In Indonesien hat der Provider SpaceDC in Jakarta ein Data-Center eröffnet, das ebenfalls als „OCP Ready“ eingestuft wurde.

Die Anlage in Amsterdam wurde nach Angaben der Partner errichtet, damit „Hosting-Unternehmen, Service-Provider, Konzerne sowie Channel-Partner die Vorteile von OCP-Produkten und -Lösungen selbst erleben“ können. Sie können dort etwa ICT-Lösungen (Information and Communications Technology), SaaS-Angebote (Software as a Service) und andere „Services oder Lösungen auf Basis von OCP entwickeln und testen“.

Das Experience Center ist laut Maincubes mit einer vollständigen Data-Center-Infrastruktur und „einzelner IT-Hardware auf OCP-Basis“ ausgestattet. Darüber hinaus bietet das Unternehmen Vor-Ort-Unterstützung in Form von technischem Wissen und Erfahrung, damit interessierte Firmen das Design und die Integration ihrer eigenen OCP-Lösungen ausführlich testen können. Neben dem Rechenzentrum in Amsterdam ist auch das Frankfurter Data-Center von Maincubes nach Angaben des Providers bereits in der Lage, OCP-Hardware und -Racks zu hosten.

„Das Open Compute Project ist eine Bewegung, die derzeit in der gesamten Rechenzentrumsbranche an Fahrt aufnimmt – und das aus gutem Grund“, erklärt Oliver Menzel, CEO von Maincubes. Es sei wichtiger denn je, dass „datenhungrige Unternehmen und die Rechenzentren, auf die sie setzen, mit höchster Leistung und Effizienz arbeiten“.

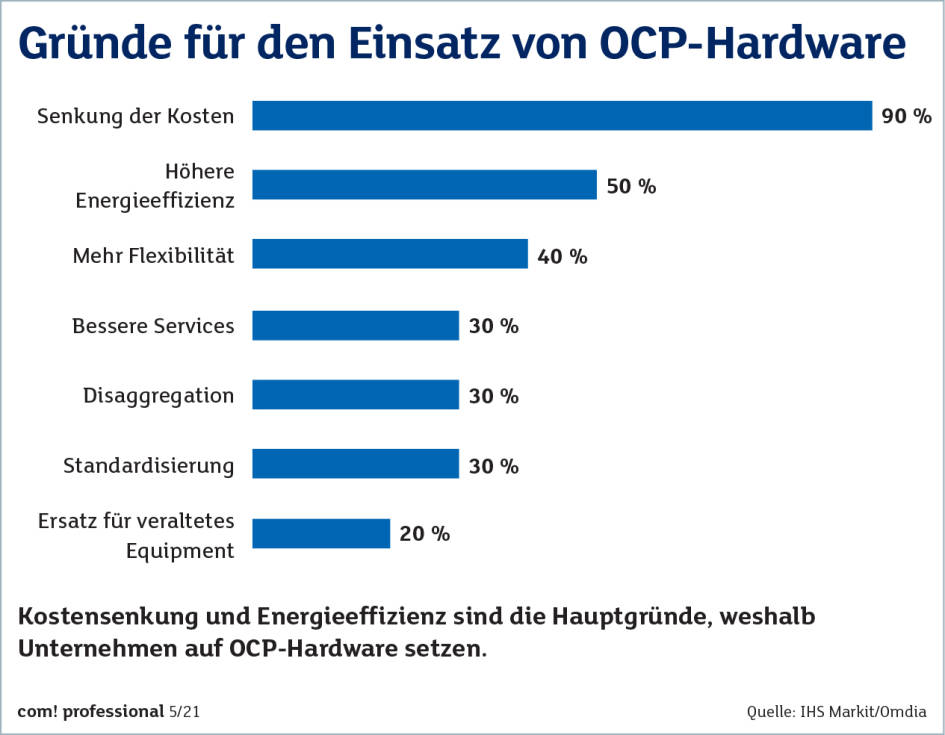

In einer von IHS Markit beziehungsweise Omdia (siehe Kasten) durchgeführten Untersuchung gaben 90 Prozent der Hersteller die Reduzierung der Data-Center-Kosten als wichtigsten Grund für die Nutzung von OCP-Hardware an. 50 Prozent versprechen sich vom Open Compute Project eine höhere Energieeffizienz, 40 Prozent mehr Flexibilität, je 30 Prozent bessere Services, Disaggregation (Server, die aus unterschiedlichen Blades zusammengesteckt werden können) sowie Standardisierung. Jeder fünfte zielt zudem auf den Ersatz von veraltetem Equipment ab.

40 Prozent Wachstum bei OCP-Hardware

Die Marktforschungsgesellschaft Omdia, die 2020 aus den Firmen Ovum, Heavy Reading, IHS Markit sowie Tractica entstanden ist, hat den OCP-Markt in den vergangenen Jahren untersucht. Die Ergebnisse sind durchaus beeindruckend. So ist der Verkauf von OCP-zertifizierter Hardware von 2018 auf 2019 um etwa 40 Prozent auf rund 3,6 Milliarden Dollar gewachsen. Für 2020 liegen noch keine Zahlen vor. Omdia rechnet damit, dass er ein Volumen von 5,3 Milliarden Dollar erreicht hat. Bis 2023 soll der Verkauf sich nochmals auf geschätzte 11,8 Milliarden Dollar im Jahr mehr als verdoppeln.

Die erwartete jährliche Zuwachsrate soll bei etwa 36 Prozent liegen und damit deutlich über den Zuwachsraten bei klassischen Servern. Dieser Bereich legte 2019 im Vergleich zum Vorjahr laut IDC um weltweit 7,5 Prozent auf 24,5 Milliarden Dollar zu. Das zeigt auch, dass die Zahlen für den OCP-Markt zwar imposant sind, dieser Bereich im Vergleich zum gesamten Server-Markt momentan aber noch relativ klein ist. Das könnte sich innerhalb der nächsten Jahre dramatisch ändern. Die Corona-Pandemie hat allerdings dafür gesorgt, dass viele Prognosen nicht mehr zutreffen und angepasst werden müssen.

Fazit & Ausblick

Das hinter OCP stehende Konzept ist durchaus überzeugend. Außerdem bringt es Hersteller und Kunden wieder an einen Tisch. Trotzdem konnte es sich bis heute noch nicht wirklich durchsetzen. Das zeigen die relativ wenigen OCP-Ready-Rechenzentren, die es bislang weltweit gibt. Es mangelt derzeit noch an konkreten Produkten, die interessierte Firmen einsetzen können. Die dahinterstehenden Ideen sind aber gut und in der Lage, die Betriebskosten im Rechenzentrum zu verringern und gleichzeitig die Skalierbarkeit durch den Einsatz von Standardmodulen zu erhöhen. Die aktuellen Wachstumsraten im zweistelligen Bereich bei OCP-Hardware zeigen zudem, dass es nur noch eine Frage der Zeit ist, bis „offene Hardware“ eine größere Rolle spielen wird.

*Andreas Th. Fischer ist freier Journalist im Münchner Süden. Er verfügt über langjährige Erfahrung als Redakteur in verschiedenen IT-Fachmedien, darunter NetworkWorld Germany, com! professional und ChannelPartner.

Seine fachlichen Schwerpunkte liegen in den Bereichen IT-Security, Netzwerke und Virtualisierung.

Be the first to comment