Die generative KI hält zunehmend Einzug in die verschiedensten geschäftlichen Bereiche. Auch in der Produktion verspricht sie viele Vorteile. Unternehmen können damit die Effizienz und Qualität der Fertigung entscheidend verbessern – verbunden mit einer deutlichen Entlastung der Maschinen-Operatoren. [...]

KI ist in der Fertigungsindustrie kein neues Thema, wie das Beispiel Predictive AI zeigt. Allerdings beschränkt sich der Einsatz von KI bisher oft nur auf die Maschinenebene. Der Zustand einer gesamten Produktionslinie oder die Kommunikation zwischen verschiedenen Systemen bleiben dabei außen vor. Mit den Fortschritten der generativen KI wird hier aber ein Wandel einsetzen, der eine effizientere industrielle Fertigung maßgeblich vorantreiben wird. Das Potenzial der generativen KI zeigt sich gerade in der Mensch-Maschine-Interaktion. Dabei geht es nicht darum, den Maschinen-Operator zu ersetzen. Vielmehr soll er bei technischen Herausforderungen durch KI-generierte Hinweise unterstützt werden, um die Produktivität insgesamt zu erhöhen.

Wichtig bei der KI-Nutzung im Fertigungsbereich ist, dass nicht ausschließlich auf LLMs (Large Language Models) gesetzt wird. Diese Modelle sind mit sehr großen Datenmengen trainiert, das heißt, alle Informationen stecken in den Modellen und ihr Wissen ist immer die Basis für die Antworten. In der Regel sind somit keine aktuellen Daten vorhanden. Für die Echtzeitnutzung in der Produktion ist das folglich nicht ausreichend.

Es geht also darum, dass nicht nur das LLM als Wissensquelle genutzt wird, sondern auch weitere Dokumente, Online-Web-Suchergebnisse und dann vor allem auch unternehmensspezifische Echtzeit- und Maschinendaten wie zum Beispiel Logdaten oder Fehlermeldungen. Für die Datenspeicherung dienen dabei Vektordatenbanken. Aus den Daten generiert das LLM dann eine Antwort, die dem Maschinen-Operator hilft, Probleme zu lösen. Konkret wird dabei der Prompt des Users, das heißt des Maschinen-Operators, im Hintergrund mit den oben genannten Daten angereichert, sodass das LLM eine möglichst exakte Antwort gibt. Inzwischen gibt es bereits mehrere Ansätze und Techniken, die die LLMs mit weiteren Informationen anreichern.

Bekannte Beispiele dafür sind RAG (Retrieval-Augmented Generation) und Agentic AI. RAG bietet die Möglichkeit, die in einem LLM vorhandenen Daten durch externe Wissensquellen zu ergänzen, etwa durch Daten-Repositories oder bestehende Dokumentation. So kann auch wesentlich einfacher sichergestellt werden, dass die Modelle richtige, sichere Antworten liefern, ohne zu halluzinieren. Mit AI Agents können Probleme unter Nutzung von Daten aus einem LLM, einer Vektordatenbank, einer Knowledge Base oder aus dem Internet analysiert werden, um Schlussfolgerungen zu ziehen und Entscheidungen zu treffen, die dann als Informationen für einen Operator oder die eigenständige Veranlassung von Veränderungen dienen.

Kleine Modelle liegen im Trend

Bei der Auswahl des richtigen Modells stehen Fertigungsunternehmen vor einer ersten Herausforderung. Hier zeichnet sich ab, dass immer mehr Firmen nicht auf LLMs, sondern auf kleinere Modelle setzen, die für spezielle Use Cases trainiert werden. Sie sind kosteneffizienter und mit geringerem Aufwand zu realisieren. Doch wie sollten Unternehmen nun eine Implementierung in Angriff nehmen – mit dem Ziel, KI nicht nur auf Maschinenbasis, sondern im Kontext einer gesamten Produktionslinie einzusetzen? Eine zentrale Voraussetzung ist die Verfügbarkeit der Daten. Im Großen und Ganzen sind sie vielfach schon vorhanden, etwa in Datenbanken oder Data Lakes. Eine Datenquelle bieten darüber hinaus die in der Fertigungsindustrie oft genutzten Digital Twins. Ist die Datenverfügbarkeit gegeben, geht es in einem nächsten Schritt um die semantische Verknüpfung der Daten und den Verbindungsaufbau zwischen den Maschinen. Hierfür eignet sich etwa eine Graphdatenbank.

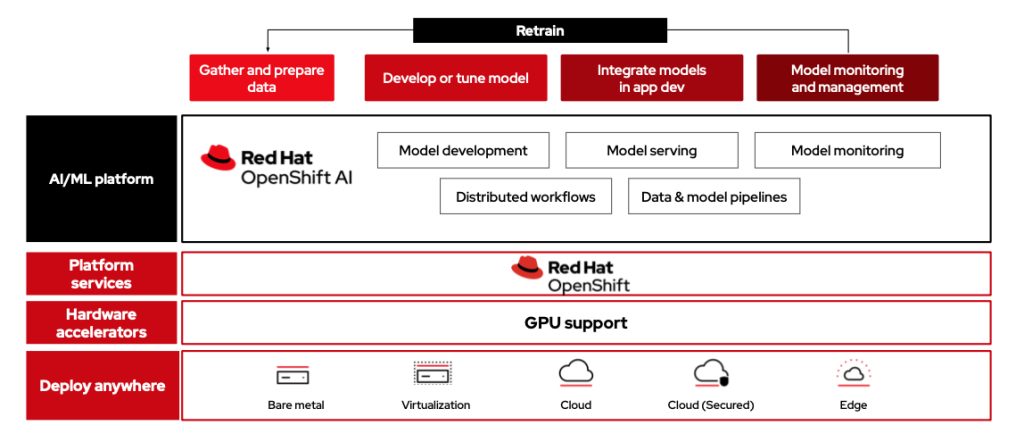

Wichtig für die KI-Nutzung ist zudem eine geeignete Infrastruktur, die die Einführung von der Entwicklung bis zum Produktivbetrieb vereinfachen und beschleunigen kann. Eine solche Infrastruktur stellt eine offene Container-basierte Hybrid-Cloud-Plattform bereit. Sie bietet zum einen eine konsistente Basis für die KI-Modell-Entwicklung, das KI-Modell-Training und auch die KI-Modell-Einbettung in Anwendungen. Zum anderen ist sie flexibel in einer Private-, Public- oder Edge-Umgebung nutzbar.

Mehr Sicherheit durch On-Premises- und Open-Source-Nutzung

Bei der KI-Nutzung stellt sich dann immer die Frage: Public Cloud oder On-Premises? In der Industrie gehen dabei derzeit viele Unternehmen den On-Premises-Weg. Dafür gibt es mehrere Gründe: Bei Public-Cloud-Services werden kontinuierlich neue Versionen ausgerollt, die beim industriellen Einsatz ein Problem darstellen können, da sich dann unter Umständen ein Gesamtsystem anders verhält. Bei der On-Premises-Nutzung eines Modells, das selbst versioniert und getestet wird, kann hingegen bei einer neuen Version relativ schnell und einfach der eigene Qualitätssicherungsprozess angewendet werden. Ein Self-Hosting unterstützt zudem bei der Erfüllung von Latenzanforderungen. Schließlich geht es gerade im Manufacturing um den Edge-Bereich, in dem KI-Algorithmen an der Datenquelle ausgeführt werden sollten. Um Fertigungsprozesse effizient zu optimieren, müssen umfangreiche Datenmengen schnell analysiert werden, und zwar direkt an der Produktionslinie durch die Vernetzung der IT mit den Anlagen oder Steuersystemen. Aufgrund der Herausforderungen in puncto Antwortzeiten ist es hier nicht immer möglich, in die Public Cloud zu gehen.

Nicht zuletzt zeichnet sich wie generell in der IT auch im KI-Bereich ein Open-Source-Trend ab. Open-Source-LLMs sind derzeit ein viel diskutiertes Thema, da viele Unternehmen nachvollziehen wollen, was in den Parametern von LLMs enthalten ist und mit welchen Daten sie trainiert wurden. Mit Open Source ist das möglich.

Für die Fertigungsindustrie ist KI kein Neuland. Predictive Maintenance oder Visual Inspection sind vielfach Standard. Mit der generativen KI kann aber eine neue Ära starten. Wichtig ist dabei – über den klassischen LLM-Einsatz hinausgehend – die Nutzung zusätzlicher Datenquellen. RAG und Agentic AI sind dabei zwei Möglichkeiten. Derzeit werden allerdings viele weitere Konzepte und Frameworks konzipiert und evaluiert. Welche Ansätze sich letztlich durchsetzen werden, ist noch offen. Aber eines ist klar: Der Weg ist vorgezeichnet und die generative KI wird die Fertigungseffizienz auf ein neues Niveau heben, indem die Maschinen-Operatoren in ihrer Arbeit entscheidend unterstützt werden, sodass etwa Ausfallzeiten nicht entstehen oder zumindest minimiert werden. Insgesamt werden so die Unternehmen eine höhere Qualität mit weniger Aufwand erzielen.

Dabei muss sich der Einsatz von KI in einem Industrieunternehmen keineswegs auf die reinen Fertigungsprozesse beschränken. Auch die Resilienz der Lieferketten kann beispielsweise verbessert werden, indem etwa durch Lieferantenanalysen und die Nutzung von AI Agents eine schnelle Umstellung von Lieferketten möglich wird. Das potenzielle Einsatzspektrum der generativen KI ist weitreichend – und deshalb wird sie ein entscheidender Treiber der weiteren industriellen Transformation sein.

*Der Autor Stefan Bergstein ist Chief Architect Manufacturing bei Red Hat.

Be the first to comment