Im Mai 2024 hat das Sysdig Threat Research Team (TRT) LLMjacking-Angriffe entdeckt. Doch nicht nur die großen Sprachmodelle (LLMs) entwickeln sich weiter, auch die Angreifer ruhen sich nicht aus. [...]

Wie das Sysdig Threat Research Team (TRT) bereits im September berichtetn, nimmt die Häufigkeit und Popularität von LLMjacking-Angriffen zu. Angesichts dieses Trends überrascht es die Experten nicht, dass DeepSeek innerhalb weniger Tage nach seiner Medienpräsenz und dem darauffolgenden Anstieg der Nutzung ins Visier genommen wurde. LLMjacking-Angriffe haben auch in der Öffentlichkeit große Aufmerksamkeit erregt, unter anderem durch eine Klage von Microsoft gegen Cyberkriminelle, die Anmeldeinformationen gestohlen und diese für den Missbrauch ihrer generativen KI-Dienste (GenAI) verwendet hatten. In der Klage wurde behauptet, dass die Beklagten DALL-E verwendet hätten, um anstößige Inhalte zu generieren. Im LLMjacking-September-Update von Sysdig TRT wurden Beispiele genannt, wie Angreifer Bilder auf harmlose Weise generieren.

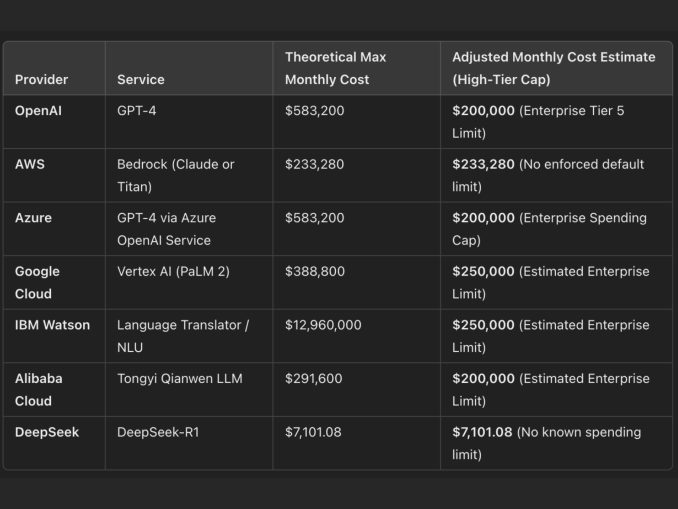

Die Kosten für die Cloud-Nutzung von LLMs können enorm sein und mehrere hunderttausend Dollar pro Monat übersteigen. Sysdig TRT fand mehr als ein Dutzend Proxyserver, die gestohlene Anmeldedaten für viele verschiedene Dienste verwendeten, darunter OpenAI, AWS und Azure. Die hohen Kosten von LLMs sind der Grund, warum Cyberkriminelle lieber Anmeldedaten stehlen, als für LLM-Dienste zu bezahlen.

LLMjackers nehmen DeepSeek schnell an

Die Angreifer implementieren die neuesten Modelle rasch nach ihrer Veröffentlichung. Beispielsweise veröffentlichte DeepSeek am 26. Dezember 2024 sein fortgeschrittenes Modell DeepSeek-V3, und einige Tage später war es bereits in einer ORP(oai-reverse-proxy)-Instanz implementiert, die auf HuggingFace gehostet wurde:

Diese Instanz basiert auf einem Fork des ORP, wo sie den Commit mit der Implementierung von DeepSeek hochgeladen haben. Einige Wochen später, am 20. Jänner 2025, veröffentlichte DeepSeek ein Reasoning-Modell namens DeepSeek-R1, und am nächsten Tag implementierte es der Autor dieses Fork-Repositorys.

Es wurde nicht nur Unterstützung für neue Modelle wie DeepSeek implementiert. Sysdig TRT hat festgestellt, dass mehrere ORPs mit DeepSeek-API-Schlüsseln ausgestattet wurden und dass die Benutzer beginnen, diese zu verwenden.

Taktiken, Techniken und Verfahren des LLMjacking

LLMjacking ist nicht mehr nur eine mögliche Modeerscheinung oder ein Trend. Es haben sich Communities gebildet, in denen Tools und Techniken ausgetauscht werden. ORPs werden aufgeteilt und speziell für LLMjacking-Operationen angepasst. Cloud-Zugangsdaten werden vor dem Verkauf auf LLM-Zugriff getestet. LLMjacking-Operationen beginnen, eine einzigartige Reihe von TTPs zu etablieren, von denen wir im Folgenden einige identifiziert haben.

Communities: Es gibt viele aktive Communities, die LLMs für nicht jugendfrei Inhalte nutzen und KI-Charaktere für Rollenspiele erstellen. Diese Nutzer bevorzugen die Kommunikation über 4chan und Discord. Sie teilen den Zugang zu LLMs über ORPs, sowohl private als auch öffentliche. Während 4chan-Threads regelmäßig archiviert werden, sind Zusammenfassungen von Tools und Diensten häufig auf der Website Rentry.co im Pastbin-Stil verfügbar, die eine beliebte Wahl für den Austausch von Links und zugehörigen Zugangsinformationen ist. Auf Rentry gehostete Websites können Markdown verwenden, benutzerdefinierte URLs bereitstellen und nach der Veröffentlichung bearbeitet werden.

Bei der Untersuchung von LLMjacking-Angriffen in den Cloud-Honeypot-Umgebungen von Sysdig TRT entdeckten die Experten mehrere TryCloudflare-Domains in den LLM-Eingabeaufforderungsprotokollen, bei denen der Angreifer den LLM zur Generierung eines Python-Skripts verwendete, das mit ORPs interagierte. Dies führte zu einer Rückverfolgung zu Servern, die TryCloudFlare-Tunnel verwendeten.

Diebstahl von Anmeldedaten: Angreifer stehlen Anmeldedaten über Schwachstellen in Diensten wie Laravel und verwenden dann die folgenden Skripte als Überprüfungswerkzeuge, um festzustellen, ob die Anmeldedaten für den Zugriff auf ML-Dienste geeignet sind. Sobald Zugriff auf ein System erlangt und Anmeldedaten gefunden wurden, führen Angreifer ihre Überprüfungsskripte auf den gesammelten Daten aus. Eine weitere beliebte Quelle für Anmeldedaten sind Softwarepakete in öffentlichen Repositories, die diese Daten preisgeben können.

Alle Skripte haben einige gemeinsame Eigenschaften: Gleichzeitigkeit, um bei einer großen Anzahl von (gestohlenen) Schlüsseln effizienter zu sein, und Automatisierung.

Best Practices zur Erkennung und Bekämpfung von LLMjacking

LLMjacking wird hauptsächlich durch die Kompromittierung von Anmeldeinformationen oder Zugangsschlüsseln durchgeführt. LLMjacking ist so weit verbreitet, dass MITRE LLMjacking in sein Attack-Framework aufgenommen hat, um das Bewusstsein für diese Bedrohung zu schärfen und Verteidigern dabei zu helfen, diesen Angriff zu erfassen.

Die Verteidigung gegen die Kompromittierung von KI-Dienstkonten umfasst in erster Linie die Sicherung von Zugangsschlüsseln, die Implementierung eines starken Identitätsmanagements, die Überwachung auf Bedrohungen und die Gewährleistung eines Zugangs mit den geringsten Privilegien. Im Folgenden sind einige bewährte Verfahren zum Schutz vor der Kompromittierung von Konten aufgeführt:

Zugangsschlüssel sichern: Zugangsschlüssel sind ein wichtiger Angriffsvektor und sollten daher sorgfältig verwaltet werden.Nachfolgend Tipps des Sysdig TRT.

- Vermeiden Sie die feste Kodierung von Anmeldeinformationen: Betten Sie API-Schlüssel, Zugriffsschlüssel oder Anmeldedaten nicht in Quellcode, Konfigurationsdateien oder öffentliche Repositories (z.B. GitHub, Bitbucket) ein. Verwenden Sie stattdessen Umgebungsvariablen oder Tools zur Verwaltung von Secrets wie AWS Secrets Manager, Azure Key Vault oder HashiCorp Vault.

- Temporäre Anmeldedaten verwenden: Verwenden Sie temporäre Sicherheitsanmeldeinformationen anstelle von dauerhaften Zugriffsschlüsseln. Zum Beispiel AWS STS AssumeRole, Azure Managed Identities und Google Cloud IAM Workload Identity.

- Rotieren Sie AccessKeys: Wechseln Sie Zugriffsschlüssel regelmäßig, um die Anfälligkeit zu reduzieren. Automatisieren Sie den Rotationsprozess, wo immer dies möglich ist.

- Überwachen Sie exponierte Anmeldedaten: Verwenden Sie automatisierte Scans, um ungeschützte Anmeldedaten zu identifizieren. Beispiele für Tools sind AWS IAM Access Analyzer, GitHub Secret Scanning und TruffleHog.

- Überwachen Sie das Verhalten von Konten: Wenn ein Kontoschlüssel kompromittiert wird, weicht er in der Regel vom normalen Verhalten ab und beginnt, verdächtige Aktionen auszuführen. Überwachen Sie Ihre Cloud- und KI-Dienstekonten kontinuierlich mit Tools wie Sysdig Secure.

Fazit

Da die Nachfrage nach Zugang zu fortgeschrittenen LLMs gestiegen ist, sind LLMjacking-Angriffe immer beliebter geworden. Aufgrund der hohen Kosten hat sich ein Schwarzmarkt für den Zugang zu OAI Reverse Proxies entwickelt, und es sind Untergrund-Dienstleister entstanden, um die Bedürfnisse der Verbraucher zu befriedigen. LLMjacking-Proxy-Betreiber haben den Zugang zu Anmeldedaten erweitert, ihre Angebote angepasst und begonnen, neue Modelle wie DeepSeek zu integrieren.

Inzwischen sind legitime Nutzer zu einem Hauptziel geworden. Da die unbefugte Nutzung von Konten zu Verlusten in Höhe von Hunderttausenden von Dollar für die Opfer führt, ist die ordnungsgemäße Verwaltung dieser Konten und der damit verbundenen API-Schlüssel von entscheidender Bedeutung geworden.

LLMjacking-Angriffe entwickeln sich weiter, ebenso wie die Motive, die sie antreiben. Letztendlich werden Angreifer weiterhin versuchen, Zugang zu LLMs zu erhalten und neue böswillige Verwendungen für sie zu finden. Es liegt an den Benutzern und Organisationen, sich darauf vorzubereiten, sie zu erkennen und sich gegen sie zu verteidigen.

Be the first to comment