Maschinelles Lernen (ML) gilt als Schlüsseltechnologie der künstlichen Intelligenz (KI) und hält Einzug in eine immer größer werdende Zahl von Systemen und Anwendungen. Dank Maschinellen Lernens können Fotos und Videos auf völlig neue Weise analysiert, interpretiert und gestaltet werden. [...]

Am Hasso-Plattner-Institut (HPI) in Potsdam forscht ein Team von Wissenschaftlern am Fachgebiet Computergrafische Systeme unter der Leitung von Jürgen Döllner im Bereich „Visual Media Analytics“ an solchen ML-Verfahren. Mit ihnen ermöglichen sie beispielsweise die schnelle und interaktive Übertragung verschiedener Kunststile – auch bekannt als „Style Transfer“ – auf Fotos und Videos.

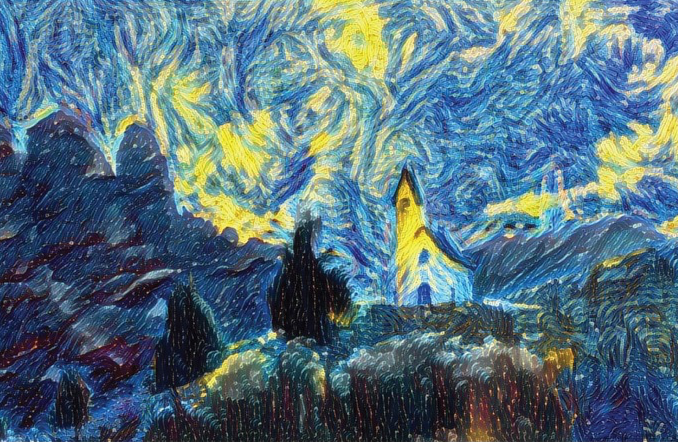

Beim Style Transfer wird ein neuronales Netzwerk mit einer Vielzahl an Gemälden und Kunstwerken trainiert, um Muster und Merkmale verschiedener Künstler zu erlernen. Dafür werden die Bilddaten auf mehreren Abstraktionsstufen, von der Objektebene bis ins kleinste Detail, analysiert. Grafische Elemente der erlernten Kunststile werden dann automatisiert und pixelscharf auf das jeweilige Foto übertragen. Die Ergebnisse besitzen grafische Züge der entsprechenden Wissensbasis, d.h. sie bekommen dadurch Züge der Kunstwerke, die als Wissensbasis verwendet wurden.

Ein großer Nachteil dieses Ansatzes war bislang, dass ausschließlich Farben und Strukturen eines künstlerischen Stils erlernt wurden, nicht jedoch weit umfangreichere Designaspekte, die die Komposition eines Kunstwerks berücksichtigen. So wird z. B. der Farbstil des Sternenhimmels in van Gogh’s „The Starry Night“ fälschlicherweise auf Wiesen und Wälder übertragen. Ziel der HPI-Forschung war es den Style Transfer von einem automatischen „Black-Box“-Prozess zu einem interaktiven Werkzeug auf Basis von Visual Media Analytics weiterzuentwickeln.

Künstliche Intelligenz ermöglicht es auch, das Geschehen in einem Video zu analysieren und dann die Dynamik in einem einzelnen Bild zu stilisieren. Wie ein solches neuartiges Abstraktionsverfahren aussehen kann, stellten Max Reimann und Sumit Shekhar 2019 auf der SIGGRAPH – der Aussenderinformationen zufolge weltweit führenden Konferenz und Fachmesse für Computergrafik und interaktive Techniken – in Los Angeles vor. Die App berechnet Bewegungsinformationen zu einem Videoclip und fasst diese in einem abstrahierten „Live-Foto“ zusammen, um Dynamik stilistisch zu visualisieren.

Die Wissenschaftler des HPI-Fachgebiets Computer Graphische Systeme publizieren regelmäßig auf renommierten Konferenzen und Symposien; auf der SIGGRAPH Asia 2017 wurden gleich zwei Arbeiten auf dem „Symposium for Mobile Graphics and Interactive Applications“ ausgezeichnet. Co-Author ist unter anderem Sebastian Pasewaldt, HPI-Doktorand und CEO des Unternehmens Digital Masterpieces (www.digitalmasterpieces.com), das er 2013 mit einem weiteren HPI-Absolventen gründete. Das HPI-Startup entwickelt Kunst– und Fotobearbeitungs-Apps wie BeCasso, Clip2Comic oder ArtCard für iPhone und iPad, die auch für Grafiker, Künstler und Buchillustratoren immer attraktiver werden. „Wir beobachten, dass unsere interaktiven Apps zunehmend auch Künstler und Kreative bei ihrer Arbeit unterstützen“, so Pasewaldt. Ausschlaggebend für den Wandel sei zum einen die enorme Verarbeitungsgeschwindigkeit der umgesetzten Techniken und das vielfältige Angebot unterschiedlicher Kunststile in einer App sowie die exzellente Ausgabequalität und einfache Bedienbarkeit.

Be the first to comment