Die freie Architektur OpenStack ist jetzt über zehn Jahre alt. Sie zählt zu einem der weltweit drei aktivsten Open-Source-Projekte für Cloud Computing. [...]

Vor über zehn Jahren betrat das erste OpenStack-Release die große Bühne der Enterprise-Software-Welt. Seitdem hat sich das Open-Source-Projekt einen festen Stellenwert im Cloud Computing erobert. 1.125 Entwickler aus 165 Organisationen / Unternehmen wirkten im letzten Herbst an der 20. Version der Plattform mit. Laut Analysen von 451 Research bringt es der weltweite OpenStack-Markt mittlerweile auf ein Volumen von 7,7 Milliarden Dollar.

Längst ist OpenStack zu einem Standard für Unternehmen geworden, die Private-Cloud-Infrastrukturen implementieren. Mittlerweile hat die Plattforme ein solche Komplexität erreicht, dass eine Implementierung nicht trivial ist. Unternehmen, die mit OpenStack arbeiten wollen, sollten wissen, welche Herausforderungen auf sie zu kommen. Sehr oft mangelt es an Ressourcen, Wissen und Erfahrung. Hinzu kommen Sicherheitsbedenken und auch so mancher Stolperstein im laufenden Betrieb.

OpenStack richtig implementieren

Was gilt es also bei Einführung und Betrieb von OpenStack zu beachten? Wo liegen die Fallstricke und wie gelingt ein Open-Stack-Projekt? Diese und weitere Fragen klärt unsere FAQ, bei deren Erstellung uns Tytus Kurek, OpenStack Produktmanager von Canonical, dem Distributor von Ubuntu, mit seinem Know-how unterstützte.

1. Startpunkt?

Wenn eine Private-Cloud-Infrastruktur mit OpenStack aufgesetzt werden soll, muss zunächst eine Referenzarchitektur definiert werden. Welche Hardware soll zum Einsatz kommen? Welche Hypervisor- und SDN-Lösung ist die beste Wahl? Wie sieht es mit der Sicherheit aus? Diese Fragen werden in der Designphase geklärt. Die Anforderungen werden gesammelt und auf der Grundlage des Inputs von Analytikern und Architekten in einer Liste der Leistungen, die bereitgestellt werden müssen, zusammengestellt. Am Ende dieser Phase ist klar, was gebaut wird, wann es gebaut wird und zu welchen Kosten.

2. Tools?

In der Regel schließt sich direkt an die Designphase die Bereitstellung an. Vielen Organisationen fehlen aber die Tools, um das Modell in eine reale Umgebung zu überführen. Welche Tools sollten dafür verwendet werden? Was ist bei der Auswahl zu beachten?

In Frage kommen Anwendungsmodellierungs-Tools, die das Modellieren einzelner Faktoren erleichtern. Zu diesen Faktoren gehören die Anzahl der eingesetzten Maschinen und ihre Hardware-Spezifikationen, die eingesetzten Anwendungen und ihre Konfigurationen, die Anzahl der eingesetzten Anwendungseinheiten sowie die Platzierung der Einheiten und die Beziehungen zwischen den Anwendungen.

3. Infrastruktur?

Selbst wenn eine manuelle OpenStack-Bereitstellung und -Konfiguration richtig konzipiert und modelliert ist, ist sie komplex und kann Wochen dauern. Was ist in dieser Phase der Bereitstellung und Konfiguration zu beachten?

Eine Reihe von Tools ermöglichen eine automatisierte OpenStack-Installation in Szenarien mit mehreren Knoten. In jedem anspruchsvolleren Szenario beginnt die Komplexität aber exponentiell zu wachsen und erhöht den Abstraktionsbedarf. Bevor jedoch ein einzelnes Paket installiert werden kann, muss die zugrunde liegende Infrastruktur vorbereitet werden. Da OpenStack in der Regel auf Bare-Metal-Systemen läuft, müssen zunächst physische Hardware und Netzwerkgeräte installiert und konfiguriert werden. Die Übernahme einer Referenzarchitektur kann diesen Prozess beschleunigen. Sobald alle Rechner im Rack stehen und verkabelt sind, kann die gesamte Cloud in weniger als einer Stunde bereitgestellt werden.

4. Skalieren?

Eine erfolgreiche Bereitstellung ist aber nur der erste Schritt zu einer OpenStack Private Cloud. Schon am „Tag 2“ kann sich herausstellen, dass das Pflichtenheft nicht detailliert genug erstellt wurde und der Cluster an seine Grenzen stößt. Wie skaliert OpenStack bei Bedarf?

Der Betrieb von OpenStack ist schwierig, aber glücklicherweise können komplexe Vorgänge vollständig automatisiert werden. Dazu zählt etwa die Skalierung des Clusters, die Verlagerung von Anwendungseinheiten oder die Wiederherstellung von Datenbanken. Dafür sollte eine Technologie, die Funktionen zur Service-Orchestrierung bereitstellt, ausgewählt werden.

5. Support?

Was passiert, wenn eine kritische Sicherheitslücke die Umgebung beeinträchtigt – und die Cloud in wenigen Stunden gepatcht werden muss? Und wie sieht es aus, wenn nicht genügend Mitarbeiter für den Betrieb von OpenStack zur Verfügung stehen?

In diesen Fällen ist es ratsam, externe Experten hinzuzuziehen, die den Betrieb von OpenStack, einschließlich Support und Managed Services, unterstützen. Das Serviceangebot kann kritische Sicherheits-Patches, 24/7-Support und mehr umfassen. Alles mit dem Ziel, eine maximale Betriebszeit und Stabilität zu gewährleisten. Unternehmen können auch den Aufwand und das Risiko, die mit dem Betrieb von OpenStack verbunden sind, vollständig abgeben – etwa an einen Managed-Services-Anbieter. Das Unternehmen kann sich dann voll und ganz auf eine OpenStack-Nutzung unter Berücksichtigung der eigenen Business-Ziele konzentrieren.

OpenStack Wiki hilft weiter

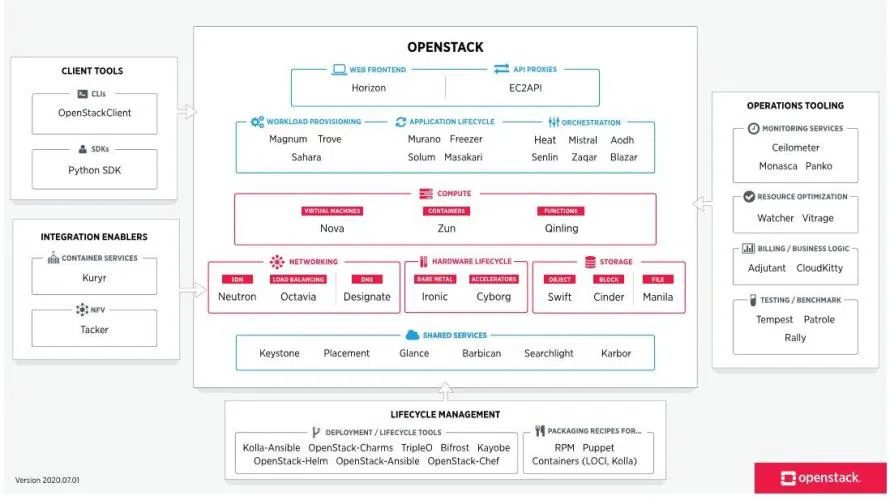

Sicher ist OpenStack komplex, da sich die Plattform aus einer Vielzahl an Komponenten zusammensetzt, welche unter anderem für Punkte wie die Virtualisierung oder die Bereitstellung von Storage zuständig sind. Mit einem gezielten Vorgehen, wie in unserer FAQ beschrieben, können sich Unternehmen die Arbeit mit OpenStack deutlich erleichtern. Eine Anlaufstelle für weitere Informationen ist auch das OpenStack Wiki, das die OpenStack Foundation unterhält.

Be the first to comment