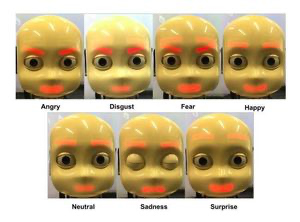

Die offene Forschungsplattform für Kognition iCub hat ein Robotergesicht entworfen, das einem vierjährigen Kind ähnelt und sieben Empfindungen ausdrücken kann: Ärger, Ekel, Furcht, Glück, Trauer, Überraschung und Neutralität. [...]

Forscher um Stefan Wermter von der Universität Hamburg haben die Darstellung der sieben Emotionsstadien mit einer Methode geschafft, die auf maschinellem Lernen beruht. Damit trainierten sie das iCub-Gesicht. Das Ergebnis wurde auf „arXiv“ publiziert.

Mensch-Maschine–Interaktion

Trügen Roboter vermehrt menschliche Züge, könnte die Interaktion zwischen Mensch und Maschine entspannter ablaufen, glauben die iCub-Schöpfer, die ihren Ursprung im Istituto Italiano di Tecnologia in Genua haben. Wenn Roboter Empfindungen ausdrücken können, werden ihre Botschaften eher akzeptiert, so die Grundüberlegung.

Die Hamburger Forschung basiert auf Tamer, einer Basis-Software, die unlängst entwickelt wurde. Es handelt sich um einen Algorithmus, der genutzt werden kann, um mehrschichtige Perceptronen zu trainieren. Das ist eine Art künstliches Gehirn, das aus elektronischen Neuronen besteht, die untereinander vernetzt sind, also ein künstliches neurales Netzwerk bilden.

Langwieriges Training notwendig

Der Roboter kann Emotionen seines menschlichen Gegenübers erkennen und seine eigene Mimik darauf abstimmen. „Unsere Absicht lag darin, den Roboter darauf zu trainieren, adäquat auf die Gefühlslage von Menschen zu reagieren“, so die Experten. Dazu ist ein langwieriges Training nötig. Um Emotionen ihres Gegenüber richtig zu deuten, sind 100 Lernschritte nötig. Dann kann der iCub allerdings nur den Gesichtsausdruck desjenigen deuten, mit dem er geübt hat. „Die Zahl der Trainingseinheiten wird sich in nächster Zeit deutlich verringern“, so die Forscher. Sie wollen die Trainingsmethoden verbessern und mehr Daten sammeln.

Be the first to comment