Charmed Kubeflow ist jetzt im NVIDIA DGX-Ready Software Programm für MLOps zertifiziert. [...]

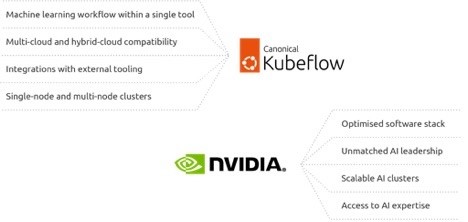

Canonical Kubeflow ist jetzt im Rahmen des NVIDIA DGX-Ready Software Programms zertifiziert. Die Zusammenarbeit zwischen Canonical und NVIDIA zielt darauf ab, den Einsatz von KI-Projekten im großen Maßstab zu beschleunigen und Open-Source auf leistungsfähiger Hardware für KI-Training zugänglich zu machen.

Durch die Zusammenarbeit von Canonical und NVIDIA ist es bereits möglich, KI-Hardware wie NVIDIA DGX AI-Supercomputer oder Mainstream-Server, die auf der NVIDIA EGX Enterprise-Plattform basieren, mit Ubuntu bereitzustellen. Der nächste Schritt kommt jetzt mit der durchgängigen zertifizierte MLOps-Lösung Charmed Kubeflow, die Charmed Kubernetes enthält, um Unternehmen einen robusten und einheitlichen Stack bis zur Anwendungsschicht zu bieten.

Die Teams von Canonical und NVIDIA haben eine Reihe von Tests durchgeführt, sowohl auf Einzelknoten- als auch auf Mehrknoten-DGX-Systemen, um die Funktionalität von Charmed Kubeflow auf MicroK8s und Charmed Kubernetes zu validieren. Mit der Möglichkeit, den gesamten Workflow des maschinellen Lernens auf diesem Stack auszuführen, können Unternehmen schneller experimentieren und ihre KI-Initiativen schneller umsetzen.

KI-Modelle vom Konzept zur Produktion bringen

Laut „The State of AI in 2022“ von McKinsey fließen 5 Prozent des Digitalbudgets von Unternehmen in KI. Dies erhöht die Zahl der Projekte, übt aber auch Druck auf die Teams aus, Projekte in die Produktion zu überführen, um ihren Wert zu beweisen.

Die Anforderungen der Unternehmen verlagern sich von der einfachen Identifizierung von Anwendungsfällen hin zum Betrieb von KI in großem Maßstab. Wichtige Funktionen, die sich sowohl auf die KI/ML-Modelle als auch auf die gesamte Infrastruktur auswirken, sind sehr gefragt, z. B. Rechenleistung, Workflow-Automatisierung und kontinuierliche Überwachung. Diese Funktionen werden von den Canonical-Angeboten, einschließlich Charmed Kubeflow, direkt abgedeckt.

Charmed Kubeflow ist eine quelloffene, durchgängige MLOps-Plattform, die auf Kubernetes läuft. Sie wurde entwickelt, um Workflows für maschinelles Lernen zu automatisieren und eine zuverlässige Anwendungsschicht zu schaffen, auf der Modelle in die Produktion übertragen werden können.

Mit einem Paket, das Tools wie KServe und KNative enthält, werden die ‚Inference- and Serving‘-Funktionen unabhängig vom verwendeten ML-Framework verbessert. Charmed Kubeflow kann mit KI-Tools und Frameworks wie NVIDIA Triton Inference Server für das Model Serving verwendet werden, um den Stack zu erweitern.

NVIDIA DGX Systeme sind speziell für KI-Anwendungsfälle in Unternehmen entwickelt worden. Diese Plattformen verfügen über NVIDIA Tensor Core GPUs, die herkömmliche CPUs bei Machine-Learning-Workloads deutlich übertreffen, sowie über erweiterte Netzwerk- und Speicherfunktionen.

Die NVIDIA DGX Systeme mit rekordverdächtiger Leistung basieren auf optimiertem Ubuntu und bieten das Beste aus beiden Welten: die neuesten Hardware-Updates und eine sichere Infrastruktur zur Ausführung von ML-Workloads.

Darüber hinaus enthalten die DGX Systeme NVIDIA AI Enterprise, die Softwareschicht der NVIDIA AI Plattform, die über 50 Frameworks und vortrainierte Modelle enthält, um die Entwicklung zu beschleunigen.

„Canonical hat eng mit NVIDIA zusammengearbeitet, um Unternehmen die einfache Ausführung von KI im großen Maßstab zu ermöglichen. Gemeinsam erleichtern wir die Entwicklung von optimierten Machine-Learning-Modellen unter Verwendung von KI-spezifischer Infrastruktur mit MLOps Open Source“, sagte Andreea Munteanu, MLOps Product Manager bei Canonical.

„Die Ausweitung dieser Zusammenarbeit auf die anderen Schichten des Stacks, um sowohl andere Arten von Hardware als auch KI-Tools und Frameworks wie NVIDIA Triton Inference Server einzubeziehen, wird es Entwicklern ermöglichen, von einer vollständig integrierten Entwicklungspipeline zu profitieren.“

„NVIDIA DGX Systeme ermöglichen es jedem Unternehmen, auf schlüsselfertiges KI-Supercomputing zuzugreifen, um ihre komplexesten KI-Herausforderungen zu bewältigen“, sagte Tony Paikeday, Senior Director of AI Systems bei NVIDIA.

„DGX-Ready MLOps-Software wie Charmed Kubeflow maximiert sowohl die Nutzung als auch die Effizienz von DGX-Systemen, um die Entwicklung von KI-Modellen zu beschleunigen.“

Effizientere KI-Infrastruktur mit MLOps-Lösungen

Im Jahr 2018 berichtete OpenAI, dass sich die in groß angelegten KI-Trainingsläufen verwendete Rechenleistung seit 2012 alle 3,4 Monate verdoppelt hat. Etwa zur gleichen Zeit stieg auch das generierte Datenvolumen dramatisch an.

Herkömmliche, universell einsetzbare Unternehmensinfrastrukturen können weder die erforderliche Rechenleistung bereitstellen noch die Petabytes an Daten unterstützen, die zum Trainieren präziser KI-Modelle in diesem Umfang erforderlich sind. Stattdessen benötigen Unternehmen spezielle Hardware, die für KI-Workloads ausgelegt ist.

KI-Infrastrukturlösungen wie NVIDIA DGX Systeme beschleunigen den ROI von KI-Initiativen mit einer bewährten Plattform, die für die speziellen Anforderungen von Unternehmen optimiert ist. Unternehmen können ihre DGX-Umgebung mit MLOps-Lösungen kombinieren, um die KI-Entwicklung im großen Maßstab zu operationalisieren.

Führende MLOps-Plattformen wie Charmed Kubeflow von Canonical sind für den Einsatz auf DGX-Systemen getestet und optimiert und stellen sicher, dass Anwender das Beste aus ihrer KI-Infrastruktur herausholen können, ohne sich um die manuelle Integration und Konfiguration ihrer MLOps-Software kümmern zu müssen.

Mehr Informationen über das DGX- Ready Software-Programm.

Umfassende Informationen bietet das gemeinsamen Webinar von NVIDIA und Canonical am 28. März 2023.

Be the first to comment