Die Corona-Pandemie verändert vieles - auch den Bereich Business Intelligence. Daten müssen jetzt besonders schnell gefunden und Prozesse noch transparenter werden. [...]

Datenbasierte Fakten statt Bauchgefühl. Immer mehr Unternehmenslenker verlassen sich bei ihren Entscheidungen nicht mehr nur auf ihre Intuition und Erfahrung, sondern setzen auf belastbare Informationen. Unternehmen sammeln entsprechende Daten aus internen Systemen und externen Quellen, bereiten sie für die Analyse vor und erstellen daraus Berichte und Datenvirtualisierungen, anhand deren möglichst die richtigen Entscheidung getroffen werden sollen.

Der Begriff Business Intelligence (BI) ist dabei in den vergangenen Jahren zu einem beliebten Buzzword für die Datenanlayse in Unternehmen geworden. Was nur wenige wissen: BI ist eigentlich ein alter Hut. Den Begriff benutzte bereits der deutsche IBM-Informatiker Hans Peter Luhn Ende der 1950er-Jahre. Etabliert haben Business Intelligence dann vor allem die Analysten von Gartner in den 90er-Jahren.

Irgendwann kam dann noch das Schlagwort Big Data hinzu, als in einer Welt exponentiellen Datenwachstums neue Anwendungsfelder in der Finanzindustrie, Mobilfunk, Verkehr oder Internet of Things (IoT) neue Architekturen mit sich brachten, um riesige Datenmengen verarbeiten zu können. Der Begriff Big Data sagt jedoch laut Marcus Giehrl, Senior Business Development Manager Germany bei beim IT-Dinstleister NTT, zunächst noch nichts über die Verwendung der Daten aus, „sondern beschreibt nur, dass die Datenmenge zu groß, zu komplex, typischerweise schlecht strukturiert und gegebenenfalls auch zu kurzlebig ist, um mit traditionellen Methoden Mehrwert aus den Daten zu ziehen.“

Business Intelligence steht laut Jörg Schmidt füreinen hingegen für einen gesamtheitlichen Prozess, in welchem ein Unternehmen oder Unternehmensbereich alle verfügbaren Datenquellen systematisch speichert und analytisch aufbereitet, und diese für alle relevanten Geschäftsprozesse in geeigneter Visualisierung zur Verfügung stellt. „Basierend auf einem strukturierten Datenbestand können somit Auswertungen zur Unterstützung unternehmerischer Entscheidungen führen“, wie der Senior Consultant Business Intelligence beim Anylatics-Unternehmen TIQ Solutions zusammenfasst.

(c) Tableau Software

„Heute ist Business Intelligence jedoch schärfer umrissen als noch vor fünf Jahren“, ergänzt Robert Ruf, Customer Advisory Lead bei SAS, einem Anbieter von Analyse-Tools. Für ihn sei BI primär für die Darstellung und Weitergabe von Informationen zuständig, „das ist im Wesentlichen die Visualisierung von Daten, aber auch Reporting.“ Mit BI könnten Anwender die Informationen sehen, nach individuellem Bedarf darstellen und damit optimal für ihre Aufgaben nutzen. Die Analyse und die eigentliche Datenverarbeitung – auch im Big-Data-Kontext – seien heute weitgehend eigene Technologiefelder.

Dr. Boris Michel, Leiter Technischer Vertrieb bei dem Analytics-Unternehmen INFORM DataLab fasst Business Intelligence wie folgt zusammen: „Summa summarum ist Business Intelligence Teil der Wertschöpfungskette im Rahmen von ‚Big Data’-Projekten, nämlich der Teil, der die Schnittstelle zwischen Entscheidern und den Daten herstellt.“

Status quo in Sachen BI

Die Technologien für das Business Intelligence sind bereits seit mehreren Jahrzehnten verfügbar und haben bereits einen hohen Reifegrad erreicht. Die entsprechenden Techniken wie Online Analytical Processing (OLAP), eine hypothesengestützte Analysemethode, werden daher für das BI in ähnlicher Art und Weise von eine Vielzahl an BI-Tools unterstützt.

Das zwingt die Software-Hersteller dazu, sich durch neue Technologien und Möglichkeiten zu differenzieren. Ein Trend ist zum Beispiel der Einsatz von Künstlicher Intelligenz (KI) in Verbindung mit analytischen Anwendungen. In der Regel ist damit die Nutzung von Machine-Learning-Algorithmen gemeint, die durch Training mathematische Modelle bilden, die dann zur Vorhersage oder Entscheidungsfindung genutzt werden.

Darüber hinaus gibt es viele interessante Ansätze wie neue Visualisierungstechniken (Advanced Data Visualization) oder sogenannte Storytelling-Komponenten, die die Interpretation von Daten unterstützen. Die Nutzung von Geodaten (Location Intelligence) ermögicht neue Anwendungsfälle vom Lademanagement elektronischer Fahrzeuge bis hin zur Landwirtschaft oder der Auswertung von Drohnendaten. Für Anwendungen im Geschäftsalltag sind Fortschritte im Bereich Text (Document Analytics) interessant, da nach wie vor zahlreiche Daten in unstrukturierter Form vorliegen und auf ihre Aufbereitung und Auswertung warten.

Nach Erfahrung von Robert Ruf von SAS bewegen sich die Unternehmendarüber hinaus weg von starren, einheitlichen BI-Werkzeugen hin zu offeneren Architekturen und Bereitstellungsmodellen. „Derzeit sehen wir einen klaren Trend hin zu Cloud-Services, die zwar standardisiert sind, aber gleichzeitig modular genutzt werden können.“ Das ebne auch den Weg für eine Dezentralisierung der BI: Künftig sei nicht mehr die Unternehmens-IT als Zentralstelle zuständig. Stattdessen stellten sich die Fachabteilungen selbst BI-Services ganz nach ihrem Bedarf zusammen. „Durchgesetzt hat sich ganz klar das Self-Service-Prinzip für die Fachabteilungen“, betont Ruf.

Den Trend zu Self-service-Tools für die Datenanalyse bestätigt auch Dr. Michel: „Viele Unternehmen setzen auf moderne Self-Service-BI-Tools, mit denen sich schnell Diagramme, Tabellen und andere Grafiken erzeugen lassen.“ Er beobachten jedoch, dass nur wenige Mitarbeiter diese Möglichkeiten auch tatsächlich einsetzen würden. Der Grund hierfür liege im mangelhaften Training sowie Sensibilisierung und vor allem darin, dass zu wenig Raum zum Experimentieren mit Daten geboten werde. „Daher würden wir Self-Service-BI der Schublade ‚Work in Progress’ zuordnen.“

Wunderpille KI?

Laut Jörg Schmidt von TIQ Solutions sei In vielen Unternehmen ist der Mehrwert der Daten bereits bekannt und die Analyse der Daten schon heute ein wichtiger Bestandteil. Auch werde die Nutzung der Daten immer wichtiger im Wettbewerb zwischen Firmen. Ein größeres Potenzial der Datenmengen könne seiner Ansicht nach durch Methoden aus Data Science, vor allem Künstlichen Intelligenz (KI), geschöpft werden. Aber: „KI ist in vielen Bereichen, unter im KMU-Bereich, noch in den Kinderschuhen, bietet aber viele Möglichkeiten.“ So könnten weitreichendere Marktanalysen entstehen, Prozesse weiter optimiert werden, Kommunikationen zwischen Maschinen ermöglicht werden, oder auch Entscheidungshilfen basierend auf Daten erstellt werden. Er rechnet damit, dass die Bedeutung von Data Science und KI in den nächsten fünf Jahren deutlich ansteigt.

„Ich habe das Gefühl, dass die Methoden im Bereich KI oft als Allheilmittel angesehen werden – im Sinne eines Methodenhype. Dabei lösen sie nicht unbedingt die konkreten Fragestellungen, die das Unternehmen hat“, gibt Jörg Schmidt zu Bedenken. „Beziehungsweise könten einfachere Auswertungen und Visualisierungen oder statistischere Berechnungen die Fragestellungen auch beantworten.“ Grundsätzlich sollte beim Vorgehen immer erst die Fragestellung klar formuliert und beleuchtet werden, bevor geeignete Methoden, Strukturen und Tools gewählt werden und nicht umgekehrt. „Auch nehme ich wahr, dass das Grundverständnis der verschiedenen Begriffe wie Big Data oder KI nicht immer klar ist.“

Stolpersteine auf dem Weg zu BI

Bis vor rund fünf Jahren ging es bei BI häufig noch darum, spezifische Auswertungen für individuelle Fachbereiche zu erzeugen, die auf umständliche Art und Weise aus Anwendungen für das Enterprise Resource Planning (ERP), Curtomer Relation Ship Management (CRM) oder anderen Systemen umständlich extrahiert werden mussten. „Inzwischen ist aber – nicht zuletzt durch Platituden wie ‚Daten sind das neue Öl’ – die Relevanz von datengetriebener Entscheidungsfindung in Unternehmen strategisch in den Vordergrund gerückt“, berichtet Dr. Boris Michel, Leiter Technischer Vertrieb bei den Analytics-Experten von INFORM DataLabs. Das führte ihm zufolge dazu, dass inzwischen selbst im Mittelstand neue Führungsrollen wie einen Chief Data Officer geschaffen werden, deren Aufgabe es sei, die Ressource Daten im Unternehmen zu entwickeln. Dazu gehöre unter anderem die Entwicklung und Umsetzung einer Datenstrategie.

Statt spezifischer Analysen oder Auswertungen steigt dabei aber vor allem das Interesse an unternehmensweiten Projekten, die die Menschen, vom der Lagerarbeiter bis zum Geschäftsführer, mit Daten und Erkenntnissen ausstatten sollen, um ihre tagtägliche Entscheidungsfindung und -geschwindigkeit zu erleichtern. Im Vordergrund stehen dabei: Management und Integration der Daten im Unternehmen, Befähigung und Aufklärung der Mitarbeiter zum datenbasierten Arbeiten und das Einbetten der Datenstrategie in die Unternehmenskultur.

Doch besonders kleine Unternehmen erkennen oft nach wie vor nicht den Mehrwert von Business Intelligence und wenden es daher auch nicht oder nur zögerlich an. Die Gründe dafür sind oft vielschichtig – zum Beispiel eine fehlende Akzeptanz im Management, aber auch die Ablehnung von Mitarbeitern gegenüber Neuem. Bei den Mitarbeitern entsteht eine solche Ablehung häufig aus der Angst heraus, dass durch die neuen Technologien und Veränderungen Arbeitsplätze wegfallen.

Laut Jörg Schmidt sei auch der Kostenfaktor in vielen Betrieben ein wichtiger Punkt. Wenn eine moderne BI-Umgebung integriert werden soll, dann sei dies noch immer mit Kosten verbunden, besonders am Anfang. Das Budget für den Aufbau und Betrieb sei dabei zunächst nicht für alle Firmen ausreichend. „Die Vernetzung der Daten und Zusammenführung ist nicht immer einfach gelöst und so können Aufwand und Kosten ansteigen.“

Doch auch wenn eine BI-Umgebung einmal aufgebaut ist, dann ist die Weiterentwicklung weiterhin relevant, um eintretende Probleme zu beheben und auf Neuerungen reagieren zu können. Das Thema wirkt für viele Firmen zu komplex, um mit der Umsetzung zu beginnen.

BI als Weg aus der Krise?

Die aktuelle Corona-Pandemie hat so manches Unternehmen in die Krise gestürzt. Für viele Betrieb stellt sich hier die Frage, ob Business Intelligence beziehungsweise die Auswertung von Daten ein Weg aus dem Tief sein könnte. Dies ist natürlich stark abhängig vom Unternehmen, dessen Produkten oder Dienstleistungen und welche Daten ich mir in einer Krisenzeit anschaue. Auf dieser Grundlage können mit Hilfe moderner Analysemethoden sicherllich Alternativen besser betrachtet und abgeschätzt werden.

„Der massive Einschnitt durch die Corona-Krise hat in jedem Fall in außerordentlicher Weise gezeigt, wie notwendig qualitativ hochwertige Daten zur Beurteilung der Lage sind, aber gleichzeitig auch, wie schwierig Vorhersagen werden, wenn sich die Rahmenparameter für die Unternehmen dramatisch ändern“, so Marcus Giehrl von NTT. Data Anlaytics könne natürlich sehr wohl helfen im Umgang mit der Corona-Krise – „die Vorhersagequalität ist aber mehr denn je kritisch zu hinterfragen. Der Fokus auf die Themen Datenqualität und die Qualität der Modellierung werden durch den disruptiven Charakter der Krise noch verstärkt.“

Es bringe aber nichts, wenn ich zum Beispiel als Ladenbetreiber erkenne, dass ich weniger Umsatz mache und in welchen Städten meine Ladenlokale schlecht laufen, erklärt Jörg Schmidt von TIQ Solutions. Deswegen müsse man vielmehr erkennen, „dass ein Online-Geschäft und dessen Wahrnehmung beim Kunden in dieser Krise hilfreich sein könnten, den Umsatz am Laufen zu halten. Oder dass ich als Restaurantbesitzer einen Lieferservice einrichten muss und plötzlich eher zum Kunden muss, statt dass dieser wie bisher zu mir kommt.“ Bin ich wiederum ein Online-Händler, dann könnten Daten über die Top-Produkte helfen gegebenenfalls Produktionskapazitäten und Preisgestaltung anzupassen.

Um beim Beispiel des Ladenlokals zu bleiben: Der stationäre Einzelhandel hat generell ein Absatzproblem – unabhängig von Corona. Die Corona-Krise zwingt die Unternehmen dazu, neue Strategien zu ermitteln und sie tatsächlich anzugehen. Der Leidensdruck wurde somit durch Corona einfach nur verstärkt und zwingt zum Handeln. Anders sehe es im Online-Segment aus: „ Da sehe und höre ich Data Analytics in Summe häufiger, vermutlich beschleunigt es dennoch die schon eintretenden Veränderungen. BI oder DataAnalytics-Anbieter müssen die Chance nutzen und die entsprechenden Mehrwerte aufzeigen“, so Schmidt.

Die Corona-Krise habe die Sicht auf Business Intelligence nach Ansicht von Marcus Giehrl mit Sicherheit verändert, allein schon, weil nahezu jeder Einzelne jetzt einen persönlichen Bezug zu Daten und deren Auswirkungen auf Entscheidungen der täglichen Lebensführung habe. Hinzu komme die globale Tragweite. „Die wochenlangen Sondersendungen mit Statistiken und KPIs zu den Infektionszahlen sind jetzt Teil des individuellen und kollektiven Gedächtnisses rund um den Globus.“ Das werde sowohl die Nachfrage von Business Intelligence m Sinne der Erwartungshaltung und Kundenanforderungen als auch die Anbieterseite verändern.

Fazit

Der Markt für Business Intelligence und die Möglichkeiten aufgrund neuer Technologien entwickeln sich ständig weiter. Doch trotz Künstlicher Intelligenz, Self-service BI & Co. – wichtig ist vor allem, dass sich Unternehmen auf die Datenanalyse einlassen und, falls noch nicht geschehen, endlich die ersten Projekte in Angriff nehmen.

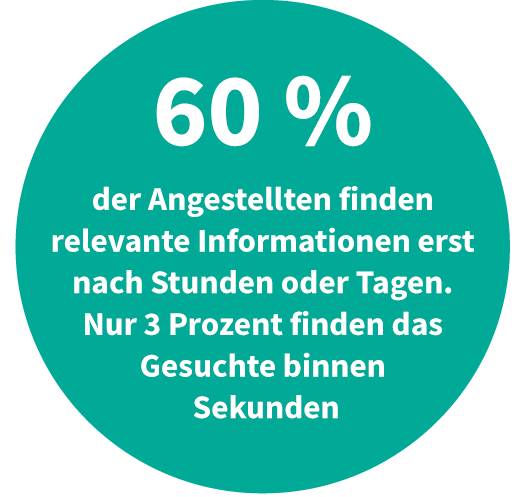

Die aktuelle Krisenzeit erfordert von Entscheidern ein noch schnelleres Agieren als üblich. „Den Luxus stunden- oder tagelanger Datenauswertungen oder von intransparenten Prozessen können sie sich in diesen Phasen nicht leisten“, so das Resüme von Dr Michel. Dazu brauche es nicht nur sofort verfügbare Auswertungen, sondern auch Optimierungssysteme, die basierend auf diesen Daten operative Entscheidungen treffen können, etwa in der Absatzplanung, Bestandsoptimierung, Produktionsplanung oder in verschiedenen Bereichen von Logistik und Transport.

Data- und Analytics-Trends 2020

Das Beratungsunternehmen BARC beobachtet regelmäßig IT-Trends, die die Zukunft von Data und Analytics beeinflussen, und ermittelt die Buzzwords, die auf der Agenda der IT-Verantwortlichen stehen sollten. Folgende BI-Entwicklungen sollten Unternehmen in diesem und den nächsten Jahren im Blick haben:

- Nutzer befähigen: In der Zukunft von Business Intelligence rücken die Nutzer weiter in den Mittelpunkt. Unternehmen müssen heute flexibler und schneller auf Veränderungen reagieren. Selfservice-BI ist zwar inzwischen in vielen Unternehmen angekommen, die Herausforderung der kommenden Jahre wird laut BARC jedoch sein, die gewachsene Software-Landschaft zu ordnen.

- Data Management & Analytics erweitern: Aufgrund der steigenden Datenvolumina und neuer Anforderungen in Unternehmen bleibt die Erweiterung von Datenmanagement und Analytics ein wichtiges Thema. So beziehen Unternehmen immer neue Quellen und Arten von Daten in ihre Arbeit ein. Die Experten sehen zudem einen steigenden Bedarf an Advanced Analytics, KI und Deep Learning, da klassische Berichte und Analysen die Anforderungen nicht mehr vollständig erfüllen.

- Datenarchitektur modernisieren: Die Heterogenität von Daten, Systemen und Anwendungen steigt. Das hat laut BARC zur Folge, dass bestehende Architekturen erweitert und modernisiert werden müssen. In den nächsten Jahren stehen Unternehmen vor der Herausforderung, die veränderte Anforderungslage architektonisch abzubilden.

- Daten & Analytics organisieren: Wertschöpfende Innovationen aus Daten können meist nur dann realisiert werden, wenn (Stamm-)Daten in einer zufriedenstellenden Qualität vorhanden sind. Methoden und Konzepte des Stammdaten- und Datenqualitätsmanagements unterstützen Unternehmen bei der Organisation und Pflege von Daten.

- Daten in Prozessen nutzen: Die vier ersten Trends führen allesamt zum fünften und letzten Ziel – Unternehmen müssen in Zukunft Daten besser in Prozessen nutzen, um wettbewerbsfähig zu bleiben. Die Integration von Business Intelligence in Prozessen kann bis hin zu deren Automatisierung inklusive Entscheidungsfindung führen. Fortgeschrittene Modelle können Mitarbeitern somit gewisse, im Vorfeld klar definierte Entscheidungen abnehmen.

Konstantin Pfliegl ist Redakteur bei der Zeitschrift com! professional.

Be the first to comment