Es gibt viel zu entdecken – zu viel. Deshalb haben wir jene Punkte herausgepickt, bei denen das iPhone 14 Pro (Max) wahrlich glänzt. [...]

Jedes Jahr dasselbe Spiel: Apple stellt neue iPhones vor. Und sie alle sind gespickt mit kleinen und großen Neuerungen, sodass nur ein «Best-of» hilft.

Dynamic Island

Sie haben als erstes die neue Kamera vermutet? Die kommt gleich. Aber die «Dynamic Island» muss an oberster Stelle erwähnt werden – einfach deshalb, weil sie so unglaublich typisch für Apple ist: Wie kaschiert man eine Schwachstelle? Indem man sie zu einer Funktion umbaut, die bei Anderen den puren Neid erweckt.

So geschehen bei der «dynamischen Insel» der beiden Pro-Modelle. Dabei wird die neue, pillenförmige Aussparung für die Kamera und die Sensoren von einer schwarzen Fläche umgeben. Sie verhält sich normalerweise brav und unauffällig, wirft sich aber bei der erstbesten Gelegenheit höchst dynamisch in Pose. Das klingt gut; aber eigentlich sagt dieses kurze Video von Apple alles, was man wissen muss:

Die Dynamic Island agiert mit der Apple-typischen Detailversessenheit, indem bei der Musikwiedergabe der Pegel auf der rechten Seite farblich an das Mini-Cover angepasst wird – um nur ein Beispiel zu nennen. Ein Tippen auf die Anzeige wechselt zum aktiven Player.

Quelle: PCtipp.ch

Damit Entwickler ohne gestalterisches Flair nicht unangenehm auffallen, bietet Apple einen flexiblen Satz an Vorlagen, die allen Programmierern zur Verfügung stehen. Es ist absehbar, dass dieses Element in Rekordzeit in allen möglichen Apps Verwendung findet.

Das Always-On-Display

Besonders stolz ist Apple auf das neue «Always-On-Display», will heißen: Das Display zeigt bei stark reduzierter Helligkeit immer noch die Uhrzeit, das Hintergrund-Bild, die Widgets und mehr – aber nur, wenn das iPhone nicht mit dem Gesicht nach unten auf dem Tisch liegt.

Weitere Maßnahmen verhindern, dass die Batterie nach kurzer Zeit leergelutscht ist. So wird die Wiederholfrequenz auf 1 Hz reduziert, was gerade noch reicht, um einen Sekundenzeiger nachzuführen. Der neue Tiefeneffekt auf dem Sperrbildschirm von iOS 16 wird außerdem deaktiviert, damit nichts den Blick auf die Uhrzeit trübt.

Quelle: PCtipp.ch

Tatsächlich wäre mir im Test nichts aufgefallen, das auf eine spürbar reduzierte Laufzeit schließen ließe. Das iPhone 14 Pro Max führt locker durch den Tag.

Doch so toll es klingt: Ich bin froh, dass sich dieses Always-On-Verhalten in der Einstellung Anzeige & Helligkeit unter Immer eingeschaltet deaktivieren lässt.

Seit dem ersten iPhone im Jahr 2007 bin ich ein dunkles Display gewohnt, das nur hell wird, wenn das Gerät etwas mitteilen möchte. In den drei Wochen mit dem iPhone 14 Pro suchte ich das Display reflexartig nach neuen Mitteilungen ab, weil ein aktives Display schließlich nichts anderes bedeuten kann, als dass jemand etwas will.

Davon abgesehen ist das Display die pure Freude.

Die Wiederholfrequenz ändert dynamisch zwischen 10 Hz und 120 Hz, sodass die Batterie bei statischen Inhalten geschont wird. Die komplette Abdeckung des P3-Farbraums sorgt für kräftige Farben und hervorragende Kontraste.

Deutlich gestiegen ist auch der Komfort im Freien. Wie beim iPhone 13 Pro beträgt die typische maximale Helligkeit 1000 Nits, die bei HDR-Inhalten auf 1200 Nits hochgeschraubt werden kann. Im Freien legt das iPhone 14 Pro noch einmal deutlich zu und erhöht die Helligkeit auf unglaubliche 2000 Nits!

Kurzum, dieses Display ist ohne Tadel.

Fotos: Besser oder nur anders?

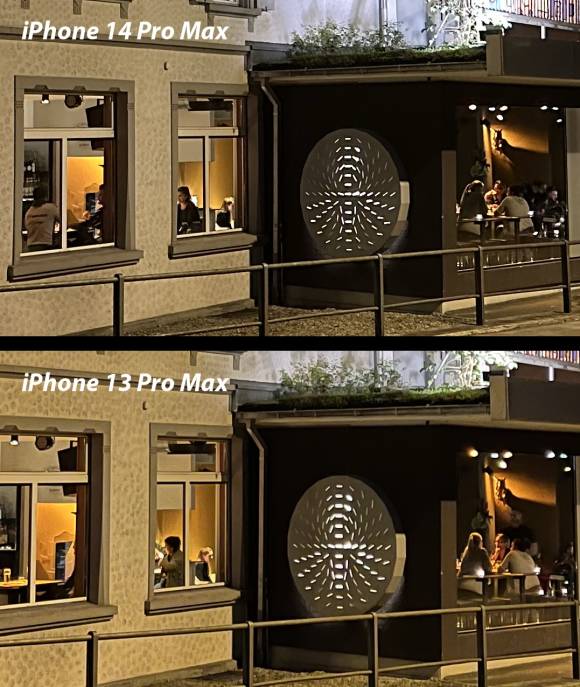

Während die Dynamic Island vor allem durch ihren originellen Ansatz und ihre Nützlichkeit gefällt, interessieren sich die meisten potenziellen Käufer für die Kamera – halt so wie jedes Jahr. Hier sind die Unterschiede auf den ersten Blick eher klein ausgefallen.

In diesem Beispiel sind die Wolken beim iPhone 14 Pro Max eher ein wenig heller, und auch die Hausfassade präsentiert sich ein wenig frischer, wohl durch einen etwas besseren Weißabgleich.

Hingegen wirken die Wolken beim iPhone 13 Pro Max einen Tick dramatischer. Das kann gefallen oder nicht – aber bei normalem Tageslicht entscheidet allein der persönliche Geschmack darüber, welches Bild besser ist.

Quelle: PCtipp.ch

So viel vorweg: Wenn das iPhone einfach als Schnappschuss-Kamera ohne weitere Ambitionen verwendet wird, dann bietet das iPhone 14 Pro zwar eine bessere Qualität als das iPhone 13 Pro.

Aber die großen Unterschiede erfahren nur jene, die sich bewusst auf die neuen Möglichkeiten einlassen – auch wenn diese vielleicht ein wenig technischer wirken, als wir es uns von Apple gewohnt sind.

Die neue «Photonic Engine»

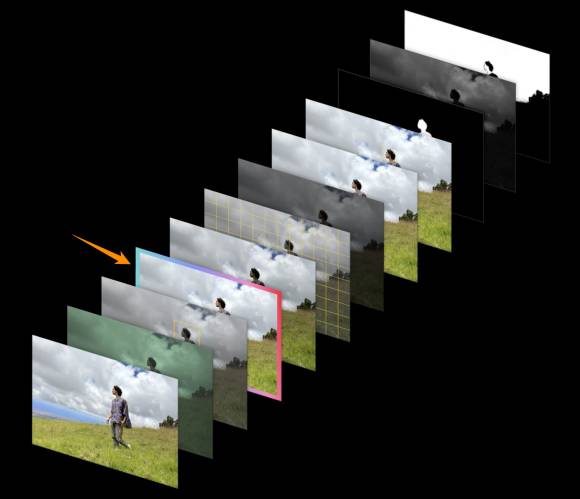

Bei jedem von Apples A-SoC (System on Chip) sorgt die «Image-Pipeline» dafür, dass ein Foto einer ganzen Reihe von Optimierungen unterzogen wird: Kontraste, HDR, Tonwertkorrektur und mehr werden der Reihe nach abgespult, bevor das Bild gespeichert wird.

Eine besondere Rolle kommt dabei «Deep Fusion» zu, das 2019 mit dem iPhone 11 seinen ersten Auftritt hatte. Der ehemalige Marketing-Chef bei Apple, Phil Schiller, bezeichnete Deep Fusion als «computergestützte, verrückte Wissenschaft der Fotografie».

Bei Deep Fusion wird bei einem Druck auf den Auslöser zunächst eine Reihe schneller Fotos aufgenommen, gefolgt von einer längeren Belichtung. Anschließend werden die Bilder mit den besten Informationen neu zusammengesetzt. Das zeigt sich besonders beim geringeren Rauschen bei schwachem Licht und bei feinen Objekten wie Haaren oder Textilfasern.

Mit dem iPhone 14 Pro hat Apple einen neuen Marketing-Begriff ersonnen: Die Photonic Engine verändert die Bildoptimierung, indem Deep Fusion weiter vorne in der Bearbeitungskette steht. Es wirkt also auf die RAW-Daten, noch bevor diese komprimiert werden.

Quelle: Apple Inc.

Diese neue Reihenfolge soll die Aufnahmen bei Nacht weiter verbessern. Doch tatsächlich würde ich im Blindtest mit einem iPhone 13 Pro als Vergleich wohl kläglich versagen.

Ja, die Bilder sind anders und zum Teil besser – aber oft ist kein Unterschied zu erkennen. Oder nur der persönliche Geschmack entscheidet. Etwa hier:

Quelle: PCtipp.ch

Und hier der Crop. Definitiv anders.

Aber besser? Schwer zu sagen:

Quelle: PCtipp.ch

Auch bei dieser Aufnahme gibt es keinen Sieger. Die Lichtverteilung des Spots wirkt beim iPhone 13 Pro natürlicher, während das iPhone 14 Pro die Struktur der Wände besser herausarbeitet:

Quelle: PCtipp.ch

Was auf jeden Fall positiv aufgefallen ist: Im Vergleich zum iPhone 13 Pro (und weiteren Vorgängern) wirken die Fotos bei kniffeligen Motiven nicht mehr so überschärft, wie es vorher manchmal vorkam.

Wie immer gilt, dass diese Image-Pipeline direkt in den SoC eingebettet, also von der Hardware abhängig ist. Die Photonic Engine wird auch vom iPhone 14 (ohne Pro) mit dem leicht überarbeiteten A15-SoC unterstützt, aber nicht von den älteren Modellen.

Endlich 48 Mpx

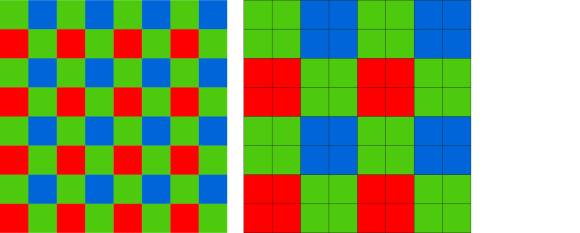

Nachdem die Foto-Auflösung der iPhones schon seit Jahren bei 12 Mpx verharrt, macht die neue Kamera einen großen Sprung nach vorn – allerdings gilt das nur die Hauptkamera, die in der Kamera-App mit «1×» beschriftet ist.

Denn es geht oft vergessen, dass im iPhone im Gegensatz zu einer klassischen Kamera nicht einer, sondern drei Kamerasensoren verbaut sind – und jeder kommt mit seiner eigenen Optik.

Der Sensor der Hauptkamera ist deutlich grösser geworden, gemäß Apple um ganze 65 Prozent.

Und wie wir seit der ersten Analogkamera wissen, gehört es zu den unverrückbaren Gesetzen der Fotografie, dass die Bildqualität mit der Größe des Films oder des Sensors zunimmt – zumindest, solange dieser Vorsprung nicht durch eine sinnlos hohe Auflösung zunichte gemacht wird. Beim iPhone 14 Pro lässt sich der deutlich größere Pixelhaufen auf zwei Arten nutzen.

12 Mpx. Wenn wie gewohnt in HEIF oder JPEG fotografiert wird, fasst das iPhone jeweils 4 Pixel zu einem einzigen Pixel zusammen («Pixel Binning»). Das läuft schlussendlich auf einen sehr viel größeren Pseudo-Pixel hinaus.

Die Auflösung bleibt im Vergleich zum Vorgänger mit 12 Mpx also unverändert, doch die Qualität des Bildes nimmt weiter zu – zumindest theoretisch. Denn wie auf der vorherigen Seite gezeigt, ist es nicht immer einfach, einen Unterschied zum iPhone 13 Pro auszumachen.

Quelle: PCtipp.ch

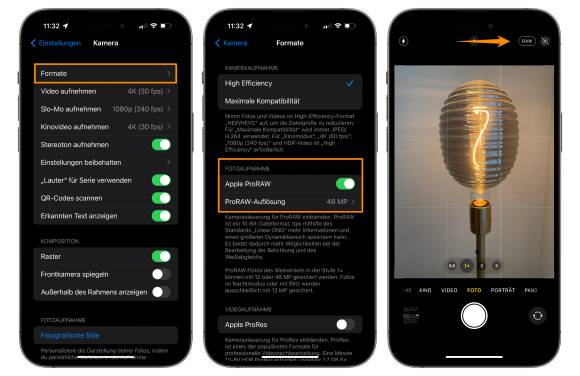

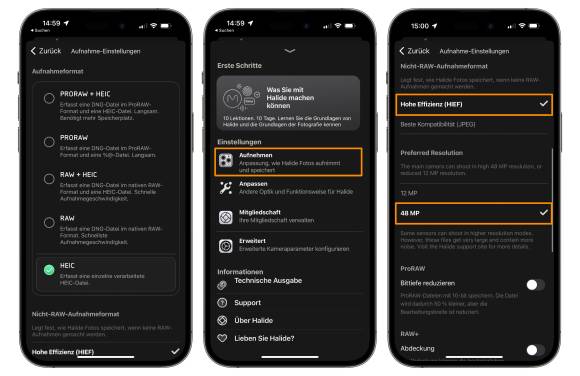

48 Mpx. Die zweite Möglichkeit besteht darin, im ProRAW-Format zu fotografieren. Dazu wird in den Einstellungen zu Kamera im Bereich Formate der Schalter bei Apple ProRAW umgelegt und gleich darunter zwischen 12 Mpx und 48 Mpx gewählt.

So getan, erscheint in der Kamera-App die Schaltfläche RAW, mit der zwischen ProRAW und HEIF (oder JPEG) gewechselt wird:

Quelle: PCtipp.ch

Doch es gilt, bei der Aufnahme genau hinzuschauen. Alle drei Kameras sind RAW-fähig; aber wenn eine andere Kamera als «1×» verwendet wird, resultiert daraus nur eine 12-Mpx-Aufnahme, was oft erst zuhause bemerkt wird.

Tipp: Die populäre Kamera-App Halide Mark II zeichnet Fotos auf Wunsch mit 48 Mpx in HEIF auf – also ohne den Umweg über das RAW-Format.

Schade nur, dass sich Apple aus unerfindlichen Gründen nicht dazu durchringen konnte. Halide kostet 12 Euro jährlich oder 60 Euro einmalig.

Quelle: PCtipp.ch

Die Tücken von 48 Mpx

Die 48 Mpx sind ein großer Sprung nach vorn. Allerdings braucht es dazu vor allem gute Lichtverhältnisse, damit die Photonic Engine nicht zu stark eingreifen muss.

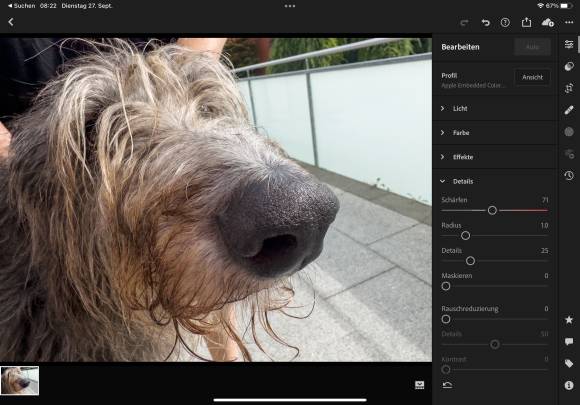

Im schwachen Licht beträgt die Auflösung zwar ebenfalls 48 Mpx; aber die Vorteile bei der Qualität sind längst nicht so offensichtlich wie im strahlenden Sonnenlicht. Dessen ungeachtet ist die neue Auflösung nach so vielen Jahren der 12-Mpx-Bilder eine Wucht:

Quelle: PCtipp.ch

Allerdings ist bei RAW-Dateien der Name Programm: Es handelt sich um «rohe Dateien». Zwar macht es uns Apple bei der Weiterverarbeitung sehr einfach: Solange die Bilder in der Fotos-App verbleiben, sehen sie aus wie gewöhnliche HEIF-Dateien und profitieren von allen Optimierungen, die ihnen die Photonic Engine angedeihen lässt.

Sie lassen sich auch mit einem Tippen teilen und verschicken, immer mit 12 Mpx. Sobald die Bilder jedoch im DNG-Format exportiert werden, geben die RAW-Daten den Ton an. Jetzt muss jedes Foto in einer RAW-Software wie Lightroom oder Capture One von Hand nachbearbeitet werden, damit die Bilder überzeugen.

Quelle: PCtipp.ch

Der Einfachheit halber könnten alle Fotos in ProRAW aufgezeichnet, normal verwaltet und erst bei Bedarf als DNG optimiert werden. Allerdings sorgt der Speicherbedarf sehr schnell dafür, dass solche Gelüste verworfen werden, denn das braucht Speicher:

- Foto mit 12 Mpx in HEIF: ca. 1,5 MB

- Foto in ProRaw und 12 Mpx: ca. 20 MB

- Foto in ProRAW und 48 Mpx: ca. 75 MB

Das dürfte jetzt zum einen oder anderen «Uff!» führen. Was ich an der Fotos-App vermisse, ist die Möglichkeit, ein ProRAW-Bild in der Fotos-App zu einem gewöhnlichen HEIF mit all seinen Annehmlichkeiten zu konvertieren.

Dann ließen sich nur jene Bilder in diesem Format behalten, die es wirklich nötig haben.

Die Vorteile von 48 Mpx

Allerdings bietet die hohe Auflösung auch einen großen Vorteil – selbst wenn am Ende der Verwurstung nur ein 12-Mpx-Bild daraus resultiert.

Das iPhone 14 Pro stellt neu vier «Brennweiten» zur Auswahl, obwohl nur drei Objektive respektive Sensoren verbaut sind. Auf Kleinbild umgerechnet sind das:

- 0,5×: 13 Millimeter

- 1×: 24 Millimeter

- 2×: 48 Millimeter

- 3×: 77 Millimeter

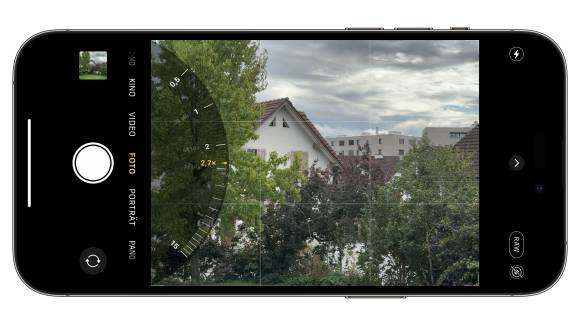

Und das ist für mich eines der Highlights des neuen Kamerasystems. Schon seit Jahren ist es möglich, in der Kamera-App ein wenig länger auf die gewünschte Kamera (1×, 2× …) zu drücken, damit ein Drehrad mit einem stufenlosen Zoom eingeblendet wird.

Nur: Dabei handelte es sich zwangsläufig um interpolierte Fotos, weil die entsprechende Linse gar nicht verbaut ist. Das war mir suspekt genug, dass ich stets die festen Brennweiten verwendet und auf das vermeintliche Zoom dankend verzichtet habe.

Quelle: PCtipp.ch

Beim iPhone 14 Pro ist das anders. Wenn ein Wert zwischen «1×» und «2×» verwendet wird, interpoliert das System gar nichts. Stattdessen wird ein Ausschnitt des 48-Mpx-Sensors angefertigt.

Verglichen mit einem konventionellen Zoom ist das zwar auch nicht die ganze Wahrheit; aber es fühlt sich besser an als ein interpoliertes Foto, das genauso gut in Photoshop oder einer ähnlichen Software mit wenigen Mausklicks errechnet werden kann.

Die Kamera für Videos

Doch nicht nur die Foto-, sondern auch die Videofunktionen haben deutlich zugelegt. Das iPhone gilt seit Jahren als das Smartphone schlechthin, um professionell wirkende Videos zu drehen, bis hin zur Unterstützung von Dolby Vision HDR direkt bei der Aufnahme.

Und Apple hat ganz offensichtlich nicht vor, hier eine Pause einzulegen.

Action-Modus

Bereits das iPhone 13 Pro überzeugte mit seiner hervorragenden Stabilisierung durch Sensor-Shift, will heißen: Der Hauptsensor des iPhones verändert rasend-schnell seine Position durch eine bewegliche Halterung, um die Verwackelungen durch lange Verschlusszeiten oder koffeingetränkte Nervenbahnen zu kompensieren.

Der neue «Action-Modus» geht bei Videos einen großen Schritt weiter: Er bietet eine sensationelle Stabilisierung, wenn die Kamera aus der Hand einem Motiv folgt – also ohne den Einsatz eines Gimbals.

Dabei wird eine 4K-Aufnahme in einem fließenden Prozess auf 2.6K beschnitten; wir tauschen also Auflösung zugunsten einer butterweichen Kameraführung. Diese Reduktion der Auflösung wird auch der Grund sein, warum der Action-Modus in einem bewussten Akt in der Kamera-App aktiviert werden muss.

Der Action-Modus funktioniert in allen Filmmodi, unterstützt das ProRes-Format und die Aufzeichnung in Dolby Vision.

Apple ProRes und Lightning

Die Möglichkeit, Videos in Apples ProRes-Datenformat aufzunehmen, kannte hingegen schon das iPhone 13 Pro. Die maximale Auflösung beträgt unverändert 4K mit 30 fps oder 1080p mit 60 fps – es sei denn, es handelt sich um die kleinste Speicherausführung des iPhone Pro mit 128 GB: Dann wird lediglich in 1080p mit 30 fps aufgezeichnet.

In 4K verschlingt eine Minute Video ganze 6 GB an Speicher – und das macht sich bemerkbar, wenn die Dateien später auf den Mac oder PC übertragen werden.

Beim Übertragen einer 5,5 GB großen ProRes-Datei von gerade einmal 1 Minute vergingen via Lightning geschlagene 150 Sekunden – und das zeigt doch, wie sehr diese Schnittstelle in die Jahre gekommen ist, vor allem bei solchen Anwendungen.

Cinematic Mode

In der Kamera-App kurz «Kino» genannt. Diese Einrichtung kannte schon das iPhone 13 Pro: Beim Drehen von Videos legt die Kamera in einem dynamischen, fließenden Prozess die Schärfe zum Beispiel auf jene Person, die sich der Kamera zuwendet, während der Rest des Bildes in einer gepflegten Unschärfe verschwindet.

Der Fokus kann aber auch mit einem Tippen an die gewünschte Stelle verlagert werden. Der Clou: Diese Fokussierung lässt sich später noch ändern. Das ist physikalisch gesehen ein Ding der Unmöglichkeit; deshalb hat die Verlagerung des Fokus’ auch nichts mit der klassischen Schärfentiefe zu tun, sondern wird digital berechnet.

Mit dem iPhone 13 Pro war der Cinematic Mode noch auf 1080p mit 30 fps beschränkt; neu sind es 4K mit 30 fps sowie mit Unterstützung von Dolby Vision HDR. Vor allem aber wurde die Berechnung des Bokehs verbessert, was vor allem bei Haaren, Schmuck und anderen Feinheiten zum Tragen kommt.

Unfallerkennung und Satelliten

Ein weiterer Schwerpunkt des neuen iPhones liegt bei der Sicherheit. Dazu gehört die neue Unfallerkennung, die einen schweren Autounfall registriert und automatisch einen Notruf absetzt, wenn man bewusstlos ist oder nicht selbst wählen kann. Dabei hilft ein neuer Beschleunigungssensor, der Kräfte bis zu 256 G erfasst.

Registriert das iPhone einen Aufprall, der als Verkehrsunfall einzuschätzen ist, kontaktiert es nach wenigen Sekunden den Notdienst und spielt eine Sprachschleife ab, die über den Aufprall informiert und gleichzeitig den Standort angibt.

Zusätzlich werden jene Personen informiert, die in der Health-App als Notfallkontakte angegeben sind, inklusive Informationen zum Standort.

Gemäß Apple wurden die Algorithmen, die zur Erkennung eines schweren Unfalls hinzugezogen werden, auf der Basis von über 1 Million Stunden realer Fahr- und Unfalldaten trainiert.

Das kann einem ein gutes Gefühl geben. Und vielleicht geht es manchmal wirklich um Sekunden, wenn es zum Schlimmsten kommt. Vermutlich wird diese Funktion im mittleren Westen der USA oder in der Wildnis von Kanada mit anderen Augen gesehen als hier bei uns.

Notrufe über Satelliten

Diese sehr spezielle Neuerung ist für uns graue Theorie, weil sie zuerst nur in den USA und Kanada verfügbar sein wird – und selbst dort frühestens im November.

Allerdings lassen sich in diesen beiden Ländern fast alle iPhone-14-Modelle nutzen, egal, wo sie gekauft wurden. Einzig die Geräte aus China, Hong Kong und Macao bleiben außen vor.

Der «Notruf» besteht genaugenommen aus einer Textnachricht. Dabei hilft das iPhone bei der Ausrichtung auf den Satelliten, was ein paar Minuten dauern kann.

Wichtig ist dabei, im Freien zu stehen und möglichst keine Hindernisse wie Bäume oder Felsen um sich zu haben. Dieser Notruf kann sinnvollerweise nur abgesetzt werden, wenn weder eine Verbindung zum Mobilfunk- noch zu einem Wi-Fi-Netzwerk besteht.

Quelle: Apple Inc.

Der Dienst soll ab seiner Einführung zwei Jahre lang kostenlos sein. Ob er anschließend überhaupt etwas kostet und wie viel, wurde noch nicht kommuniziert. Vermutlich ist sich Apple da selbst noch nicht sicher.

Kaufberatung und Fazit

Selten lagen zwei iPhone-Generationen so nahe zusammen. Im Vergleich zum iPhone 13 Pro fallen vor allem das Always-On-Display und erst recht die clevere Dynamic Island ins Gewicht.

Bei der Kamera wird es schwieriger.

Fotografen profitieren in erster Linie von der 48-Mpx-Hauptkamera und der verbesserten Schärfung durch die Photonic Engine. Auch das neue «Tele», das von der höheren Auflösung profitiert, wird gerne genommen. Der Wow-Effekt bleibt hingegen aus, zu gering sind die Unterschiede – aber das zeigt auch nur, dass bereits die Kamera des iPhone 13 Pro überragende Ergebnisse erzielen konnte.

Die wahren Profiteure der aktuellen Generation sind die Videofilmer. Der neue Action-Modus sorgt für dramatische und doch professionell wirkende Kamerafahrten, während der Kino-Modus auf 4K angehoben und das Bokeh präziser wurde. Beide sorgen für Ergebnisse, die sich im besten Wortsinn «sehen lassen».

Hingegen ist das iPhone 14 Pro (Max) ein gewaltiger Sprung für alle, die bis jetzt mit einem iPhone 12 oder älter ausgerüstet sind. Hier gibt es nur einen Rat: zugreifen.

Und das iPhone 14 (Plus)?

Zu den Besonderheiten dieser Generation gehört auch, dass die reguläre und die Pro-Version deutlich auseinanderdriften.

Der Preisunterschied beträgt 250 Euro, doch wenn sich dieser Unterschied verkraften lässt, wählen Sie unbedingt die Pro-Version.

Das iPhone 14 und das größere iPhone 14 Plus kommen mit einem langsameren SoC. Es fehlen die 120 Hz Wiederholrate, die Dynamic Island, das Always-On-Display und die 2000 Nits maximale Helligkeit.

Vermisst werden außerdem die 48 Mpx der Hauptkamera und, und, und.

Kurzum: Die 250 Eurp sind ein zu kleiner Unterschied, um auf so viele großartige Funktionen zu verzichten – vom tieferen Wiederverkaufswert ganz zu schweigen.

Fazit

Das iPhone 14 Pro (Max) bietet einige herausragende Eigenschaften, während die Liquid Island ein völlig neues, aber sehr überzeugendes Bedienkonzept einführt.

Es ist anzunehmen, dass in Zukunft immer mehr Apple-Geräte damit ausgestattet werden, doch für heute bleibt die quirlige Anzeige ein Merkmal der Premium-Serie.

Davon abgesehen, verdienen das Display, die Kamera und die ganze Anmutung die Bestnote. Nur der Unterschied zum iPhone 13 Pro ist ein wenig kleiner ausgefallen als erwartet. Aber das tut den Qualitäten keinen Abbruch.

Be the first to comment