In vielen Unternehmen fehlt es noch an einer Strategie für eine sinnvolle Datenverarbeitung. Das Datenmanagement ist Dreh- und Angelpunkt der Digitalisierung, denn Daten sind die wertvollste digitale Ressource eines Unternehmens. [...]

Oft aber bleiben datengetriebene Geschäftsmodelle und daraus resultierende Wettbewerbsvorteile noch ungenutzt. Vielmehr sind Daten in vielen Firmen noch ein kostspieliges Sorgenkind.

Wortschöpfungen wie Datenexplosion oder Datentsunami beschreiben, wie immer mehr Sensoren, Technologien und Maschinen in den Unternehmen tagtäglich gigantische Datenmengen generieren. Einen Wert erhalten diese Daten aber nur dann, wenn sie sinnvoll zusammengeführt, analysiert und ausgewertet werden. Dafür müssen die passenden Daten zur Verfügung stehen, die Datenqualität muss angemessen sein und der manuelle Aufwand gering. Das Thema Datenwachstum ist nicht neu, das Ausmaß setzt die Unternehmen jedoch immer mehr unter Handlungsdruck. IDC prognostiziert bis 2024 ein Datenwachstum von 26 Prozent pro Jahr.

Eine weitere Baustelle ist die Massenfragmentierung von Daten. Sie resultiert aus der wachsenden Verbreitung von Daten über verschiedene Infrastruktursilos, Standorte, Clouds und Kopien hinweg. Häufig verwenden Unternehmen für unterschiedliche Anforderungen jeweils andere Lösungen. Es fehlt ein Gesamtkonzept für die Datenspeicherung und -verwaltung. So entstehen Insellösungen und Datensilos, die von anderen Unternehmensbereichen isoliert sind und sich nicht sinnvoll nutzen lassen. Das verschenkt nicht nur viel Potenzial, sondern verlangsamt Prozesse und hemmt die Innovationskraft des Unternehmens.

Das Gegenmittel: ein zentrales Datenmanagement. Dies erfordert eine einheitliche Plattform, auf der die Daten gespeichert, miteinander verknüpft und visualisiert werden. So lassen sich sowohl genaue Vorhersagen treffen als auch Prozesse transparenter gestalten, Abläufe optimieren, die Innovationskraft steigern sowie Zeit und Budget sparen.

Mit Data Management as a Service (DMaaS) übertragen Unternehmen die gesamte Last der Datenverwaltung an einen Provider. Ein DMaaS-Dienst übernimmt die komplette Datenerfassung und Datenspeicherung aus allen Unternehmensbereichen – von Servern, Desktops, mobilen Geräten und Cloud-Diensten. Der DMaaS-Service ist die zentrale Sammelstelle aller Daten, auf die berechtigte Mitarbeiter weltweit unmittelbaren Zugriff haben. Zudem ist ein DMaaS-Dienst in der Regel günstiger als Kauf, Installation und Management einer Speicherplattform On Premise. Die Analysten von Gartner betonen: „Schlechtes Datenmanagement führt zu ständig steigenden Speicherkosten. Die IT-Industrie hat kein Speicherproblem; sie hat ein Datenmanagementproblem.“

„Daten sind ein sehr wertvolles Gut für Unternehmen“

Pascal Brunner, Field Technical Director EMEA beim DMaaS-Anbieter Cohesity, erklärt im Interview, warum Data Management as a Service für Unternehmen immer attraktiver wird.

com! professional: Was sind die größten Herausforderungen der Unternehmen mit Blick auf das exponentielle Wachstum der Daten, und was für Daten sind das überhaupt?

Pascal Brunner: Die größte Herausforderung liegt darin, dass sich der überwiegende Teil der Unternehmensdaten in fragmentierten Infrastruktursilos befindet. Dazu gehören Backups, Archive, Dateisysteme, Objektspeicher sowie Daten für Test, Entwicklung und Analysen. Dadurch entsteht das Problem der Mass Data Fragmentation. Durch die weiter steigende Flut an verschiedenartigen Daten – etwa von IoT-Sensoren, Monitoring- oder Analysesystemen und weiter befeuert durch die Einführung von 5G – müssen Unternehmen nach neuen Möglichkeiten des Datenmanagements suchen. Dies erfordert aus Gründen der Skalierbarkeit häufig den Umstieg in die Cloud, um die Wertschöpfung aus den zahlreichen Daten zu erleichtern.

com! professional: Wie kann man mit Data Management nicht nur die Datenmengen, sondern auch die zunehmende Fragmentierung der Datenspeicher in den Griff bekommen?

Brunner: Datenmanagement ist ein entscheidender Faktor für jedes Unternehmen, das auf Geschwindigkeit und Sicherheit angewiesen ist. Im Rahmen von Data Management as a Service können Kunden Lösungen abonnieren, die ein breites Spektrum von Anwendungsfällen abdecken: Backup, Disaster Recovery, Datei- und Objektdienste, Datenkopieverwaltung, Datensicherheit und Governance als Service komplett aus einer Hand. Dies reduziert Infrastruktursilos und gleichzeitig die Fragmentierung großer Datenmengen.

com! professional: Wie kann ein Unternehmen den Status quo und den Handlungsbedarf im Bereich Data Management ermitteln?

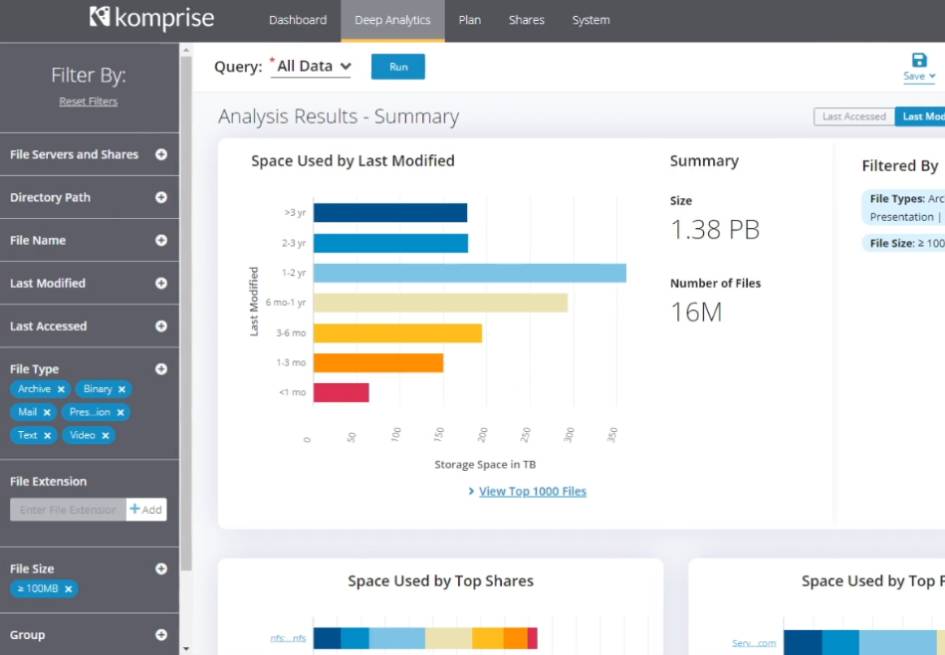

Brunner: Häufig gibt es in Unternehmen an verschiedenen Orten mehrere Kopien der gleichen Daten. Dies erhöht die Speicherkosten signifikant. Die Datenkopien entstehen durch Test- und Entwicklungsumgebungen, Sicherungen, siloartige Anwendungen, Archive und regulatorische Anforderungen. So geben laut IDC-Studien die Unternehmen bis zu 60 Prozent des Speicherbudgets alleine für die Verwaltung von Kopien aus. Die Unternehmen sollten prüfen, ob sie genau wissen, wo welche Daten liegen. Außerdem sollten sie sich fragen, ob sie das volle Potenzial aus ihren Daten schöpfen. Mit DMaaS haben sie eine einfache Möglichkeit, umfassende Datenmanagement-Funktionen als Teil eines cloudbasierten Services zu nutzen, ohne selbst eine entsprechende Infrastruktur aufbauen zu müssen.

com! professional: Welche konkreten Vorteile bringen DMaaS-Angebote?

Brunner: Daten sind ein sehr wertvolles Gut für Unternehmen. Daher müssen sie sowohl geschützt als auch jederzeit verfügbar sein. Dieser Kompromiss gelingt auf optimale Weise mit Hilfe von DMaaS-Services. Sie bieten großen und mittelständischen Unternehmen eine einfache Möglichkeit zur Sicherung, Verwaltung und Analyse ihrer Daten. Bei der Bereitstellung stehen mehrere Wege offen. Es gibt eine vollständig schlüsselfertige, vom Anbieter verwaltete DMaaS-Lösung, eine von Partnern verwaltete Infrastruktur und eine vom Kunden selbst verwaltete Version.

com! professional: Aus welchen Schritten und Modulen setzt sich DMaaS zusammen?

Brunner: DMaaS vereinfacht stark die Art und Weise, wie Daten gespeichert, gesichert, verwaltet und analysiert werden. Es bietet eine kapazitätsbasierte Preisgestaltung, beseitigt Infrastruktursilos und konsolidiert Daten aus verschiedenen Anwendungsfällen wie Datensicherung und -archivierung, Disaster Recovery, Datei- und Objektdienste, Copy Data Management und Analysen in einem einheitlichen Service – ohne sich auf den Betrieb der darunterliegenden Infrastruktur kümmern zu müssen.

com! professional: Sind bei DMaaS besondere Sicherheitsmaßnahmen und zusätzliche Compliance-Schritte notwendig?

Brunner: Bei DMaaS sind grundsätzlich die gleichen Maßnahmen in Bezug auf Security und Compliance nötig wie im unternehmenseigenen Rechenzentrum. Bei der Nutzung von Partner-Lösungen oder des Cohesity-Angebots sind strenge Sicherheitsvorkehrungen gewährleistet. Allerdings sind sie – ebenso wie die nötigen Compliance-Maßnahmen – in enger Absprache zwischen Anbieter und Kunde an die jeweiligen Anforderungen anzupassen. Um Kunden bei der Erfüllung von Compliance-Anforderungen zu unterstützen, können sie Backup-Repositories mit Diensten wie Amazon Macie verbinden, der maschinelles Lernen nutzt, um sensible Daten automatisch zu erkennen, zu klassifizieren und zu schützen.

Exponentielles Wachstum der Daten

Was exponentielles Wachstum bedeutet, hat Corona eindrucksvoll vor Augen geführt. Ähnlich folgenreich ist dieser Effekt beim Datenwachstum. Es stellt für die Unternehmen eine große Aufgabe dar, all die anfallenden Daten zu erfassen und damit umzugehen. Rüdiger Ernst, Head of Technology Services beim IT-Dienstleister NTT Data, sieht mehrere Entwicklungen: „Eine Herausforderung ist das rasante Wachstum von unstrukturierten Texten, Bildern und Audio, aber auch von Realtime-Daten durch Webtracking und das Internet der Dinge. Die zweite Herausforderung ist, diese Daten so zu strukturieren, dass man damit etwas anfangen kann.“ Lösungsansätze seien Metadatenmanagement, aber auch neue Wege wie KI-unterstützte Suchfunktionen, bei denen Fragen frei formuliert und vom System in die technische Abfragesprache übersetzt werden.

Sobald die benötigten Informationen erst einmal gefunden sind, geht es im nächsten Schritt darum, sie zu interpretieren. Dazu müssen die Daten eine standardisierte Form aufweisen und korrekt verknüpft werden. Das bedeutet auch, dass die Unternehmen stets genügend Speicher und Rechenleistung zur Verfügung stellen müssen. Möglichst kosteneffizient lässt sich das in der Cloud umsetzen. „Bei Alibaba Cloud sehen wir die konkreten Herausforderungen durch das exponentielle Wachstum der Daten bei unseren Kunden: die großen Datenvolumina sicher, performant und kostengünstig zu verarbeiten“, so Raymond Ma, General Manager for Europe bei Alibaba Cloud Intelligence. Dies stelle viele Unternehmen heutzutage vor eine immense Aufgabe.

Michael Krett ist Geschäftsführer des Datenmanagement-Spezialisten Dynamigs: Er sieht durch das exponentielle Datenwachstum an vielen Fronten Arbeit auf die Unternehmen zukommen. „Sie brauchen einerseits immer mehr günstigen Speicherplatz, der andererseits sehr leistungsfähig für Produktionsdaten sein soll. Ständiger Zukauf von neuer Speicher-Hardware bedeutet jedoch hohe Investitionen.“ Um diese zu minimieren, brauche es sowohl eine langfristige Storage- als auch eine Datenstrategie.

„Erst wenn man weiß, welche Daten man hat und welche zusätzlichen Daten man in Zukunft generieren wird, kann man sie sortieren, strukturieren und auf die geeigneten Speicher verteilen – je nach Anforderungen.“ Beispielsweise seien kalte Daten, auf die das Unternehmen nur sporadisch angewiesen ist, auf kostengünstigem Cloud-Speicher und Produktionsdaten auf schnellem Flash-Speicher am besten aufgehoben.

Ingo Vorreiter, Cloud Strategist bei der BTC Business Technology Consulting AG, sieht exponentielles Datenwachstum in zwei Bereichen: „Zum einen im Segment Forschung und Entwicklung, wo heute dank Machine Learning und KI-Algorithmen sehr viele Daten entstehen. Zum anderen gibt es die Tendenz, bereichsübergreifend möglichst große, zentrale Data Lakes anzulegen, deren Nutzen stark davon abhängt, wie viele und wie unterschiedliche Datenquellen diesen See speisen.“ Dank der Public Cloud sei ausreichend Speicherplatz keine Herausforderung mehr, auch Compute-Leistung sei immer genügend vorhanden. „Die größte Herausforderung ist die Bandbreite, um gewaltige Datenmengen von ihrem Entstehungsort in die Cloud zu bekommen. Edge-Computing könnte dabei eine wesentliche Schlüsseltechnologie sein.“

„Enorme Datenmengen entstehen insbesondere bei vernetzten Geräten“, weiß Nicky Graßmann, Business Development für Data Driven Services beim IT-Dienstleister Doubleslash Net-Business. „Die hohen Abtastraten von Sensoren lassen Datenmengen schneller entstehen, als sie über herkömmliche Netze weitergegeben werden können. Technologien wie 5G können hier Abhilfe schaffen.“

Die zunehmende Fragmentierung von Datenspeicherorten und -technologien erschwert den Umgang mit den Daten erheblich. Nur allmählich setzt ein Umdenken ein. „Alternativen können organisatorisch sein“, so Rüdiger Ernst, „etwa mit Data-Mesh-Architekturen mit verschiedenen Datenprodukten, die je nach Situation verknüpft und dezentral kuratiert werden. Oder technisch mit Microservice-Architekturen, einem Ansatz aus der Software-Entwicklung.“

„Data Management muss heute da stattfinden, wo das Datenwachstum am größten ist: in der Cloud“, bekräftigt Ingo Vorreiter. In einer Cloud sei das Management selbst größter Datenmengen mit den nativen Werkzeugen sehr gut realisierbar. Die Herausforderung bestehe im Multi-Cloud- und Hybrid-Cloud-Datenmanagement.

Status Quo und Handlungsbedarf

Der Weg zur Erkenntnis führt über Selbsterkenntnis: Unternehmen müssen zunächst ermitteln, wo sie in Sachen Data Management stehen. Daraus leitet sich dann ab, welche Schritte und Maßnahmen erforderlich sind. Dazu dient ein Data-Management-Assessment. Es zeigt, ob die Datenarchitektur zu den Geschäftszielen passt, und wägt diese hinsichtlich Kosten, Flexibilität und Risiken ab.

„Viel zu oft erkennen Unternehmen erst dann den vorhandenen Handlungsbedarf, wenn sie in immer kürzeren Abständen neue Speicher benötigen und die Kosten für Hardware aus dem Ruder laufen“, weiß Michael Krett. Spätestens jetzt sollte das Unternehmen eine klare Datenmanagement-Strategie entwickeln. Im ersten Schritt geht es darum, den Datenbestand zu erfassen. Anschließend gilt es, eine Reihe von Fragen zu beantworten: Was wird wo abgelegt, welche Informationen sind besonders zu schützen und wer bekommt welche Zugriffsrechte? Bei einer Cloud-Strategie ist zudem zu klären, wie man die Daten gegen Zugriffe Dritter absichert und wie man aus der Cloud eines Providers wieder herauskommt, falls die Kosten unerwartet steigen. „Gerade für die Cloud sollte man immer einen Plan B parat haben“, fasst Krett zusammen.

Data Management as a Service

Data Management as a Service stellt eine für Unternehmen besonders komfortable Variante dar, weil der Provider ihnen die Komplexität des Kaufs und Betriebs einer internen Speicherplattform abnimmt. Christian Mertens, Leiter Competence Center Data & Analytics beim IT-Dienstleister und Berater Adesso, beschreibt es so: „Der DMaaS-Provider betreibt eine skalierbare, flexible und zugeschnittene Plattform für die Orchestrierung aller definierten Unternehmensdaten. Darüber hinaus sind Zusatzleistungen möglich, die den Service-Gedanken weiter schärfen: So kann der DMaaS-Provider beispielsweise Compliance-Funktionalitäten, Analytics Services, Legal Hold, zentralisierte Suche, Datensicherung oder Disaster Recovery zusätzlich bereitstellen.“

Die Unternehmensdaten seien somit von überall erreichbar und sie ließen sich in einer skalierbaren Umgebung durchsuchen und verwerten. Oft seien DMaaS-Lösungen zudem günstiger als der On-Premise-Betrieb, zumal Pay-per-Use-Modelle eine nutzungsgerechte Zahlung ermöglichten.

„Kauf, Installation und Wartung von Infrastruktur für das Data Management sind nicht länger Aufgabe des Kunden“, führt Mertens aus. „Nach der Entscheidung für einen DMaaS-Provider werden die benötigten Service-Leistungen abgestimmt. Von der einfachen Speicherung aller sekundären Daten bis hin zu analytischen Zusatzservices gibt es eine Vielzahl von Anwendungsfällen. Für die regelmäßige Übertragung der Daten werden abschließend alle relevanten Systeme per Agenten oder Schnittstellen konnektiert. Systemspezifische Rahmenparameter lassen sich abschließend individuell festlegen – etwa mit welcher Vorhaltezeit die Daten gespeichert werden oder wie oft eine Übertragung stattfindet. Parallel werden die Zugänge für entsprechende Nutzer breitgestellt, sodass sie jederzeit auf die Daten und Services zugreifen können.“

Datenmanagement ist ein kontinuierlicher Prozess. Jeder Status quo ist immer nur ein kleiner Punkt auf dem Zeitstrahl, denn die Menge und die Art von Informationen entwickelt sich ständig weiter. Eine moderne Lösung geht deshalb über die einmalige Analyse des Datenbestands hinaus und kann diesen regelmäßig scannen und analysieren. „Automatisierungs-Tools beschleunigen dabei die kontinuierliche Analyse und verschieben Daten samt ihren Abhängigkeiten und Zugriffsrechten selbstständig an den optimalen Ort“, beschreibt Michael Krett von Dynamigs.

Was hinzu kommt: Je nachdem, ob es sich um eine Public, Hybrid oder Private Cloud handelt, müssen die Unternehmen sehr genau überlegen, ob es überhaupt zulässig ist, Daten in eine Cloud-Umgebung zu verlagern. Nachdem der Europäische Gerichtshof in Luxemburg im vergangenen Jahr das Privacy-Shield-Abkommen gekippt hat, empfehlen sich heute lokale Cloud-Anbieter, die garantieren, dass die Speicherung und Verarbeitung von Daten den Kriterien der DSGVO genügen. „Auch in Sachen Sicherheit ist in der Cloud Vorsicht geboten“, ergänzt Krett. „Die Unternehmen stehen in der Verantwortung, mit geeigneten Tools für die Sicherheit von Daten und Workloads sorgen.“

Data Management und KI

Wenn es darum geht, aus Daten Mehrwerte zu generieren, dann kommt schnell Künstliche Intelligenz ins Spiel. „KI hat das Zeug, das Data Management zu bereichern, weil es ganz neue Möglichkeiten für die Analyse schafft“, ist Franz Kögl überzeugt. Er ist Vorstand bei Intrafind Software, einem Spezialisten für Enterprise Search.

„KI ist in der Lage, mit semantischer und logischer Texterkennung Inhalte in Dateien zu erfassen und Beziehungen zwischen Daten zu erkennen. Dabei ist es fast egal, in welchem Format sie vorliegen und wo sie gespeichert sind, oder aus welchen Quellen sie zusammengeführt werden, etwa einem cloudbasierten Data Management as a Service.“ Intelligente Enterprise-Search-Funktionen beschränken sich laut Kögl nicht mehr auf das bloße Finden von Dateien, sie würden auch bei der Analyse und Verknüpfung helfen und so das Wissen im Unternehmen viel leichter zugänglich machen.

Zudem könne Enterprise Search smarte Metadaten erzeugen und damit beliebige Metadaten-Ebenen über die gesamte Daten- und Informationslandschaft legen. Erst die Einordnung in einen Kontext mache aus bloßen Daten wertvolles Wissen, mit dem die Mitarbeiter im Unternehmen produktiv arbeiten können.

Fazit & Ausblick

Datenspeicherung und Datenverwaltung werden auch in den kommenden Jahren nicht stillstehen. Rüdiger Ernst von NTT Data erwartet einen weiteren Preisverfall bei Speichern, der jedoch durch das Mehr an Daten und die wachsende Komplexität in datengetriebenen Unternehmen aufgezehrt werde. Als Trend neben der Virtualisierung sieht er Transparenz. „Das bedeutet, dass die Anwender trotz der zunehmenden technologischen Diversifizierung immer gleich auf die Daten zugreifen und mit ihnen arbeiten können, sie also die darunterliegenden Technologiewechsel und -varianten gar nicht mitbekommen. Damit erhält auch das Master Data Management noch mehr Bedeutung: Nur darüber kann eine konsistente Datenauswertung über eine heterogene Landschaft hinweg sichergestellt werden.“

Alibaba-Manager Ma findet Prognosen in so einem dynamischen Umfeld wie Cloud-Computing und Data Management schwierig. „Was wir erwarten können, sind weitere Reduzierungen im Bereich der Speicherkosten sowie eine Verlagerung des Schwerpunkts auf die Ausbildung und die Entwicklung in Kernkompetenzen wie Big Data und Machine Learning.“

„Man muss kein Prophet sein, um vorauszusehen, dass Daten auch in Zukunft die Kronjuwelen vieler Unternehmen darstellen werden“, so Dynamigs-Mann Michael Krett. „Um aus diesen Daten auch den entsprechenden Wert zu ziehen, braucht es ein professionelles Datenmanagement.“

Diese Tatsache erkennen immer mehr Unternehmen an und planen Positionen dafür ein, etwa die des Chief Data Officers oder des Data Management Executives. Auch die Cloud als Speicherort gewinnt weiter an Bedeutung. Obwohl sich die Hybrid Cloud als ideale Infrastruktur herauskristallisiert hat, haben traditionelle Speicher vor Ort noch lange nicht ausgedient. Es geht darum, herauszufinden, wo man welche Daten idealerweise speichert. Kalte Daten wie Archivdaten, regelmäßig genutzte Backups oder Echtzeit-Produktivdaten, sie alle benötigen andere Speicherorte. Und bei alledem ist der Faktor Datenschutz miteinzubeziehen.

Umstritten ist die Rolle von Data Lakes. Ingo Vorreiter postuliert: „Ein Megatrend ist der Aufbau von möglichst umfassenden Data Lakes, deren Use-Case zum Teil erst dann entsteht, wenn die Datensammlung bereits begonnen hat.“ Nicky Graßmann von Doubleslash Net-Business sieht das anders: „Zentrale Data-Lake-Konzepte gehören eher der Vergangenheit an. Zukünftig werden wir dezentrale, föderierte Datenlandschaften sehen, bei denen sowohl On-Premise- als auch Cloud-Speicher zum Einsatz kommen. Daten werden in Unternehmen wie Produkte erzeugt und wiederverwendet, als Austauschplattform kommen unternehmensweite Data Marketplaces zum Einsatz.“

Das exponentielle Wachstum von Daten macht es notwendig, bei der Datenspeicherung und der Datenverwaltung ökonomische Wege zu finden, meint Franz Kögl von Intrafind. „Stichwort Right Data und Dark Data. Nicht alle Daten sind wichtig, nicht alle nützlich, da müssen Unternehmen zu Lösungen kommen, bei denen eben nur die passenden Daten vorgehalten und analysiert werden. Für diese Datenökonomie brauchen Unternehmen leistungsfähige Tools und qualifizierte Mitarbeiter.“

Intrafind rechnet mit einem deutlichen Anstieg tiefgehender Datenanalysen in den kommenden Jahren, aber das sei kein Selbstläufer: „Viele Entscheider kennen das Potenzial einer Enterprise-Search-Lösung nicht und können sich noch nicht so recht vorstellen, in welchen Use-Cases sie Insight Search nutzen können. Wir arbeiten daran, das zu ändern.“DMaaS ist noch nicht sehr weit verbreitet, hat aber großes Potenzial. Gerade im Mittelstand oder bei Start-ups ist die Einführung von DMaaS mit geringeren Hürden verbunden und dadurch attraktiv.

„Die DMaaS-Provider werden die nächste Maturitätsstufe erreichen und durch weitere Services sowie ganzheitliche Konnektierungslösungen für Enterprise-Unternehmen interessant werden“, glaubt Christian Mertens. „Ähnlich wie die Cloud-Akzeptanz wird auch die DMaaS-Akzeptanz in Stufen wachsen: Ich gehe davon aus, dass wir zunächst vermehrt hybride Szenarien sehen werden, in denen die Daten teilweise unternehmensintern und teilweise von DMaaS-Providern verwaltet werden.“

*Andreas Dumont schreibt seit 2001 für die com!: zunächst für die „HomeP@ge“-Beilage, ein Überbleibsel des „HomeP@ge-Magazins“. Das war die Zeit, als jeder eine private Homepage basteln wollte. In der Periode, als das Heft unter com! online firmierte, stand das Thema Internet im Mittelpunkt. Die Jahre bei com! – Das Computer-Magazin waren geprägt von Windows-Themen in allen Facetten, angereichert mit Open Source. In com! professional ist er hauptsächlich für die Ressorts Software und Sicherheits zuständig. In seiner freien Zeit spielt er gerne Schach, läuft Halbmarathons, programmiert in Delphi oder bastelt an einem Arduino-Projekt – sofern er nicht gerade auf Reisen ist.

Be the first to comment