Wer den Cyberspace nutzt, begegnet möglicherweise bald einmal animierten Avataren. ETH-Forscher haben neue Algorithmen entwickelt, mit denen sich virtuelle Menschen deutlich einfacher als bisher erstellen lassen. [...]

Spätestens seit der Corona-Pandemie starren wir noch häufiger in den Bildschirm. Sitzungen, Gespräche mit Arbeitskollegen oder Konferenzen finden per Videotelefonie statt. Geht es nach den großen Tech-Unternehmen, sollen wir uns dagegen schon ab nächstem Jahr in einer virtuellen Erlebniswelt, dem sogenannten Metaversum, treffen können – mittels 3D-Brillen und spezialisierten Computerprogrammen.

Der Schlüssel zu einem möglichst natürlichen Nutzererlebnis in Virtual-Reality-Anwendungen sind sogenannte Avatare, also computergenerierte, plastische Darstellungen von Menschen. Je realistischer die Avatare aussehen und sich verhalten, desto eher stellt sich das Gefühl einer echten sozialen Interaktion ein.

Einen Menschen detailgetreu und in Bewegung zu modellieren, fordert die Entwicklerinnen solcher Anwendungen jedoch nach wie vor heraus. Heute können Grafikprogramme zwar schon fotorealistische, statische Avatare erstellen. Um aber beispielsweise ein lachendes Gesicht zu animieren, müssen Grafikdesigner fast jedes Einzelbild am Computer nochmals von Hand bearbeiten; sie bessern Nuancen wie Falten und den Schattenwurf aus.

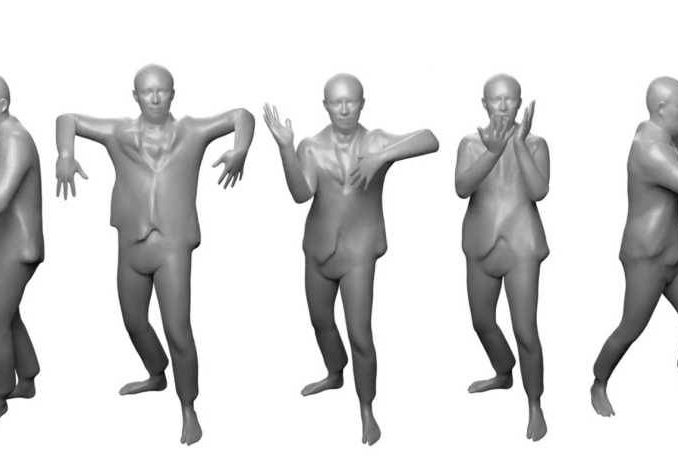

Wie es einfacher geht, zeigten Forscher um Otmar Hilliges, Professor für Computerwissenschaften an der ETH Zürich, in einer neuen Studie, die sie an der internationalen Konferenz für Computer Visioncall_made im Herbst 2021 veröffentlichten. Anstatt jedes Detail zu modellieren, nutzen die Wissenschaftler intelligente Algorithmen, die basierend auf 3D-Bildern von Menschen in einigen wenigen Posen lernen, animierte Ganzkörper-Avatare in allen erdenklichen Posen automatisch darzustellen.

Computermodell kann sogar Überschlag darstellen

Computerprogramme, die mithilfe Künstlicher Intelligenz (KI) lebensechte virtuelle Menschen erstellen, existieren erst seit wenigen Jahren. Damit diese Programme die verschiedenen Körperpositionen realistisch abbilden können, werden sie mit sogenannten 3D-Scans eines realen Menschen trainiert, die ein komplexes Kamerasystem vorgängig aufgenommen hat.

(c) Xu Chen/ETH Zürich

Die KI-Algorithmen verarbeiten die Scans, indem sie unzählige Punkte außerhalb und innerhalb des Körpers vermessen und so dessen Konturen als mathematische Funktion definieren. Sie erstellen dabei eine erste Darstellung des Menschen in der Grundposition. Die Algorithmen berechnen nun jeweils den Weg von einer bewegten Pose zurück in diese Grundposition. Auf diese Weise bauen sie ein Computermodell auf, das Avatare in Bewegung versetzen kann.

Extreme Posen außerhalb des bekannten Bewegungsrepertoires überfordern solche Modelle jedoch und es entstehen gut sichtbare Fehler in den Darstellungen: Die Arme sind losgelöst vom Körper oder die Gelenke am falschen Ort positioniert. Heutige Modelle werden daher mit möglichst vielen verschieden Posen trainiert, was einen riesigen Aufwand für die Bilderfassung bedeutet und eine enorme Rechenleistung voraussetzt.

(c) Xu Chen/ETH Zürich

Gerade für interaktive Anwendungen sind KI-Avatare daher bislang kaum verwendbar. «Es ist unmöglich und vor allem ineffizient, das gesamte Bewegungsrepertoire im Bild einzufangen», sagt Xu Chen, ETH-Doktorand und Erstautor der Studie.

Die von Chen entwickelte neue Methode verfolgt hingegen den umgekehrten Ansatz: Ausgehend von der Grundposition berechnen die KI-Algorithmen den Weg zu einer bewegten Pose. Weil auf diese Weise der Ausgangspunkt der Berechnungen immer der gleiche bleibt, lernen die Algorithmen besser, Bewegungen zu verallgemeinern.

Ein solches Computermodell ist erstmals in der Lage, auch neue Bewegungsmuster problemlos darzustellen. Selbst akrobatische Bewegungen wie einen Überschlag oder eine Rückenbrücke kann es erzeugen.

Beliebig neue Gesichter mit nur einem Bild

Noch lassen sich die neuen Ganzkörper-Avatare nicht personalisieren; die Darstellungen beschränken sich auf den Menschen, von dem die 3D-Bilder stammen. Chen und seine Kollegen möchten daher das Computermodell dahingehend weiterentwickeln, dass es beliebig neue Identitäten erschaffen kann.

(c) Marcel Bühler/ETH Zürich

Um die Gesichter von Avataren zu personalisieren und beliebig abzuändern, hat Marcel Bühler, ebenfalls Doktorand in Hilliges Gruppe, bereits eine Lösung gefunden. Wie auch Chen in seinen Ganzkörpermodellen nutzte Bühler intelligente Algorithmen, die aus der Kombination von einem 3D-Gesichtsmodell und einer großen Palette von Porträtfotos neue animierte Gesichter zu kreieren.

Während bisherige Computerprogramme bereits gute Animationen von Gesichtern in der Frontalansicht liefern, kann das Modell von Bühler auch Gesichter in der seitlichen Ansicht sowie von oben und unten realistisch darstellen.

Wer genau hinschaut, kann Deepfakes entlarven

(c) Marcel Bühler/ETH Zürich

Besteht die Gefahr, dass mit der neuen Technik bald noch realistischere Deepfake-Videos kursieren, um beispielsweise eine Rede eines wichtigen Politikers vorzugaukeln? «Deepfake-Videos sind noch lange nicht perfekt», erklärt Bühler. Die meisten Computerprogramme würden oft nur für ein bestimmtes Setting gute Resultate liefern. So kann das neue Gesichtsmodell beispielsweise Details wie Haare noch nicht realistisch darstellen.

«Wer genau hinschaut, findet nach wie vor Fehler», sagt der ETH-Doktorand. Er findet es wichtiger, die Öffentlichkeit über den aktuellen Stand der Dinge zu informieren und sie zu sensibilisieren. Wenn Forschungsarbeiten zu 3D-Darstellungstechniken wie auch deren Schwachstellen öffentlich zugänglich seien, könnte dies Cybersecurity-Fachpersonen dabei helfen, Deepfake-Videos im Web leichter aufzuspüren, so Bühler.

Für interaktive Virtual-Reality-Anwendungen bringt die Arbeit der ETH-Forscher große Fortschritte. Gut möglich, dass Tech-Unternehmen wie Facebook und Microsoft die neu entwickelten Techniken der beiden Doktoranden in ihre Avatare implementieren werden.

Dieser Artikel ist zuerst auf ETH-News erschienen.

Be the first to comment