Cloud-Initiativen bergen für viele Unternehmen böse Überraschungen, weil die Kosten falsch kalkuliert wurden. Wir geben fünf Tipps für das Cloud-Kostenmanagement. [...]

Immer mehr Unternehmen erkennen Cloud-Dienste als Technologie für ihre Geschäfte von morgen an – eine Entwicklung, die durch COVID-19 noch einmal beschleunigt wird. Der Wechsel in die Cloud bringt viele Vorteile mit sich, darunter Effizienz, Flexibilität und Agilität. Allerdings verändert sich damit die Kostenstruktur, da klassische Investitionskosten für IT-Infrastruktur – etwa der Auf- und Ausbau eines Rechenzentrums – entfallen.

Viele Unternehmen legten in den vergangenen Jahren den Fokus auf eine schnelle Adaption der Cloud. Dadurch sind aus Kostensicht unvorteilhafte Konstellationen entstanden. Das gilt vor allem, wenn bestehende Brownfield-IT-Landschaften einfach via Lift & Shift migriert wurden. Viele Betriebe haben also die Cloud für sich entdeckt, ohne aber die erhofften Kosten- und Skaleneffekte nutzen zu können.

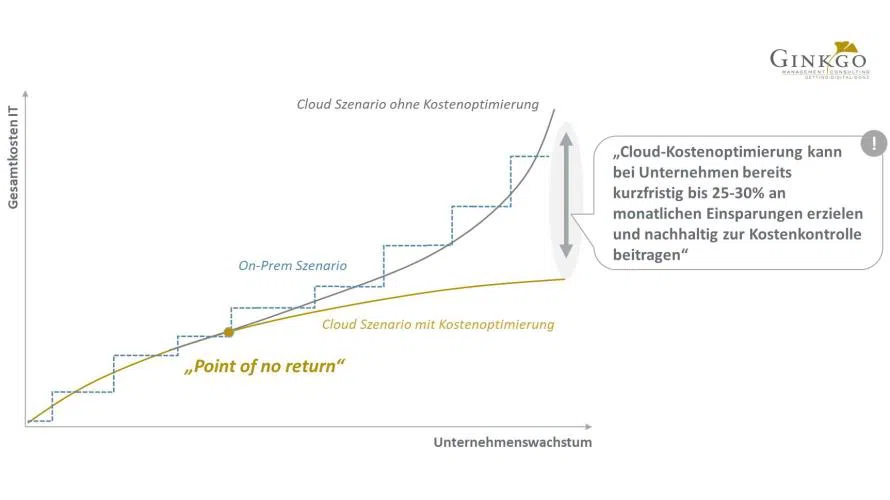

Eine Senkung der Cloud-Kosten von 25 bis 30 Prozent pro Monat ist möglich, wenn Unternehmen ihre Cloud-Landschaft auf folgende fünf Faktoren hin untersuchen:

- Ganzheitliches Verständnis aller Cloud-Kosten

- Zentralisierte Kostenkontrolle

- Identifikation und Entfernung von Zombie-Ressourcen

- Richtige Dimensionierung von Cloud-Ressourcen

- Nutzung des richtigen Kostenmodells je nach Anwendungsfall

1. Ganzheitliches Verständnis aller Cloud-Kosten

Die Cloud-Kosten beziehen sich nicht nur auf die Infrastrukturkosten der genutzten Ressourcen. Beispielsweise entstehen beim Herunterladen von Daten aus der Cloud versteckte Kosten. Grundsätzlich sind die Spielregeln in der Cloud so, dass alle in der Cloud verarbeiteten Daten um ein Vielfaches günstiger sind als die Daten, die zur weiteren Bearbeitung wieder aus der Cloud herausholt werden. Die unterschiedlichen Kosten eines Datentransfers innerhalb der Cloud (Ingress) im Vergleich zum Datentransfer aus der Cloud heraus (Egress) muss bereits im Architekturdesign berücksichtigt werden. Auch wenn die Kostenunterschiede zunächst minimal erscheinen, multiplizieren sie sich durch die Skalierung der Cloud und erreichen schon bald eine empfindliche Grenze.

Ein ebenfalls unterschätzter Faktor ist die richtige Zuordnung von individuellen Service-Leveln auf die jeweiligen Anwendungsfälle. Anstelle eines einheitlichen Modells zur Datenredundanz (Data Redundancy) empfiehlt es sich, jeden Anwendungsfall einzeln abzuwägen und dabei das volle SLA-Spektrum der Cloud Service Provider (CSP) zu nutzen. Allein mit solchen SLA-Optimierungen lassen sich die monatlichen Speicherkosten schnell um 15 Prozent senken.

Eine weitere Chance besteht in der Optimierung interner Kostenstrukturen, die etwa die Cloud-Provisionierung oder Service-Desk-Aufwendungen betreffen. Oft tauchen die internen Leistungen nicht gleich in der Betrachtung der direkten Cloud-Kosten, sondern erst später in den gesamten IT-Betriebskosten auf. Dadurch entsteht ein verzerrtes und verzögertes Bild aller IT-Aufwendungen. Ein sauber koordinierter Informationsaustausch zwischen den Bereichen Betrieb, Architektur, Software-Entwicklung und Finanzen über zukünftige Kapazitätsbedarfe sowie über aktuell anfallende Betriebskosten der Cloud, ist ein guter Startpunkt, um ein ganzheitliches Verständnis zu erreichen.

2. Zentralisierte Kostenkontrolle

Wer die Angebote von Cloud Service Providers (CSPs) vergleichen will, braucht volle Kostentransparenz und muss zudem Kostentreiber in den eigenen Umgebungen identifizieren. Voraussetzung hierfür sind Metriken wie:

- Ist- vs. Sollkosten bei Anwendungen,

- Prozentsatz der Gesamtbetriebskosten oder

- Anwendungen sortieren nach Kosten.

Lediglich durch eine kontinuierliche Überwachung und Anpassung solche rund anderer Metriken ist es möglich die notwendige Transparenz über Cloud-Kosten zu gewährleisten. Die Standard-Dashboards der CSPs sind hierfür ein hilfreicher Startpunkt, aber oft reichen sie nicht aus, weil sie die Komplexität der eigenen IT-System- und Prozesslandschaft nur unzureichend widerspiegeln. Insbesondere in einem Multi-Cloud-Kontext sollten Unternehmen daher auf CSP-unabhängige Tools für die zentralisierten Kostenkontrolle setzen.

Ein wichtiger Aspekt dabei, egal ob eine Single- oder eine Multi-Cloud-Umgebung angestrebt wird, ist ein klarer Tagging-Prozess. Hierbei werden Cloud-Ressourcen anhand ihrer Anwendungsfälle und ihrer technischen Spezifikationen klassifiziert. Die richtige Granularität zu erreichen, ist ein wesentlicher Faktor, um Transparenz über den jeweiligen Einsatz, Status sowie über Abhängigkeiten der Cloud-Ressourcen zu erlangen.

Eine solche Einzelbetrachtung ist ein wichtiger Baustein, um Cloud-Kostenelemente zu analysieren und mit anderen IT-Kostenmetriken in Zusammenhang zu bringen. Hierbei kommt das Cloud-Kostenmanagement mit anderen IT-Governance-Themen in Berührung.

3. Identifikation und Entfernung von Zombie-Ressourcen

Nicht genutzte Cloud-Ressourcen, sogenannte Zombie-Ressourcen, können zu unnötigen und langlebigen Kostentreibern werden. Insbesondere Entwicklungsumgebungen sind prädestiniert dafür aufgebaut, nach ihrer Nutzung aber nicht mehr zurückgebaut zu werden. Hier wird dann täglich Geld aus dem Fenster geworfen. Bereits bei der Provisionierung gilt es, ökonomisches Bewusstsein für die Nutzung von Cloud-Ressourcen zu etablieren. Dadurch kann ein Großteil unnötiger Mehrausgaben proaktiv verhindert werden. Im Übrigen geben auch die CSPs Werkzeuge an die Hand, um unnötig gebuchte Ressourcen zu identifizieren und Folgemaßnahmen anzustoßen.

CSPs stellen mittlerweile Standard-Skripts bereit, die es ermöglichen, die eigene Cloud-Umgebung zu analysieren und das Nutzungsverhalten einzelner Ressourcen sichtbar zu machen. Cloud-Verantwortliche sollten jedoch darauf achten, die jeweiligen Skripts auf die individuellen Gegebenheiten der eigenen Cloud-Umgebung anzupassen. Diese Anpassungen sollten sich auf Parameter beziehen wie zum Beispiel

- Nutzungsverhalten innerhalb und außerhalb von Geschäftszeiten,

- Anzahl angebundener und nicht genutzter Pipelines,

- unnötige Lizenzen und Berechtigungen sowie

- tägliche, wöchentliche und monatliche Zugriffe.

Durch solche individualisierten Skripts und die richtigen Parameter lässt sich sicherstellen, dass individuelle Anwendungsfälle überwacht werden und die Analyseergebnisse einen tatsächlichen Mehrwert bringen. Diese Aufgabe kann entweder zentral durch ein Cloud Center of Excellence übernommen oder in einer End-to-End-Verantwortung den jeweiligen Produkt-Teams zugeschrieben werden.

4. Richtige Dimensionierung von Cloud-Ressourcen

Neben Zombie-Ressourcen treten häufig falsch provisionierte und bemessene Cloud-Ressourcen auf. Dabei werden Rechen- und Speicherkapazitäten bereitgestellt, die für den geforderten Anwendungsfall zu groß sind oder in dem Ausmaß nur in Stoßzeiten benötigt werden. Anstelle einer dynamischen und bedarfsgerechten Bereitstellung wird die Spitzenlast als durchgängiger Leistungsparameter definiert und dann auch über die gesamte Zeit bezahlt. Vor allem das Autoscaling – das automatisierte Anpassen der Kernkomponenten von Cloud-Ressourcen wie Compute, Storage, Networking etc. – ist ein wichtiger Standard in der Cloud und sollte weitflächig und möglichst oft genutzt werden.

Insbesondere der Storage-Bereich bietet Potenzial, kaum genutzte Daten können problemlos und automatisiert in jeweils kostengünstigere Speichertypen transferiert werden. Viel zu oft lagern kaum genutzte Daten in hochperformanten und dadurch teuren „Hot-Storage“-Speicherklassen. Dabei wäre ein Wechsel in Cold-Storage-Speicherklassen meist schnell möglich und ohne gravierenden Einfluss auf den Endnutzer umsetzbar.

5. Nutzung des richtigen Kostenmodells je nach Anwendungsfall

CSPs bieten Kostenmodelle wie zum Beispiel Spot, On-demand oder Reserved Instances für unterschiedliche Szenarien an. Ein großer Hebel für die Kostensenkung liegt im Ausarbeiten individueller Kostenmodelle je nach Anwendungsfall. Das ist viel besser, als eine Pauschallösung für das gesamte Unternehmen zu adaptieren.

Darüber hinaus gilt es, ein umfassendes Anforderungsmanagement für Cloud-Ressourcen zu etablieren. Durch transparente Planung lässt sich vermeiden, dass überproportional viele On-Demand Ressourcen aus der Cloud bezogen werden. Viele Kunden haben die Sorge, dass am Jahresende reservierte Instanzen bezahlt werden müssen, die gar nicht benötigt wurden. Durch ein inkrementelles Herantasten an die finale Zielgröße für reservierte Instanzen, beginnend mit zirka 60 Prozent der jährlichen Durchschnittslast, lässt sich eine zu starke Verbindlichkeit gegenüber einem bestimmten CSP vermeiden.

Generell empfiehlt es sich hier, eigene Erfahrungen zu sammeln, auch auf das Wissen anderer zuzugreifen und das Vorgehen in regelmäßigen Abständen zu validieren. Das Identifizieren eines geeigneten Kostenmodells ist eine individuelle und praxisnahe Arbeit, die stark vom jeweiligen Cloud-Szenario abhängt. Es ist ein Unterschied, ob eine E-Commerce-Plattform betrieben oder ein SAP-System gehostet wird. Die Lösung dieser Aufgabe sollte von industrieübergreifenden und datengetriebenen Best Practices unterstützt werden.

Cloud-Kostenmanagement verankern

Erste Erfolge beim Optimieren der Cloud-Kosten lassen meist nicht lange auf sich warten, dennoch sollte eine nachhaltige Verankerung des Cloud-Kostenmanagements in der Organisation angestrebt werden. Nur so lässt sich sicherstellen, dass die Cloud-Kosten transparent bleiben und Kostentreiber früh identifiziert werden.

Je nach Umfang der zu verwaltenden Cloud-Umgebungen kann es sinnvoll sein, die Funktion eines Cloud Cost Officer zu etablieren, der das Thema nicht ausschnitthaft, wie die verantwortlichen Produkt-Teams, sondern als konzernweite Schnittstellenfunktion ganzheitlich betrachtet. Unabhängig von den Governance-Strukturen ist es aber in jedem Fall sinnvoll, alle Mitarbeiter dafür zu sensibilisieren. Dabei können Trainingsinitiativen und sinnvolle Anreize helfen. Ein Cloud Center of Excellence oder eben ein Cloud-Cost-Officer muss hierbei unterstützen. Ein vom CIO unterstütztes und über alle Organisationseinheiten hinweg greifendes Kostenmanagement ist kritisch für den Erfolg der digitalen Transformation von Unternehmen.

Reagieren CIOs hier zu spät oder gar nicht, können ihnen die Kosten davonlaufen und sie werden unglaubwürdig, Skaleneffekte lassen sich kaum noch realisieren. Die Cloud wird in den kommenden Jahren der zentrale Treiber der Digitalisierung sein, darauf sollten sich Unternehmen kostenseitig vorbereiten.

*Christian Rose ist Geschäftsführer und Partner bei Ginkgo Management Consulting.

Be the first to comment