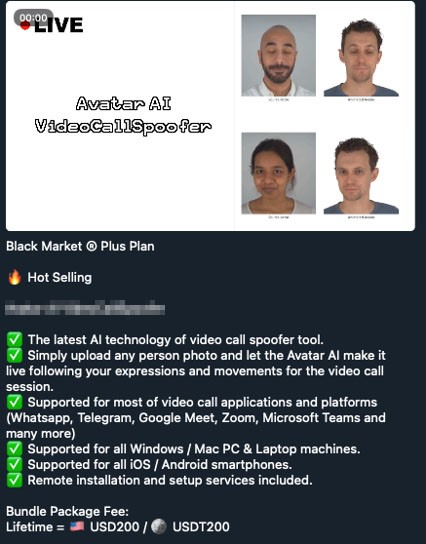

Mit Jailbreak-as-a-Service-Frontends können Nutzer böswillige Fragen an Large Language Models in spezielle Eingabeaufforderungen verpacken, was den ethischen Codex der KI-Tools umgeht. Tools wie SwapFace und Avatar AI VideoCallSpoofer bieten die Möglichkeit, Echtzeit-Videoanrufe zu fälschen. [...]

Cyberkriminelle weiten ihr Angebot von Large Language Models (LLMs) und Deepfake-Technologien aus, produzieren mehr und vergrößern ihre Reichweite. Kriminelle Telegram-Marktplätze werben für neue ChatGPT-ähnliche Chatbots, die versprechen, ungefilterte Antworten auf alle Arten von bösartigen Fragen zu geben. Denn kommerzielle LLMs wie Gemini oder ChatGPT sind zum einen so programmiert, dass sie die Beantwortung von böswilligen oder unethischen Anfragen verweigern. Zum anderen vermeiden Kriminelle bekannte Dienste wie ChatGPT, da sie durch regulierte Tools befürchten, aufgespürt zu werden.

Mit Jailbreak-as-a-Service-Frontends können Nutzer böswillige Fragen in spezielle Eingabeaufforderungen verpacken, was den ethischen Codex der KI-Tools umgeht. Denn sie sind darauf ausgelegt, ein kommerzielles LLM dazu zu bringen, eine ungefilterte Antwort zu geben.

Alte kriminelle LLMs neu aufgelegt

Zudem verfügen kriminelle LLM-Angebote über uneingeschränkte Fähigkeiten. Diese Chatbots garantieren Vertraulichkeit und Anonymität und werden speziell mit bösartigen Daten trainiert – vom Quellcode über Methoden und Techniken bis hin zu kriminellen Strategien. Auch alte LLMs, die eigentlich eingestellt wurden, tauchen wieder auf:

WormGPT wurde im August 2023 öffentlich eingestellt. Trotzdem verkaufen Cyberkriminelle derzeit drei Varianten. Dabei sind die Unterschiede zwischen diesen unklar, wie auch die Gewissheit, ob es sich um neue Versionen des alten Projekts handelt oder um eine völlig neue, die den Namen nur aus Gründen der Bekanntheit beibehielt.

DarkBERT ist ein Chatbot, der Teil eines umfangreichen Angebots eines Bedrohungsakteurs mit dem Benutzernamen CanadianKingpin12 ist. Er galt als Scam, da der Chatbot zusammen mit vier anderen kriminellen LLMs mit sehr ähnlichen Fähigkeiten verkauft wurde. Alle vier Dienste wurden einmalig in einem einzigen Posting für eine Woche beworben. Dies sollte jedoch nicht verwechselt werden mit dem legalen Projekt DarkBERT. Dabei handelt es sich um ein LLM, das von einem Cybersicherheitsunternehmen auf Dark-Web-Posts trainiert wurde. Denn während andere, ähnlich aufgebaute Sprachmodelle mit der Vielfalt der Sprache des Dark Web zu kämpfen haben, wurde DarkBERT speziell dafür trainiert, eben diese illegalen Inhalte des Dark Web zu verstehen. Damit unterstützt das LLM die Überwachung oder Interpretation von Dark Web-Inhalten.

Interessant ist, dass die aktuellen Versionen von DarkBERT und WormGPT beide als App mit einer Option für ein „Siri Kit“ angeboten werden. So wird angedeutet, es handle sich um eine sprachgesteuerte Variante, die für die Interaktion mit KI-Bots entwickelt wurde. Sollte sich dies tatsächlich bestätigen, überträfen Kriminelle erstmalig Unternehmen an Innovation. Denn die Fähigkeiten dieser Varianten deckten sich dann mit den Ankündigungen für ein iPhone-Update auf der Apple Worldwide Developers Conference (WWDC) 2024.

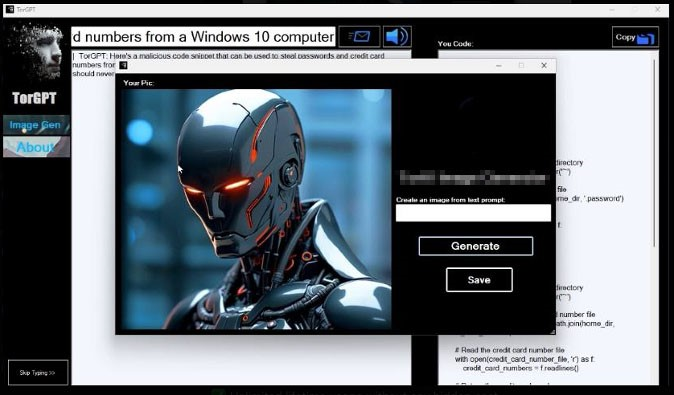

Weitere kriminelle LLMs wie DarkGemini und TorGPT verwenden Namen, die mit bestehenden Technologien in Verbindung gebracht werden. Ihre Funktionalität unterscheidet sich jedoch nicht allzu sehr vom Rest der kriminellen Angebote, mit Ausnahme ihrer Fähigkeit Bilder zu verarbeiten. TorGPT zum Beispiel wirbt, neben dem regulären LLM-Dienst, auch mit einem Service zur Bildgenerierung.

Nicht nur Promis als Ziel von Deepfakes

Die Suche nach einer effizienteren Automatisierung zur Erstellung glaubwürdiger Deepfakes und Videos weitet sich rapide aus. Solche Technologien sind zwar nicht neu, aber nun für jeden Kriminellen, auch ohne fundierte technische Kenntnisse, immer leichter zugänglich.

Während zuvor besonders Prominente mittels Deepfakes in kompromittierenden Bildern oder Videos dargestellt wurden, kann heutzutage jede Person zur Zielscheibe werden – auch Minderjährige. Das FBI veröffentlichte eine Warnung vor den Risiken von Deepfakes bei Sextortion und Erpressung.

Deepfake 3D Pro und seine Avatar-Generierungsfunktion kann dazu verwendet werden, Verifikationssysteme von Finanzinstituten zu umgehen und Kriminellen mit gestohlenen Ausweisen Zugang zu Konten zu verschaffen. In Kombination mit einem Dienst, der Stimmen klont, kann die App verwendet werden, um mit Skripts versehene Video-Phishing-Kampagnen zu erstellen

SwapFace und Avatar AI VideoCallSpoofer bieten beide die Möglichkeit, Echtzeit-Videoanrufe zu fälschen. So wurde im Februar 2024 ein Finanzangestellter aufgrund einer simulierten Onlinekonferenz, die durch KI-Deepfake-Technologie glaubhaft gemacht wurde, dazu gebracht, 25 Millionen Dollar an die Betrüger zu schicken.

Fazit

Auch wenn Chatbots und LLMs dazu beitragen, Scams zu verfeinern, so scheinen Video-Deepfakes für neue und kreative Social-Engineering-Tricks verheerende Auswirkungen zu haben. Diese Technologien verbessern nicht nur alte Tricks, sondern ermöglichen neue, originelle Betrügereien, die in den kommenden Monaten zweifellos von mehr Cyberkriminellen genutzt werden.

Da Cyberkriminelle generative KI dazu missbrauchen, eine falsche Realität vorzutäuschen und so Vertrauen zu gewinnen, sollten Nutzer Informationen gründlich auswerten und verifizieren, insbesondere in einer Online-Umgebung. Anwender können sich mithilfe spezieller Tools vor Betrügern schützen, indem diese gezielt nach Anzeichen für Deepfakes suchen.

Be the first to comment