Das Bauchgefühl von Managern wird im digitalen Zeitalter immer unwichtiger. Stattdessen sind es Daten und daraus abgeleitete Erkenntnisse (Insights) und Handlungsempfehlungen, die als Grundlage von Entscheidungen herangezogen werden. [...]

Das gilt nicht nur für Unternehmen, sondern auch für staatliche Einrichtungen und Organisationen. Welche Reibungsverluste im öffentlichen Bereich entstehen können, zeigt exemplarisch die Covid-19-Pandemie. In Fachmedien wie der „Ärztezeitung“ ist von einem „Corona-Blindflug“ die Rede. Mangelhaftes Datenmanagement und unzureichende Analysetechniken hätten dazu geführt, dass Einschränkungen für Bürger und Unternehmen beschlossen wurden, ohne dass eine geeignete Datengrundlage vorlag.

Gegen solche Unzulänglichkeiten sind auch Unternehmen nicht gefeit, die seit vielen Jahren Business-Intelligence-Tools und ERP-Software einsetzen. Ein Problem besteht darin, dass sich ein Wildwuchs entwickelt hat, wie Mathias Golombek feststellt, Chief Technology Officer und Mitglied des Vorstands der Exasol AG. „Silos“ erschwerten eine übergreifende Nutzung von Daten. „Doch nicht nur zu viele verschiedene Plattformen, sondern auch Herrschaftswissen verhindert häufig, dass Unternehmen das Potenzial von Big Data und Data Analytics ausschöpfen“, so Golombek weiter.

Bereiche zusammenbringen

Eine Ausprägung dieses „Herrschaftswissens“ ist, dass Unternehmen eine Vielzahl von Tools für einzelne Nutzergruppen implementieren. „Es ist in Unternehmen ein weitverbreitetes Problem, die verschiedenen Personae unter den Nutzern, vom Fachbereichsexperten bis hin zum ‚Data Hunter‘, auf einen gemeinsamen Nenner zu bringen“, bestätigt Andreas Becks, Senior Manager Customer Advisory, Artificial Intelligence bei SAS. Hinzu kommen Produktivitätsengpässe, die ein schnelles Erstellen von Modellen für eine Datenanalyse erschweren. Das gilt beispielsweise für Modelle, bei denen Künstliche Intelligenz (KI) und maschinelles Lernen (ML) eingesetzt werden.

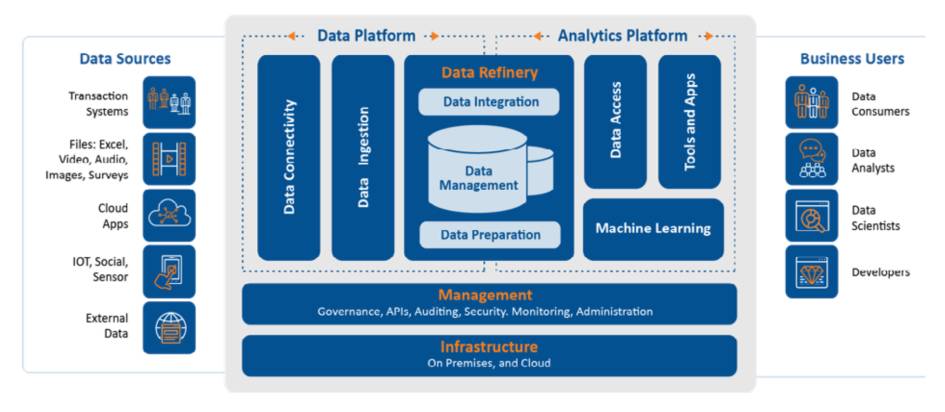

Als Ausweg propagieren die Anbieter von Unternehmens-Software und von Lösungen für Datenmanagement und -analyse einen integrativen Ansatz: „Es geht darum, eine leicht beherrschbare Plattform zu nutzen, die es erlaubt, Daten anzubinden, zu verwalten, zu kuratieren und ihre Qualität sicherzustellen“, betont Stephan Schnieber, Sales Leader IBM Cloud Pak for Data bei IBM. Eine solche Plattform sollte den Nutzern außerdem die Möglichkeit geben, Analytics– und KI-Modelle zu erstellen, zu katalogisieren, in Produktion zu bringen und zu pflegen.

Es gilt also, Informationsbestände aus unterschiedlichen Domänen und Unternehmensbereichen in einer zentralen Datenquelle zusammenzufassen, die für Analysen zur Verfügung steht. „Es handelt sich dabei nicht um einen komplett neuen Ansatz“, betont Teemu Kinnunen, Lead Data Scientist bei der Digitalagentur Futurice. „Aber er hat in jüngster Zeit an Bedeutung gewonnen, vor allem wegen der Diversität der Daten und der Komplexität der Daten-Pipelines.“

„Unified Analytics geht weit über Business Intelligence hinaus“

EMEA & APJ, Tibco Software

(c) Tibco

Unternehmen, die allein auf Business-Intelligence-Software setzen, werden im datenorientierten Zeitalter das Nachsehen haben, so Erich Gerber, Senior Vice President EMEA & APJ bei Tibco Software. Gefordert seien vielmehr Unified- oder Hyperconverged-Analytics-Plattformen, mit denen Manager dank Künstlicher Intelligenz und Machine Learning Entwicklungen abschätzen können.

com! professional: Herr Gerber, welche Problempunkte wollen Nutzer mithilfe von Unified-Analytics- beziehungsweise Hyperconverged-Analytics-Plattformen beseitigen?

Erich Gerber: Ein Punkt ist, dass derzeit separate Plattformen für Analysezwecke und Datenmanagement im Einsatz sind. Ein weiterer, dass sich Datensilos gebildet haben, die übergreifende Analysen erschweren. Die Antwort darauf ist der Ansatz Hyperconverged Analytics für Analytics, Data Science und Streaming – und zwar über Daten- und Analytics-spezifische Rollen hinweg. Er ermöglicht die Anbindung an Echtzeitdatenströme und damit geschäftsrelevante Erkenntnisse, die schnelle Reaktionen erfordern. Aus Sicht von Anwendern geht dies weit über die Möglichkeiten traditioneller Ansätze wie Business Intelligence hinaus.

com! professional: Welche Hauptbestandteile sollte eine solche Analytics-Lösung umfassen?

Gerber: Ich möchte drei Punkte hervorheben: Visual Analytics, Data Science und Streaming Analytics. Visual Analytics ermöglichen allen Anwendern KI-gestützte und suchgesteuerte Einblicke für eine bessere Entscheidungsfindung. Das erfolgt in Verbindung mit einer intelligenten Datenerkennung, Geodatenanalyse und prädiktiver Analyse mit einem Klick. Anders ausgedrückt: Damit „demokratisieren“ Unternehmen Erkenntnisse mittels maßgeschneiderter Analyse-Apps. Mit Data Science wiederum können Unternehmen auf Knopfdruck einen Wettbewerbsvorteil erzielen. Das erfolgt mithilfe von Ein-Klick-Klassifizierungs-, Clustering- und Prognose-Methoden. Sie können Modelle erstellen, überwachen und trainieren, und dies bei voller Kontrolle über die Modelle und Daten, Stichwort Governance.

com! professional: Und was hat es mit Streaming Analytics auf sich?

Gerber: Hier ist die Integration von Streaming-Analysefunktionen zu nennen, um „immersive“ visuelle Analysen von Echtzeitdaten neben historischen Daten bereitzustellen. Organisationen können Aktionen und Warnungen mit prädiktiven Modellen auf Live-Daten automatisieren. Und sie haben die Möglichkeit, mithilfe einer visuellen Entwicklungsumgebung Streaming-Anwendungen schnell zu erstellen und einzusetzen.

com! professional: Welche Hauptvorteile bringen integrierte Analytics-Plattformen den Nutzern?

Gerber: Data Science ist immer Teamarbeit: Data Scientists und Citizen Data Scientists, Dateningenieure, Geschäftsanwender und Entwickler benötigen flexible und erweiterbare Tools, die die Zusammenarbeit,

Automatisierung und Wiederverwendung von analytischen Workflows fördern. Algorithmen sind jedoch nur ein Teil von Analyselösungen. Um vorausschauende Erkenntnisse liefern zu können, müssen sich Unternehmen daher immer stärker auf die Bereitstellung, Verwaltung und Überwachung von Analysemodellen konzentrieren.

Abhilfe schaffen hier Plattformen, die den gesamten Analyselebenszyklus unterstützen und gleichzeitig Unternehmenssicherheit und Governance bieten. Die Unternehmen können so mit nur einer Plattform den Großteil ihrer Analytics-Aufgaben erledigen. Ein weiterer Vorteil ist, dass sie schnellere und präzisere Insights erzielen, etwa dank Künstlicher Intelligenz und maschinellem Lernen. KI und ML sind längst mehr als nur ein großes Hype-Thema. Die Anwendungsfälle sind vielfältig. Man denke nur an dynamische Preisgestaltungsmodelle oder an „digitale Zwillinge“ in der Fertigung.

com! professional: Welche Herausforderungen sind mit Unified Analytics verbunden?

Gerber: Hier ist zum einen die Notwendigkeit zu nennen, Daten zusammenzuführen, bevor diese Daten auf einer zentralen Plattform analysiert werden können. Dabei handelt es sich um Daten, die aus unterschiedlichen Quellen stammen beziehungsweise in unterschiedlichen Formaten vorliegen.

Zum anderen scheitern derzeit die meisten Projekte, wenn die entwickelten Modelle in einem operativen Umfeld eingesetzt werden sollen. Mit Tibco Streaming helfen wir unseren Kunden, Machine-Learning-Modelle auf einfache Weise mit Echtzeitdaten zu verbinden.

com! professional: Sie haben mehrfach Künstliche Intelligenz und maschinelles Lernen angesprochen. Welche Rolle spielen diese Technologien bei Unified Data Analytics?

Gerber: Kurz gesagt: KI und ML sind integrale Bestandteile der Plattform. Bei Data Science handelt es sich um einen multidisziplinären Ansatz, um Muster mithilfe einer Kombination aus Analysemethoden, Fachwissen und Technologien zu finden, zu extrahieren und zu nutzen. Dazu zählen Künstliche Intelligenz und maschinelles Lernen ebenso wie beispielsweise Data Mining, Deep Learning und prädiktive Analysen.

com! professional: Inwieweit vertrauen Menschen, also User, den Ergebnissen solcher Analytics-Lösungen? Vor allem dann, wenn diese Handlungsvorschläge unterbreiten?

Gerber: Sie sprechen ein wichtiges Thema an. Und hier liegt, wenn man so will, tatsächlich „einer der Hunde begraben“. Ein Beispiel: Das Video-Interview eines japanischen Schachgroßmeisters auf einem Kanal für Schach-Interessierte wurde im Jahr 2020 plötzlich unterbrochen. Anschließend war der Kanal für knapp 24 Stunden nicht erreichbar. Auslöser waren offenbar Vorwürfe wegen „Hate Speech“, ausgelöst durch einen Verweis auf „Schwarz gegen Weiß“ – im Kontext des Schachspiels wohlgemerkt. Es gibt natürlich auch positive Beispiele: Wir haben viele Kunden, die auf eine Analytics-Lösung von Tibco setzen, unter anderem Siemens Mobility. Dessen Kunden konnten dadurch die ungeplanten Ausfallzeiten ihrer Züge um 30 bis 50 Prozent senken.

Begriffs-Wirrwarr

Darüber, welchen Namen ein solcher integrativer Ansatz haben soll, herrscht allerdings Uneinigkeit. Ein Teil der Anbieter solcher Lösungen führt „Unified Analytics“ ins Feld, ein anderer „Unified Data Analytics“ (UDA), um die Rolle des Datenmanagements zu unterstreichen. SAS wiederum favorisiert „Unifying Analytics“. Dies soll klarmachen, dass nicht nur technische Komponenten unter einen Hut gebracht werden müssen. „Genauso wichtig ist es, die unterschiedlichen Kompetenzen im Unternehmen zusammenzubringen: Data Scientists, Experten aus den Fachbereichen und die IT“, unterstreicht Andreas Becks von SAS.

Tibco, laut dem Analystenhaus Gartner einer der führenden Anbieter von integrierten Analytics-Lösungen, bezeichnet seinen Ansatz als „Hyperconverged Analytics“. Die Plattform des Unternehmens kombiniert visuelle Analysen mit Data-Science- und Streaming-Funktionen. Exasol wiederum stellt seine Datenbanklösung in den Mittelpunkt von Unified (Data) Analytics. „Damit können Anwender alle Informationen aus einer Datenzugriffsschicht ziehen und analysieren. Dadurch werden Datensilos beseitigt“, verdeutlicht Mathias Golombek. Fachleute erhalten auf diese Weise eine einheitliche Sicht auf Informationen und datenbasierte Prozesse.

Empfehlungen von der KI-Instanz

Ein Ziel von Unified Data Analytics besteht darin, den Nutzern Insights an die Hand zu geben, mit denen sie Geschäftsprozesse und die Beziehung zu Kunden optimieren. „Es geht darum, immer zielgenauere Entscheidungshilfen zu erhalten“, sagt Peter van der Putten, Director Decisioning & AI Solutions bei Pegasystems. Das amerikanische Software-Haus konzentriert sich auf Lösungen für das Kundenbeziehungsmanagement und die Optimierung von Prozessen. „Daraus resultieren konkrete Einzelfallempfehlungen für sogenannte Next Best Actions für den Vertrieb, das Marketing oder den Kundendienst.“

Das heißt, Unified Data Analytics beschränkt sich nicht darauf, den Istzustand von Geschäftsaktivitäten oder mögliche Entwicklungen (Trends) aufzulisten. Vielmehr macht ein Großteil der Lösungen Vorschläge, wie sich Abläufe und Business-Strategien verbessern lassen. Damit weist die integrierte Datenanalyse Elemente auf, die aus dem Bereich Prescriptive Analytics stammen. Dieses Verfahren stellt Nutzern ebenfalls Handlungsempfehlungen zur Verfügung und setzt diese auf Wunsch automatisch um.

Von Business Intelligence bis Hyperconverged Analytics

Der Bereich Analytics teilt sich in viele Untersegmente auf. Hier ein Überblick über die wichtigsten Spielarten.

Bei Descriptive Analytics wird im Wesentlichen dargestellt, was passiert (oder passiert ist) und warum. Der Großteil dessen, was Organisationen heute unter Business Intelligence einordnen, ist das Visualisieren von Daten. Auch das fällt fast ganz in den Bereich deskriptiver Analyseverfahren.

Einen Schritt weiter geht Predictive Analytics. Dieser Ansatz identifiziert anhand wiederkehrender Vorgänge (Events) Muster. Auf deren Grundlage wird die Wahrscheinlichkeit ermittelt, dass ein bestimmtes Ereignis eintritt. „Was geschieht als Nächstes?“ Dieser Teil von Analytics nutzt Verfahren aus dem Bereich Data Science und Machine Learning. Durch die Aktualisierung der Daten, mit denen Muster ermittelt beziehungsweise Modelle trainiert werden, passen sich diese an veränderte Umstände an. Moderne Werkzeuge automatisieren diesen Zyklus: Daten bereitstellen, Daten aufbereiten, Modelle trainieren und validieren. Predictive Analytics gibt Fachleuten und Führungskräften Hinweise, welche Entwicklungen eintreten können.

Wenn man auf schnell wechselnde Marktentwicklungen oder Cyberangriffe unverzüglich reagieren muss, kommt Prescriptive Analytics ins Spiel. Auch diese Analyseform setzt Daten und deren Analyse in Prognosen um. Im Gegensatz zu Predictive Analytics geben präskriptive Analyse-Tools aber Handlungsempfehlungen. Diese Empfehlungen können Prescriptive-Analytics-Lösungen automatisch umsetzen.

Weitere Analytics-Spielarten stammen von Anbietern – etwa Hyperconverged Analytics von Tibco. Dieser Ansatz fasst visuelle Analysen, Data Science und Streaming-Funktionen in einer Plattform mit einer einheitlichen Benutzeroberfläche zusammen. Damit können Anwender Erkenntnisse aus historischen Daten gewinnen und grafisch darstellen. Mit Data Science (Advanced Analytics) lassen sich Maschinenlernmodelle trainieren und Aussagen über Ereignisse treffen, die in der Zukunft passieren. Mit Streaming können die Machine-Learning-Modelle oder Regeln mit Echtzeitdaten versorgt und operationalisiert werden, um automatisch Aktionen auszulösen.

Databricks, ein Anbieter von Lösungen für ein Datenmanagement und die Datenanalyse mithilfe von Künstlicher Intelligenz, forciert den Begriff Unified Data Analytics. Entsprechende Lösungen setzen in starkem Maß auf KI, um Daten-Pipelines aufzubauen, die Informationen aus diversen Datensilos miteinbeziehen.

Einen weiteren Schwerpunkt bilden Tools, die die Zusammenarbeit von Datenwissenschaftlern (Data Scientists) und Datennutzern vereinfachen. Die Datenanalyse- und Business-Intelligence-Funktionen stammen von Drittanbietern wie Microsoft und Tableau.

Eine Automatisierung von Prozessen stößt jedoch bei etlichen Anwendern noch auf Skepsis. Der Grund: die Angst davor, die Kontrolle über Entscheidungen und Abläufe zu verlieren. Doch letztlich dürfte an der Kombination von Prescriptive Analytics und Automatisierung in vielen Bereichen kein Weg vorbeiführen. Ein Beispiel sind IT-Sicherheitssysteme, die bereits beim ersten Anzeichen einer Cyberattacke Gegenmaßnahmen ergreifen und dadurch Schäden minimieren.

Auch in Handel und Fertigung gewinnen fortgeschrittene Datenanalysemodelle mit autonomen Maßnahmen an Bedeutung. Das ist etwa bei der dynamischen Anpassung von Preisen (Dynamic Pricing) der Fall. „Heute möchten Unternehmen Entscheidungsprozesse vollautomatisch innerhalb von Sekunden treffen, um das Geschäftsmodell zu optimieren, Risiken einzuschätzen oder die Beziehung zu Kunden zu personalisieren“, sagt Mathias Golombek von Exasol.

Die Zentrale Rolle von KI

Damit sich aus den wachsenden Datenbeständen verwertbare Erkenntnisse und Handlungsempfehlungen extrahieren lassen, und dies am besten in Echtzeit, sind zwei Technologien unverzichtbar: KI und maschinelles Lernen. „Bei Unified Data and Analytics geht es um das Zusammenspiel von Daten und KI. Beide sind gleich wichtig. Denn Daten ohne nachgelagerte Nutzung bringen keine Vorteile, und KI ohne Daten ist nicht möglich“, betont Stephan Schnieber von IBM. Deshalb hat IBM bei seiner Unified-Data-Analytics-Plattform Cloud Pak for Data Daten und KI-Modelle in einem Katalog zusammengefasst. Er enthält zudem die relevanten Metadaten. Data Engineers und Datenwissenschaftler können auf diese Informationen zugreifen – mit den Tools, die sie für ihre Aufgabe benötigen.

Auch die Plattformen anderer Anbieter, etwa Tibco, Databricks, Thoughtspot oder Oracle, verfügen über KI- und Machine-Learning-Funktionen. SAS stellt bei seiner Viya Platform „eine umfassende Bibliothek mit Machine-Learning-Verfahren“ bereit, so Andreas Becks. Datenbankspezialisten wie Exasol haben wiederum Schnittstellen für Data-Science-Anwendungen und KI-/ML-Bibliotheken integriert, etwa Tensorflow und R.

KI und Machine Learning werden laut Pegasystems im Rahmen von Unified Data Analytics etwa dafür verwendet, um Fragen zu beantworten wie „Welcher Servicefall könnte als nächster auftreten und wie lässt er sich lösen?“ oder „Welche Service Level Agreements sind dabei zu beachten?“. Das erfordert Machine-Learning-Modelle, die eine Analytics-Plattform mithilfe von Künstlicher Intelligenz in Echtzeit erzeugt. Ein Nebeneffekt: Die Aufgabe von Data Scientists ändert sich: „Sie erstellen die Modelle nicht mehr selbst, sondern kontrollieren und optimieren die automatisch generierten Modelle“, erläutert Peter van der Putten.

Technik und Mensch in Einklang

Allerdings ist auch bei Unified Data Analytics noch Raum für Verbesserungen, so van der Putten. Zwar sei die Kombination von Datenmanagement, Analysefunktionen und Machine Learning auf einer einzigen Plattform der richtige Schritt, aber nur ein Etappenziel. „Derzeit liegt der inhaltliche Schwerpunkt von Unified Data Analytics auf der Entwicklung von Vorhersagemodellen, also Predictive Models, aber zu wenig auf deren Bereitstellung, dem Management und dem Monitoring“, erläutert der Fachmann. Es reicht seiner Ansicht nach nicht aus, Daten immer besser analysieren zu können. „Analysen sind kein Selbstzweck. Man muss die Erkenntnisse daraus praktikabel machen und in die internen operativen Prozesse und die Interaktion mit den Kunden einfließen lassen.“

Damit sich solche Konzepte umsetzen lassen, muss jedoch nicht nur der technische Unterbau stimmen. Vielmehr muss man die Mitarbeiter mitnehmen. Das gilt für die Führungskraft wie für den Sachbearbeiter. „Um ein ‚wissensbasiertes‘ Unternehmen aufzubauen, ist es notwendig, zusammen mit den Nutzern entsprechende Services zu entwickeln und zu implementieren“, erläutert Teemu Kinnunen von Futurice. „Und um das zu erreichen, ist es notwendig, Erkenntnisse aus Daten zu gewinnen und dieses Wissen zu nutzen, um bessere Entscheidungen zu treffen.“

Umsetzen lässt sich eine solche Strategie in mehreren Schritten, so Kinnunen. Zunächst ermittelt ein Unternehmen zusammen mit einem Spezialisten, welche Geschäftschancen sich aus der Analyse von Daten und den damit verbundenen Insights ergeben könnten. „Anschließend werden die potenziellen User und deren Anforderungen definiert“, so der Fachmann, „außerdem eine Vorgehensweise, um die Analytics-Lösungen optimal zu nutzen.“ Im dritten Schritt kommen technische Tools zum Zuge, um Daten zu untersuchen und etwa in Predictive-Analytics-Modelle umzusetzen.

Fallstricke vermeiden

Wenn ein Unternehmen die richtige Balance zwischen Technologien, Menschen, Prozessen und Best Practices gefunden hat, dann hat es einen großen Schritt in Richtung einer erfolgreichen Implementierung von Unified Data Analytics getan. Doch es gibt weitere potenzielle Stolpersteine, erläutert Wayne W. Eckerson, Gründer und Präsident des amerikanischen Beratungsunternehmens Eckerson Group in der Studie „The Rise of Unified and Analytic Platforms“.

„Das größte Risiko ist ein Vendor-Lock-in“, so Eckerson. „Unternehmen, die für ihre gesamte Daten- und Analytics-Umgebung die Lösung eines einzelnen Anbieters nutzen, müssen diesem Hersteller ein hohes Maß an Vertrauen entgegenbringen.“ Allerdings nehmen viele Firmen dieses Risiko in Kauf, um Kostenvorteile und kürzere Markteinführungszeiten zu erreichen, so der Fachmann. Weitere mögliche Problempunkte sind die mangelnde Skalierung und die Bindung an spezielle Funktionen und Features, die die Plattform bereitstellt. Zudem sollten Interessenten darauf achten, dass Schnittstellen zu vorhandenen Business-Intelligence-Lösungen, Datenbanken und KI-/Machine-Learning-Programmen vorhanden sind. Sonst kann es leicht passieren, dass sich die Unified-Data-Analytics-Plattform zu einem neuen „Silo“ in der IT-Landschaft entwickelt.

Doch unterm Strich überwiegen bei Weitem die Vorteile von Unified Data Analytics, so Eckerson. Zu den wichtigsten zählen, dass Unternehmen schnell und mit akzeptablem Aufwand Erkenntnisse erhalten, mit deren Hilfe sie umgehend auf veränderte Marktgegebenheiten reagieren und neue Angebote entwickeln können. Diese Faktoren haben gerade durch die Digitalisierung an Bedeutung gewonnen.

Zudem steht Nutzern eine Lösung aus einem Guss zur Verfügung. Das reduziert die Kosten für Betrieb und Wartung, vor allem, wenn die Plattform ein Cloud-Angebot ist. Hinzu kommt, dass – im Idealfall – unterschiedliche Gruppen die Lösung verwenden können, vom Manager bis zu den Mitarbeitern in Fachbereichen oder bei einem Schwesterunternehmen. Das heißt, es lässt sich eine „Demokratisierung“ von Daten und Analysen erreichen. So haben nicht nur elitäre Zirkel im Unternehmen Zugang zu Informationen, sondern alle, die Daten für ihre Arbeit nutzen wollen.

Wichtig für Nutzer im EU-Raum ist, dass eine Plattform Data-Governance-Funktionen bereitstellt. Dadurch lassen sich Datenschutz- und Compliance-Vorgaben erfüllen, etwa die der DSGVO. Data Governance ist außerdem wichtig, damit nur dazu autorisierte Nutzergruppen Zugang zu bestimmten Daten und Analysen erhalten.

| Lösungen im Bereich Unified Data Analytics (Auswahl) | ||

| Anbieter | Lösungen | Details (Auswahl) |

| Amazon Web Services | QuickSight; Kinesis Data Analytics; | Cloudbasierte Analyse-Sservices für BI (QuickSight mit Machine-Learning-Funktionen) und Streaming-Daten (Kinesis Data Analytics); Integration eigener ML-Modelle möglich; |

| Apache Spark | Spark | Engine für Bearbeitung großer Datenbestände; Kombination von SQL-, Streaming- und weiteren komplexen Analysen; Machine-Learning-Modul; Implementierung in Clustern |

| Board | Board Platform | Plattform BI, Analytics und Performance-Management; Identifizierung und Integration von Datenquellen; Planungs- und Simulationsfunktionen; Predictive und Advanced Analytics |

| Cubeware | Cubeware Solutions Platform | Deutscher Anbieter; Analyse-Anwendungen nicht nur für Datenspezialisten; Datenaufbereitung, Governance |

| Databricks | Lakehouse | Integration von Daten, Analysen und KI auf einer Cloud-Plattform; Collaboration-Funktionen für Data Scientists, Data-Engineering- und KI-Fachleute; Entwicklungsumgebungen |

| Domo | Domo Platform | Datenplattform mit KI-basierten Analytics-Funktionen u..a für Risikomanagement, Kundenverhalten, IoT; unterstützt BI- und Visualisierungstools |

| Exasol | Exasol Analytics-Datenbank | In-Memory-Datenbank für Unified-Analytics-Anwendungen; Übersicht über alle Datensilos und datenbezogenen Prozesse; Schnittstellen für KI, ML, BI etc. |

| Google (Looker) | Google Looker | BI- und Analytics-Plattform, Teil der Google Cloud ist; Hosting auf AWS und Multi-Cloud-/Hybrid-Clouds |

| IBM | IBM Cloud Pak for Data | Daten- und KI-Plattform für Cloud-basierte Analytics- und Datenservices; Dienste fürs Erstellen von KI- und ML-Modellen sowie Anbinden und Optimieren von Datenquellen; Entwicklungstools und Branchenlösungen; |

| Incorta | Direct Data Platform | Mapping von Daten aus unterschiedlichen Quellen mittels spezieller Engine; keine Datenmodellierung oder ETL-Jobs erforderlich; Analysen innerhalb weniger als einer Sekunde; Datenmanagement mittels Spark; Machine-Learning-Funktionen; |

| Infor | Infor Birst; Infor CloudSuite; | Cloud-Plattform für Integration von Geschäftsprozessen, Anwendungsentwicklung, Datenstrategie und Datenanalyse |

| Microsoft | Azure Analysis Services; Azure Synapse Analytics; | Cloud-basierter Unified-Analytics-Dienst mit Datenintegration, Data Warehouse und Big-Data-Analysefunktion; Integration von Azure Machine Learning; Echtzeitanalysen |

| Microstrategy | Microstrategy Platform; | „Hyperintelligence“-Analytics- und Business-Intelligence-Plattform; Integration von Analysefunktionen in Anwendungen wie Salesforce, Workday oder Microsoft Office; Anbindung von Datenquellen im Unternehmen und in der Cloud; |

| Oracle | Oracle Analytics Cloud; Oracle Analytics Server | Funktionen für Datenaufbereitung und -integration sowie Metadaten und Visualisierung; Collaboration-Funktionen; machinelles Lernen |

| Pega | Pega Plattform | Unified Data Analytics mit KI- und ML-Funktionen; Branchen- Lösungen etwa für Kundenbeziehungsmanagement |

| Pyramid Analytics | Pyramid v2020 | Augmented-Analytics-Funktionen mit Machine-Learning; Abdeckung des gesamten Lebenszyklus von Daten, hoher Automatisierungsgrad; |

| Qlik | Qlik Platform; Qlik Sense; Qlik View; Qlik Alerting | Plattform für Augmented Analytics mit KI / Machine Learning; SQL-Analytics; Guided Analytics mit Data-Discovery |

| Riverlogic | River Logic Platform | Schwerpunkt Prescriptive Analytics für Lieferketten-Management, Produktions-und Kapazitätsplanung in Industrie und Logistik |

| SAP | SAP Analytics Cloud | Schwerpunkt Geschäftsprozesse und Kundenbeziehungen; Funktionen für BI, Predictive Analytics, Planung, integriertes Datenmanagement |

| SAS | SAS Viya (Erweiterung der SAS-Plattform); SAS Unified Insights MM | SAS Viya kombiniert KI, Analytics, Datenmanagement; Unified Insights MM bietet Self-Service-Funktionen für Data Mining, KI, Maschine Learning; Abdeckung des gesamten Analyse-Lebenszyklus |

| Sisense | Sisense Analytics Plattform | Embedded Analytics-Lösung mit umfassende Funktionen für Datenerfassung, -Aufbereitung und -Analyse; Marktplatz für externe Angebote |

| Tableau | Tableau Plattform | Kooperation mit Databricks bei SQL Analytics; Integration von Salesforce Einstein-Discovery für predictive Analytics; Prognosemodellierung; Datenmanagement über Tableau Data Management; |

| Talend / Stitch Data | Stitch | Unternehmensbereich von Talend; als Cloud-Service verfügbar; Schwerpunkt Integration von Daten aus unterschiedlichen Quellen in Data Warehouse; Analytics-Funktionen über Drittanbieter |

| TCS | Connected Inteligence Platform | Kombination von Data-Engineering- und Data-Science-Funktionen; Echtzeitanalysen; Predictive Analytics; Analyse von Streaming-Daten; Machine Learning für Erstellen von Insights; automatisierte Workflows |

| Teradata | Teradata Vantage | Datenmanagement- und Analytics-Funktionen mit KI und ML; speziell für Hybrid- und Multi-Cloud, aber auch auch On Premises einsetzbar; No-Code-Funktionen |

| Thoughtspot | Thoughtspot Platform | Analytics-Plattform mit einfacher Bedienung, In-Memory-Datenbank und KI-Unterstützung; automatisierte Insights |

| Tibco | Tibco Spotfire | „Hyperconverged“-Analytics-Plattform; Daten von Data Warehouses, Data Lakes und NoSQL/Hadoop/Spark-Datenbank-Clustern; Support von Streaming-Daten; automatische Abstimmung von Analysen und Visualisierungen auf Nutzergruppen |

| Vertica | Vertica Analytics Platform | als Unified Analytics Warehouse vermarktet; Integration von Elementen von Data Warehouses und Data Lakes; KI und Machine Learning für Predictive Analytics; |

| Yellofin | Yellofin Suite | Kombination von automatisierter Data Discovery mit Dashboards und datenbezogenen „Story-Telling“-Funktionen; Einbindung anderer Anbieter; mobiler Zugriff möglich; Collaboration-Funktionen |

Fazit & Ausblick

Eine Plattform statt eines ganzen „Zoos“ von Tools. Das Versprechen, das Unified-Data-Analytics-Lösungen geben, klingt verlockend. Natürlich werden solche Plattformen in der Praxis nicht jedem Unternehmen die gesamte Palette an Vorteilen bieten, die die Hersteller aufführen. Klar ist aber auch, dass in vielen Firmen Datensilos und „Herrschaftswissen“ ein Problem sind. Herkömmliche Business-Intelligence– und Analytics-Ansätze bieten dafür oft keinen brauchbaren Ausweg. Deshalb sollten sich Unternehmen jeder Größe mit dem Thema Unified Data Analytics auseinandersetzen. Denn Daten sind nun einmal zu einem zentralen Wirtschaftsfaktor avanciert. Und offenkundig täte auch die öffentliche Hand gut daran, ihre Datenstrategie und die eingesetzten Lösungen kritisch zu hinterfragen und Unified-Data-Analytics-Ansätze zu evaluieren.

Be the first to comment