Lieferkettenausfälle haben in letzter Zeit für Schlagzeilen gesorgt, aber eine flexible, leistungsstarke Daten-Supply-Chain ist für Unternehmen ebenso wichtig, um flexibel und datengesteuert zu bleiben. [...]

Lieferketten bzw. Ausfälle der Daten-Supply-Chain – sind derzeit ein heißes Thema. Die Menschen sind frustriert, weil sie in den Regalen der Geschäfte nicht die Produkte vorfinden, die sie gerade benötigen.

Die Fragilität der globalen Lieferkette ist so gravierend, dass viele Unternehmen bereits damit begonnen haben, ihre Lieferkettennetzwerke komplett umzugestalten, um für die Zukunft sowohl stärker als auch flexibler zu sein. Dabei werden sie auch prüfen wollen, ob eine andere geschäftskritische Lieferkette, auf die sie sich verlassen, verbessert werden muss: ihre Daten-Supply-Chain.

Die Herausforderungen der Daten-Supply-Chain machen nicht die gleichen Schlagzeilen wie die Ausfälle der globalen Lieferkette, aber das sollten sie auch. Ohne eine widerstandsfähige Daten-Lieferkette wird es Unternehmen nach Meinung von Pure Storage zukünftig schwerfallen, sich in die datengesteuerten und agilen Organisationen zu verwandeln, um in der vierten industriellen Revolution wettbewerbsfähig zu sein.

Wenn man bedenkt, wie wichtig Daten für das Management und die Planung von Lieferketten sind, liegt es auf der Hand, dass auf einer kaputten Lieferkette nichts aufgebaut werden kann.

Pure Storage nimmt die aktuellen Entwicklungen zum Anlass das Thema der Daten Supply Chain zu beleuchten.

Was ist eine Daten-Supply-Chain?

Eine Daten-Supply-Chain umfasst die Schritte, die bei der Umwandlung von Rohdaten in verwertbare Erkenntnisse erforderlich sind, damit Unternehmen Innovationen vorantreiben, Umsätze generieren, Kunden bedienen und fundierte Entscheidungen treffen können, z. B. darüber, welches Produkt als nächstes hergestellt und in welche Technologien investiert werden soll.

Wie eine reale Lieferkette besteht auch eine Datenlieferkette aus vielen verschiedenen Schritten und Teilnehmern, die zusammenarbeiten, um ein bestimmtes Produkt an einen bestimmten Ort oder eine bestimmte Personengruppe zu bringen, auch wenn es sich in diesem Fall um verwertbare oder analysierte Daten handelt.

Die typischen Schritte einer Lieferkette sind die Erstellung von Rohdaten, die Umwandlung und Integration dieser Rohdaten in verschiedene Systeme und die Nutzung oder Analyse dieser Daten, um sie für ein Unternehmen nutzbar zu machen.

In einer Datenversorgungskette extrahiert das Unternehmen zunächst Daten in verschiedenen Formaten aus unterschiedlichen und oft isolierten Quellen und bereitet diese Daten so auf, dass sie in ein Repository geladen werden können, auf das später zur Analyse zugegriffen werden kann.

Die Daten werden dann weiteren Prozessen wie Formatierung, Anreicherung und Bereinigung unterzogen, bevor sie analysiert und in einen Geschäftswert umgewandelt werden können.

Dies ist ein sehr einfacher Überblick über einen komplexen, zeitaufwändigen Prozess, für dessen Ausführung viele Tools und Akteure erforderlich sind – von fortschrittlichen Technologien wie maschinellem Lernen und künstlicher Intelligenz (KI) bis hin zu menschlichen Datenexperten wie Datenarchitekten und Datenwissenschaftlern.

Wie, wo und von wem genau Daten „umgewandelt“ werden, hängt davon ab, um welche Art von Informationen es sich handelt und was das Unternehmen damit machen möchte – von der Betrugserkennung bis hin zur Vorhersage von Anlagenausfällen.

Daten-Supply-Chain vs. Daten-Pipeline

Eine Daten-Supply-Chain unterscheidet sich von einer Daten-Pipeline insofern, als eine Daten-Pipeline das Werkzeug oder der Prozess ist, mit dem die Daten tatsächlich von einem Punkt zu einem anderen bewegt werden.

In diesem Sinne ist eine Daten-Pipeline eigentlich eine Untergruppe oder ein Teil einer Supply-Chain, zu der auch Data Lakes, Data Warehouses, Datenbanken, potenziell verschiedene Arten von Datenplattformen, Messaging-Warteschlangen und Analyse-Tools zählen.

Herausforderungen für die Daten-Supply-Chain

Genauso wie die globale Lieferkette dafür verantwortlich ist, dass die Produkte in die Geschäfte und bis an die Haustür gelangen, steht auch die moderne Lieferkette, die Datenprodukte liefert, vor großen Herausforderungen wie Kosten und Komplexität.

Die Herausforderungen für die Versorgungskette sind denen der globalen Versorgungskette nach Meinung von Pure Storage sehr ähnlich.

1. Komplexität

Wie die Technologie-Stacks im Allgemeinen sind auch die Daten-Supply-Chains in den letzten fünf Jahren nur noch komplexer geworden. Komplexität ist nie gut für ein System. Oft jedoch, auch in der Welt der Technologie, werden Probleme dadurch gelöst, dass immer mehr Schichten oder Komponenten als Pflaster hinzugefügt werden, die am Ende alles verlangsamen und möglicherweise sogar das System zerstören, das mit diesen Pflastern repariert werden sollte.

Bei Daten-Supply-Chains ist das nicht anders. Wie bei den harten Gütern der globalen Versorgungskette gilt auch hier: Je mehr Daten die Welt produziert, desto schwieriger ist es, diese Daten durch die Versorgungskette zu bekommen, um die Datenprodukte zu erzeugen, auf die sich die Unternehmen für ihre datengesteuerte Entscheidungsfindung verlassen.

Unternehmen neigen dazu, diesen Datenstrom zu bewältigen, indem sie immer mehr Schichten zu ihrem Supply-Chain-Management-System hinzufügen, was anfangs manchmal funktioniert, später aber oft zu kostspieligen Problemen in Form von Systemausfällen, Ausfallzeiten und möglicherweise sogar Datenschutzverletzungen führt.

2. Kosten

Die Kosten sind ein weiteres großes Problem moderner Daten-Supply-Chains, das direkt mit der Komplexität zusammenhängt. Durch die Komplexität bedingte Lücken und Ineffizienzen in der gesamten Lieferkette hindern Unternehmen daran, ihre Ziele im Bereich der modernen Datenanalyse vollständig, zeitnah und kosteneffizient zu erreichen.

Je komplexer ihre Lieferkette ist, desto mehr Fachwissen benötigen sie, um sie reibungslos ablaufen zu lassen, und desto mehr Zeit und Geld werden sie aufwenden müssen, um Fehler zu beheben.

Die Kosten stehen auch in direktem Zusammenhang mit der Skalierbarkeit. Moderne Unternehmen müssen Wege finden, um ihre Datenpipelines und Lieferketten einfach und kostengünstig zu skalieren.

Andernfalls werden ihre Budgets bei der derzeitigen Geschwindigkeit des Datenwachstums bald ausgereizt sein, und sie werden ihre Lieferketten auf die billigste Art und Weise flicken müssen, was später nur zu tieferen und teureren Problemen führen wird.

3. Der Umgang mit strukturierten und unstrukturierten Daten

Die beträchtliche Zunahme der Menge an unstrukturierten Daten, die produziert werden, bringt die moderne Lieferkette ebenfalls ins Wanken. Unstrukturierte Daten sind von Natur aus schwieriger zu definieren und zu verarbeiten, da sie nicht durch Zahlen dargestellt werden können.

Der typische Weg, mit unstrukturierten Daten umzugehen, besteht darin, sie in einen Data Lake zu werfen, aber Data Lakes haben ihre eigenen Probleme mit Datenqualität, Zuverlässigkeit und Hacking.

Unternehmen versuchen, das Problem mit Geld zu lösen, indem sie in mehr Appliances und in Technologien wie KI investieren.

Dies wird jedoch zu einem Teufelskreis, da sie ihrer Lieferkette nur mehr Infrastruktur hinzufügen, die nicht skalierbar ist, was wiederum die oben genannten Kosten- und Komplexitätsprobleme verschlimmert.

Moderne Datenspeicherung für eine nahtlose Daten-Supply-Chain

Um die Gesamtleistung ihrer Lieferkette zu verbessern, setzen viele Unternehmen auf moderne Datenspeicher, die alle Arten von Daten mit massiven Skalierungsfunktionen konsolidieren können.

Die Konsolidierung unstrukturierter Daten in einer zentralen, zugänglichen Datenebene hilft Unternehmen, ihren Datenfluss zu rationalisieren und die gemeinsame Nutzung von Daten im gesamten Unternehmen zu verbessern.

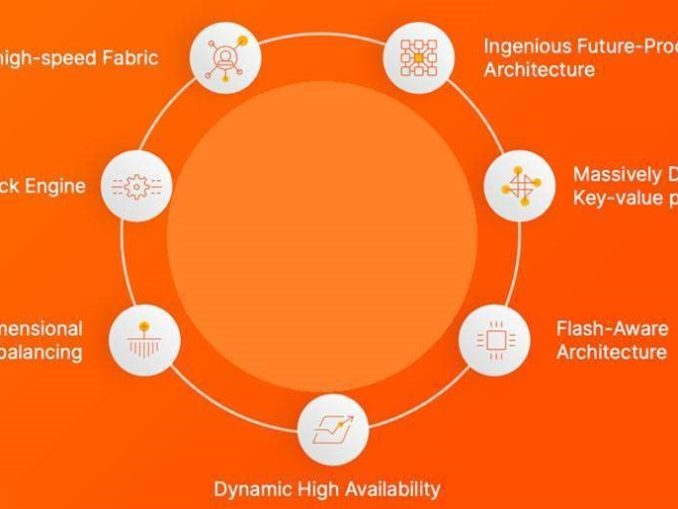

Aus diesem Grund hat Pure Storage das Konzept „Unified Fast File and Object“ (UFFO) entwickelt, das sich mit den wachsenden Anforderungen der Lieferkette weiterentwickelt und entsprechend skalierbar ist.

Eine entsprechende Plattform bietet die Skalierbarkeit, Flexibilität und den Investitionsschutz, um unstrukturierten Daten für das nächste Jahrzehnt und darüber hinaus zu vereinfachen:

- Kapazität und Leistung, die unabhängig voneinander aktualisiert und flexibel und unterbrechungsfrei skaliert werden können, wenn sich die Geschäftsanforderungen ändern.

- Zukunftssichere Aufrüstbarkeit und Investitionsschutz. Unternehmen erhalten die Verfügbarkeit aufrecht, reduzieren die Verschwendung und sorgen für die Sicherheit ihrer Daten in Zeiten beispielloser Veränderungen.

- Die Option des As-a-Service-Verbrauchs für eine UFFO-Plattform, um den Wachstumsambitionen der Kunden besser gerecht zu werden.

Genau wie die Entwicklung einer Lieferkette der nächsten Generation für die Auslieferung physischer Güter erfordert auch die Modernisierung der Datenlieferkette sorgfältige Planung, Investitionen und Zeit.

Pure Storage ist sich sicher: In der „neuen Industrie“ kann es sich kein Unternehmen leisten, auf eine flexible, leistungsstarke Lieferkette zu verzichten, die auf die Zukunft ausgerichtet ist.

Be the first to comment