Trotz vieler unbestreitbarer Vorteile ist Cloud-Computing kein Selbstläufer. Der Einzelfall entscheidet. Ein Pro & Contra. [...]

Eine Zeit lang sah es so aus, als seien die Technologien rund um die Cloud eine noch nicht dagewesene Revolution in der Informationstechnologie. Keine Sorgen mehr und keinen Ärger mit dem eigenen Rechenzentrum, ob klein oder groß – stattdessen gegen einen monatlichen Obolus der komfortable Zugriff auf externe Institutionen, die Daten und Anwendungen beherbergen.

Und das mit Services für wenig beliebte Aufgaben wie Storage und Backup, wie es normalen Unternehmen wegen der fehlenden Expertise und der Kosten selbst unmöglich wäre. Die Cloud-Dienstleister propagierten zudem, immer die besten und neuesten Geräte und Tools einzusetzen.

Inzwischen hat Ernüchterung die Begeisterung der ersten Zeit abgelöst, auch wenn sich kaum jemand dem Trommelfeuer von Marketingleuten, Anwender-Reports und Analysten-Statements entziehen kann, die voll des Lobes für die Cloud sind. Und es stimmt ja auch: Die Cloud ist allgegenwärtig geworden.

Vereinzelt hörbare kritische Stimmen wie die von Apple-Mitgründer Steve Wozniak, der die mangelnde Kontrolle der Cloud durch die Anwender beklagte, sind nicht durchgedrungen.

Etappen der IT bis zur Cloud

Dabei hat die Cloud an der Funktionsweise der IT gar nicht so viel geändert. Das Verhältnis von physischen und virtuellen Servern, Applikationen und Daten, Speichersystemen, Entwicklungs-Tools, Ausgabe- oder Endgeräten und Netzwerkfunktionen ist gleich geblieben.

Sie befinden sich jetzt nur woanders, an einem oder an mehreren anderen physischen Orten, wo sie von einem Cloud-Service-Provider (CSP) gemanagt werden. Der Provider lässt sich dafür im Abo oder nach tatsächlichem Verbrauch bezahlen.

Eine kurze Definition von Cloud-Computing lautet heute so wie auf der IBM-Website: „Cloud-Computing verwandelt die IT-Infrastruktur in ein Betriebsmittel oder ein Dienstprogramm. Mit einer Cloud kann man über das Internet in eine irgendwo existierende Infrastruktur eintauchen und die Ressourcen dort benutzen, ohne dass man sie bei sich selbst im eigenen Rechenzentrum installieren und unterhalten muss.“ Im Vergleich zum traditionellen Rechenzentrum ergeben sich prinzipiell folgende Vorteile:

- Niedrigere IT-Kosten: Man braucht weniger oder gar keine interne IT-Infrastruktur, es entstehen keine konstanten Ausgaben mehr für Kauf, Installation, Konfiguration, Verwaltung und Reparaturen von Hard- und Software im eigenen Unternehmen.

- Schnelle Reaktion: Mit einer Cloud-Anbindung kann man neue Anwendungen innerhalb von Minuten abrufen – anstatt auf wochen- oder monatelange Arbeitsprozesse der eigenen IT-Abteilung warten zu müssen.

- Ausbau der IT: Erweiterungen der IT-Dienste gehen leichter und mit weniger Kosten vonstatten – stückweise oder elastisch je nach aktuellen Anforderungen und Bestellprozessen des Providers. Das Gleiche gilt für ein Reduzieren der verwendeten Services und Produkte. Im Endeffekt kann man sogar zusammen mit seinem Provider eine weltweit angelegte virtuelle Infrastruktur aufbauen – mit Internetzugriffen von (fast) überall aus.

Die Voraussetzung dafür ist eine virtualisierte Infrastruktur: Virtualisierung abstrahiert von den realen Gegebenheiten und Begrenzungen von Servern, Storage-Systemen oder Netzwerkstrukturen. Durch den Einsatz einer speziellen Software können mehrere Hardware-Systeme zusammengefasst oder unterteilt werden.

Zum Beispiel lässt sich ein einzelner Hardware-Server in mehrere virtuelle Server aufteilen. Damit stehen auf der gleichen Hardware-Basis mehrere Server-Instanzen zur Verfügung.

Durch Cloud-Computing werden gegenwärtig bestehende Rechenzentren ersetzt oder nach und nach aufgelöst. Historisch betrachtet ist das keineswegs neu, sondern eine Art Revival des Mainframe-Computings. Vor der Einführung der sogenannten Mini-Computer in den 70er- Jahren des letzten Jahrhunderts – geprägt vor allem durch die Computer von Digital Equipment – verfūgten nur sehr große Unternehmen oder einzelne Behörden über leistungsstarke (und teure) Großrechner. Solche Mainframes waren mittels Timesharing und mit ihrem Betriebssystem in der Lage, von sehr vielen Anwendern an ihren entfernten Terminals gleichzeitig genutzt zu werden.

Mit der Verbreitung von PCs und Unix-Workstations sowie Windows- und Unix-Servern ging der Markt für Timesharing zurück und die Mainframes verloren allmählich immer mehr Marktanteile. Virtualisierung – einst eine Domäne des Betriebssystems der IBM-Mainframes – erlebte 1999 durch die Gründer von VMware (ehemalige Mitarbeiter von IBM) eine Neugeburt – dieses Mal entwickelt für x86-Systeme.

Damit war die Basis gelegt für modernes Cloud-Computing und die Virtualisierung weiterer Elemente, darunter Storage, Networking (Virtual Private Networks und virtuelle Local Area Networks) und Container für Anwendungen (zum Beispiel Docker). Erst 2006 tauchte der Begriff „Cloud“ auf, als Amazon den neuen Dienst Amazon Web Services (AWS) zusammen mit Elastic Compute Cloud (EC2) herausbrachte.

Als Vorläufer von Cloud-Computing gelten auch ASPs (Application Service Provider), die eine Anwendung via Internet anbieten, und Dienste wie früher Compuserve oder AOL. Salesforce etwa hatte großen Erfolg mit so einem Modell, bei dem sich alle Software-Komponenten und auch die meisten Daten der Anwender auf den Rechenzentren des Anbieters befinden.

Online-Applikationen für private Nutzer wie Evernote oder Dropbox haben ebenfalls den Weg für das heutige Cloud-Computing geebnet. Man unterscheidet drei Hauptkategorien von Cloud-Services:

- SaaS (Software as a Service): Ein Third-Party-Provider hostet Anwendungen und stellt sie über das Internet zur Verfūgung. Beispiele: Netsuite (seit 2016 bei Oracle), Concur (seit 2014 bei SAP), Microsoft 365.

- PaaS (Platform as a Service): Ein Third-Party-Provider hostet Plattformen und Tools für die Anwendungsentwicklung und bietet sie via Internet an. Beispiele: AWS Elastic Beanstalk, Google App Engine, Heroku (Cloud-Plattform für Programmiersprachen).

- IaaS (Infrastructure as a Service): Ein Third-Party-Provider hostet Server, Storage und andere virtuelle Ressourcen und bietet sie via Internet an. Beispiele: AWS, Microsoft Azure, Google Compute Engine, Alibaba.

State of the Cloud

Mit der Verbreitung der Cloud-Services setzte es sich auch immer mehr durch, Disaster-Recovery ūber das Internet zu organisieren statt über interne Lösungen im Unternehmen selbst. Dafür fällt – so lautet die Kernbotschaft der Anbieter – nur ein Bruchteil der Kosten an, die für eigene Recovery-Lösungen aufgewendet werden müssen.

In der Realität hat sich bei Katastrophenfällen allerdings oft herausgestellt, dass die Ūbertragungskosten bei einem Restore über das Internet sehr aufwendig sein können. Außerdem kann es bei einem solchen Restore mehrere Stunden oder sogar Tage dauern, bis das Unternehmen wieder einen geordneten Betrieb aufnehmen kann.

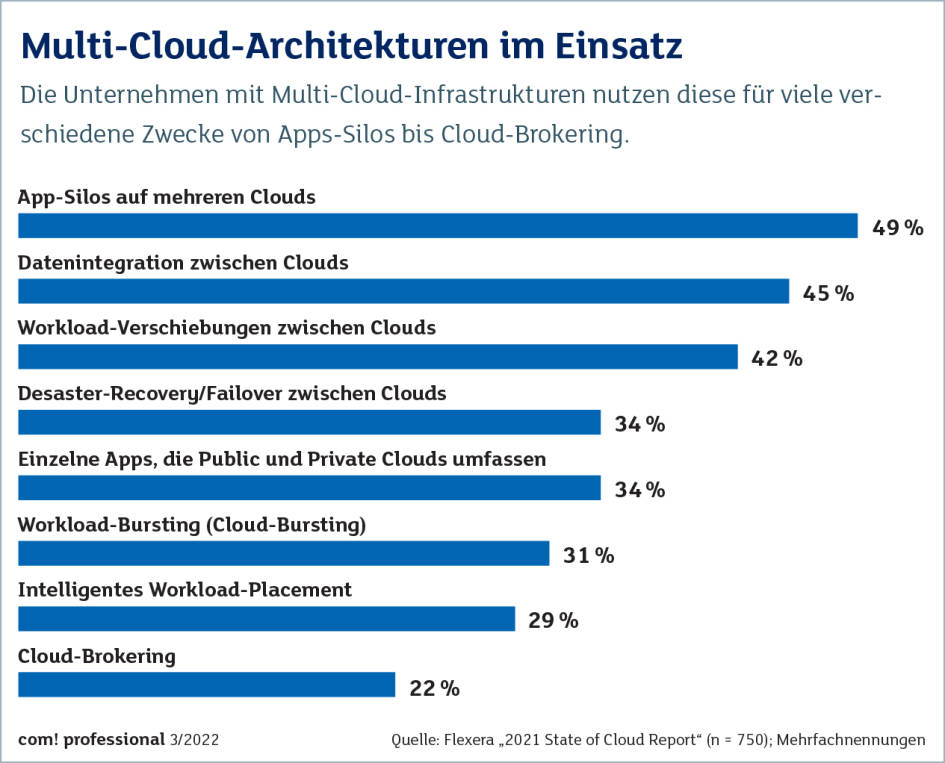

Neuere Cloud-Entwicklungen umfassen auch Container-Angebote als Ersatz für virtuelle Maschinen. Managementdienste und hybride Produkte wie Docker Enterprise, Red Hat Openshift und VMware Tanzu werden zunehmend in Private- und Public-Cloud-Umgebungen eingesetzt.

Zudem hat im Zusammenhang mit den Versuchen, die Corona-Epidemie einzudämmen, der Cloud-Zug weiter Fahrt aufgenommen, und die Unternehmen geben weniger für eigene Hard- und Software aus.

Gartner-Analysten gehen der US-Website Tech Target zufolge davon aus, dass Unternehmen bis zum Jahr 2024 rund 45 Prozent der IT-Ausgaben von ihrer internen Infrastruktur auf Cloud-Services verlagern werden. Dass die interne IT in den meisten Unternehmen ganz verschwinden wird, wie noch vor ein paar Jahren von vielen Fachleuten behauptet wurde, gilt inzwischen jedoch als unwahrscheinlich. Dazu beigetragen haben auch schwere Störfälle wie der im vergangenen Jahr beim französischen Cloud-Anbieter OVHcloud, bei dem die Daten zahlreicher Firmen fast komplett zerstört wurden.

Angesichts der Vielzahl an Cloud-Optionen, die auf dem Markt angeboten werden, müssen sich die Unternehmen entscheiden zwischen Public-, Private- oder Hybrid-Angeboten. Dabei sind Faktoren wie Skalierbarkeit, Sicherheit, Performance, Zuverlässigkeit und Kosten zu beachten. Auch die Ausgaben und Investitionen bei einer eventuellen späteren Rückführung der Applikationen oder der Datenspeicherung in das eigene oder ein neu zu erstellendes Rechenzentrum sollten in die Kalkulation eingehen.

Abzuwägen sind auch die Vor- und Nachteile länger bestehender Rechenzentren, die unter der Obhut (und Befehlsgewalt) des Unternehmens stehen im Vergleich zu den relativ neuen zentralen Cloud-Rechenzentren, bei denen ein differenzierter Einblick, Erfahrung und direkte Eingriffsmöglichkeiten fehlen.

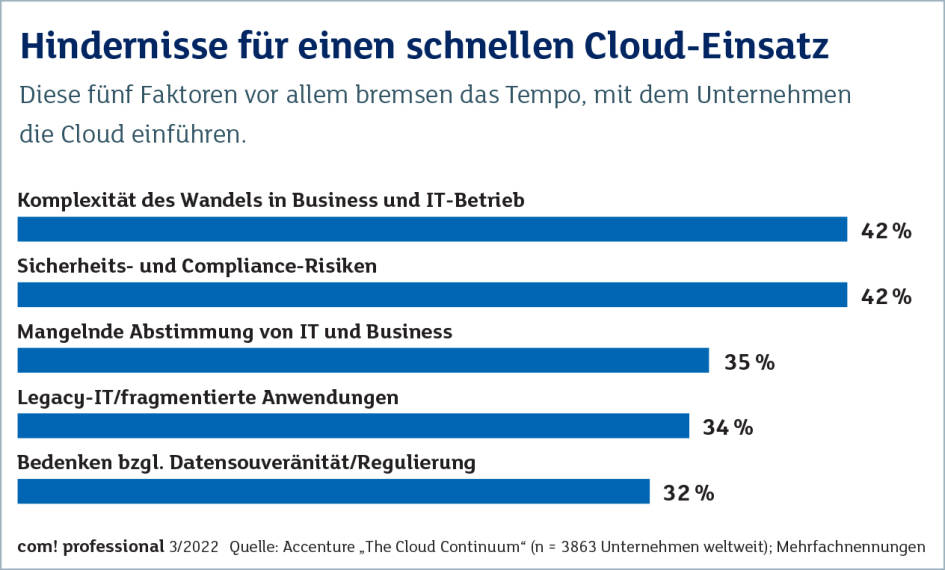

Zudem sind die Komplexität, wechselnde technologische Angebote und Preisgestaltungen mit zu bedenken. Cloud-Consulting, wie es etwa Accenture mit seinen „Cloud Services“ anbietet, kann hilfreich sein, verursacht aber weitere Kosten.

Zukunft der Cloud

Ein besonderes Problem kann ein für die Cloud geeignetes Sicherheitskonzept sein. Anwender sollten sich nicht nur auf die Maßnahmen des Providers verlassen. Insbesondere bei einer eigenen Entwicklung von cloudnativen Anwendungen ist ein Sicherheitsplan notwendig. Herkömmliche Sicherheits-Tools sind für die traditionelle Software-Entwicklung und bestehende Infrastrukturprozesse gedacht und verfügen oft nicht über den Funktionsumfang für moderne Cloud-Anwendungen.

In diesem Zusammenhang führt Liran Tal, Director of Developer Advocacy bei dem auf Cloud-Sicherheit spezialisierten Start-up Snyk, aus: „Entwickler sind nun auch für die Sicherheit von cloudnativen Anwendungen verantwortlich, und zwar von Anfang an bis hin zur finalen Bereitstellung. Daher stehen sie vor vielen neuen Herausforderungen – und deshalb benötigen sie entwicklerorientierte Tools, um diese Sicherheitsprobleme in der Cloud anzugehen. Silos müssen aufgebrochen werden und Entwickler, Betriebs- und Sicherheitsexperten sollten verstärkt zusammenarbeiten, mit dem gemeinsamen Ziel, sichere Anwendungen zu entwickeln und auf den Markt zu bringen.“

Generell lässt sich sagen, dass der Einsatz einer Cloud-Lösung die Arbeit der IT-Teams nicht automatisch erleichtert. So heißt es im „2021 State of the Cloud Report“ des IT-Management-Spezialisten Flexera: „Die größten Herausforderungen sind Sicherheit, Ausgaben, Governance und Fachwissen. Insgesamt geben 81 Prozent der von uns Befragten an, dass Sicherheit eine Herausforderung darstellt, gefolgt von 79 Prozent für die Verwaltung der Cloud-Ausgaben und jeweils 75 Prozent für Governance, fehlende Ressourcen/Expertise und Compliance. Und 55 Prozent der Befragten geben an, dass das Verständnis der Kostenauswirkungen von Software-Lizenzen eine der größten Herausforderungen für die Cloud ist.“

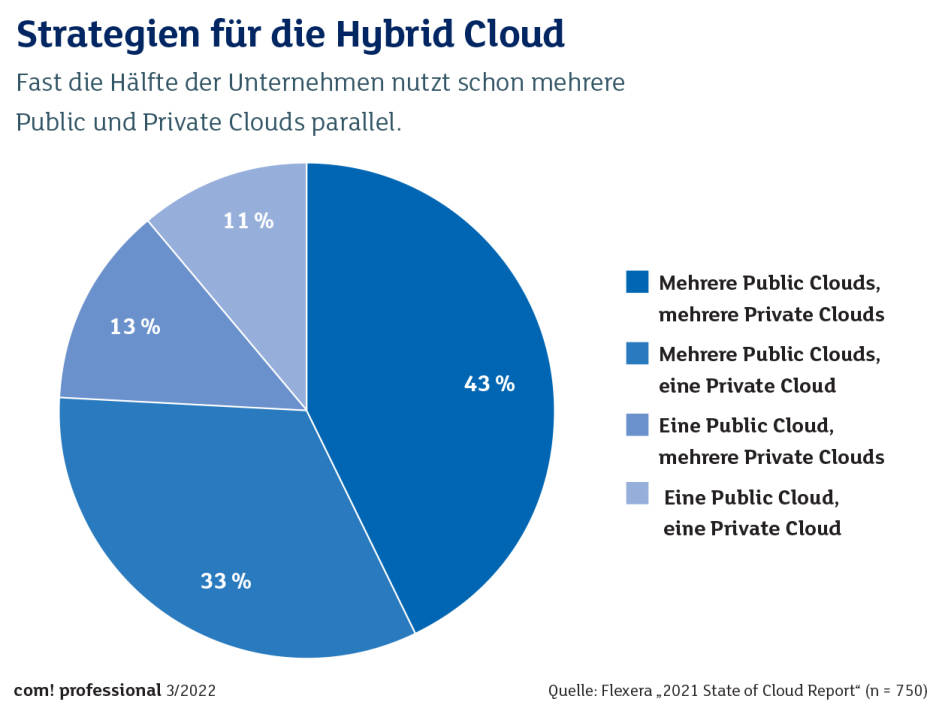

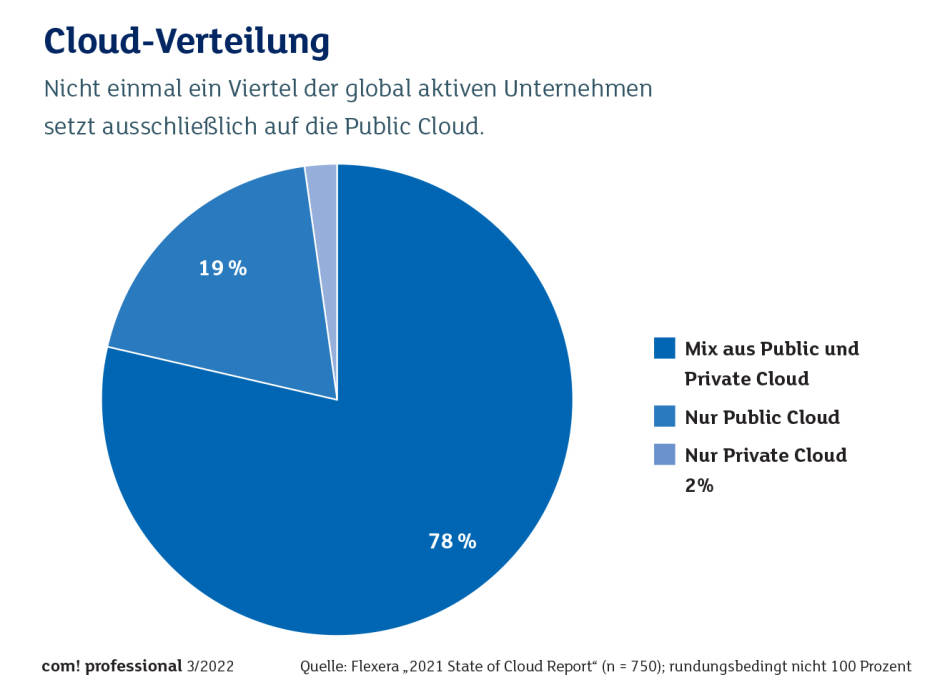

Interessant auch: Erst 19 Prozent der globalen Unternehmen setzen laut Flexera voll und ganz auf die Public Cloud – anders als das viele der interessierten Provider und Hersteller propagieren. Die große Mehrheit hält weiter an On-Premise-Rechenzentren fest und experimentiert oder nutzt die Cloud nur zum Teil.

Gleiches besagen andere Untersuchungen, wie sie etwa IDC und Gartner in der letzten Zeit vorgelegt haben. Teils lag dabei der Anteil der globalen Unternehmen, die vollständig auf ein Cloud-Modell umgestiegen sind, sogar unter 10 Prozent.

Die Untersuchungen zeigen auch, dass sensible Finanzdaten oder Auftragsdaten mehr On-Premise oder in gemischten Umgebungen gehalten werden. In vielen Darstellungen wird der insgesamt wachsende Marktanteil von Public-Cloud- und Hybrid-Installationen hervorgehoben, was aber keinesfalls damit gleichzusetzen ist, dass die Mehrheit der Unternehmen ihre eigenen Rechenzentren aufgegeben hätte.

„Es wird ein disruptiver Markt sein, um es vorsichtig auszudrücken.“

Sid Naq, VP Gartner

Sid Naq, Research Vice President bei Gartner, fasst zusammen: „Die Ereignisse des letzten Jahres (2020, d. Red.) haben es den CIOs ermöglicht, ihre Zurückhaltung bei der Verlagerung von geschäftskritischen Arbeitslasten aus dem eigenen Haus in die Cloud zu überwinden. Auch ohne die Pandemie wäre die Nachfrage nach neuen Rechenzentren gesunken. Neue Technologien wie Containerisierung, Virtualisierung und Edge-Computing setzen sich immer mehr durch und treiben die Investitionen für die Cloud weiter in die Höhe. Einfach ausgedrückt: Die Pandemie hat das Interesse der CIOs an der Cloud verstärkt.“

Naq ist der Ansicht, dass die Cloud als Bindeglied zwischen vielen anderen Technologien dienen wird. CIOs sollten sie vermehrt nutzen, um den „Sprung ins nächste Jahrhundert“ zu ermöglichen, wenn sie komplexere und neuere Anwendungsfälle angehen. Das Resümee von Naq lautet: „Es wird ein disruptiver Markt sein, um es vorsichtig auszudrücken.“

*Hartmut Wiehr ist Autor bei com!professional.

Be the first to comment