Während Large Language Models (LLMs) und künstliche Intelligenz bei der Automatisierung neue Potenziale in der Geschäftswelt erschließen, lassen sich damit auch täuschend echt aussehende Fotos und Videos erzeugen, die viel Schaden anrichten können. [...]

Die bildergenerierende künstliche Intelligenz (KI) wirbelt unser Leben durcheinander. Zum einen ist KI eine mächtige Hilfe bei der Digitalisierung von Unternehmen. Der Start von ChatGPT sei vor einem Jahr eine Initialzündung für den KI-Einsatz gewesen, sagt Bitkom-Präsident Ralf Wintergerst, und habe vielen Menschen erstmals vor Augen geführt, was KI heute schon leisten könne: »Für Unternehmen war es noch nie so einfach und kostengünstig wie heute, KI einzusetzen und erste Erfahrungen zu sammeln.« Das ist die eine Seite.

Die andere, die dunkle Seite der KI umfasst die Beeinflussung, Manipulation und Verbreitung falscher Informationen anhand von künstlich erzeugten Bildern mit »Nachrichten«-Charakter. Dabei soll die Bevölkerung für oder gegen eine Sache eingestimmt oder – vielleicht zutreffender formuliert – aufgehetzt werden.

Gerade wenn es um Politiker, politische Parteien, Klimawandel oder die COVID-Pandemie geht, können Fake News großen Schaden anrichten und demokratische Entscheidungen erschweren oder gar verunmöglichen, sollten diese doch von einer aufgeklärten und informierten Bevölkerung getroffen werden. Insbesondere in Kriegen und bewaffneten Konflikten wie gegenwärtig in der Ukraine und Israel, versuchen Kriegsparteien immer wieder die Betrachter durch manipulierte Bilder, zunehmend eben auch KI-Bilder, auf ihre Seite zu ziehen.

Deswegen hat der weltgrößte Pressefotografie-Wettbewerb »World Press Photo« KI-Bilder zu einem absoluten No-Go erklärt und auch für die Open-Kategorie verboten. Das ist aber nur ein Tropfen auf dem heißen Stein. Natürlich, Propaganda hat es schon immer gegeben. Doch während früher das Manipulieren von Bildern Fachwissen und Zeit erforderte, kann das heute jeder Mensch mit einem PC und Zugang zum Internet in wenigen Sekunden erledigen.

Auf der Plattform X (ehemals Twitter) teilte Eliot Higgins zahlreiche KI-Bilder, die den ehemaligen US-Präsidenten Donald Trump bei der Flucht vor der Polizei oder bei seiner (imaginierten) Verhaftung zeigen. Wer genau hinsieht, erkennt, dass diese Bilder künstlich erstellt wurden. Zum Beispiel sind die Gesichter umstehender Personen völlig verschwommen, die Polizisten blicken nicht in die richtige Richtung oder Arme und Hände sehen seltsam aus. Dennoch: Diese Bilder werden stetig besser und es gibt bereits KI-Bilder, die weder für Fachleute noch mit technischen Systemen zur Erkennung von KI-Bildern von authentischen Fotos zu unterscheiden sind.

© Truth Social/Trump

© Eliot Higgins

© Eliot Higgins

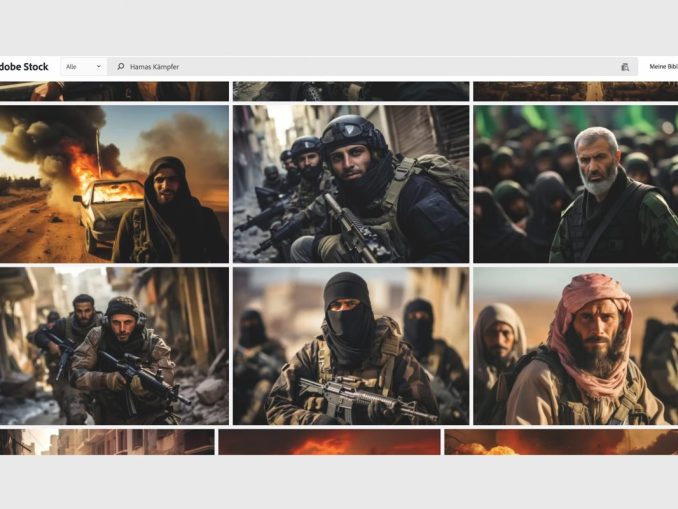

Nicht hilfreich ist es, wenn KI-Bilder ganz offiziell in den Workflow der Berichterstattung Eingang finden, wovor Ende November der Deutsche Fotorat in einer Aussendung warnte. Gerade absurd wird es, so der Fotorat, wenn unter dem Schlagwort »Gaza« beispielsweise auf der Bilddatenbank Adobe Stock KI-generierte fotorealistische Bilder von zerstörten Städten angeboten werden, oder hoch emotionale Bilder von Kindern in Trümmerlandschaften sowie ferner Portraits von bärtigen Bewaffneten, die in derBildbeschreibung als »Hamas-Krieger« bezeichnet werden. Da diese Bilder gleichrangig mit echtem Fotomaterial angeboten, identisch verschlagwortet und in vielen Fällen inhaltlich ähnlich beschrieben werden, könne es vorkommen, dass beim Kauf solcher Bilder – auch trotz KI-Hinweis vom Anbieter – die Kennzeichnung und das Wissen, dass es sich hier um künstlich erzeugte Bilder handelt, im Laufe des weiteren Redaktionsprozesses übersehen werde beziehungsweise verloren gehe.

Würde so ein Bild als tatsächliches Foto veröffentlicht, führe das wohl zu einem Vertrauensverlust bei den Mediennutzern und -nutzerinnen, warnt der Fotorat und fordert: 1.) verantwortungsvolles Handeln von Bildanbietern. »Die bloße Kennzeichnung von KI-Bildern beim Vertrieb von Bildrechten reicht nicht aus, wenn sonstige Bildinformationen nicht von denen realer Fotos zu unterscheiden sind«, so der Fotorat. 2.) Ein klares Nein zur Verwendung von KI-Bildern in der Berichterstattung und 3.) einen verantwortungsvollen Einsatz von KI-Bildern im politischen Diskurs. Eine deutliche Kennzeichnung der KI-Bilder ist notwendig und im Zweifel ist ein authentisches Foto vorzuziehen.

Maßnahmen gegen Fake News

Einig sind sich Experten und Expertinnen darin, dass geeignete Mittel zur Bekämpfung von Fake News der Ausbau von Bildung und Medienkompetenz sind. In der erstmals 2022 im Auftrag der RTR Medien unter der Leitung von Univ.-Prof. Thomas Steinmaurer der Universität Salzburg und in Kooperation mit dem Institut für Soziologie der Universität Linz durchgeführten Studie »Digital Skills Austria« konnte empirisch nachgewiesen werden, dass der Besuch von Kursen zur Bildung von Medienkompetenz eine erkennbare Wirkung auf die Fähigkeit zur Lösung von Aufgaben im digitalen Raum hat. Die Studie wurde 2023 erweitert und liegt jetzt als »Digital Skills Austria 2023« vor.

Bei einer Experten-Tagung diesen November zum Thema Medien- und Informationskompetenz beleuchtete Wolfgang Struber, Geschäftsführer der RTR Medien, die beiden Seiten der künstlichen Intelligenz: »Wir werden lernen müssen, KI verantwortungsvoll zu nutzen und zu kontrollieren, denn für nationale und regionale Medien bedeuten diese Anwendungen eine Chance im Wettbewerb mit den internationalen Online-Giganten. In den falschen Händen ist KI aber auch ein gefährliches Werkzeug zur Herstellung von Falschinformationen. Dieser Gefahr kann durch den Ausbau von Informationskompetenz und digitalen Fähigkeiten der Bevölkerung entgegengetreten werden. Das ist eine demokratiepolitisch bedeutsame Aufgabe für alle Teile der Gesellschaft.«

Echte Inhalte verifizieren, statt falsche erkennen

Möglichkeiten, wie die Verbreitung manipulierter Aufnahmen verhindert werden können, zeigt der von der Content Authenticity Initiative (CAI) erschaffene C2PA-Standard. Der Ansatz ist, nicht Fake-News zu erkennen, sondern mit Kameras gemachte Fotos als nicht manipulierte zu kennzeichnen. Bei dem C2PA-Standard handelt es sich um eine in die Kameras integrierte Authentifizierungstechnologie, bei der mit verschlüsselten Metadaten der Ursprung eines Fotos verifiziert wird. Leica und Sony sind die ersten Kamerahersteller, die diesen Standard implementieren. Die erste Leica-Kamera mit dieser Technik ist die M11-P, bei Sony wird die Ende Jänner 2024 auf den Markt kommende Alpha 9 III mit dieser Technik ausgestattet sein. Weitere Sony-Modelle sollen sich in den nächsten Wochen mit dieser Authentifizierungstechnologie nachrüsten lassen können.

Die Alpha 9 III verfügt dabei über einen Hardware-Chip, der eine digitale Signatur hinzufügt. Sony arbeitet hier mit Camera Bits zusammen, einem US-amerikanischen Softwarehaus, das die Fotosoftware »Photo Mechanic« herstellt. Bei dieser spielt ebenfalls das Verwalten von Metadaten eine Rolle. In der C2PA-Authentifizierungslösung soll Camera Bits sicherstellen, dass die digitale Signatur und weitere Änderungen an jedem Bild in den Metadaten erhalten bleiben.

Be the first to comment